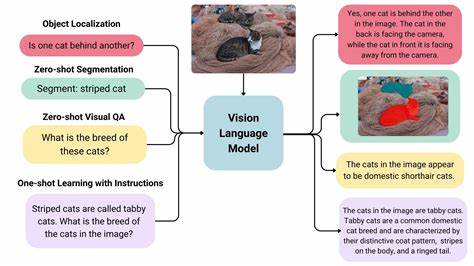

In der dynamischen Welt der Künstlichen Intelligenz (KI) erleben wir immer wieder beeindruckende Fortschritte. Besonders Vision-Language-Modelle (VLMs), die Bilder und Sprache gleichzeitig verarbeiten können, haben in den letzten Jahren viel Aufmerksamkeit erregt. Doch wie gut sind solche Modelle tatsächlich darin, komplexe Aufgaben zu bewältigen, die für Menschen als selbstverständlich gelten? Eine spannende und innovative Antwort darauf liefert VideoGameBench, ein neu entwickelter Benchmark, der ins Zentrum rückt, ob VLMs klassische Videospiele erfolgreich spielen können. Diese Forschungsinitiative bietet einen einzigartigen Ansatz, Videospiele aus den 1990er Jahren als Testumgebung zu nutzen, um elementare menschliche Fähigkeiten auf die Probe zu stellen, wie visuelle Wahrnehmung, räumliche Navigation und Gedächtnismanagement. Videospiele sind seit jeher speziell so konzipiert, dass sie intuitiv von Menschen erlernt und gemeistert werden können.

Durch ihre komplexen Mechanismen und interaktiven Herausforderungen stellen sie eine hervorragende Plattform dar, um die Leistungsfähigkeit von KI-Modellen im Kontext von Echtzeit-Interaktion mit visuellen Eingaben zu überprüfen. VideoGameBench umfasst zehn populäre Spiele dieser Ära, die von den Modellen direkt und in Echtzeit gesteuert werden müssen. Das Besondere an diesem Benchmark ist, dass die VLMs ausschließlich mit rohen visuellen Daten und einer abstrakten Beschreibung von Zielen und Steuerungsmöglichkeiten arbeiten, was einen deutlichen Unterschied zu bisherigen Ansätzen darstellt, die häufig auf spielbezogene Hilfsmittel oder zusätzliche Informationen angewiesen sind. Drei der Spiele bleiben während der Evaluierung sogar geheim, um sicherzustellen, dass die entwickelten Methoden nicht nur auf bekannte Spiele zugeschnitten sind, sondern auch auf unbekannte Umgebungen generalisieren können. Die Testergebnisse sind ernüchternd und höchst aufschlussreich zugleich.

Selbst die fortschrittlichsten Vision-Language-Modelle schaffen es kaum, über den Anfang eines Spiels hinauszugehen. Dieses Ergebnis hebt die erheblichen Herausforderungen hervor, die mit der Umsetzung visueller und sprachlicher Fähigkeiten in komplexen, dynamischen Szenarien verbunden sind. Ein wesentlicher Engpass stellt dabei die Latenzzeit bei der Inferenz dar. Echtzeit-Spiele erfordern schnelle Entscheidungsfindungen, doch viele der derzeitigen Modelle benötigen zu lange, um Eingaben zu verarbeiten und Aktionen zu generieren. Um diesem Problem entgegenzuwirken, wurde eine ergänzende Methode namens VideoGameBench Lite eingeführt, bei der das Spiel pausiert, bis das Modell seine Entscheidung getroffen hat.

Dieser Ansatz führt zwar zu verbesserten Ergebnissen, doch der beste getestete KI-Agent, Gemini 2.5 Pro, erreicht damit immer noch nur einen äußerst geringen Fortschritt von 1,6 Prozent im Vergleich zum vollständigen Benchmark. Diese Resultate sind nicht nur eine Herausforderung, sondern auch eine Einladung an die Forschungsgemeinschaft, die Entwicklung von KI-Systemen voranzutreiben, die besser mit visueller Wahrnehmung, räumlicher Orientierung und Erinnerungsvermögen umgehen können. Besonders relevant ist dies, da viele Anwendungen jenseits von Spielen diese Fähigkeiten benötigen, beispielsweise in Robotik, autonomem Fahren oder assistiven Technologien. VideoGameBench stellt somit eine wichtige Plattform zur Evaluierung und Weiterentwicklung von Vision-Language-Modellen dar, die eine Brücke zwischen rein statistischen Fähigkeiten und echtem „Verstehen“ schlagen wollen.

Die Kombination aus visueller Analyse und natürlicher Sprachverarbeitung in einem interaktiven Umfeld stellt eine hochkomplexe Herausforderung dar, die aktuell noch weit von der Leistungsfähigkeit menschlicher Spieler entfernt ist. Für Entwickler und Forscher im Bereich der Künstlichen Intelligenz bietet VideoGameBench eine wertvolle Möglichkeit, verschiedene Modelle und Ansätze direkt zu vergleichen und die Grenzen der aktuellen Technologien auszuloten. Darüber hinaus stimuliert das System die Entwicklung neuer Methoden, welche die Latenz reduzieren und die Entscheidungsfindung in Echtzeit verbessern können. Es wird deutlich, dass klassische Videospiele weit mehr sind als bloßer Zeitvertreib: Sie fungieren als anspruchsvolle Prüfsteine, die die Schnittstellen zwischen Wahrnehmung, Kognition und Handlung erfordern – genau jene Bereiche, in denen KI zukünftig wirken muss, um menschenähnliche Fähigkeiten zu erlangen. Die Einführung von VideoGameBench markiert somit einen Schritt in Richtung einer umfassenderen und realitätsnäheren Bewertung von Vision-Language-Modellen, die über reines Textverständnis und Bilderkennung hinausgehen.

Indem reale Spielewelten als Testumgebung genutzt werden, entsteht ein praxisnahes Szenario, das nicht nur punktuelle Aufgaben, sondern auch den Prozess des Lernens, Entscheiden und Handelns in dynamischen Umgebungen überprüft. Abschließend lässt sich sagen, dass VideoGameBench ein bedeutendes Forschungswerkzeug darstellt, das die gegenwärtigen Grenzen von Vision-Language-Modellen sichtbar macht und zugleich Impulse für zukünftige Innovationen setzt. Die Herausforderung, komplexe Videospiele erfolgreich zu meistern, bringt KI-Modelle an ihre Leistungsgrenzen und zeigt auf, wie viel Potenzial noch in der Kombination von visueller Wahrnehmung und Sprachverarbeitung steckt. Für die KI-Forschung bedeutet dies eine spannende Herausforderung, die weitreichende Folgen für die Entwicklung intelligenter Systeme mit realweltlichen Fähigkeiten haben wird.