Die Bewertung und Rankingerstellung in Wettbewerben mit vielen Teilnehmern stellt eine komplexe Herausforderung dar, insbesondere wenn die Anzahl der Einreichungen in die Hunderte geht und die Information von den Stimmen nur partiell vorliegt. Der Summer of Math Exposition (SoME) hat sich dieser Problematik gestellt und einen eigenen Ranking-Algorithmus entwickelt, der Fairness, Genauigkeit und Nutzerkomfort vereint. Der Weg zu diesem einzigartigen Algorithmus verdeutlicht die Probleme herkömmlicher Abstimmungssysteme und zeigt, wie maßgeschneiderte Lösungen neue Maßstäbe setzen können. In den Anfängen nutzte die Summer of Math Exposition einen Ansatz, der auf dem Bradley-Terry-Modell basierte, genauer gesagt eine Variante namens Crowd BT. Dieses Modell arbeitet mit Paarvergleichen, bei denen den Teilnehmenden zwei Einträge präsentiert werden und sie den besseren von beiden wählen müssen.

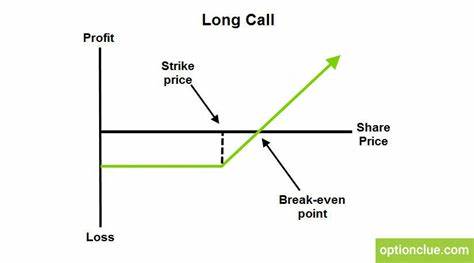

Die Idee dahinter ist, durch eine Vielzahl solcher Paarvergleiche ein globales Ranking zu erstellen. Der Vorteil lag in der einfachen Implementierung und einer gewissen Bewährung in anderen Kontexten wie Hackathons. Trotzdem zeigte sich schnell, dass die Genauigkeit und Geschwindigkeit dieses Verfahrens nicht den Anforderungen eines Wettbewerbs mit hunderten Einreichungen entsprach. Zudem erwies sich die Benutzeroberfläche als wenig flexibel. Im Anschluss wurde ein neuer Algorithmus entwickelt, der auf Ideen der Graphentheorie und des PageRank-Algorithmus basiert.

Dabei wurde ein sogenannter Expander-Graph konstruiert, der durch seine Eigenschaften wie hohe Konnektivität, regelmäßige Verteilung der Kanten und geringe Durchmesser sicherstellt, dass alle Einträge die gleiche Aufmerksamkeit erhalten. Die Einträge sind in einem Netzwerk miteinander verbunden, und die Richtung der Kanten zeigt jeweils auf den vermeintlich besseren Beitrag. Durch Anwendung eines Point-Flow-Mechanismus, ähnlich wie beim bekannten PageRank von Google, wird ein Ranking der Einträge bestimmt. Dieses Verfahren sollte eine gerechtere Bewertung ermöglichen und robustere Informationen aus den zahlreichen Paarvergleichen ableiten. Trotz der theoretischen Vorteile offenbarte ein Benchmark-Test einige Schwächen der PageRank-basierten Lösung.

Vor allem zeigten sich eine hohe Empfindlichkeit gegenüber „Noise“, also Fehlern und ungenauen Bewertungen seitens der Jury. Solche Störungen können sich durch die Weitergabe von Punkten im Netzwerk potenzieren und letztlich zu verfälschten Ergebnissen führen. Diese Erkenntnis unterstreicht die Problematik, die Google selbst bei „Link-Farmen“ beobachtet hat, die den PageRank manipulieren wollen. Ein iteratives Verfahren verbesserte die Performance des PageRank-Ansatzes deutlich. Dabei wird der PageRank nicht statisch auf dem gesamten Graphen angewandt, sondern in regelmäßigen Zyklen.

Nach jeweils einer festgelegten Anzahl neuer Bewertungen wird das Ranking neu berechnet und verwendet, um die nächsten Vergleiche gezielt zwischen benachbarten Einträgen im aktuellen Ranking durchzuführen. So wird der Rankingprozess dynamisch und robuster gegenüber Störeinflüssen. Parallel zu diesen Entwicklungen erwies sich die Mehrheitsurteilsmethode (Majority Judgement) als äußerst vielversprechend. Dieses Verfahren bewertet die Einträge individuell anhand von Noten, nicht durch Paarvergleiche. Die finale Platzierung ergibt sich aus dem Median der Bewertungen, was das System besonders widerstandsfähig gegenüber extremen Bewertungen macht.

Extreme Einschätzungen durch „Fans“ oder „Trolle“ verlieren ihre verzerrende Wirkung, weil der Median die Mitte der Verteilung abbildet. Selbst bei einer großen Streuung von Bewertungen bleiben die Einträge fair bewertet, was die Repräsentativität der Urteile für die Mehrheit steigert. Ein weiterer Vorteil dieser Methode liegt in der Benutzerfreundlichkeit. Die Jury muss nur einen einzelnen Beitrag anschauen und bewerten, was deutlich weniger Zeit in Anspruch nimmt als bei Paarvergleichen. Insbesondere bei längeren Beiträgen, die bis zu 30 Minuten dauern können, minimiert dies die Entscheidungsmüdigkeit und verhindert verzerrte Bewertungen durch subjektive Reihenfolgeeffekte.

Die befragte Jury bewertet die Beiträge anhand einer einzigen, präzise formulierten Frage: „Wie wertvoll ist dieser Beitrag für den Bereich der Online-Mathematik-Exposition im Vergleich zu einem typischen Mathematikvideo, das sie gesehen haben?“ Dabei werden fünf abgestufte Antwortmöglichkeiten von „deutlich schlechter“ bis „besser als die meisten“ angeboten, mit „etwa gleichwertig“ als neutralem Mittelpunkt. Dieser Ansatz nutzt die Erfahrung der Jurorinnen und Juroren optimal und reflektiert ein eher abstraktes Vergleichsbild, das vielen Teilnehmern intuitiv verständlich ist. Um die Qualität der Bewertungen noch weiter zu steigern und die Aufmerksamkeit effizienter zu lenken, setzt der Algorithmus der Summer of Math Exposition zusätzliche Filter und Optimierungen ein. Zu Beginn gibt es eine sogenannte Aufwärmphase, in der die Einträge zunächst willkürlich, aber gewichtet nach der Anzahl der erhaltenen Bewertungen, zugewiesen werden. Nach etwa zehn Bewertungen je Beitrag werden die untersten 25 Prozent der Einträge ausgeblendet, da sie kaum Chancen auf ein gutes Ergebnis haben.

Im nächsten Schritt folgt eine Phase, in der sich die Trends bestätigen: Die Einträge werden gewichteter nach ihrem Median-Score verteilt und die niedrigsten 25 Prozent erneut gefiltert, sodass sich die Auswahl auf die qualitativ hochwertigen Beiträge konzentriert. Abschließend wird eine Sichtbarkeitssteigerung für Beiträge mit hoher Variabilität der Bewertungen eingeführt. Diese hebt jene Einträge hervor, die unterschiedliche Meinungen anziehen und bei denen eine bessere Einigung möglich erscheint. Diese Maßnahmen vermindern einen möglichen Bias zugunsten polarisierender Einträge, indem sie die Sichtbarkeit mit zunehmender Anzahl der Bewertungen reduzieren. Diese multilagige Optimierung kombiniert die Ziele, ein faires Ranking zu schaffen, die Juryerfahrung zu verbessern und letztlich exzellente Beiträge sichtbar zu machen.

Die Filtermechanismen sorgen dafür, dass die Aufmerksamkeit der Juroren effizient auf die vielversprechendsten Einträge gelenkt wird, sodass Energie auf bedeutende Entscheidungen fokussiert bleibt und weniger relevante Einreichungen die Gesamtperformance nicht beeinträchtigen. Die Entwicklung des Summer of Math Exposition Ranking-Algorithmus demonstriert eindrucksvoll, wie komplexe Abstimmungsprozesse für große Wettbewerbe innovativ und durchdacht umgesetzt werden können. Die bewusste Abkehr von herkömmlichen Paarvergleichsmethoden zugunsten eines bewährten Mehrheitsurteils schafft nicht nur transparentere und akkuratere Ergebnisse, sondern verbessert auch die Motivation und Zufriedenheit der Juroren. Dies ist besonders wertvoll in einem Bereich wie der Online-Mathematik, wo Teilnehmer aus ganz unterschiedlichen Zugängen und Erfahrungslevels kommen. Der Einsatz von Expander-Graphen, iterativem PageRank und intelligenter Sichtbarkeitssteuerung zeigt zudem, wie moderne mathematische Konzepte und Algorithmik zur Lösung praktischer Probleme im Wettbewerbskontext beitragen.

Während der Anfangsalgorithmus mit Paarvergleichen und PageRank theoretisch spannende Ansätze lieferte, überzeugte letztlich die pragmatischere und robustere Majority Judgement Methode. Diese Entwicklung liefert auch für andere große Online-Wettbewerbe Impulse, die mit ähnlichen Herausforderungen im Bewertungsprozess kämpfen. Das Prinzip der Kombination aus individueller fundierter Bewertung, statistischer Auswertung mittels Median und mehrstufigen Filtern kann als Blaupause dienen, um faire und effiziente Rangfolgen zu ermitteln. Dabei ist es essenziell, die Nutzerfreundlichkeit im Blick zu behalten und Entscheidungsmüdigkeit so gering wie möglich zu halten. In der Praxis bestätigte sich der optimierte Ranking-Algorithmus der Summer of Math Exposition durch empirische Tests, die eine hohe Übereinstimmung mit der wahren Qualität der Einträge zeigten.

Dies beweist, dass mit einem durchdachten System aus bewährten mathematischen Verfahren und gezielten Zusatzmaßnahmen auch bei umfangreichen und heterogenen Wettbewerben eine valide und nachvollziehbare Bewertung erzielt werden kann. Somit steht der Summer of Math Exposition als positives Beispiel da, wie technische Innovationen in Abstimmungssystemen auf spezifische Anforderungen zugeschnitten werden können, um Transparenz, Fairness und Qualität in einem anspruchsvollen Wettbewerbsumfeld zu gewährleisten. Die Kombination aus algorithmischem Know-how und menschlicher Expertise schafft eine solide Grundlage für nachhaltige und vertrauenswürdige Rankings in der Welt der Online-Mathematik und darüber hinaus.