Die rasante Entwicklung künstlicher Intelligenz eröffnet immer neue Möglichkeiten, wie Computeranwendungen intelligenter und benutzerfreundlicher gestaltet werden können. Eine der größten Herausforderungen im Bereich der Mensch-Computer-Interaktion besteht seit jeher darin, grafische Benutzeroberflächen (GUI) zuverlässig und flexibel zu steuern. Hier setzt UI-TARS an, ein multimodaler KI-Agent von ByteDance, der auf einer Kombination aus Computer-Vision und Sprachverarbeitung basiert und automatisierte Aktionen in vielfältigen digitalen Umgebungen ermöglicht. UI-TARS verkörpert eine neue Generation von KI-Systemen, die sowohl Computerbefehle verstehen als auch kontextbewusst ausführen können – und das mit einer bemerkenswerten Präzision und Vielseitigkeit. Die technologische Grundlage von UI-TARS basiert auf einem vision-language Modell, das speziell für die Interpretation von Bildschirminhalten und die Ableitung entsprechender Handlungsschritte entwickelt wurde.

Ausgestattet mit verstärktem Lernen kann das System seine Entscheidungen durch selbstständiges Nachdenken vor der Ausführung optimieren. Diese Fähigkeit führt zu einem deutlichen Fortschritt im Vergleich zu bisherigen KI-Agenten, die oft auf rein statistischen oder regelbasierten Verfahren beruhen. Das Resümee der jüngsten Updates zeigt eine verbesserte Leistungsfähigkeit in unterschiedlichen Benchmark-Tests, sowohl bei Desktop-Anwendungen als auch in mobilen Szenarien und sogar in komplexen virtuellen Spielwelten wie Minecraft. Besonders interessant ist die Skalierbarkeit und Adaptivität von UI-TARS. Die jüngste Generation, UI-TARS-1.

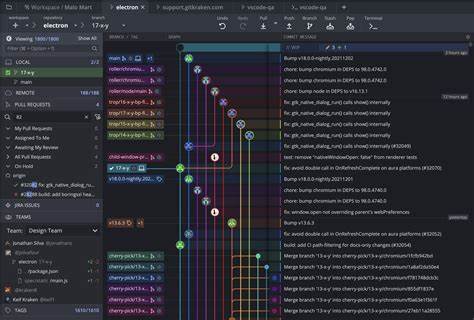

5, integriert Erkenntnisse aus fortschrittlichem Reinforcement Learning, die es erlauben, Entscheidungen während der Inferenzzeit zu verfeinern und so besser an spezifische Umgebungen und Aufgabenstellungen anzupassen. Dieses Merkmal macht das System nicht nur leistungsfähiger, sondern auch flexibler in der Anwendung – von der Routinebedienung am Computer bis hin zu anspruchsvollen Spiel- oder Browserszenarien. Die Open-Source-Präsenz auf GitHub ermöglicht es Entwicklern und Forschern weltweit, das Potenzial von UI-TARS direkt zu nutzen. Durch eine einfache Installation per Python-Paketmanagement können Anwender das Modell schnell zur Steuerung von grafischen Benutzeroberflächen einsetzen. Die Integration umfasst verschiedene Prompt-Vorlagen, die speziell auf unterschiedliche Nutzungsbereiche zugeschnitten sind.

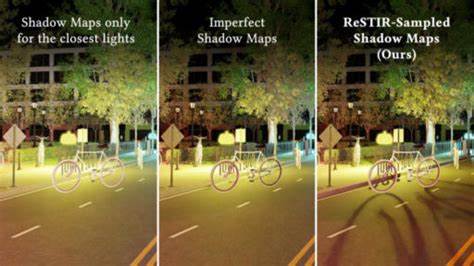

So unterstützt UI-TARS unter anderem Standard-Desktopaufgaben wie Mausaktionen, Tastatureingaben und Scrollen, passt sich aber ebenso an mobile Umgebungen mit typischen Apps und Gestensignalen an. Besondere Aufmerksamkeit verdient die Verarbeitung von Koordinaten, die für die präzise Interaktion mit GUI-Elementen essenziell ist. Im Gegensatz zu früheren Modellen verwendet UI-TARS absolute Koordinaten, um die Position von Objekten auf dem Bildschirm exakt zu bestimmen und anzusteuern. Diese Herangehensweise erhöht die Genauigkeit der ausgeführten Aktionen erheblich und vermeidet Fehler, die durch fehlerhafte Positionserkennung entstehen könnten. Entwickler erhalten umfangreiche Hilfestellungen und Visualisierungswerkzeuge, um die koordinatenbasierte Steuerung besser zu verstehen und zu optimieren.

Die Leistungsfähigkeit von UI-TARS lässt sich auch quantitativ anhand mehrerer Benchmark-Studien bewerten. In Testszenarien wie OSWorld, Windows Agent Arena oder WebVoyager erzielt UI-TARS-1.5 deutliche Vorteile gegenüber Konkurrenzmodellen wie OpenAI CUA oder Claude 3.7. Beispielsweise zeigt das System bei Aufgaben im Bereich Computerbenutzung eine hohe Erfolgsquote und glänzt zudem bei mobilen Anwendungen und Spielsteuerung.

Besonders bei der sogenannten „Grounding Capability“, also der Fähigkeit, Handlungskommandos in konkrete Aktionen umzusetzen, erzielt UI-TARS Spitzenwerte. In puncto Gaming hat UI-TARS ebenfalls beeindruckende Ergebnisse geliefert. Bei dem beliebten Poki-Spiele-Set schneidet das System nahezu perfekt ab und hinterlässt andere KI-Agenten deutlich hinter sich. Auch in der Minecraft-basierten Umgebung, wo komplexe Aufgaben aus dem Spielkontext gemeistert werden müssen, zeigt das Modell, dass es über einfache GUI-Interaktion hinaus glaubwürdig Situationen analysieren und darauf reagieren kann. Die Integration von Gedankengängen („Thought“) im Entscheidungsprozess führt hier zu besseren Performancedurchläufen und erhöht die Trefferquote bei schwierigen Spielhandlungen signifikant.

Dennoch ist UI-TARS nicht ohne Herausforderungen. Die enorme Rechenleistung, die das Modell benötigt, begrenzt teilweise den Einsatz in ressourcenschwachen Umgebungen oder bei langfristigen, aufwendigen Aktivitäten. Außerdem besteht das Risiko von Fehlinformationen und Fehlinterpretationen durch das Modell, wenn die visuelle Umgebung mehrdeutig oder ungewöhnlich gestaltet ist. Ein weiterer wichtiger Punkt ist die ethische Komponente: Da UI-TARS auch in der Lage ist, Sicherheitsmechanismen wie Captchas zu umgehen, besteht die potentielle Gefahr des Missbrauchs etwa für betrügerische Zwecke oder unautorisierte Automatisierungen. Hier investiert ByteDance in Sicherheitsüberprüfungen und regelt den Zugriff streng, um solche Risiken zu minimieren.

Die Zukunft von UI-TARS sieht vielversprechend aus. ByteDance kündigt bereits an, das Modell kontinuierlich weiterzuentwickeln und Forschern frühzeitigen Zugang zu gewähren, um gemeinsam neue Einsatzbereiche und Verbesserungen zu erforschen. Langfristig soll UI-TARS in der Lage sein, noch komplexere Aufgaben in realen Anwendungsfällen zu übernehmen – sei es im Bereich smarter Plattformen, automatisierter Dienstleistungsprozesse oder als Assistent in gamifizierten Lernszenarien. Diese Vision unterstreicht das Ziel, intelligente Agenten zu schaffen, die nahtlos mit menschlichen Nutzern zusammenarbeiten und die Digitalwelt zugänglicher und effizienter gestalten. Zusammenfassend lässt sich sagen, dass UI-TARS von ByteDance einen bedeutenden Schritt in der Entwicklung von AI-basierten GUI-Agenten darstellt.

Es kombiniert modernste KI-Methoden mit praktischer Anwendbarkeit und eröffnet neue Perspektiven für Automatisierung und Interaktion. Die Verfügbarkeit als Open-Source-Projekt macht es zu einem attraktiven Werkzeug für Entwickler, Unternehmen und akademische Forscher gleichermaßen und wird sicher eine wichtige Rolle in der Zukunft intelligenter Benutzerschnittstellen spielen.

![Implicit UVs: Real-time semi-global parameterization of implicit surfaces [pdf]](/images/090CB859-F55B-457A-ADF1-988138671EBB)