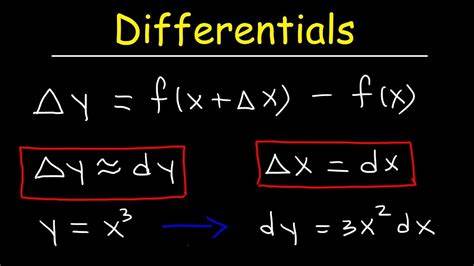

Die Geschichte der Analysis beginnt mit der Entstehung der Differenzialrechnung, deren Ursprung eng mit den Begriffen der Differentiale und Ableitungen verknüpft ist. Die Frage, was zuerst kam – die totalen Differentiale oder die partiellen Ableitungen – mag auf den ersten Blick simpel erscheinen, offenbart sich jedoch bei genauerer Betrachtung als überraschend komplex. Historisch gesehen waren Differentiale bereits im frühen 17. Jahrhundert ein etabliertes Konzept, während die systematische Definition partieller Ableitungen erst im 18. Jahrhundert erfolgte.

Die Entwicklung dieser Konzepte ist nicht nur eine Geschichte der mathematischen Entdeckungen, sondern auch der philosophischen und methodischen Auseinandersetzungen über grundlegende Begriffe wie das Unendlich Kleine und die Grenzwerte. Die Vorstellung eines Differenzials als „infinitesimaler“ Zuwachs wurde bereits in den frühen Werken von Mathematikern wie Leibniz klar formuliert. Als unendlich kleine, aber nicht nullwertige Größen verstanden, ermöglichten Differenziale eine intuitive Behandlung von Veränderungen, die später die Grundlage für den Begriff der Ableitung bildeten. Im 17. Jahrhundert war der Umgang mit solchen infinitesimalen Mengen noch unscharf, doch Mathematiker wie Newton und Leibniz erfanden Methoden, um diese Konzepte in lohnenswerte Rechenoperationen zu verwandeln.

Die Arbeit der Bernoulli-Brüder sowie des Marquis de l’Hôpital trug wesentlich dazu bei, die Regeln für die Differenzialrechnung systematisch niederzulegen. L’Hôpitals erstes Lehrbuch der Differentialrechnung aus dem Jahr 1696 fasste viele dieser Erkenntnisse zusammen und präsentierte unter anderem die Summe- und Produktregeln für Differentiale. Während in der Anfangszeit der Analysis zum Großteil algebraische Gleichungen untersucht wurden, führte das Konzept der Funktionen erst im 18. Jahrhundert zu einer tiefgreifenden Erweiterung der mathematischen Möglichkeiten. Die Funktion als Beziehung zwischen Variablen erlangte mit Mathematikern wie Johann Bernoulli und Leonhard Euler eine erste klare Gestalt, auch wenn in den meisten frühen Arbeiten Funktionen noch stark mit geometrischen Vorstellungen verknüpft waren.

Euler definierte Funktionen als analytische Ausdrücke der Variablen, was einerseits die Handhabung erleichterte, andererseits jedoch das Spektrum der Funktionen einschränkte. Erst im späten 19. Jahrhundert gelang mit Dedekind und anderen eine abstraktere, allgemeinere Definition, welche die Grundlage der modernen Funktionstheorie bildet. Eine Herausforderung der frühen Analysis war die mangelnde Strenge im Umgang mit infinitesimalen Größen, die einem Gegenstand zwischen Null und jeder positiven Zahl ähnelten, jedoch nicht null waren. Gottfried Wilhelm Leibniz umging philosophische Probleme, indem er die Differentiale als willkürliche, aber kleine Größen definierte, während Johann Bernoulli und L’Hôpital ihre postulativen Annahmen über deren Verhalten formulierten.

Diese Denkweisen ermöglichten effiziente Berechnungen, führten jedoch zu Kritik, etwa von George Berkeley, der 1734 in „The Analyst“ die mathematische Logik der Zeit als nicht überzeugend angriff. Newton hingegen entwickelte sein „Verfahren der ersten und letzten Verhältnisse“, das auf geometrischer Grundlage die Analyse mit Grenzwerten näher erläuterte. Im 18. und 19. Jahrhundert wurde das Konzept der Grenzwerte zur fundamentalen Basis der Analysis weiterentwickelt.

Mit Thinkern wie Colin Maclaurin, d’Alembert und besonders Augustin-Louis Cauchy wurde das wissenschaftliche Fundament für den Grenzwertbegriff gelegt und schließlich zu einer rigorosen Definition ausformuliert. Cauchy beschrieb den Grenzwert als eine Größe, der sich die Werte der Variablen annähern, ohne explizit Epsilon-Delta-Begriffe einzuführen, wie sie später entwickelt wurden. Diese formalisierten Grenzwerte machten es möglich, die Differentialrechnung fehlerfrei und logisch konsistent zu begründen und legten auch den Grundstein für die Integralrechnung und Partielle Differentialgleichungen. Parallel zu diesen Entwicklungen versuchte Joseph-Louis Lagrange einen anderen Weg, die Analysis zu fundieren. Sein Ansatz basierte auf der Theorie der Potenzreihen, mit dem Ziel, den Begriff der Ableitung durch die Manipulation von Potenzreihen zu ersetzen.

Diese algebraische Herangehensweise zeigte beeindruckende Ergebnisse, konnte jedoch nicht alle Probleme der Konvergenz lösen und blieb daher nicht die alleinige Grundlage der Analysis. Dennoch beeinflusste diese Sichtweise die nachfolgenden Mathematiker, wie François-Joseph Servois, der wichtige Begriffe wie Distributivität und Kommutativität prägte und versuchte, die Differentialrechnung mithilfe von Operatoren und Reihen darzustellen. Über Jahrhunderte hinweg blieb die Verwendung von infinitesimalen Größen ein kontroverses Thema. Im 20. Jahrhundert erarbeitete Abraham Robinson eine mathematisch strenge Form der Infinitesimalrechnung, die sogenannte Nichtstandard-Analyse.

Er konstruierte einen erweiterten Zahlenbereich, die hyperreellen Zahlen, der sowohl unendlich große als auch unendlich kleine Zahlen enthält. Mit diesem erweiterten Zahlenraum konnten die alten intuitiven Vorstellungen von Leibniz formal und logisch konsistent umgesetzt werden. Die hyperreellen Zahlen erlauben eine Wiedergeburt der Infinitesimalmethoden, ohne Einbußen bei der Präzision und Rigorosität, die moderne Analysis erfordert. Aus heutiger Sicht ist der Übergang von Differenzialen zu Ableitungen nicht nur eine reine Geschichtsstunde, sondern verdeutlicht die tiefe Verbindung zwischen intuitiven mathematischen Objekten und ihrem formalen, axiomatischen Fundament. Moderne Analysis bildet heute das Rückgrat zahlreicher Disziplinen – von der theoretischen Physik über Ingenieurwesen bis hin zur Finanzmathematik.

Das Verständnis der historischen Entwicklung hilft, diese vielfältigen Anwendungen in einen größeren Kontext einzuordnen und gewährt Einblick in die kreative Arbeit der Mathematiker, die unser heutiges Verständnis möglich gemacht haben. Die Bedeutung von Funktionen und Limits zeigte sich besonders in den Arbeiten Eulers, dessen „Introductio in analysin infinitorum“ als prägende Vorstufe zur Analysis gilt. Eulers Umgang mit Reihenentwicklungen und seine Herleitungen grundlegender Reihen, etwa der Exponentialreihe, belegt die Genialität seines offenen, aber dennoch weitgehend korrekten Umgangs mit infinitesimalen Größen. Seine Arbeit diente später als Blaupause für die präzisere Analyse mit Grenzwerten. In der multivariaten Analysis, die mit klassischen Differenzialen für Funktionen von zwei oder mehr Variablen begann, entwickelte sich schließlich die Theorie der partiellen Ableitungen und totalen Differentiale.

Diese Struktur ermöglichte die Behandlung komplexerer realweltlicher Probleme, beispielsweise in der Physik und der Mechanik. Die Betrachtung infinitesimaler Flächen- und Volumenelemente führte zur Entstehung der heutigen Differenzialgeometrie und partiellen Differentialgleichungen. Die Diskussion um die Definitionen von Differenzialen und Ableitungen zeigt exemplarisch den Übergang von anschaulich-intuitiven Begriffen zu formalisierten, rigorosen Konzepten, die moderne Mathematik so unverzichtbar macht. Die Wiederaufnahme der Infinitesimalidee im 20. Jahrhundert durch Robinson spiegelt das Prinzip der Mathematik wider: Sie ist ein lebendiges Feld, in dem alte Ideen neu interpretiert und weiterentwickelt werden können, sofern die logische Genauigkeit gewährleistet bleibt.

Insgesamt lässt sich sagen, dass die Entwicklung von Differenzialen zu Ableitungen ein eindrucksvolles Kapitel in der Geschichte der Mathematik darstellt. Von der Einführung des infinitesimalen Denkens über die Suche nach soliden Grundlagen bis zur modernen Notation und Anwendung hat sich ein reichhaltiges, faszinierendes Geflecht herausgebildet, das heute integraler Bestandteil der mathematischen Ausbildung und Forschung ist. Die vielen historischen Figuren – von Leibniz und Newton über Bernoulli und L’Hôpital bis hin zu Euler, Cauchy, Lagrange und Robinson – haben jeweils auf ihre Weise bedeutende Mosaiksteine gelegt, die das Bild der Analysis formen.