Die Fortschritte im Bereich computergenerierter Bilder setzen die Forschung nach effizienteren und leistungsfähigeren Verfahren zur Darstellung und Berechnung von 3D-Geometrien kontinuierlich unter Druck. Klassische Algorithmen und Strukturen, insbesondere Bounding Volume Hierarchies (BVHs), sind seit Jahrzehnten das Fundament für die Beschleunigung von Schnittstellenberechnungen beim Raytracing, das als ein Standardverfahren für fotorealistische Bildgenerierung gilt. Dennoch stoßen traditionelle Ansätze bei der Nutzung moderner Grafikprozessoren an ihre Grenzen, vor allem wegen divergenten Kontrollflüssen und unvorhersehbaren Speicherzugriffen. Die Integration von neuronalen Netzwerken in die Geometrie-Repräsentation eröffnet nun völlig neue Perspektiven und kann die Leistungsfähigkeit von 3D-Renderings signifikant steigern. Monte-Carlo-Raytracing simuliert das komplexe Verhalten von Lichtstrahlen in virtuellen 3D-Umgebungen und erfordert für jede Lichtstrahl-Szene-Interaktion umfangreiche Berechnungen.

Von zentraler Bedeutung sind dabei Schnittpunkttests, also das Erkennen, an welchen Stellen ein Lichtstrahl mit Objekten kollidiert. Die Effizienz dieser Tests bestimmt maßgeblich die Renderzeit. BVHs bündeln geometrische Primitive und ermöglichen so eine Reduktion der Anzahl von Schnittpunktberechnungen, indem sie grob begrenzende Volumen nutzen. Jedoch sind diese Hierarchien schwer begreifbare Strukturen für moderne parallele Prozessorarchitekturen wie GPUs, welche am effizientesten funktionieren, wenn Berechnungen mit uniformem und vorhersehbarem Ablauf simultan durchgeführt werden. Genau hier zeigen neuronale Netzwerke ihr Potenzial.

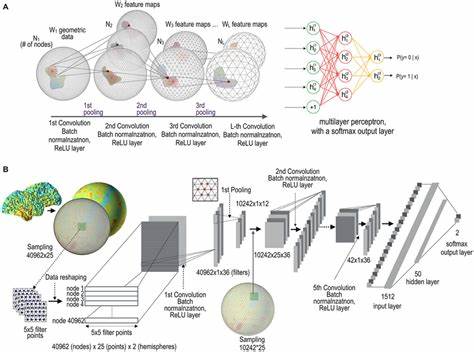

Insbesondere vollständig verbundene Netzwerke mit multilayer perceptrons (MLPs) arbeiten überwiegend anhand großer, gut optimierbarer Matrixmultiplikationen. Diese Berechnungsmuster sind ideal auf die Hardware für paralleles Rechnen abgestimmt. Die Idee, klassische BVH-Traversierung durch neuronale Netzwerke zu ersetzen oder zu ergänzen, gewinnt daher zunehmend an Bedeutung. So kann eine regulärere und hardwareeffizientere Verarbeitung realisiert werden, was zu dramatischen Zeitersparnissen bei gleichbleibender Bildqualität führen kann. Die Neural Intersection Function (NIF), ein von AMD im Jahr 2023 eingeführtes Konzept, markiert einen Meilenstein auf diesem Gebiet.

Anstatt die prototypische, jedoch unstrukturierte und divergente Traversierung von BVHs zu nutzen, setzt NIF ein zweigeteiltes neuronales Netz ein, das aus einer äußeren und einer inneren Komponente besteht. Diese behandeln Strahlen, die außerhalb beziehungsweise innerhalb der Objektgrenzen agieren. Durch die Verwendung von Gittercodierung, bei der räumliche Merkmale organisiert werden, und der Evaluierung mittels MLPs wird ein äußerst effizienter Rechenprozess ermöglicht. Dabei ersetzt NIF die komplexen Branching-Strukturen durch konsistente, parallele Matrixoperationen, die sich hervorragend für GPUs eignen und vorhandene Hardwarefunktionen wie AMD Matrix Cores oder NVIDIA Tensor Cores optimal nutzen. Die Leistungsfähigkeit von NIF zeigt sich darin, dass die Zeit für die Berechnung von sekundären Lichtstrahlen, etwa für direkte Beleuchtung, im Vergleich zu klassischen BVH-Methoden um bis zu 35 % reduziert werden kann, ohne Kompromisse bei der Bildqualität eingehen zu müssen.

Dennoch bringt NIF einige Herausforderungen mit sich. So ist eine zeitintensive Online-Training-Phase notwendig, die für jeden Blickwinkel neu durchgeführt werden muss. Zudem bleibt das System während des Trainings weiterhin auf herkömmliche BVHs angewiesen und ist gegenwärtig nur auf Schattenstrahlen beschränkt. Um diese Beschränkungen zu überwinden, wurde das Locally-Subdivided Neural Intersection Function (LSNIF) Konzept entwickelt. LSNIF geht einen Schritt weiter und wandelt das neuronale Modell von einer szene- und sichtwinkelabhängigen Lösung in eine objektzentrierte, vortrainierte Methode um.

Jedes Objekt erhält ein eigenes, viewpoint-unabhängiges Modell, das offline trainiert wird und sich somit in beliebigen Szenen und aus beliebigen Perspektiven wiederverwenden lässt. Diese Objektmodelle beruhen auf einer Kombination aus voxelbasierter Geometrie, sparsamer Mehrfrequenz-Gittercodierung und kompakten MLPs. Durch diese Änderungen kann LSNIF vielfältige Strahltypen unterstützen – vom primären Sichtstrahl über Schatten- bis hin zu reflektierten Strahlen –, wodurch die Anwendbarkeit für moderne Pfadverfolgungsalgorithmen im Rendering deutlich erweitert wird. Zudem kann LSNIF detaillierte Oberflächeneigenschaften vorhersagen, wie Sichtbarkeit, Oberflächennormalen, Treffpunkte oder Materialzuordnungen, was eine reichhaltige und realistische Darstellung ermöglicht. Eine der großen Herausforderungen im Bereich neuronaler Schnittpunkterkennung ist das sogenannte Ray Aliasing.

Dabei führen nahe beieinanderliegende oder ähnliche Strahlen zu Verwirrungen innerhalb des Modells, da für diese trotz ähnlicher Richtung unterschiedliche Daten entscheidend sind. NIF milderte dieses Problem bereits durch die Nutzung von Treffpunkten anstatt der Ursprünge als Netzwerkeingaben, aber nur in einem begrenzten Kontext. LSNIF löst dies robuster durch lokale Voxelrasterisierung der Objektoberflächen, welche in einem niederdimensionalen Gitter gespeichert und mit einem Digital Differential Analyzer (DDA) Algorithmus verarbeitet werden. So entstehen präzise und unterscheidbare Eingabedaten, die das Netzwerk besser lernen und generalisieren lassen. Die Verwendung sparsamer mehrstufiger Hash-Gitter zur Kodierung der Voxelgrenzen senkt außerdem drastisch den Speicherbedarf im Vergleich zu dicht besetzten Gittern.

Dadurch wird die Verarbeitung schneller und ressourcenschonender, was insbesondere für Anwendungen mit limitiertem Arbeitsspeicher von Vorteil ist. Gemäß der Architektur von LSNIF kommt auf jedes Objekt ein kompaktes neuronales Netz, das mehrere Eigenschaften gleichzeitig vorhersagen kann. Dies ermöglicht einen kombinierten Vorhersagedurchlauf, der gegenüber separaten Modellen erheblich schlanker und schneller ist. Die Unterstützung verschiedener Materialien je Objekt sorgt für eine größere visuelle Vielfalt und realistischere Renderings, wie sie in hochwertigen Produktionen erwartet werden. Die visuelle Qualität von LSNIF-Renderings steht herkömmlichen BVH-basierten Ergebnissen in nichts nach.

Tests zeigen, dass selbst bei komplexen Schattenwürfen oder Kantenschärfen der qualitative Unterschied kaum auffällt. Quantitative Fehleranalysen wie FLIP-Maps bestätigen den Erhalt der Wahrnehmungsgenauigkeit. Zudem bewährt sich LSNIF in dynamischen Szenarien mit bewegten Objekten und wechselnden Beleuchtungsverhältnissen, was seine Eignung für Echtzeit- und interaktive Anwendungen unterstreicht. Die Integration von LSNIF in etablierte Raytracing-Pipelines ist ebenfalls gelungen. So lässt sich LSNIF als benutzerdefinierter Intersection Shader in der Microsoft DirectX® Raytracing (DXR) API betreiben.

Hierbei werden statt geometrischer Primitive neuronale Netzwerke verwendet, um Schnittstellen zu erkennen, was auch die Verwendung bei primären sowie sekundären Strahlen ermöglicht. Beispiele hierfür sind Szenen mit mehrfach instanzierten Stanford Bunny Modellen, die vollständig ohne konventionelle Geometriedaten und BVH-Strukturen auskommen und ihre Raumabfragen vollständig per Neural Inference erledigen. Die Vorteile liegen auf der Hand: Neben der schrittweisen Abschaffung komplexer Hierarchie- und Speicherverwaltungssysteme erlauben neuronale Netzwerke ein effizienteres GPU-Mapping, was für künftige Generationen von Grafikprozessoren ein vielversprechender Ansatz ist. Verbesserungen der GPU-Programmiermodelle könnten in Zukunft neuronale implizite Oberflächen als Kernbestandteil professioneller Renderlösungen etablieren. Die Forschung rund um NIF und LSNIF ist noch jung, aber bereits sehr aussichtsreich.

Sie zeigt, wie Machine Learning und Deep Learning traditionelle Verfahren in der Computergrafik neu definieren können. Die Kombination aus Hardwareeffizienz, Skalierbarkeit, schneller Inferenz und der Fähigkeit zur Darstellung vielseitiger geometrischer und materialbezogener Eigenschaften schiebt die Grenzen für realistische und performante 3D-Darstellungen deutlich voran. Für Grafikentwickler und Forscher eröffnen sich so neue Möglichkeiten, komplexe Szenen mit hoher visueller Qualität in Echtzeit oder in kürzerer Zeit zu rendern. Die Vorteile erstrecken sich über Echtzeitanwendungen wie Videospiele und virtuelle Realität bis hin zu kinoreifer Offline-Rendering-Produktion. Als nächste Schritte der Forschung werden nicht nur die Weiterentwicklung der Netzarchitekturen und Trainingsverfahren erwartet, sondern auch die Integration weiterer Sensordaten oder adaptiver Modelle, die das Rendering noch adaptiver und präziser gestalten könnten.

Dadurch könnten neuronale Netzwerke künftig nicht nur die Geometrie, sondern auch komplexe physikalische Effekte und Materialien umfassend in der Pipeline abbilden. Insgesamt zeigt der Einsatz neuronaler Netzwerke für geometrische Repräsentationen einen bedeutenden Paradigmenwechsel, der das traditionelle Rendering revolutionieren und die kreative Freiheit in der computergenerierten Bildwelt erheblich erweitern wird.