Die Houston Housing Authority (HHA), eine bedeutende Einrichtung zur Verwaltung und Bereitstellung von bezahlbarem Wohnraum, befindet sich aktuell in einer ungewöhnlichen rechtlichen Auseinandersetzung. Im Zentrum des Konflikts steht ein eingereichtes Rechtsgutachten, welches zahlreiche Ungereimtheiten und offenkundige Fehler aufweist, die Experten auf die Nutzung sogenannter „Large Language Models“ (LLM) zurückführen. Diese KI-gestützten Modelle, darunter bekannte wie GPT-4, sind mittlerweile in der Lage, komplexe Texte zu generieren – allerdings nicht frei von Fehlern, insbesondere sogenannten Halluzinationen. Diese Fehlinformationen, die von der KI ohne echte sachliche Grundlage erfunden werden, bilden den Kern des diskutierten Problems. Der Fall der Houston Housing Authority wirft somit ein Schlaglicht auf den verantwortungsbewussten Einsatz von Künstlicher Intelligenz im juristischen Bereich und die Implikationen für die Rechtssicherheit und ethisches Handeln.

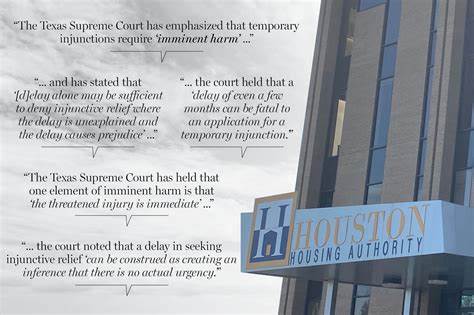

Während KI-Tools in vielen Branchen bereits als wertvolle Hilfsmittel etabliert sind, zeigt sich bei der juristischen Dokumentenerstellung eine weitaus kritischere Perspektive. Kompetente juristische Beratung erfordert nicht nur juristisches Fachwissen, sondern auch Verantwortungsbewusstsein und Sorgfalt, die bislang von intelligenten Maschinen nur bedingt geleistet werden können. Die Einreichung eines Rechtsgutachtens, das fehlerhafte Informationen enthält, kann gravierende Folgen haben: Das Gericht und die betroffenen Parteien riskieren Fehleinschätzungen, beeinträchtigte Prozessführung und im schlimmsten Fall ungerechte Entscheidungen. Die spezifischen Halluzinationen im HHA-Rechtsgutachten betreffen unter anderem falsche Rechtsnormen, erfundene Präzedenzfälle und unplausible Argumentationsketten. Diese Mängel konnten von richterlicher Seite und gegnerischer Anwaltschaft zeitnah erkannt und benannt werden.

Allerdings führte dies bereits zu Verzögerungen im Verfahrensablauf sowie zu einer Anfrage nach einer Revision oder Neuverfassung des Dokuments durch qualifizierte Juristen ohne KI-Beteiligung. Der Einsatz von LLM-Technologie im rechtlichen Umfeld ist nicht grundsätzlich zu verwerfen, wenn klare Grenzen und Kontrollen definiert sind. Die Houston Housing Authority wird wohl künftig auf eine strikte Überprüfung der Inhalte durch erfahrene Fachkräfte setzen müssen, bevor KI-generierte Texte eingereicht werden. Darüber hinaus ruft dieser Fall dazu auf, die Regulierungen und Standards zum Einsatz von KI im Rechtswesen zu überdenken. Ethik und Rechtssicherheit müssen im Vordergrund stehen, damit solche Technologien nicht zu einem Risiko, sondern zu einer Verbesserung der juristischen Arbeit führen.

Interessant ist auch die Debatte um mögliche Haftungsfragen bei Schäden, die durch KI-Fehler entstehen. Wer trägt die Verantwortung, wenn eine KI ein fehlerhaftes Rechtsdokument erstellt? Die menschlichen Anwender, die Entwickler der KI oder die Einrichtung, die das Dokument einreicht? Der Fall der Houston Housing Authority liefert ein aktuelles Beispiel für die Komplexität, die hinter der Integration moderner Technologien in traditionelle Berufsfelder steckt. Vor diesem Hintergrund gewinnen Schulung und Sensibilisierung für den sachgerechten Umgang mit KI zunehmend an Bedeutung. Juristische Fachanwälte müssen nicht nur ihre fachlichen Kompetenzen ausbauen, sondern auch verstehen, wie KI-Modelle funktionieren und welche Risiken deren Nutzung birgt. Nur durch eine enge Verzahnung von juristischem Expertenwissen und technischer Überwachung können Fehlinformationen vermieden werden.

Der eingeschlagene Weg der Houston Housing Authority zeigt, dass die versprochene Effizienzsteigerung durch Künstliche Intelligenz kein Freibrief für Nachlässigkeit ist. Qualitätskontrolle und menschliche Verantwortung bleiben essenziell, um die Integrität des Rechtssystems zu schützen. In einer Zeit, in der digitale Innovationen in immer mehr Arbeitsprozesse Einzug halten, muss das Rechtssystem besonders sorgfältig gewährleisten, dass technologischer Fortschritt nicht auf Kosten der Rechtsklarheit und Gerechtigkeit geht. Der Fall der Houston Housing Authority ist ein Lehrstück für alle Institutionen und Unternehmen, die Künstliche Intelligenz produktiv einsetzen wollen. Er erinnert daran, dass Technik nur ein Werkzeug ist, dessen Wert maßgeblich vom verantwortungsbewussten Umgang abhängt.

Die Zukunft der juristischen Arbeit wird wahrscheinlich hybrid sein – ein Zusammenspiel aus menschlicher Expertise und technologischer Unterstützung. Umso wichtiger ist es, heute die Weichen richtig zu stellen, damit die Chancen der KI genutzt und die Risiken minimiert werden. Insgesamt steht der Fall der Houston Housing Authority stellvertretend für die Herausforderungen eines digitalisierten Rechtsalltags. Die Frage, wie Vertrauen und Zuverlässigkeit in KI-basierte Prozesse hergestellt werden können, bleibt hochaktuell. Nur durch klare Richtlinien, transparente Verfahren und den Erhalt menschlicher Kontrolle kann eine Balance gefunden werden.

Letztlich zeigt dieses Beispiel, dass Innovation und Tradition Hand in Hand gehen müssen, um auch in Zukunft ein faires und funktionierendes Rechtssystem sicherzustellen.