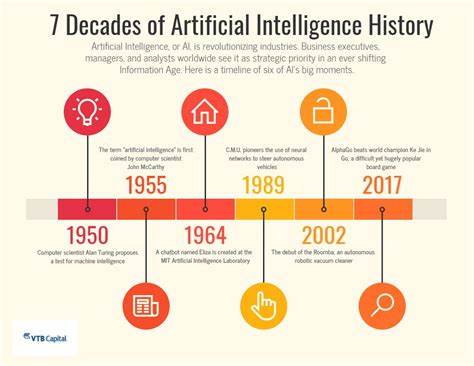

In der Welt der Informationsverarbeitung gelten Datenbanksysteme (DBMS) seit Jahrzehnten als unverzichtbare Werkzeuge, um große Mengen an Daten effizient zu speichern, zu verwalten und zugänglich zu machen. Die klassischen Lehrmeinungen, die in nahezu jedem Informatikstudium vermittelt werden, basieren auf bewährten Konzepten wie relationalen Datenbanken, ACID-Transaktionen und universellen Datenmodellen. Doch Prof. Michael Stonebraker, eine Ikone auf dem Gebiet der Datenbanksysteme und Gewinner des Turing-Awards, widerspricht dieser universellen Sichtweise entschieden. In seinem provokanten Vortrag „One Size Fits None – Everything You Learned in Your DBMS Class is Wrong“ fordert er ein Umdenken, das weit über die bisherigen Paradigmen hinausgeht und die Traditionen in Frage stellt, die seit Jahrzehnten als Standard gilt.

Stonebrakers Argumentation beginnt mit der Feststellung, dass der Markt und die Datenanforderungen heute vielfältiger und spezialisierter sind als jemals zuvor. Klassische relationale Datenbanken wurden ursprünglich entwickelt, um allgemeine Anforderungen abzudecken und Transaktionen in homogener Umgebung zuverlässig zu behandeln. Doch die Realität moderner Anwendungen unterscheidet sich grundlegend: riesige Datenvolumen, unterschiedliche Datenformate, schnellere Verarbeitungserfordernisse und vielfältige Zugriffsmuster verlangen nach maßgeschneiderten Lösungen. Das zentrale Mantra von Stonebraker lautet deshalb, dass es keine universelle Datenbanklösung gibt, die in jeder Domäne und für jede Aufgabe optimal funktioniert. Ein „One Size Fits All“-Ansatz ist zum Scheitern verurteilt.

Diese Sichtweise ist nicht nur eine theoretische Kritik, sondern beruht auch auf Stonebrakers praktischem Wirken an diversen bahnbrechenden Projekten. Als Schöpfer oder maßgeblicher Entwickler von Systemen wie Ingres, Postgres, VoltDB und SciDB hat er mehrfach bewiesen, dass spezialisierte Datenbanken, die für bestimmte Anforderungen ausgelegt sind, deutlich bessere Ergebnisse liefern können als traditionelle, universal angelegte Systeme. So hat Ingres die relationale Datenbankwelt maßgeblich geprägt, während Postgres flexible Erweiterungen und objekt-relationale Ansätze einführte. VoltDB hingegen zeigt, wie NewSQL-Datenbanken extrem schnelle Transaktionsverarbeitung ermöglichen, und SciDB zielt auf Wissenschaftsdaten mit multidimensionalen Datentypen ab. Das Konzept des Spezialisierens und Optimierens wurde von Stonebraker als „polymorpher Datenbankansatz“ beschrieben – die Idee, dass Datenbanken nicht als monolithisches System existieren, sondern als maßgeschneiderte Lösungen, die auf Anwendungsfälle abgestimmt sind.

Dieses Prinzip widerspricht der bisherigen Lehre, dass ein einzelnes System alle Bedürfnisse abdecken kann. Natürlich hat diese Forderung weitreichende Konsequenzen für Entwickler, Unternehmen und die Wissenschaft: die Komplexität in der Auswahl, Integration und Wartung verschiedener Systeme steigt, doch der Nutzen in Hinblick auf Leistung und Skalierbarkeit rechtfertigt den Mehraufwand. Ein weiterer wichtiger Punkt in Stonebrakers Kritik betrifft die traditionellen ACID-Eigenschaften (Atomicity, Consistency, Isolation, Durability), die seit Jahrzehnten als Goldstandard für Zuverlässigkeit gelten. Gerade im Zeitalter von Big Data und Cloud-Anwendungen zeigen sich jedoch Grenzen. Stonebraker betont, dass in manchen Szenarien andere Modelle, etwa BASE (Basically Available, Soft state, Eventually consistent), sinnvoller sind und bessere praktische Resultate liefern.

Die Maxime „strikte Konsistenz um jeden Preis“ muss hinterfragt werden, um moderne Anforderungen an Verfügbarkeit, Partitionstoleranz und enorme Datenmengen zu erfüllen. Ein zentrales Element in seinem Vortrag ist die Sicht auf die Weiterentwicklung der Technologie in den letzten Jahren. Hardware wird immer spezieller und leistungsfähiger. Prozessorarchitekturen, Hauptspeichergrößen, Netzwerkbandbreiten und Speichertechnologien differenzieren sich enorm. Gleichzeitig entstehen durch mobile Geräte, IoT, Echtzeitanalysen und maschinelles Lernen neue Workloads mit ganz eigenen Anforderungen.

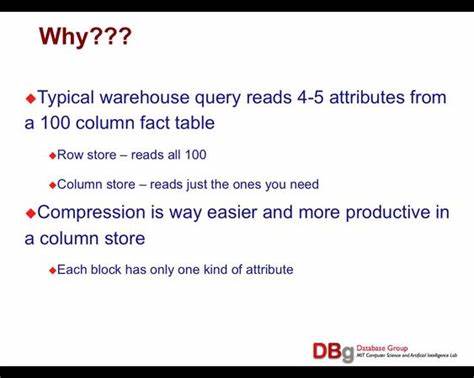

Stonebraker argumentiert, dass Datenbankdesigner diese hardwareseitigen Möglichkeiten viel fokussierter nutzen müssen. Alte Systeme, die für eine andere Welt konstruiert wurden, können mit den modernen Möglichkeiten nicht Schritt halten. Hier entsteht ein enormer Innovationsbedarf. Ein spannender Aspekt, den Stonebraker hervorhebt, ist auch die Rolle von Cloud-Umgebungen und verteilten Systemen. Der Trend zu cloudnativen Architekturen, Microservices und skalierbaren Plattformen erfordert neue Denkweisen beim Datenmanagement.

Das starre monolithische Modell wird durch modulare, flexible und verteilte Systeme ersetzt. Dabei entstehen aber neue Herausforderungen bei Konsistenz, Latenz und Fehlerbehandlung. Stonebraker sieht darin sowohl eine Chance als auch eine zwingende Notwendigkeit, traditionelle Paradigmen zu überdenken und individuell angepasste Lösungen zu entwickeln. Seine Kritik an traditionellen DBMS-Prinzipien hat weitreichende Auswirkungen auf Lehre und Praxis. Für Studierende und Ausbilder bedeutet es, das Fachwissen anzupassen und mit modernen Entwicklungen zu ergänzen.

Statt sich ausschließlich auf relationale Modelle und ACID-Transaktionen zu konzentrieren, müssen auch NoSQL-Datenbanken, NewSQL-Konzepte, Stream-Processing und spezialisierte Systeme in den Mittelpunkt rücken. Unternehmen sollten ihre Infrastruktur kritisch hinterfragen und gezielt hybride oder spezialisierte Plattformen einsetzen, um unter den unterschiedlichen Anwendungsszenarien optimale Ergebnisse zu erzielen. Zusammenfassend lässt sich sagen, dass Michael Stonebrakers Auffassung einen Paradigmenwechsel in der Datenbankwelt markiert. Die Aussage, dass „alles, was man im DBMS-Kurs gelernt hat, falsch sein könnte“, ist provokativ, dient aber der Anregung zur Reflexion über den Stand der Technik und zukünftige Herausforderungen. Vielfalt, Spezialisierung und Flexibilität werden immer wichtiger, da die Realität heutiger Datenverarbeitung kaum noch durch ein einziges Modell abzubilden ist.

Damit steht die Datenbankforschung und Entwicklung an einem spannenden Wendepunkt. Die Balance zwischen theoretischer Fundierung und praktischer Anpassung ist schwieriger denn je – doch die Innovationen, die durch spezialisierte Systeme und neue Architekturen entstehen, können das Fundament für die nächsten Jahrzehnte der digitalen Zukunft bilden. Wer sich auf diese neue Realität einstellt, profitiert von höherer Effizienz, Skalierbarkeit und besserer Anpassungsfähigkeit an die komplexen Anforderungen moderner Datenwelt.