Die rasante Entwicklung moderner Informations- und Kommunikationstechnologien basiert maßgeblich auf dem Verständnis von Kanalkapazitäten und deren Grenzen. Das Shannon-Hartley-Theorem stellt dabei einen Meilenstein dar, der die maximale Datenrate definiert, mit der Informationen fehlerfrei über einen Rausch-behafteten Kommunikationskanal mit begrenzter Bandbreite übertragen werden können. Es handelt sich um ein fundamentales Ergebnis in der Informationstheorie, das sowohl theoretische Grundlagen als auch praktische Anwendungen im Kommunikationssektor miteinander verbindet. Ursprünge und historische Bedeutung des Theorems Die Ursprünge des Shannon-Hartley-Theorems liegen in den bahnbrechenden Arbeiten von Ralph Hartley Ende der 1920er Jahre sowie Claude Shannon in den 1940er Jahren. Hartley formulierte erste Konzepte, die sich mit der Begrenzung der Informationsübertragung in einem Kanal mit endlicher Bandbreite befassten.

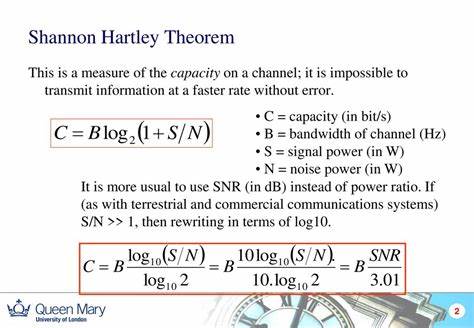

Sein sogenanntes Hartley-Gesetz stellt eine Proportionalität zwischen der Bandbreite eines Kanals und der maximal möglichen Datenrate her, wobei er die Begrenzung durch die Signalwerte untersuchte. Später gelang es Claude Shannon, diese Grundideen weiterzuentwickeln und formal in der Informationstheorie zu verankern. Shannons Nachweis, dass es eine obere Grenze (die Kanalkapazität) für die fehlerfreie Übertragungsrate gibt, stellte das Fundament für das Noisy-Channel-Coding-Theorem dar. Das Shannon-Hartley-Theorem verknüpft diese Erkenntnisse dazu mit konkreten Modellen des Rauschens in Kanälen. Die mathematische Grundlage Das Herzstück des Shannon-Hartley-Theorems ist die Formel für die Kanalkapazität C: C = B * log2(1 + S/N) Dabei bezeichnet C die maximale fehlerfreie Datenrate in Bit pro Sekunde, B ist die Bandbreite des Übertragungskanals in Hertz, S die mittlere Leistung des empfangenen Signals und N die Leistungsstärke des Rauschens innerhalb der Bandbreite.

Der Quotient S/N entspricht dem Signal-Rausch-Verhältnis (SNR) am Empfänger, wobei dieser Wert linear und nicht in Dezibel dargestellt wird. Die Funktion log2(1 + S/N) beschreibt den Effizienzgewinn durch das Signal-Rausch-Verhältnis. Je höher dieser Wert ist, desto mehr Information können pro Hertz Bandbreite übertragen werden. Allerdings unterliegt sowohl die Bandbreite als auch das SNR natürlichen und technischen Begrenzungen, sodass es stets eine Maximumsrate gibt. Physikalische Bedeutung und praktische Auswirkungen In realen Kommunikationssystemen ist das SNR oft durch Umgebungsrauschen, Störeinflüsse und technische Limitationen begrenzt.

Außerdem entsteht nicht beliebig große Bandbreite einfach so, da Frequenzspektrum Ressourcen sind, die reguliert und geteilt werden müssen. Damit definieren diese Parameter die praktisch erreichbare Balance zwischen Datenrate, Zuverlässigkeit und Übertragungsqualität. Die Bedeutung des Theorems zeigt sich beispielsweise bei Mobilfunknetzen, Satellitenkommunikation oder Breitbandinternet. Systemingenieure können mit dem Shannon-Hartley-Theorem das absolute Limit der Übertragungsrate abschätzen und darauf basierend modulieren, codieren und das Übertragungsverfahren optimieren. Zusammenhang mit anderen Konzepten der Informationstheorie Das Shannon-Hartley-Theorem steht in engem Zusammenhang mit anderen wesentlichen Konzepten wie dem Nyquist-Satz und dem Noisy-Channel-Coding-Theorem.

Der Nyquist-Satz definiert die maximale Symbolrate bei beschränkter Bandbreite, wohingegen Hartleys Arbeiten über die Anzahl der Signalstufen (M-Level) den möglichen Informationsgehalt pro Symbol beschreiben. Shannon verband diese Ideen und beantwortete die Frage, wie sich trotz Rauschen eine fehlerfreie Datenübertragung sicherstellen lässt, wenn die Datenrate unter der Kapazitätsgrenze bleibt. Der Einsatz von modernen Fehlerkorrekturverfahren wie Turbo-Codes oder Low-Density-Parity-Check-Codes bringt die Übertragungsraten näher an diese Grenze heran, ohne die Zuverlässigkeit nennenswert zu beeinträchtigen. Erweiterungen und Besonderheiten Das einfache Modell des Shannon-Hartley-Theorems setzt additive weiße Gaußsche Rauschprozesse voraus, also gleichverteiltes Rauschen über die Frequenz. In der Praxis kann es jedoch auch frequenzabhängiges Rauschen oder andere Störquellen geben.

Dafür wurde das Theorem verallgemeinert, indem es die Kanalbandbreite in kleinste Frequenzabschnitte unterteilt, in denen jeweils unterschiedlich viel Signal- und Rauschleistung vorliegt. Diese Betrachtung führt zu dem Integral über die Bandbreite, mit dem die Kapazität eines Kanals unter farbigen Rauschbedingungen berechnet wird. Die Umsetzung komplexer Modulationsverfahren, die adaptiv auf das lokale SNR reagieren, erhöht so die Effizienz und den Datendurchsatz weiter. Annäherungen und praktische Grenzen Insbesondere bei sehr hohen oder sehr niedrigen Signal-Rausch-Verhältnissen kann die Formel approximiert werden, um vereinfachte Ergebnisse zu erhalten. Im Hoch-SNR-Bereich wächst die Kapazität näherungsweise logarithmisch in Bezug auf die Leistung, während sie im Nieder-SNR-Bereich nahezu linear mit der Leistung zusammenhängt.

Diese Erkenntnisse erzwingen Implikationen für das Systemdesign: bei geringem SNR ist es sinnvoller, die Bandbreite zu steigern, während bei hohem SNR eher die Verstärkung der Signalqualität eine Rolle spielt. Gleichzeitig informiert das Theorem darüber, dass es keinen adäquaten Ersatz für Bandbreite gibt – eine zu kleine Bandbreite begrenzt die mögliche Datenrate, egal wie hoch das SNR ist. Anwendungsbeispiele in der modernen Kommunikation Im Mobilfunk erlaubt das Theorem, die maximal erreichbare Datenrate für verschiedene Technologien zu modellieren, etwa bei LTE oder 5G. Auch Satellitenkommunikation nutzt das Verständnis der Kanalkapazität, um die Grenze für Sprach- und Datenübertragung festzulegen und das Design effizienter Modulationsschemata zu fördern. Ebenso bei DSL-Verbindungen, bei denen über Kupferleitungen Daten übertragen werden, sorgt die Kenntnis der Kanalkapazität für eine genaue Einschätzung des maximal möglichen Datendurchsatzes bei gegebener Leitungsqualität.

Zusammenfassung und Ausblick Das Shannon-Hartley-Theorem bildet bis heute die Grundlage für die Interpretation und Gestaltung digitaler Kommunikationssysteme. Durch die präzise Definition der Kanalgrenzen stellt es einen unverzichtbaren Referenzpunkt dar, der das Zusammenspiel von Bandbreite, Signalstärke und Rauschleistung quantifiziert und so die Effizienz moderner Informationsübertragung vorhersagbar macht. Zukünftige Entwicklungen fokussieren sich auf immer ausgefeiltere Kodierungsstrategien, adaptive Modulationsverfahren und die Nutzung neuartiger Kommunikationskanäle, um sich der theoretischen Kapazitätsgrenze weiter anzunähern. Dennoch bleibt das Grundprinzip gültig: Die Datenrate in einem realen Kanal ist unvermeidlich durch fundamentale physikalische und statistische Gesetzmäßigkeiten begrenzt, deren Verständnis unabdingbar für innovatives Kommunikationsdesign ist.