PostgreSQL gilt als eine der stabilsten und zuverlässigsten Datenbanken für geschäftskritische Anwendungen, die Wert auf ACID-Konformität (Atomicity, Consistency, Isolation, Durability) legen. Namhafte Unternehmen setzen seit Jahren auf PostgreSQL und profitieren von seiner Funktionalität und seinem großen Ökosystem. Doch trotz dieser Stärken stößt PostgreSQL vor allem bei der Skalierung an natürliche Grenzen. Vertikale Skalierung kann nur begrenzt erweitert werden, und die zunehmende Komplexität moderner Anwendungen verlangt nach Systemen, die eine problemlose horizontale Skalierung erlauben und dabei maximale Ausfallsicherheit garantieren. Genau an diesem Punkt tritt CockroachDB in den Vordergrund – eine verteilte SQL-Datenbank, die durch ihre Architektur speziell dafür entwickelt wurde, im Cloud-Zeitalter beste Performance und hohe Verfügbarkeit zu bieten.

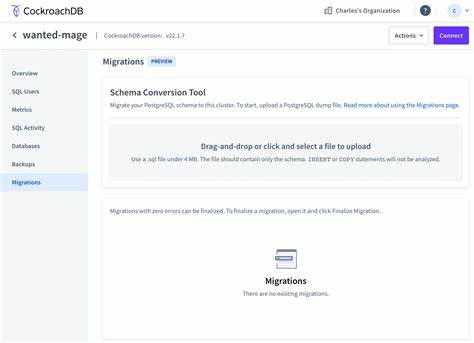

Für viele Unternehmen, die bisher mit PostgreSQL gearbeitet haben, stellt die Migration hin zu CockroachDB eine große Herausforderung dar. Gerade in Umgebungen, in denen mehrere Teams mit unterschiedlichsten Datenbankanforderungen arbeiten, ist eine nahtlose und zugleich sichere Migration essenziell, um Produktionsausfälle zu verhindern, Datenintegrität zu gewährleisten und gleichzeitig neue Funktionalitäten nutzen zu können. Ein zentraler Aspekt für eine erfolgreiche Migration von PostgreSQL zu CockroachDB ist die Nutzung von Change Data Capture (CDC). Dabei werden Änderungen an der Datenbank nahezu in Echtzeit aufgezeichnet und weiterverarbeitet. Diese Methode ermöglicht eine kontinuierliche Datenreplikation ohne die Notwendigkeit, das System für Wartungsarbeiten offline zu nehmen.

Unternehmen können so ihre Datenbanken synchron halten und den finalen Cutover auf CockroachDB mit minimaler Latenz und Unterbrechung vollziehen. PostgreSQL verwendet intern Write-Ahead Logs (WAL), die alle Änderungen vor dem Eintrag auf die Festplatte protokollieren. Das macht sie zur optimalen Quelle für das Lesen von Ereignisströmen. Mit der logischen Decodierung durch Plugins wie pgoutput können diese binären WAL-Daten in Veränderungen der Datenbankobjekte übersetzt werden – seien es Inserts, Updates oder Deletes. Für Unternehmen, die viele Datenbanken mit unterschiedlichen Anforderungen verwalten, ist eine solche granulare und konsistente Erfassung von Änderungen unverzichtbar.

Aufbauend auf dieser Datenstromquelle kommen Tools wie Debezium zum Einsatz. Debezium ist eine Open-Source-Plattform, die über Kafka Connect einen Stream aus den logischen Decoding-Daten erzeugt. Sie bildet Bridge-Funktionalitäten für diverse Datenbanken ab und ermöglicht eine flexible Verarbeitung der Änderungen in Echtzeit. In Szenarien mit hohem Datenaufkommen sind Debezium-Konnektoren pro Tabelle effektiv, da sie initial eine vollständige momentane Momentaufnahme (Snapshot) der Daten liefern und danach nur noch die Veränderungen fortlaufend streamen. Die empfangenen Änderungsdaten werden meist im Kafka-Cluster in einem strukturieren Format, häufig Avro, gespeichert.

Damit schaffen Unternehmen eine mittlere Schicht, die Daten Puffert, skaliert und parallel an weitere Systeme senden kann. Für den Integrationsschritt zu CockroachDB setzen fortschrittliche Firmen oft auf maßgeschneiderte Konsumenten, die mittels Frameworks wie Apache Beam arbeiten. Apache Beam ermöglicht es Ereignisströme zu verarbeiten, Upserts (also Insert oder Update in einem Zug) durchzuführen und Löschungen adäquat abzubilden. Besonders wichtig sind auch eingebaute Transformationen, um eventuelle Inkompatibilitäten zwischen PostgreSQL und CockroachDB auszugleichen – etwa bei Datentypen oder Constraint-Handling. Die Migration wird dadurch als durchgängig konsistenter Prozess gestaltet, der durch Transaktions-Checkpointing und Backpressure Mechanismen an eine sichere und nachvollziehbare Verarbeitung geknüpft ist.

Backpressure verhindert, dass Daten ein System überfordern und sorgt für eine stabile Pipeline, die eng mit der Ziel-Datenbank interagiert. Somit gelingt eine hohe Datenintegrität und das Risiko von Datenverlust wird signifikant reduziert. Die Cloud-Native Architektur von CockroachDB passt hervorragend zu diesem Ansatz. Besonders Plattformen wie Google Cloud mit ihrem Dataflow-Runner bieten alle Vorteile, die für verteilte Streaming-Prozesse notwendig sind: Skalierbarkeit, Monitoring, Ausfallsicherheit und einfache Infrastrukturverwaltung per Infrastruktur-as-Code-Tools wie Terraform. Diese Kombination erlaubt aggressives Monitoring von Datenfrische und schneller Fehlerdiagnose auch im großen Maßstab.

Ein nicht zu unterschätzender Bestandteil des Migrationsprozesses ist die Implementierung eines Rückfallmechanismus. Obwohl CockroachDB hohe Zuverlässigkeit aufweist, ist es ratsam, eine Spiegelung einzurichten, die Änderungen umgekehrt zurück nach PostgreSQL streamt. Diese doppelseitige Datenhaltung liefert eine Sicherheitsschicht, mit der man im Notfall zügig zurückwechseln kann – eine zentrale Forderung bei unternehmenskritischen IT-Systemen. Der Cutover von PostgreSQL zu CockroachDB ist dann nur noch ein koordinierter Schritt. Wenn sich die Datenbestände im Gleichgewicht befinden und durch eigens entwickelte Tools validiert wurden, kann die Traffic-Umleitung über Proxy-Server erfolgen.

Dank binärer Kompatibilität und der sorgfältigen Synchronisationsstrategie merken Endnutzer von der Migration in der Regel nichts. Für besonders latenzsensibele Anwendungen sind jedoch teilweise kurze Schreib- oder Lesepauses unvermeidlich, um Synchronisationsspitzen abzufangen. Dies erfordert eine sehr gute Planung und Kommunikation zwischen den Teams. Referentielle Integritätsbedingungen, also Fremdschlüsselverknüpfungen, stellen eine der komplexeren Herausforderungen dar. PostgreSQL erlaubt es innerhalb von Transaktionen temporäre Inkonsistenzen, während CockroachDB bisher strikt auf vollständige Konsistenz achtet.

Das kann zu Konflikten führen, wenn Tabellen miteinander in zyklischen Abhängigkeiten stehen. Die gangbare Lösung ist ein temporäres Aufheben der Constraints während der Migration und eine strikte Isolierung des Migrationsfensters, sodass keine externen Zugriffe oder Schreibvorgänge die Datenlage verfälschen. Vor dem endgültigen Umschalten werden dann die Constraints wieder aktiviert – meist ohne das System noch einmal offline zu nehmen. Was diese Migration exemplarisch zeigt, ist die Stärke von Change Data Capture nicht nur für Migrationsszenarien, sondern auch als Basis für Echtzeitanalysen, Personalisierung und betrieblichen Resilienzaufbau. Während CockroachDB die Möglichkeit bietet, verteilte Workloads in modernen Cloud-Architekturen performant zu bewältigen, stellt CDC sicher, dass Daten agil, konsistent und hochverfügbar zwischen Systemen bewegt werden können.

Für Unternehmen, die vor der Entscheidung stehen, PostgreSQL durch eine skalierbarere Datenbank wie CockroachDB abzulösen, lohnt sich die Investition in eine durchdachte CDC-gestützte Migrationsstrategie. Sie minimiert Risiken, reduziert Ausfallzeiten und legt den Grundstein für zukünftige funktionale Erweiterungen. Zugleich zeigt der Einsatz von bewährten Open-Source-Technologien und Cloud-Diensten, wie sich komplexe Herausforderungen in moderne Abläufe und Prozesse integrieren lassen – ein entscheidender Wettbewerbsvorteil in sich schnell verändernden Märkten. In Summe verbindet der Wechsel zu CockroachDB die Stabilität und Funktionsvielfalt von PostgreSQL mit den Vorteilen verteilten Rechnens: Skalierbarkeit, Ausfallsicherheit und einfache Wartbarkeit. Ein gut konzipierter Migrationsprozess, der Change Data Capture und Streaming-Technologien nutzt, ist dabei der Schlüssel zum Erfolg.

Die Zukunft gehört Unternehmen, die Datenmanagement als strategischen Prozess begreifen und entsprechende Technologiestacks clever einsetzen, um agil und widerstandsfähig zu bleiben.