Die fortschreitende Entwicklung von Künstlicher Intelligenz (KI) hat zahlreiche Bereiche unseres Lebens revolutioniert und verändert die Art und Weise, wie wir Informationen verarbeiten und Entscheidungen treffen. Insbesondere im wissenschaftlichen Umfeld stellt sich zunehmend die Frage, wie KI-gestützte Systeme den Forschungsprozess effizienter und objektiver gestalten können. Eine provokante Idee, die auf Plattformen wie Hacker News diskutiert wird, ist, ob es nicht möglich wäre, eine wissenschaftliche Konferenz komplett von einer KI entscheiden zu lassen, welche Forschungsarbeiten akzeptiert werden. Doch wie realistisch und sinnvoll ist eine solche Vorstellung? Und was bedeutet das für die Qualität und Diversität der Wissenschaft? Die traditionelle Rolle von Peer-Review-Verfahren bei Konferenzen ist es, Expertenmeinungen einzuholen, um die wissenschaftliche Relevanz, Methodenqualität und Innovation eines Beitrags zu beurteilen. Dieses Verfahren ist im Kern menschlich: Experten nutzen ihr Wissen, ihre Erfahrung und ihr Verständnis des Forschungsfeldes, um eine kritische Bewertung vorzunehmen.

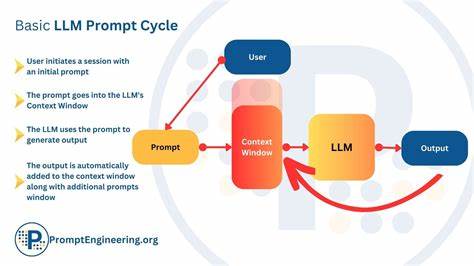

Die Herausforderung ist jedoch, dass der Peer-Review-Prozess oft zeitintensiv, subjektiv und manchmal anfällig für Bias oder Interessenskonflikte ist. Deshalb erscheinen KI-basierte Systeme auf den ersten Blick als attraktive Alternative oder zumindest als hilfreiche Ergänzung. Große Sprachmodelle (LLMs) wie GPT-3 oder GPT-4 haben in vielen Bereichen hervorragende Leistungen gezeigt, indem sie Text verstehen, generieren und nach Mustern analysieren können. Allerdings ist es wichtig, ihre Funktionsweise realistisch einzuschätzen. Sie basieren darauf, Wahrscheinlichkeiten für Folgeworte zu bestimmen und dadurch kohärente Inhalte zu produzieren, ohne ein tiefes Verständnis des Themas oder der bewerteten wissenschaftlichen Arbeit.

Sie lernen nicht aktiv hinzu oder entwickeln eine eigene Expertise, sondern ziehen Rückschlüsse aus dem bereits vorhandenen Trainingsdatensatz. Das macht es fraglich, ob sie tatsächlich die Nuancen einer wissenschaftlichen Arbeit zuverlässig bewerten können. Ein zentraler Kritikpunkt an der alleinigen Nutzung von KI für die Annahme von Konferenzbeiträgen ist, dass solche Systeme keine originären wissenschaftlichen Erkenntnisse oder neue Ansätze bewerten können, die nicht schon in ihren Trainingsdaten enthalten sind. Sie haben nicht die Fähigkeit, innovative Ideen von bloß gut formulierten Texten zu unterscheiden – eine für die Wissenschaft essenzielle Fähigkeit. Zudem können sie bestehende Verzerrungen oder Vorurteile aus den Trainingsdaten replizieren, was das Risiko birgt, bestimmte Forschungsrichtungen oder Autorengruppen zu benachteiligen.

Darüber hinaus stellt sich die Frage nach der Transparenz und Nachvollziehbarkeit der KI-Entscheidungen. Die Black-Box-Natur vieler LLMs erschwert es erheblich, die Gründe für eine Ablehnung oder Annahme einer Arbeit nachzuvollziehen. Dies ist problematisch für die Vertrauenswürdigkeit des Begutachtungsprozesses und die Möglichkeit für Forscher, aus Feedback zu lernen und ihre Arbeiten zu verbessern. Auf der anderen Seite gibt es Potentiale für den Einsatz von KI-Systemen, um den Peer-Review-Prozess zu unterstützen. So könnten KIs erste Plausibilitätsprüfungen vornehmen, um grobe Formatierungsfehler, Plagiate oder fehlende Referenzen aufzuspüren.

Sie könnten auch helfen, die Arbeitsbelastung von Gutachtern zu reduzieren, indem sie Vorschläge für die Zuweisung von Reviews machen oder Themencluster identifizieren. Damit könnten Konferenzen effizienter organisiert und beschleunigt werden. Die ethischen und sozialen Dimensionen einer KI-getriebenen Annahme von wissenschaftlichen Arbeiten sind nicht zu unterschätzen. Wissenschaft lebt von Diversität, von interdisziplinärem Austausch und gelegentlichem Paradigmenwechsel. Der Prozess der wissenschaftlichen Begutachtung sollte Raum für unkonventionelle Ansätze lassen und verschiedene Perspektiven zulassen.

Ein rein algorithmisches Verfahren könnte zu einer Konformität mit bestehenden Mustern und Lehrmeinungen führen, was der Innovationskraft abträglich wäre. Die Diskussion auf Plattformen wie Hacker News zeigt daher, dass die Community skeptisch gegenüber der Idee ist, KI als alleinigen Entscheider in diesem Kontext einzusetzen. Um es mit den Worten eines Nutzers zusammenzufassen: LLMs funktionieren vor allem als statistische Sprachmodelle, die die Wahrscheinlichkeit von Wortfolgen vorhersagen, aber keine echten Bewertungen oder Lernprozesse durchführen. Ein KI-gestützter Support im Peer-Review ist vorstellbar, aber eine vollautomatische Entscheidung über die Annahme wissenschaftlicher Beiträge stellt derzeit mehr Risiko als Chance dar. In Zukunft könnten hybride Modelle entstehen, in denen menschliche Expert:innen und KI-Systeme Hand in Hand arbeiten.