Künstliche Intelligenz und insbesondere große Sprachmodelle verändern zunehmend die Art und Weise, wie Maschinen Informationen verarbeiten und Probleme lösen. Längsketten des Denkprozesses, bekannt als Chain-of-Thought (CoT), spielen eine zentrale Rolle bei der Fähigkeit dieser Modelle, komplexe Aufgaben mit menschlicher Logik zu bewältigen. Trotz ihrer Bedeutung ist das Verständnis darüber, wie genau solche Modelle denken und welche Strategien sie anwenden, bislang begrenzt. Dies stellt eine Herausforderung dar, wenn man das Ziel verfolgt, das Verhalten von KI-Modellen transparenter und kontrollierbarer zu machen. Ein neuer innovativer Ansatz widmet sich genau diesem Problem.

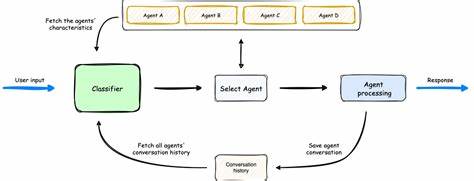

Anstatt sich auf vordefinierte Kategorien oder menschliche Intuitionen zur Kategorisierung von Denkprozessen zu verlassen, setzt er auf eine datengetriebene, bottom-up Analyse. Dabei werden automatisch verschiedenste Kriterien, die in den von den Modellen generierten Ketten des Denkens sichtbar werden, extrahiert und in einem semantischen Raum verortet. Hierbei erfolgt eine Clustering-Analyse, um repräsentative Kategorien herauszuarbeiten, die das breite Spektrum der Denkstrategien adäquat abbilden. Diese neuartige Methode ermöglicht es, Kontrastive Kriterien zu formulieren, die als interpretative Bezugspunkte dienen, um die Denkweisen der Modelle besser zu verstehen. Durch menschliche Evaluationen wurde bestätigt, dass dieser Ansatz deutlich verständlichere und umfassendere Einsichten liefert als herkömmliche Strategiekategorien.

Diese Erkenntnisse sind nicht nur akademisch wertvoll, sondern haben auch praktische Relevanz. Denn auf Basis der gewonnenen Analysen lässt sich das zukünftige Verhalten von KI-Modellen besser vorhersagen. Es wird möglich, herauszufinden, welche Denkstrategie ein Modell mit hoher Wahrscheinlichkeit wählen wird und diese gezielt zu beeinflussen. Durch solche Steuerungen können effektivere Denkansätze gegenüber weniger förderlichen bevorzugt werden, was die Leistungsfähigkeit bei komplexen Aufgaben deutlich erhöht. Ein besonders interessanter Befund betrifft den Einfluss des Trainingsdatenformats auf das Denkverhalten der Modelle.

Es zeigt sich, dass das Format – also ob die Daten in freier Form oder als Multiple-Choice-Fragen vorliegen – einen viel stärkeren Effekt auf die Auswahl der Denkstrategie hat als thematische Unterschiede zwischen den Daten. Diese Erkenntnis unterstreicht die Wichtigkeit einer formatbewussten Gestaltung von Trainingsdaten und Modellarchitekturen, um gezielt gewünschte Reasoning-Fähigkeiten zu fördern. Die Bedeutung dieses Forschungsansatzes lässt sich in mehreren Dimensionen betrachten. Zum einen unterstützt er Forscher und Entwickler darin, die Komplexität der Ketten des Denkens bei KI-Modellen systematisch zu erfassen und zu quantifizieren. Zum anderen schafft er die Grundlage dafür, Modelle transparenter zu machen, indem er ihre internen Verarbeitungsprozesse erklärbar gestaltet.

Darüber hinaus können diese Erkenntnisse die Effizienz von Anwendungen in vielfältigen Bereichen steigern – von der automatisierten Textgenerierung und Problemlösung über das maschinelle Lernen bis hin zu sicherheitskritischen Systemen, die nachvollziehbare Entscheidungen treffen müssen. Die Fähigkeit, die Denkweise von Modellen vorauszusehen und zu lenken, ist ein wesentlicher Schritt hin zu vertrauenswürdiger und kontrollierbarer künstlicher Intelligenz. In Zukunft könnte die Integration solcher Analyse- und Steuerungsverfahren auch bei der Entwicklung von Künstlicher Allgemeiner Intelligenz (AGI) eine Rolle spielen. Denn das tiefere Verständnis darüber, wie komplexe Reasoning-Prozesse zustande kommen und wie sie sich optimieren lassen, ist entscheidend, um KI-Systeme zu schaffen, die flexibel, robust und nachvollziehbar in unterschiedlichsten Kontexten agieren können. Abschließend zeigt sich, dass der Ansatz, Reasoning-Modelle nicht nur zu beobachten, sondern aktiv zu analysieren, vorherzusagen und zu steuern, die nächste Entwicklungsstufe bei der KI-Entwicklung markiert.

Er trägt dazu bei, die oft als Blackbox wahrgenommenen KI-Systeme transparenter zu machen und sie zielgerichteter für anspruchsvolle Anwendungen nutzbar zu machen. Für Unternehmen, Forschungseinrichtungen und Entwickler bietet sich dadurch ein enormes Potenzial, die Leistungsfähigkeit von KI effizienter und verantwortungsvoller zu gestalten und die Zukunft der intelligenten Maschinen maßgeblich mitzugestalten.