Künstliche Intelligenz bestimmt zunehmend das Gesicht verschiedenster Branchen, allen voran die Softwareentwicklung. KI-Agenten, die als autonome digitale Helfer fungieren, erweitern die Fähigkeiten von Entwicklern und revolutionieren Arbeitsprozesse. Gleichzeitig scheint die Kontrolle über diese komplexen Systeme oft eine scheinbar unmögliche Mission zu sein. Wer sich auf die neue Welt der KI-Agenten einlässt, steht vor der Herausforderung, nicht nur die passenden Tools auszuwählen, sondern die Zusammenarbeit durch präzise Planung und stringentes Management zu steuern. Ein wesentlicher Grundstein für den erfolgreichen Umgang mit KI-Agenten liegt in der differenzierten Betrachtung von Werkzeugen, Materialien und Technik.

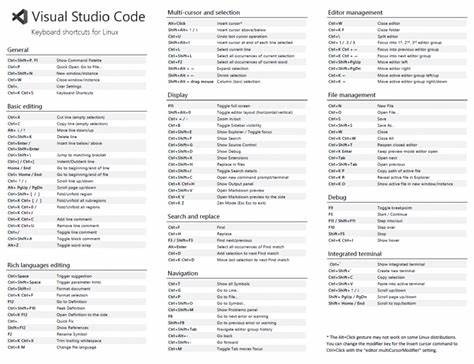

Während Werkzeuge wie Cursor, Windsurf oder Copilot technisch ähnlich funktionieren, sind die Materialien – bestehend aus Code, Diagrammen, Daten und vor allem präzisen Eingaben – ausschlaggebend für die Qualität der KI-Ergebnisse. Die Art und Weise, wie diese Materialien zusammengefügt und präsentiert werden, entscheidet maßgeblich über den Erfolg eines Projekts. Deshalb sollte der Fokus stets auf der sorgfältigen Auswahl und Vorbereitung der Eingaben liegen, nicht allein auf der Wahl des Werkzeugs. Die abstimmte eigene Kompetenz ist ebenso ein kritischer Faktor. Nur wer seine eigenen Fähigkeiten, Grenzen und die des KI-Tools realistisch einschätzt, kann die richtigen Phasen für Untersuchung und Umsetzung festlegen.

Trotz der enormen Leistungsfähigkeit heutiger KI-Modelle ist ein grundsolides Verständnis von Architektur und ein klares Kommunikationsvermögen unerlässlich. KI-Agenten spiegeln oft die Qualität der an sie gestellten Anweisungen wider: Versteht der Nutzer den Code und kann verständlich instruieren, ist auch die Ausgabe qualitativ hochwertig – andernfalls nicht. Planung erhält in diesem Kontext höchste Priorität. Anders als beim herkömmlichen Vorgehen ist der Anteil der vorbereitenden Arbeit in der KI-Agenten-Steuerung immens. Vibe Coding, also das vage Herangehen ohne Struktur, mag zwar schnelle Ergebnisse liefern, diese gleichen jedoch eher Prototypen ohne Verwertbarkeit.

Erfolgreiches Agent Coding erfordert wiederverwendbare, modulare Pläne, die sowohl das aktuell zu entwickelnde Feature dokumentieren als auch die Grundlage für flexible Nachjustierungen bilden. So wird ein Fundament geschaffen, das Änderungen, Fehlerbehebungen und Erweiterungen erleichtert und sogar die Fehlerminimierung fördert. Die Gestaltung eines klaren, nachvollziehbaren Weges vom Ausgangspunkt zum Ziel ist dabei essenziell. Da einfache Anweisungen wie „Nimm das dritte Element und verändere es“ bei KI-Systemen oft zu Missverständnissen führen, muss die Planung detailliert und in kleine, verifizierbare Schritte gegliedert erfolgen. Nur so lassen sich riskante spontante Erfindungen durch die KI vermeiden, die andernfalls den Quellcode destabilisieren könnten.

Eine akribische modulare Struktur trägt dazu bei, Probleme schon frühzeitig zu erkennen und den Agenten gegebenenfalls in eine Vorbereitungsphase zurückzuführen. Der Wahl des richtigen Modells kommt eine hohe Bedeutung zu, da es großen Einfluss auf Kosten, Leistung und die Genauigkeit der Ergebnisse hat. Modelle variieren dabei von günstigen Aktionsmodellen, die direkt nach Plan ausführen, bis hin zu komplexen Denkmodellen, die größere Kontextfenster und tiefere Überprüfungen ermöglichen. Der bewusste Einsatz je nachdem, ob eine Planung, eine einfache Änderung oder eine tiefgehende Evaluation notwendig ist, sorgt für effiziente Nutzung und Kostenkontrolle. Ein automatisches Modellmanagement kann dabei zwar bequem erscheinen, birgt jedoch das Risiko von Kontextverlusten oder überhöhten Ausgaben.

Die Kostenkontrolle im Einsatz von KI-Agenten ist ein weiterer elementarer Aspekt. Durch das Setzen von Nutzungs- und Ausgabelimitierungen, gezieltes Aktivieren und Deaktivieren von Modellen sowie ständige Überwachung des Verbrauchs lässt sich die Balance zwischen Investition und Ertrag bewahren. Der Versuch, an günstigen, aber qualitativ minderwertigen Modellen zu sparen, kann auf Dauer zu Frustration und erhöhtem Zeitaufwand führen. Stattdessen lohnt es sich, in bewährte Premium-Modelle zu investieren und den Verbrauch mithilfe von Analysewerkzeugen genau im Auge zu behalten. Ein weiterer moderner Ansatz ist das Model Context Protocol (MCP), das die Kommunikation zwischen verschiedenen KI-Agenten und Werkzeugen standardisieren soll.

Dabei handelt es sich jedoch nicht um eine magische Lösung, sondern um eine abgeschlossene Struktur zur Übergabe von Prompts und Toolaufrufen im JSON- und Markdown-Format. MCP ähnelt in seiner Funktion bereits existierenden API-Integrationen und unterstützt damit ein reibungsloseres Zusammenspiel verschiedener Systeme. Trotzdem sollte man sich bewusst sein, dass MCP keine grundlegend neue Lern- oder Kontrollschicht definiert, sondern eher als formaler Rahmen auf bereits bekannte Abläufe aufsetzt. Die Praxis zeigt, dass häufig genau die Schwächen in der Planung und im eigenen Code zu Problemen mit KI-Agenten führen. Scheitert die Zusammenarbeit, liegt es meist an einem Mangel an klaren Anweisungen, mangelhafter Architektur oder unzureichendem Refactoring bestehender Strukturen.

Die KI spiegelt hierbei die Herausforderungen ihrer menschlichen Nutzer wider und zwingt zu einer ehrlichen Auseinandersetzung mit der Qualität des eigenen Codes. Je früher solche strukturellen Probleme erkannt und systematisch adressiert werden, desto leichter gestaltet sich die spätere Zusammenarbeit und desto geringere Kosten entstehen. Eine der wertvollsten Einsatzgebiete von KI-Agenten ist die Unterstützung beim Refactoring und Debugging. Trotz der oft unterschätzten Bedeutung helfen Agenten, Fehlerquellen aufzudecken, redundanten oder ineffizienten Code zu verbessern und so technische Schulden abzubauen. Dies führt zu nachhaltig besser wartbaren und erweiterbaren Systemen.

Dabei empfiehlt sich, Änderungsprozesse konsequent durch Pläne zu steuern, Änderungen schrittweise umzusetzen und nach jeder kleinen Etappe manuell zu prüfen, um die Kontrolle über das Gesamtsystem nicht zu verlieren. Allerdings ist trotz aller Automatisierung das Prinzip „Vertrauen, aber prüfen“ weiterhin unverzichtbar. KI-Agenten generieren Vorschläge auf Basis statistischer Wahrscheinlichkeiten und können durchaus Lösungen anbieten, die scheinbar funktionieren, aber in der Praxis zu unerwarteten Fehlern führen. Deshalb ist es wichtig, dass Entwickler Begleittests selbst durchführen und Ausgaben der KI kritisch hinterfragen. Fehlerhafte Korrekturversuche, beispielsweise das Abschneiden von Texten oder falsche Formatierungen, entgehen dem menschlichen Auge kaum.

Nur durch kontinuierliches Monitoring lässt sich Qualität sicherstellen. Das Schreiben von klaren, detaillierten Problembeschreibungen sowie das Einbringen relevanter Informationen, wie Screenshots, Logs oder Architekturdokumentationen, erhöht die Chancen einer korrekten Analyse und zielgerichteten Lösung enorm. Sehr hilfreich ist dabei das Konzept, Fehler und ihre Behebung nicht als ad hoc Vorgänge, sondern als Bestandteil eines nachverfolgbaren, dokumentierten Plans abzubilden, der Rückschlüsse auf Systemzustände und Fehlerquellen erlaubt. Schließlich sollten wir uns stets bewusst sein, dass KI-Agenten keineswegs den Menschen ersetzen, sondern vielmehr einen Weg bieten, das eigene Können zu erweitern und zu verbessern. Verantwortungsvolle Planung, sorgfältige Steuerung der Agenten und eine offene Haltung zu eigenen Fehlern sind die Schlüssel, um das volle Potenzial der Technologie auszuschöpfen.