Die Nutzung von künstlicher Intelligenz in der Marktforschung revolutioniert die Art und Weise, wie Unternehmen ihre Zielgruppen verstehen und ansprechen. Besonders beeindruckend ist die Fähigkeit, tausende von virtuellen Kundenprofilen oder sogenannten KI-Personas zu generieren und so vielfältige und tiefergehende Einblicke in Konsumentenverhalten zu erhalten. Die Erstellung von 5.000 solchen Personas ist jedoch kein triviales Unterfangen. Es erfordert durchdachte Strategien, technische Präzision und ein tiefes Verständnis sowohl der Technologie als auch der Zielmärkte.

Aus den Erfahrungen der Entwicklung und Skalierung eines solchen Projekts zeigen sich zentrale Herausforderungen und wertvolle Lektionen, die Unternehmen auf ihrem Weg hin zu umfassenderen synthetischen Marktforschungsdaten unterstützen können. Einer der ersten und grundlegenden Punkte betrifft die Qualität und Authentizität der generierten Personas. Viele Nutzer, die KI-gestützte Simulationen einsetzen, kennen das Problem der übermäßig zustimmenden oder unkritischen Antworten, die klassische Chatbots häufig liefern. Diese Systeme sind darauf trainiert, hilfreich zu sein, was jedoch oft dazu führt, dass ehrliche, kritische Konsumentenmeinungen nicht adäquat widergespiegelt werden. Das Problem liegt darin, dass der Model-Output kaum beeinflusst werden kann, um eine gewisse „Persönlichkeit“ oder Skepsis zu simulieren – der virtuelle Kunde lobt meist alles und hinterfragt wenig.

Die Lösung ist dabei nicht der einfache Einsatz fertiger Chatbots wie GPT-Modelle im Standardmodus, sondern vielmehr die gezielte Nutzung der API mit kundenspezifischen Anweisungen. So lassen sich genau definierte Verhaltensweisen programmieren, indem das System angewiesen wird, als skeptischer Verbraucher mit Konkurrenzoptionen zu agieren. Durch mehrere Beispiele und konkrete Rollenvorgaben kann die Repräsentativität und Glaubwürdigkeit deutlich gesteigert werden. Dies ist vergleichbar mit dem Unterschied zwischen einer wohlwollenden Mutter, die jede Idee unterstützt, und einem neutralen Fremden, der kritisch hinterfragt. Doch Realismus und Vielfalt sind nur eine Seite der Medaille.

Um valide und belastbare Marktforschungsergebnisse zu erzielen, muss auch die Stichprobengröße passen. Während typische Anwendungen mit 50 bis 100 Personas oft ausreichend sind, reichen diese Mengen bei der Analyse spezieller Zielgruppen nicht aus. Ein Beispiel illustriert dies: Arbeitet eine Marke mit vielfältigen Kundensegmenten, von denen sechs Prozent der Zielgruppe im Bausektor tätig sind, spiegeln 100 generierte Personas gerade einmal sechs Personen dieser Nische wider – nicht genug, um belastbare Schlüsse zu ziehen. Erst mit einer Skala von 5.000 virtuellen Kunden können zehnfach höhere Repräsentationen ermöglicht werden, wodurch Mikrosegmente tiefgehend und statistisch abgesichert analysiert werden können.

Dieses Ausrichten auf unterschiedliche Subgruppen eröffnet Möglichkeiten, die zuvor nur mit enormem Aufwand oder kaum machbar waren. Die Arbeit mit einer solch großen Anzahl an Personas bringt allerdings technische und methodische Komplexitäten mit sich. Eines der wichtigsten Probleme ist die Konsistenz der aus der KI generierten Daten. In kleineren Samples fallen Inkonsistenzen kaum auf, bei Tausenden von Einträgen führen sie zu erheblichen Schwierigkeiten bei der Auswertung. Die Formate können schwanken, Angaben unvollständig sein, Begriffe uneinheitlich genutzt werden.

Dieses Fragmentierungsproblem hat enorme Auswirkungen auf Datenintegrität und Analysequalität. Eine zentrale Erkenntnis war der Einsatz moderner Datenstrukturbibliotheken wie Pydantic in Kombination mit der KI-API, um eindeutige, validierte Datenmodelle durchzusetzen. So wird jede KI-Persona streng nach definierten und programmierten Vorgaben erstellt. Die Vorteile sind enorm: Einheitliche Attributnamen, klare Datenformate und automatisierte Validierung verhindern Fehler und vereinfachen die Weiterverarbeitung signifikant. Diese technische Disziplinierung der Daten ist eng verbunden mit der statistischen Genauigkeit der erhaltenen Persona-Population.

Ein bedeutender Fehler wäre es, einfach eine zufällige Auswahl verschiedener demographischer Merkmale zu erzeugen ohne deren realistische Verteilung zu berücksichtigen. Das erzeugt Daten, die zwar numerisch vielfältig sind, aber keinerlei realem Markt entsprechen. Bei einer echten Zielgruppe beispielsweise aus den USA sollten regionale, geschlechtsspezifische und sozioökonomische Verteilungen akkurat gespiegelt werden, um Relevanz zu gewährleisten. Ebenso müssen Korrelationen zwischen Merkmalen wie Einkommen und Bildungsstand stimmen. Die bessere Lösung ist eine iterative Optimierung: Mithilfe eines Evaluator-Optimierer-Patterns werden jede Erzeugungsrunde automatisiert mit den Zielverteilungen abgeglichen.

Danach wird der Prompt entsprechend angepasst, sodass unterrepräsentierte Gruppen verstärkt erzeugt werden. Auf diese Weise wächst eine KI-Population mit authentischem, marktrealistischen Profil heran. Dieses Vorgehen erfordert eine enge Zusammenarbeit mit dem Kunden, um alle Annahmen und Bestandsdaten zur Zielgruppe präzise zu erfassen und als Eingabe für den Algorithmus bereitzustellen – ein Prozess, der gerne als Personifizierung bezeichnet wird. Die Erstellung der 5.000 virtuellen Nutzer ist darüber hinaus eine zeitintensive Prozesskette.

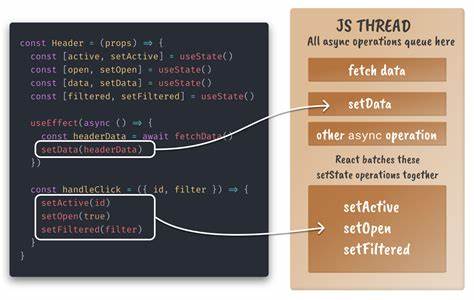

Je nach Modell und Komplexität dauert die Generierung einer einzelnen Persona mit allen zugehörigen Eigenschaften mehrere Sekunden. Hinsichtlich einer Menge von Tausenden würde das sequentielle Abarbeiten leicht mehrere Stunden bedeuten. Eine bedeutende Verbesserung bringt hier die asynchrone Verarbeitung. Dabei starten zahlreiche Anfragen parallel, die Verarbeitung erfolgt gleichzeitig und beschleunigt die Gesamtzeit erheblich. Allerdings ergaben sich hier neue Herausforderungen: Unkontrollierte Parallelität führt schnell zu Überschreitung von API-Rate-Limits und einer Vielzahl von Fehlermeldungen sowie Rücksetzpunkten.

Das verdeutlicht, dass hohe technische Performance immer mit gezieltem Management von Fremdsystembeschränkungen und schlauer Fehlerbehandlung verbunden sein muss. Neben Zeit und Technik darf auch die Kostenfrage nicht außer Acht gelassen werden. Während die Nutzung der leistungsfähigsten GPT-Modelle mit exzellenter Output-Qualität punktet, sind diese mit pro Persona Kosten im zweistelligen Dollarbereich teuer. Bei 5.000 Personas summiert sich dies auf Kaufsummen im fünfstelligen Bereich und überschreitet oft das Budget vieler Unternehmen.

Untersuchungsergebnisse zeigten, dass kleinere Modelle mit reduzierter Rechenleistung und vereinfachter Komplexität deutlich günstigere Kosten sowie schnellere Bearbeitungszeiten ermöglichen. Bei sachkundiger Anwendung sind die Unterschiede in der Aussagekraft oft marginal und akzeptabel für Testphasen und Prototypen. Dies unterstreicht die Bedeutung, im Entwicklungprozess zunächst auf leichte Modelle zu setzen, um Kosten und Zeit zu optimieren und erst ab finaler Qualitätsabsicherung auf die größeren Modelle umzusteigen. Ein weiterer Performance-Killer früherer Ansätze war die Handhabung von Umfragen mittels Einzel-fragen-APIs. Das bedeutete unzählige rundum wiederholte Verarbeitungsschritte und Punktionen großer Datenvolumen durch Token-Wiederholungen für jede einzelne Frage.

Die Umstellung auf die Modellierung kompletter Survey-Abschnitte mit Pydantic ermöglichte es, mehrere Rahmenfragen in einem einzigen API-Aufruf zusammenzufassen. Damit wurden nicht nur kostspielige Token-Verbrauchskosten deutlich gesenkt, sondern auch die Antwortzeiten optimiert. Die so generierten Antworten waren zudem leichter zu verarbeiten und auszuwerten, was die Effizienz der gesamten Forschungsdurchführung verbesserte. Trotz aller Automatisierung birgt die Verwaltung großer Datenmengen durch KI-generierte Personas eigene Risiken. In der Praxis zeigte sich, dass versehentliche Datenverluste etwa durch Überschreiben von Ergebnisdateien oder fehlende Sicherungsmechanismen lange Laufzeiten und hohe Ressourcen verschwenden können.

Eine konsequente Umsetzung von idempotenten Verfahren mit eindeutigen Verzeichnissen und ständigen Zwischenspeicherungen in Form von Checkpoints hat sich hier als Retter erwiesen. Dieses Vorgehen ermöglicht ein systematisches Starten, Stoppen und Wiederaufnehmen von Prozessen ohne Datenunschärfen oder inkonsistente Doppelerfassungen – vergleichbar mit Speicherständen bei Computerspielen. Rückblickend lässt sich sagen, dass die Erstellung von 5.000 KI-Personas ein komplexer Prozess ist, der weit über eine einfache Bot-Abfrage hinausgeht. Der Schlüssel zum Erfolg liegt in klarer Strukturierung, datengetriebener Steuerung und Echtzeit-Optimierung der demographischen Eigenschaften.

Dabei gilt es technische Grenzen von APIs und Kostenstrukturen genau zu beachten und durch clevere Methodik zu umschiffen. Wer sich an diese Leitlinien hält, profitiert von der Möglichkeit, synthetische Marktforschung kostengünstig und skalierbar durchzuführen und dabei fast in Echtzeit umfangreiche Zielgruppen-Simulationen zu erhalten. Die gewonnenen Erkenntnisse eignen sich hervorragend zum Testen von Produktideen, Marketingstrategien oder Preismodellen und bieten gerade im dynamischen Umfeld digitale Tools eine enorme strategische Wettbewerbsdifferenzierung. Trotz der hohen Effizienz und Reichweite menschlicher Marktforschung bleibt sie in der Präzision unerreicht. KI-basierte Persona-Generierung kann eine Genauigkeit von bis zu 85 Prozent im Vergleich zu realen Umfragen erzielen.

Diese „nahezu menschliche“ Validität in Kombination mit massiv niedrigen Kosten und kurzen Durchlaufzeiten macht synthetic research zu einem spannenden und zukunftsträchtigen Instrumentarium in der Marktforschung. Unternehmen, die frühzeitig in diese Technologie investieren und dabei die beschriebenen Best Practices berücksichtigen, können vielseitig neue Einblicke gewinnen, ohne enorme Budgets investieren zu müssen. Der Weg zu validen, vielfältigen und skalierbaren KI-Personas ist eine spannende Herausforderung mit hohem Innovationspotenzial, die inzwischen umsetzbar und beinahe jedem zugänglich geworden ist.