Die Entscheidung für ein Datenbanksystem ist eine fundamentale Weiche für jedes technologiegetriebene Unternehmen. Die Wahl beeinflusst nicht nur die Performance und Skalierbarkeit, sondern auch die operativen Kosten und den langfristigen Wartungsaufwand. Motion, ein aufstrebendes Unternehmen im Bereich KI-Workflows, stand vor genau dieser Herausforderung: Nach mehrjährigem Einsatz von CockroachDB und dessen starker Skalierbarkeit wurde der Entschluss gefasst, zu PostgreSQL zu migrieren. Die Gründe lagen nicht nur in den finanziellen Aspekten, sondern auch in technischen Limitierungen und operativen Hindernissen, die das Team zunehmend belasteten. CockroachDB wird insbesondere für seine mühelose horizontale Skalierbarkeit und extrem hohe Verfügbarkeit geschätzt – wobei die SQL-kompatible Schnittstelle den Umstieg für viele Entwicklerfreundlich macht.

Speziell für Geo-redundanz und Multi-Region-Setups bietet CockroachDB Vorteile, optimiert für diese komplexen Anwendungsfälle. Motion nutzte dazu ein ORM, welches es schneller ermöglichte, zwischen verschiedenen Datenbanken zu wechseln und Migrationen zu testen. Dennoch zeigte sich mit wachsendem Datenvolumen eine Reihe von Herausforderungen, die von Ausführungszeitüberschreitungen bei Migrationen bis zu suboptimaler Query-Performance reichten. Ein zentrales Problem war die Migration von Datenbankschemata, die bei großen Tabellen zu regelmäßigen Timeout-Fehlern führten. Die Situation brachte das Deployment oft für Stunden zum Erliegen, was die Entwickler zwang, manuell und parallel migrationsbezogene Operationen durchzuführen – eine riskante Prozedur, die mit zunehmendem Datenvolumen immer schwerer handhabbar wurde.

Demgegenüber zeigte sich PostgreSQL bei ähnlichen Migrationen als deutlich robuster und schneller. Ein Testlauf einer vergleichbaren Schema-Änderung mit einem einfach hinzugefügten Spaltenfeld in einer Teammitgliedertabelle dauerte dort lediglich wenige Sekunden. Diese Performance-Engpässe hatten auch Auswirkungen auf die Datenextraktion und -integration. ETL-Prozesse begannen häufig zu hängen oder stießen auf Fehler, besonders, da verfügbare Tools wie Airbyte für CockroachDB noch in frühen Alphaphasen waren und sogar Speicherlecks aufwiesen. Für Unternehmen, die auf kontinuierliche Datenströme und ein zuverlässiges Reporting angewiesen sind, bedeutete das substanzielle Risiken und Limitierungen.

Ein weiterer Aspekt betraf die tatsächliche Geschwindigkeit der Anfragen. Während CockroachDB in speziellen Fällen dank seines ausgeklügelten Query Optimizers Vorteile offenbarte und komplexe Abfragen besser planten konnte, zeichnete sich im Alltag ein gegenteiliges Bild ab. Das ORM-generierte SQL war oft verschachtelt und führte zu vollen Tabellen-Scans, was die Datenbank stark belastete und die Antwortzeiten in die Länge zog. Diese Problematik wurde in einem realen Beispiel mit einer Team-Task-Abfrage besonders deutlich, die auf CockroachDB zwanzigmal langsamer als auf PostgreSQL lief. Die Ursache lag häufig in den vielen Joins und der Vielzahl eingeschlossener Spalten, welche CockroachDBs Planer nicht effizient verarbeiten konnte.

Die Verschwendung von Ressourcen und damit verbundene höhere Latenzen beeinträchtigten spürbar die Nutzererfahrung. Darüber hinaus bewahrten UI-Probleme die Entwickler vor unnötiger Verwirrung. CockroachDB zeigte Index-Empfehlungen, die teils widersprüchlich schienen, indem vermeintliche ungenutzte Indizes vorgeschlagen wurden, die in Wirklichkeit aktiv verwendet wurden. Ebenso erschwerte das Handling von langlaufenden Abfragen die Administration erheblich. Während PostgreSQL eine einfache Abbruchmöglichkeit direkt über Client-Tools bot, erforderte CockroachDB den oft riskanten Eingriff über das Konsolentool, mit der Gefahr unvollständiger Abbrüche.

Nicht außer Acht zu lassen sind die Support-Erfahrungen. CockroachDBs Kundenservice erwies sich als weniger zugänglich und reagierte oft verzögert, was bei kritischen Bugs zu längeren Ausfallzeiten führte. Zudem gab es wiederkehrende Probleme mit der Netzwerkverbindung innerhalb der genutzten Virtual Private Clouds, speziell bei Tools wie Tailscale, die sich nicht zufriedenstellend beheben ließen. Die technische Umsetzung der Migration war ebenfalls eine Herausforderung. Mit einer Datenbankgröße von sorgsam gewachsenen 100 Millionen Zeilen bot CockroachDB wenig ausgereifte Möglichkeiten für Data-Pipelines mit Echtzeit-Replikation.

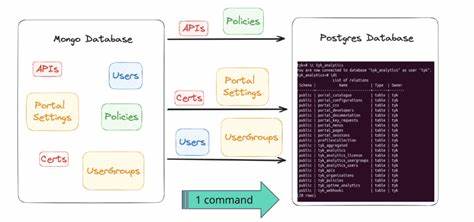

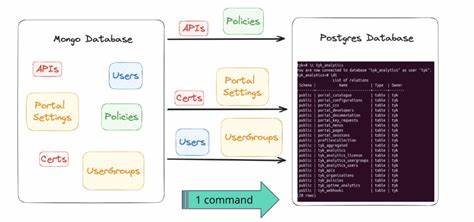

Um hier Abhilfe zu schaffen, entwickelte das Motion-Team eine eigens angepasste ETL-Lösung mit dem aufstrebenden Tool Bun. Der Prozess bestand darin, das Datenbankschema zu lesen, die Daten jeder Tabelle in separate Dateien zu exportieren und dann mittels paralleler Prozesse in PostgreSQL einzuspeisen. Dabei zeigten sich jedoch Unterschiede in der Datenkodierung, beispielsweise bei JSON- oder Array-Datentypen. Es wurde notwendig, eine maßgeschneiderte Parsing-Pipeline zu erstellen, um die Daten kompatibel ohne Informationsverlust zu transformieren. Dies verdeutlicht, wie wichtig gewisse Anpassungen bei der Migration sind, besonders wenn unterschiedliche Datenbanksysteme beteiligt sind.

Das finale Migrationsevent wurde mit hoher Rechenpower auf einer virtuellen Maschine bei Google Cloud abgewickelt. Dank konsequenter Wartungsmodi und sorgfältigem Vorarbeiten konnte die Datenmigration binnen knapp 15 Minuten durchgeführt werden, bei weniger als einer Stunde Ausfallzeit. Nach Abschluss zeigte sich eine sofortige Verbesserung: Die Latenz der aggregierten Anfragen sank um rund ein Drittel. Zusätzlich konnten viele zuvor ineffiziente Abfragen dank der mächtigen Analyse- und Optimierungstools im PostgreSQL-Ökosystem zeitnah identifiziert und verbessert werden. Die wirtschaftlichen Vorteile sind dabei nicht zu vernachlässigen.

Die jährlichen Einsparungen belaufen sich auf über 110.000 US-Dollar – ein bedeutender Faktor nach Abwägung von Performance und Stabilität. Auch wenn PostgreSQL konservativ dimensioniert wurde, zeigte sich eine nachhaltige Skalierbarkeit für künftiges Wachstum. Die Erfahrungen von Motion verdeutlichen, dass eine Migration weg von spezialisierten verteilten Datenbanken hin zu einem traditionellen, bewährten System wie PostgreSQL nicht nur eine Kostenentscheidung ist, sondern maßgeblich Einfluss auf die Entwicklungsprozesse, Betriebssicherheit und Performancequalität hat. Die eigene ETL-Entwicklung und die intensive Anpassung an Dateninkompatibilitäten zeigen, dass der Erfolg einer Migration nicht nur an Technologie, sondern auch an Fachwissen und sorgfältigem Projektmanagement hängt.