In der heutigen digitalen Welt sind Daten das wertvollste Gut vieler Unternehmen. Doch nicht die isolierten Datensätze allein sind entscheidend, sondern vor allem die Beziehungen zwischen ihnen. Kundeninteraktionen, Produktverknüpfungen und Transaktionshistorien ergeben ein komplexes Beziehungsgeflecht, das traditionelle maschinelle Lernverfahren oft nur unzureichend erfassen können. Genau hier setzen Relationale Graph Transformer an – eine neuartige Architektur, die das Potenzial hat, die Art und Weise, wie Unternehmen ihre relationalen Daten nutzen, grundlegend zu verändern. Relationale Graph Transformer stellen einen bedeutenden Entwicklungsschritt im Bereich des Relationalen Deep Learning dar.

Anstatt Daten aus relationalen Datenbanken in starre Tabellen umzuwandeln und manuell Features zu extrahieren, betrachten diese Modelle die gesamte Datenbank als ein umfangreiches, vernetztes Graphsystem. Jedes Datenbankelement – sei es ein Kunde, Produkt oder eine Bestellung – wird dabei als ein Knoten in einem Graphen interpretiert. Die Verbindungen zwischen diesen Knoten entsprechen den Fremdschlüsselbeziehungen der relationalen Datenbank und bilden somit die Kanten des Graphen. Durch diese Herangehensweise entfällt die aufwendige Umwandlung relationaler Daten in flache Vektoren, wodurch wertvolle Informationen über Mehrtabellenbeziehungen erhalten bleiben. Die Vorteile dieses Ansatzes sind vielschichtig.

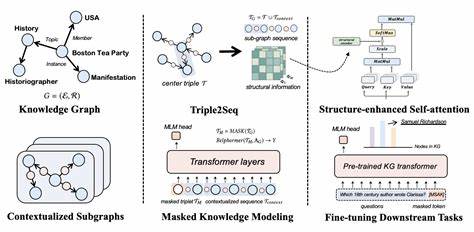

Einerseits verkürzt sich die Zeit bis zur Analyse erheblich, da die traditionellen, oft komplexen Datenvorbereitungsschritte drastisch reduziert werden. Andererseits verbessert sich die Genauigkeit bei Vorhersagen, da Relationale Graph Transformer nicht nur direkte Verbindungen, sondern auch komplexe und langreichweitige Beziehungsstrukturen erfassen können, die bei herkömmlichen Modellen häufig unberücksichtigt bleiben. Ein zentraler Schritt zur Verarbeitung relationaler Daten mittels Graph Transformer ist die Transformation der Datenbank in zwei spezifische Grapharten. Zunächst wird ein Schema-Graph erstellt, in dem Tabellen als Knoten fungieren und die Fremdschlüsselbeziehungen die Kanten bilden. Dieser Graph dient als konzeptuelles Modell, das den Aufbau und die Art der Beziehungen in der gesamten Datenbank abbildet.

Auf Basis dieses Schemas wird anschließend ein Entitätsgraph konstruiert, in dem jede einzelne Zeile einer Tabelle einen Knoten repräsentiert und die Verbindungen zwischen diesen Knoten auf den Fremdschlüsselverweisen beruhen. Hierbei wird der heterogene Charakter des relationalen Systems abgebildet, da unterschiedliche Knotentypen (beispielsweise Kunden oder Produkte) sowie verschiedenartige Kanten (etwa Kauf- oder Betrachtungsbeziehungen) explizit unterschieden werden. Diese strukturierte Abbildung ermöglicht es dem Relationalen Graph Transformer, Beziehungsinformationen in viel höherer Tiefe und mit größerer Aufmerksamkeit zu verarbeiten. Die herkömmliche Beschränkung vieler Graph-Neural-Network-Modelle, die nur Nachrichten zwischen benachbarten Knoten weiterleiten, wird durch den Einsatz von Transformer-Mechanismen überwunden, die eine direkte Interaktion zwischen allen Knoten in einem Subgraphen erlauben. So wird der Informationsfluss beschleunigt und langreichweitige Relationen können effektiv modelliert werden.

Unternehmen aus Branchen wie Handel, Finanzdienstleistungen oder Logistik profitieren besonders von diesen Fähigkeiten. In einem E-Commerce-System etwa kann der Relationale Graph Transformer nicht nur einzelne Transaktionen analysieren, sondern durch direkten Informationsaustausch zwischen Produkten, Kunden und Transaktionen komplexe Muster entdecken – beispielsweise welche Produktkombinationen häufig gemeinsam gekauft werden oder wie das Kaufverhalten bestimmter Kundensegmente saisonal schwankt. Dabei ist es unerheblich, ob diese Beziehungen unmittelbar oder über mehrere Zwischenschritte bestehen – der Graph Transformer kann dank seines Aufmerksamkeitsmechanismus selbst weit entfernte Zusammenhänge berücksichtigen. Die Verarbeitung der heterogenen Daten, die in relationalen Tabellen enthalten sind, stellt eine besondere technische Herausforderung dar. Jede Tabellenzeile besteht aus Attributen verschiedenster Formate – numerische Werte, kategoriale Variablen, Zeitstempel, Textfelder oder sogar Bilder.

Relationale Graph Transformer nutzen daher einen multimodalen Embedding-Prozess, bei dem jede Art von Daten spezialisierte Enkodierer erhält. Numerische Werte werden normalisiert und durch Mehrlagige Perzeptrons transformiert, Kategorien erhalten lernbare Einbettungen, Textdaten durchlaufen vortrainierte Sprachmodelle, und Bilddaten werden mittels vortrainierter Convolutional Neural Networks oder Vision Transformer verarbeitet. Anschließend werden diese unterschiedlichen Embeddings zusammengeführt und repräsentieren jeden Knoten umfassend und adaptiv. Neben den Knoteninformationen spielen auch die Kanten im Graphen eine entscheidende Rolle. Während herkömmliche Transformer-Modelle Kanteninformationen ignorieren, integrieren Relationale Graph Transformer die Bedeutung der unterschiedlichen Beziehungen aktiv in ihren Lernprozess.

Jede Kante wird als eine individuelle Relation verstanden und fließt über relation-spezifische Gewichtungen in die Aufmerksamkeitsberechnung ein. Dies erlaubt es dem Modell, feinsinnige Unterschiede zwischen etwa einer Kaufbeziehung, einer Produktempfehlung oder einer hierarchischen Verbindung zu berücksichtigen. Dieses relationale Bewusstsein macht die Modelle nicht nur präziser, sondern auch verständlicher für Fachanwender, die die Bedeutung der einzelnen Verbindungen nachvollziehen können. Zeitliche Aspekte stellen einen weiteren wichtigen Faktor dar, da viele Relationale Deep Learning-Anwendungen Ereignisse im Zeitverlauf analysieren. Um das Modell temporal zu sensibilisieren, werden spezielle Zeit-Embeddings verwendet, die als positionsähnliche Kodierungen dienen.

Dadurch ist der Graph Transformer in der Lage, Zeitstempel zu berücksichtigen, das Fortschreiten von Ereignissen zu verstehen und Vorhersagen auf einer zeitlich korrekten Grundlage zu treffen. Dies verhindert Probleme wie Datenlecks durch Informationen aus der Zukunft und erhöht die Verlässlichkeit der Analyseergebnisse. Eine der größten Herausforderungen bei der Skalierung von Graph Transformer Modellen auf reale Unternehmensdaten sind die enorme Größe der relationalen Graphen und ihre Komplexität. Mit Millionen von Entitäten und Milliarden von Kanten stoßen klassische Transformer-Architekturen schnell an ihre Grenzen, da der Rechenaufwand quadratisch mit der Größe des Graphen wächst. Relationale Graph Transformer adressieren dieses Problem durch speziell angepasste Sampling- und Batching-Strategien, die den Graph in handhabbare Subgraphen zerlegen.

Diese Unterteilungen orientieren sich dabei am Schema und der relationalen Struktur, sodass die wichtigsten Verbindungen erhalten bleiben und gleichzeitig die Modellkomplexität reduziert wird. Darüber hinaus zeichnen sich Relationale Graph Transformer durch ihre Fähigkeit aus, nicht nur lokale, sondern auch globale Zusammenhänge zu erfassen. Während Graph-Neural-Networks typischerweise auf Nachbarschaftsinformationen beschränkt bleiben, können Relationale Graph Transformer über ihre Aufmerksamkeit Mechanismen Abhängigkeiten über große Distanzen im Graphen modellieren. Diese Eigenschaft ist insbesondere bei Prognose- und Klassifikationsaufgaben von Vorteil, bei denen Informationen aus weit entfernten Datenpunkten einen entscheidenden Beitrag leisten. Experimentelle Untersuchungen auf Benchmarks wie RelBench, einem etablierten Datensatz für relationales Deep Learning, zeigen beeindruckende Resultate.

Relationale Graph Transformer erreichen dort signifikant höhere Vorhersagegenauigkeiten als klassische Graph-Neural-Networks und übertreffen traditionelle maschinelle Lernverfahren sogar um mehr als 40 Prozent. Diese überlegene Leistung wird dabei trotz erheblicher Einschränkungen durch lokale Nachbarschaftssampling erzielt, was das immense Potential dieser Methoden unterstreicht. Betrachtet man die praktischen Anwendungen, profitieren zahlreiche Bereiche von der Einführung Relationaler Graph Transformer. Im Kundenmanagement können präzisere Churn-Vorhersagen getroffen und personalisierte Angebote effizienter erstellt werden. Im Bereich der Betrugserkennung ermöglichen diese Modelle das Erkennen versteckter Muster über mehrere Entitäten hinweg, die mit herkömmlichen Verfahren schwer zu finden wären.

Auch in der Lieferkettenoptimierung und der Bedarfsprognose erweisen sich Relationale Graph Transformer als wertvolles Werkzeug, um komplexe Abhängigkeiten und Entwicklungsdynamiken präzise zu erfassen. Die Integration dieser Technologie ist mittlerweile auch für Unternehmen ohne spezialisierte Data-Science-Teams zugänglich. Plattformen wie Kumo AI bieten praxisnahe Lösungen, mit denen Datenverantwortliche ohne tiefgreifende technische Kenntnisse eigene Graph Transformer Modelle trainieren und nutzen können. Automatisierte Machine-Learning-Pipelines und benutzerfreundliche Schnittstellen erleichtern die Anbindung an vorhandene relationale Datenbanken und beschleunigen somit den Einstieg in diese innovative Technologie. Zukunftsorientiert bieten Relationale Graph Transformer noch reichlich Potenzial für Weiterentwicklungen.

Verbesserte Sampling-Methoden, erweiterte globale Kontextmechanismen über Cross-Attention Funktionen sowie die Entwicklung noch aussagekräftigerer Positionskodierungen könnten die Modellleistung weiter steigern. Zudem sind hybride Ansätze denkbar, bei denen Graph Transformer mit anderen KI-Techniken kombiniert werden, um so beispielsweise Erklärbarkeit und Effizienz zugleich zu verbessern. Zusammenfassend lässt sich festhalten, dass Relationale Graph Transformer eine grundlegende Neuausrichtung der Datenanalyse in relationalen Datenbanken ermöglichen. Sie überwinden die Einschränkungen vorheriger Methoden durch die native Verarbeitung von komplexen Beziehungsstrukturen und multidimensionalen Datenmodalitäten. Unternehmen können dadurch schneller zu aussagekräftigen Erkenntnissen gelangen, Entscheidungen fundierter treffen und Wettbewerbsvorteile in zunehmend datengetriebenen Märkten sichern.

Wer heute die Potentiale relationaler Graph Transformer nutzt, legt den Grundstein für eine dateninformierte Zukunft, in der intelligente Systeme nicht nur Daten lesen, sondern deren Verbindungen verstehen und sinnvoll nutzen können.

![AI still tells terrible financial advice [pdf]](/images/9B9E5D12-992F-45C3-93AF-35BAAA884C9C)