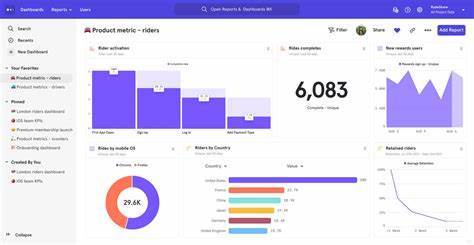

In der heutigen datengetriebenen Geschäftswelt ist der Zugriff auf präzise und aktuelle Produktanalysen unerlässlich, um fundierte Entscheidungen zu treffen. Doch gerade bei einem schnell wachsenden Unternehmen kann die hohe Belastung durch umfangreiche Analyseanfragen die unterliegende Datenbank erheblich beeinträchtigen. Dies führt nicht selten zu Performance-Einbrüchen, Verzögerungen in Dashboards und schlimmstenfalls zum kompletten Ausfall wichtiger Anwendungen. Ein solcher „Datenbank-Kollaps“ kann immense Kosten verursachen und das Kundenerlebnis nachhaltig negativ beeinflussen. Um diese Situation zu vermeiden, gilt es, sowohl die Architektur als auch die eingesetzten Technologien und Methoden für Produktanalysen sorgfältig zu planen und umzusetzen.

Die Herausforderung liegt darin, analytische Abfragen so zu gestalten, dass sie keine übermäßigen Ressourcen der produktiven Datenbank beanspruchen und gleichzeitig schnelle, belastbare Ergebnisse liefern. In diesem Zusammenhang lohnt sich ein Blick auf typische Szenarien aus dem Startup-Alltag, bei denen Dashboard-Abfragen unerwartete Lastspitzen verursachten und was man daraus lernen kann. Oft beginnt alles mit einer einfachen Abfrage, die beispielsweise Monatsumsätze, durchschnittliches Kundenalter oder Anzahl unterschiedlicher Kunden nach Regionen aggregiert. Im Normalfall sind diese Abfragen überschaubar, doch sobald sich die Datenmenge vervielfacht oder ein besonderes Ereignis wie eine Flash-Sale-Kampagne enorme Transaktionsvolumina generiert, kommt die Datenbank schnell an ihre Grenzen. Ein grundlegendes Problem ist, dass viele solcher Abfragen mehrere Millionen Datensätze scannen müssen, um relevante Informationen zu aggregieren.

Dabei finden ressourcenintensive Operationen wie Full-Table-Scans, aufwändige Joins über große Tabellenmengen, komplexe Gruppierungen und Distinct-Zählungen statt. Die Summe dieser Anforderungen bewirkt, dass CPUs ausgelastet werden, viel Arbeitsspeicher benötigt wird und I/O-Operationen die Festplatten belasten. Dies zeigt sich zudem darin, dass Transaktionsdatenbanken wie PostgreSQL zwar effiziente MVCC-Techniken (Multiversion Concurrency Control) nutzen, um Sperren zu minimieren, jedoch bei großen Datenmengen und komplexen Analyseabfragen unerwartete Belastungsspitzen entstehen. Ein verbreiteter Fehler besteht darin, Analyseabfragen direkt auf produktive Transaktionsdatenbanken auszuführen, ohne die speziellen Anforderungen analytischer Workloads zu berücksichtigen. Solche Datenbanken sind optimiert für punktuelle Lese- und Schreibzugriffe mit hoher concurrency, nicht für großflächige Joins und Aggregationen auf Millionen von Datensätzen.

Eine einzige schlecht optimierte Dashboards-Abfrage kann dadurch ganze Systeme ins Stocken bringen und sogar wichtige Geschäftsprozesse gefährden. Um derartigen Problemen zu begegnen, greifen Teams häufig zuerst zu kurzfristigen Optimierungen. Ein klassisches Mittel ist das Anlegen von Indizes. Gut gewählte Indexstrukturen können Filteroperationen beschleunigen, indem sie schnellen Zugriff auf relevante Datensätze gewähren und so Full-Table-Scans vermeiden. Dies führte in vielen Fällen zu einer deutlichen Verbesserung der Antwortzeiten etwa beim Dashboard-Rendering.

Es ist jedoch wichtig zu erkennen, dass Indizes bei hohen Schreiblasten zusätzliche Belastungen verursachen können, da jeder Index bei Datenänderungen aktualisiert werden muss. Dies wiederum kann die Schreibperformance negativ beeinflussen und zu einem Wachstum des Speicherplatzbedarfs führen. Darüber hinaus bieten Indizes wenig Entlastung bei Aggregationen wie COUNT DISTINCT, die weiterhin alle zugrundeliegenden Daten durchlaufen müssen. Ein weiterer Schritt, der häufig unternommen wird, ist die Nutzung von Read Replicas. Diese schalten eine exakte Kopie der Produktionsdatenbank bereit, auf der ausschließlich Leseanfragen laufen.

Die Hauptdatenbank wird dadurch spürbar entlastet, da der Analytics-Traffic getrennt verarbeitet wird. Der Vorteil liegt auf der Hand: Die Produktionsdatenbank profitiert von niedrigeren CPU- und I/O-Lasten, während Dashboards weiterhin eine aktuelle Datenbasis zur Anzeige erhalten. Allerdings besteht hier das Problem, dass für jede Anpassung im Schema oder neue Indizes weiterhin diese Replik auf der Primärdatenbank erzeugt werden müssen. Zudem bleiben komplexe, rechenintensive Aggregationen auf der Replica kostspielig in Bezug auf Ressourcen. Um die Abfrageperformance nachhaltig zu verbessern, setzen viele Teams auf Materialized Views.

Dabei handelt es sich um vordefinierte Tabellen, die das Ergebnis komplexer Anfragen bereits im Voraus berechnen und speichern. Somit können Dashboards diese Materialized Views statt der eigentlichen Tabellen abfragen, was deutlich schneller ist. Die Herausforderung bei Materialized Views liegt in deren Aktualisierung: Sie müssen regelmäßig aktualisiert werden, um Datenkonsistenz und Aktualität sicherzustellen. Gerade bei stark wachsenden Datenmengen kann deren Pflege jedoch komplex und wartungsintensiv werden. Automatisierte Aktualisierungsprozesse sind notwendig, doch mit zunehmendem Datenvolumen steigt auch die Gefahr von Verzögerungen oder inkonsistenten Datenzuständen.

Darüber hinaus findet man in der Praxis oft den Vorschlag, Tabellen nach bestimmten Kriterien wie Zeiträumen zu partitionieren, also physisch in kleinere Segmente zu unterteilen. Dies kann Abfragen effizienter gestalten, indem beispielsweise nur die für das Analyseintervall relevanten Partitionen gelesen werden müssen. Obwohl Partitionierung grundsätzlich Vorteile bezüglich I/O und Planungszeiten bietet, erfordert sie eine sorgfältige Planung. Falsch implementierte oder nicht adäquat gewartete Partitionierungen können sogar kontraproduktiv sein und die Komplexität erhöhen. Ein Weg, der von manchen Teams begangen wird, ist das Skalieren der Datenbankhardware durch Aufrüstung von CPUs, RAM und Festplattenspeicher.

Dies ist oft eine kurzfristige Lösung, die jedoch mit wachsenden Datenmengen und komplexeren Abfragen schnell an ihre Grenzen stößt. Auch das horizontale Skalieren durch Sharding, also die Aufteilung der Datenbank auf mehrere Server, klingt attraktiv, birgt aber erhebliche Herausforderungen in Bezug auf Datenkonsistenz, Query-Logik und Verwaltungsaufwand. Im Kern zeigt sich, dass relationale Transaktionsdatenbanken für analytische Workloads nicht ideal sind, da sie im Row-Store-Format gespeicherte vollständige Datensätze lesen. Selbst wenn nur wenige Spalten einer breiten Tabelle benötigt werden, müssen alle Spalten gelesen und verarbeitet werden, was immense I/O-Operationen erzeugt. Moderne analytische Workloads profitieren jedoch stark von der Nutzung von Columnar Storage, in dem nur relevante Spalten gelesen und Daten stark komprimiert werden.

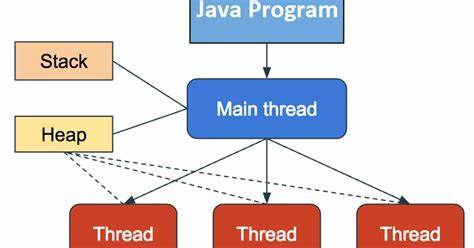

Die Verarbeitung erfolgt spaltenweise, was deutlich effizienter ist für Filter, Aggregationen und große Scans. Diese Erkenntnis hat in den letzten Jahren zu einer neuen Welle analytischer Datenbanken geführt, die speziell für solche Workloads optimiert sind. Solche Systeme verwenden moderne Kompressionsverfahren, spaltenorientierte Speichermodelle und vectorisierte Ausführungspipelines, um extrem schnelle Ausführung selbst bei großen Datenvolumen zu gewährleisten. Unternehmen mit großem Datenvolumen und entsprechendem Data Engineering Team setzen häufig auf spezialisierte Data Warehouses wie Snowflake oder Google BigQuery. Diese Plattformen trennen die analytischen Daten vollständig von der produktiven Umgebung und bieten skalierbare Ressourcen für Analyse-Workloads.

Damit einher geht oft ein ETL- (Extract, Transform, Load) oder ELT-Prozess, der kontinuierlich Daten aus der operativen Datenbank extrahiert, bereinigt und in den Data Warehouse lädt. Dadurch reduzieren sich Lastspitzen auf die Produktivdatenbank enorm, während Analysten trotzdem zeitnah auf aggregierte und bereinigte Daten zugreifen können. Allerdings geht der Betrieb solcher Pipelines mit zusätzlicher Komplexität und Abhängigkeit von spezialisierten Data Engineering Teams einher. Fehlermeldungen, Pipeline-Ausfälle oder verzögerte Aktualisierungen stellen reale Risiken dar. Nicht zuletzt kann der Faktor Datenfrische zu einem Zielkonflikt führen.

Während produktive Dashboards oft Echtzeitdaten erwarten, sind bei Batch-orientierten Pipelinearchitekturen oft Verzögerungen von Stunden bis Tagen zu beobachten. Dies kann insbesondere bei wichtigen Kundenanwendungen zu Verwirrung oder sogar geschäftlichen Nachteilen führen, wenn Daten nicht adäquat synchron sind. Eine Alternative zur kompletten Data-Warehouse-Architektur stellen moderne analytische Datenbanken dar, die als leichtgewichtige oder eingebettete Engines funktionieren. DuckDB beispielsweise ist eine spaltenorientierte Datenbank, die lokal oder eingebettet in Anwendungen läuft und auch ohne großen Administrationsaufwand schnelle analytische Abfragen ermöglicht. Dies ist besonders attraktiv für Teams, die keine volle Data-Warehouse-Infrastruktur betreiben wollen, aber dennoch von effizienten Analysen profitieren möchten.

Für Unternehmen mit größeren Datenmengen und Bedürfnissen an verteilter Verarbeitung bieten Systeme wie ClickHouse extrem schnelle Abfragen bei massiv verteilt gespeicherten Daten. Für Teams, die PostgreSQL als Kernsystem beibehalten möchten, gibt es spezialisierte Read-Replica-Lösungen mit analytischem Fokus wie BemiDB, die automatische Datenreplikation und Spaltenspeicherung kombinieren. Im Umfeld von Echtzeit-Analytics kommen Lösungen wie Materialize zum Einsatz, die inkrementelle View-Updates direkt bei Datenänderungen durchführen. Hierdurch können Echtzeit-Dashboards realisiert werden, ohne ganze Abfragen ständig neu auszuführen. Solche Streaming-Ansätze sind ein vielversprechender Trend, der aber gerade für kleinere Unternehmen noch mit erhöhtem technischen Aufwand und Know-how verbunden sein kann.

Letztlich hängt die Wahl der richtigen Architektur und Technologie von mehreren Faktoren ab: dem Datenvolumen, den Anforderungen an Datenfrische, der Komplexität der Abfragen, der vorhandenen Expertise im Team und den operativen Kapazitäten. Nicht jede Firma benötigt sofort den vollen Umfang eines Data Warehouses. Ein zielgerichteter Einsatz leichter analytischer Engines kann oft viele Probleme vermeiden und die Stabilität der Produktivumgebung sichern. Wichtig ist, frühzeitig die Grenzen von Transaktionsdatenbanken für analytische Anforderungen zu erkennen und gezielte Strategien zu entwickeln. Dazu gehört, Daten getrennt zu speichern, Analysen vorzubereiten und nicht mehr direkt auf der Produktivdatenbank zu performen.

Ein pragmatischer Ansatz mit einem Mix aus Technologie, Optimierungen und organisatorischer Zusammenarbeit hilft Unternehmen, effektive Produktanalysen zu realisieren, ohne in den sogenannten Datenbank-Kollaps zu laufen. Abschließend zeigt das Beispiel startuptypischer Szenarien: Unbedachtes Ausführen großer Dashboard-Queries im Produktionssystem kann schnell zu kritischen Performanceproblemen führen. Konventionelle Gegenmaßnahmen wie Indexes und Read Replicas bringen Verbesserungen, lösen die eigentliche Architekturproblematik jedoch nicht vollständig. Aufwändige ETL-Prozesse in Data Warehouses müssen gegen operationalen Aufwand und Verzögerungen abgewogen werden. Die neuesten analytischen Technologien ermöglichen heute dennoch eine unkomplizierte, skalierbare und performante Verarbeitung.

Unternehmen profitieren von einer wohlüberlegten Kombination aus bewährten Konzepten und modernen Lösungen, die maßgeschneidert auf ihre Bedürfnisse abgestimmt sind. Somit entsteht eine nachhaltige und agile Infrastruktur für Produktanalysen ohne Datenbank-Kollaps – ein entscheidender Wettbewerbsvorteil in der datengetriebenen Zukunft.