Die rasante Entwicklung von Künstlicher Intelligenz prägt zahlreiche Bereiche unseres Lebens, insbesondere im Zusammenspiel von Bildern und Sprache. Vision-Language-Modelle (VLMs) gehören zu den Innovationen, die es möglich machen, dass Maschinen Bilder verstehen und mit Texten in Beziehung setzen können. Diese Technologie findet bereits Anwendung in vielfältigen Szenarien, vom automatisierten Sortieren von Fotos bis hin zur Unterstützung medizinischer Diagnosen mit bildbasierten Daten. Doch trotz ihrer vermeintlichen Leistungsfähigkeit offenbart eine jüngst veröffentlichte Studie des Massachusetts Institute of Technology (MIT) erhebliche Schwächen: Vision-Language-Modelle sind kaum in der Lage, Verneinungen wie „nicht“ oder „kein“ korrekt zu verarbeiten. Diese Entdeckung stellt die Zuverlässigkeit solcher Systeme insbesondere in kritischen und bereichsspezifischen Anwendungen infrage.

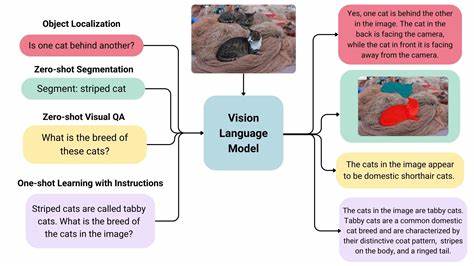

Das grundsätzliche Prinzip von Vision-Language-Modellen beruht darauf, dass sie Bildinhalte mit passenden Textbeschreibungen verknüpfen. Hierfür werden große Datensätze aus Bildern und dazugehörigen Bildtexten verwendet, sodass die Modelle lernen, visuelle Objekte und Aktionen mit entsprechenden sprachlichen Ausdrücken zu assoziieren. Typischerweise arbeiten VLMs mit zwei separaten Encodern – einem für Bilder und einem für Text. Diese erzeugen jeweils numerische Repräsentationen, sogenannte Vektoren, die anschließen mittels Ähnlichkeitsmaßen miteinander verglichen werden. Auf diese Weise soll sichergestellt werden, dass zum Beispiel ein Foto einer Katze und der Text „eine sitzende Katze“ ähnliche Repräsentationen erzeugen, was die semantische Übereinstimmung bestätigt.

Eine entscheidende Schwäche der Modelle ergab sich hinsichtlich der Behandlung von Negationen. Tatsächlich basieren die Trainingsdaten meist auf positiven Beschreibungen, welche lediglich enthalten, was auf einem Bild zu sehen ist. Es gibt nur sehr wenige bis gar keine Beispiele, die explizit erwähnen, was nicht auf dem Bild dargestellt ist. Ein Bild mit einem Hund, das im Text nicht ausdrücklich vermerkt, dass es keinen Helikopter gibt, verweist darauf, dass Verneinungen schlichtweg fehlen. Diese Lücke führt dazu, dass VLMs Verneinungen entweder ignorieren oder falsch interpretieren.

Infolgedessen tendieren sie dazu, die bloßen Existenz von Objekten anzuerkennen, ohne die Negation mit einzubeziehen – ein Phänomen, das die Forscher als „Affirmation Bias“ bezeichnen. Die Auswirkung dieser Unzulänglichkeit ist besonders gravierend, wenn Vision-Language-Modelle in sensiblen Bereichen wie der medizinischen Diagnose zum Einsatz kommen. Stellen wir uns vor, ein Radiologe untersucht ein Röntgenbild eines Patienten. Auf dem Bild ist beispielsweise eine Schwellung im Gewebe erkennbar, jedoch kein vergrößertes Herz. Wenn ein VLM den Bericht mit anderen Fällen abgleicht, aber Verneinungen wie „kein vergrößertes Herz“ nicht erkennt, könnte das Modell fälschlicherweise Berichte herausfiltern, die beide Bedingungen - sowohl die Schwellung als auch ein vergrößertes Herz - umfassen.

Dies kann die diagnostische Einschätzung massiv verfälschen und letztlich falsche Behandlungsentscheidungen nach sich ziehen. Zur Überprüfung der Fähigkeiten von VLMs beim Umgang mit Verneinungen haben die MIT-Forscher zwei spezifische Testverfahren entwickelt. Zunächst verwendeten sie ein großes Sprachmodell, um vorhandene Bildbeschreibungen zu überarbeiten und gezielt Verneinungen in die Captions aufzunehmen. Anschließend testeten sie, wie gut VLMs in der Lage waren, Bilder mit bestimmten Objekten zu finden, die aber explizit andere Objekte nicht enthalten sollten. Die Ergebnisse zeigten, dass die Leistung um fast 25 Prozent einbrach, sobald Verneinungen ins Spiel kamen – die Modelle entfernten sich teilweise von einem zufälligen Rateverhalten.

Ein weiterer Test fokussierte Multiple-Choice-Fragen, bei denen VLMs die bestpassende Bildbeschreibung aus mehreren ähnlichen Alternativen wählen mussten. Auch hier wurde Verneinungstext hinzugefügt, der das Vorhandensein oder Fehlen von Objekten differenzierte. Auch in diesem Szenario erreichten die besten Modelle nur rund 39 Prozent Genauigkeit, wobei einige Modelle Werte zeigten, die schlechter als ein reiner Zufallstreffer waren. Diese Beispiele verdeutlichen eindrucksvoll, wie massiv die aktuelle Schwäche von Vision-Language-Modellen im Bereich Negation ist. Angesichts dieser Probleme entwickelten die Wissenschaftler einen Ansatz, der auf der Erweiterung der Trainingsdaten um synthetisch generierte Bildunterschriften mit Verneinungen basiert.

Mithilfe eines großen Sprachmodells erstellten sie aus einem Datensatz mit rund 10 Millionen Bild-Text-Paaren neue Caption-Varianten. Diese Captions wurden so formuliert, dass sie natürliche Sprache simulieren und gleichzeitig explizit negierte Inhalte ausdrücken, etwa indem sie formulieren, welche Objekte auf dem Bild fehlen. Mit diesem erweiterten Datensatz wurde das Training von Vision-Language-Modellen verfeinert. Die daraus resultierenden Modelle zeigten erhebliche Verbesserungen: Die Fähigkeit, Bilder mit Berücksichtigung von Verneinungen abzurufen, stieg um etwa 10 Prozent. Bei der Multiple-Choice-Aufgabe legte die Genauigkeit sogar um rund 30 Prozent zu.

Diese Erkenntnisse signalisieren, dass das Problem grundsätzlich lösbar ist, wenn Trainingsdaten gezielter und vielfältiger gestaltet werden. Dennoch warnen die Forscher davor, dies bereits als endgültige Lösung zu betrachten. Die bisherige Arbeit fokussiert sich vor allem auf Datenaugmentation und berührt nicht die grundlegende Funktionsweise der Modelle. Es sind tiefere Eingriffe erforderlich, beispielsweise die getrennte Verarbeitung von Bild- und Textinformationen oder die Entwicklung spezieller architektonischer Konzepte, um die Bedeutung von Verneinungen besser zu erfassen. Die Bedeutung dieser Forschung ist nicht auf den medizinischen Bereich beschränkt.

Anwendungen von Vision-Language-Modellen in der Qualitätskontrolle in der Industrie etwa könnten ebenfalls gravierende Fehler produzieren, wenn Produkte mit bestimmten Mängeln erkannt werden sollen, von denen ausgeschlossen wird, dass sie andere bestehende Defekte haben. Überhaupt gilt für alle Domänen, in denen das Fehlen eines Merkmals genauso wichtig ist wie seine Anwesenheit, dass die korrekte Erkennung von Verneinungen zentral ist. Die Studie unterstreicht die Notwendigkeit einer kritischen Evaluation der momentanen Einsatzbereiche von Vision-Language-Modellen. Große KI-Modelle werden inzwischen oft blind vertraut und in hochsensiblen Umgebungen eingesetzt, obwohl ihnen elementare sprachliche Strukturen wie Negationen nicht zuverlässig zugänglich sind. Die Forscher betonen, dass die Industrie und Wissenschaft hier geboten sind, die derzeitige Behandlung der Daten, die Modellarchitekturen und die Testverfahren grundlegend zu überprüfen und anzupassen.