Die Welt der GPU-Programmierung wird seit Jahren von CUDA dominiert, der proprietären Plattform von NVIDIA, die für Hochleistungsrechner und Deep Learning maßgeblich ist. Die zunehmende Verbreitung von KI-Anwendungen und die Weiterentwicklung von Hardware eröffnen jedoch neue Chancen und Herausforderungen für Entwickler und Unternehmen. Ein Thema, das dabei immer wieder in Foren und Communities diskutiert wird, ist die Migration bestehender CUDA-Projekte auf alternative Plattformen oder Frameworks. Dieser Beitrag beleuchtet, wie der aktuelle Stand in der Migration von CUDA aussieht, welche Ansätze existieren und welche Erfahrungen Nutzer bisher gemacht haben. CUDA hat sich insbesondere durch seine enge Verzahnung mit NVIDIA-GPUs und den daraus resultierenden hohen Performanzgewinnen als Standard etabliert.

Viele Entwickler und Unternehmen haben massiv in CUDA-basierten Code investiert, was eine Migration zu alternativen Lösungen oft als riskant und aufwendig erscheinen lässt. Dennoch wächst der Bedarf, CUDA-abhängige Anwendungen für andere Hardwareplattformen oder zukunftssichere Ökosysteme anzupassen. Gründe hierfür sind unter anderem die Begrenzung auf NVIDIA-Produkte, die Kosten für Hardware und Lizenzen sowie das Aufkommen neuer konkurrierender Frameworks und Architekturen wie AMDs ROCm oder Intels OneAPI. Eine besonders interessante Entwicklung in diesem Kontext ist die Einführung von Plattformen, die eine einfachere Migration ermöglichen wollen. Hierbei hebt sich CANN 6.

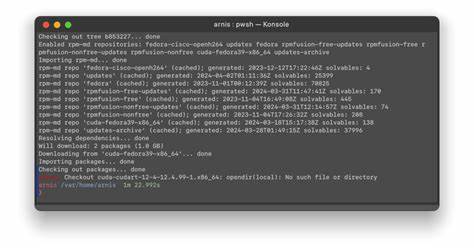

0 (Compute Architecture for Neural Networks), eine Technologie von Huawei, hervor, die eine angeblich „Ein-Klick-Migration“ von CUDA-Code verspricht und eine PyTorch-Kompatibilität von etwa 95 Prozent erreicht. Diese Angaben wecken Hoffnung bei Entwicklern, die sich bisher vor dem großen Aufwand einer manuellen Portierung gescheut haben. Doch wie realistisch ist eine solche Migration und welche Erfahrungen wurden bislang gesammelt? In der Praxis zeigt sich, dass die Automatisierung von Migrationen von CUDA-Code auf andere Plattformen zwar Fortschritte macht, jedoch nicht ohne Einschränkungen ist. Viele Nutzer berichten, dass gewisse CUDA-spezifische Features, Bibliotheken und Optimierungen nicht eins zu eins übertragen werden können. Das bedeutet, dass nach der automatischen Konvertierung manuelle Nacharbeiten notwendig sind, um die Performance und Stabilität der Anwendungen zu gewährleisten.

Insbesondere komplexe Kernel-Implementierungen, hardware-spezifische Optimierungen und Bibliotheksaufrufe erfordern nach wie vor Fachwissen und Feintuning. Dennoch stellt eine partielle Automatisierung für viele Anwender eine enorme Zeitersparnis dar und erleichtert den Einstieg in alternative Frameworks. Neben technischen Herausforderungen spielen auch der Support und die Community-Unterstützung eine große Rolle. Plattformen wie ROCm von AMD oder OneAPI sind aktiv in der Weiterentwicklung und bieten zunehmend kompatible Tools zur Migration. Die breitere Hardware-Unterstützung, offene Standards und eine offene Entwicklergemeinschaft zeigen positive Effekte bei der Verbreitung und Stabilisierung der Alternativen.

Im Gegensatz dazu bleibt CUDA durch seine proprietäre Natur stark an NVIDIA gebunden, was in bestimmten Projekten als Nachteil empfunden wird, vor allem wenn eine Multi-Hardware-Kompatibilität gefordert ist. Für Entwickler, die den Schritt wagen möchten, empfiehlt es sich, eine sorgfältige Analyse des bestehenden Codes vorzunehmen, die genutzten CUDA-Funktionalitäten zu dokumentieren und mögliche Alternativen zu recherchieren. Zudem ist das Experimentieren mit Hybridansätzen sinnvoll, bei denen Teile des Codes weiterhin in CUDA laufen, während andere Komponenten schrittweise migriert werden. Ein vollständiger Rewrite ist oftmals nicht zwingend erforderlich, wenn man auf moderne Migrationswerkzeuge und Framework-Unterstützung setzt. Auch die Zukunft der GPU-Programmierung wird durch die Suche nach besseren und flexibleren Lösungen geprägt sein.

Die technische Landschaft ist im Wandel. Neue Entwicklungsansätze wie ML-optimierte Compiler, Hardware-agnostische Frameworks und standardisierte Schnittstellen könnten mittelfristig einen grundlegenden Wandel mit sich bringen und die Abhängigkeit von einzelnen Herstellern reduzieren. Insbesondere im Bereich Künstliche Intelligenz ist das Potenzial groß, dass Migrationen von CUDA zu alternativen Plattformen zunehmend an Bedeutung gewinnen, um Modelle sowohl auf verschiedenster Hardware als auch in heterogenen Cloud-Umgebungen effizient betreiben zu können. Abschließend lässt sich festhalten, dass die Migration von CUDA keine triviale Aufgabe ist, aber durch neue Tools und Frameworks zunehmend praktikabler wird. Wer sich auf den Prozess einlässt und die Eigenheiten der Zielplattformen beherrscht, kann von größerer Flexibilität, Kosteneinsparungen und Zukunftssicherheit profitieren.

Parallel dazu bleibt CUDA aufgrund seiner hohen Performanz und des Ecosystems weiterhin eine wichtige Säule im GPU-Computing. Die Balance zwischen Innovation und Bewährtem wird somit für viele Entwickler und Unternehmen zu einem zentralen Erfolgsfaktor.