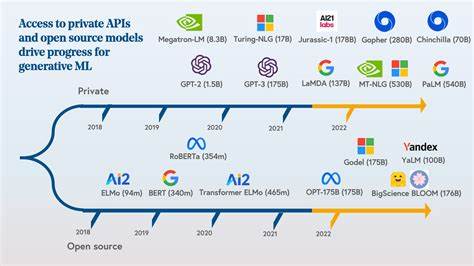

Die rasante Entwicklung generativer Künstlicher Intelligenz hat die Art und Weise revolutioniert, wie wir mit Technologie interagieren, Inhalte erstellen und Entscheidungen treffen. Von Chatbots über Bildgeneratoren bis hin zu komplexen Sprachmodellen erweitern generative KI-Systeme kontinuierlich ihre Einsatzmöglichkeiten. Mit diesem Fortschritt wächst jedoch auch die Notwendigkeit einer unabhängigen, transparenten und zuverlässigen Evaluierung dieser Modelle. Genau hier setzt Atlas an, eine Plattform, die sich auf die unabhängige Bewertung und das Benchmarking generativer KI-Modelle spezialisiert hat. In einer Welt, in der zahlreiche KI-Modelle auf den Markt drängen, ist es für Entwickler, Unternehmen und Endnutzer essenziell, verlässliche Informationen über die Leistungsfähigkeit verschiedener Systeme zu erhalten.

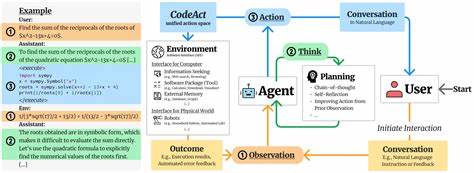

Oft basieren Vergleiche auf subjektiven Erfahrungswerten oder von den Produzenten selbst veröffentlichten Daten, die nicht selten zu optimistisch oder einseitig dargestellt sind. Atlas verfolgt einen anderen Ansatz: Die Plattform bietet unabhängige, objektive Evaluierungen, die anhand einheitlicher Metriken und realitätsnaher Tests durchgeführt werden. Das Herzstück von Atlas ist ein umfangreiches Framework, das es ermöglicht, verschiedene Modelle unter ähnlichen Bedingungen miteinander zu vergleichen. Durch standardisierte Testverfahren werden die generativen Fähigkeiten der KI-Systeme in unterschiedlichen Szenarien geprüft. Dabei fließen verschiedene Aspekte wie Textqualität, Kreativität, Kohärenz, Verständlichkeit und in manchen Fällen auch die Fähigkeit zur Faktenwiedergabe in die Bewertung ein.

Diese umfassende Herangehensweise stellt sicher, dass die Resultate von Atlas nicht nur oberflächliche Effekte widerspiegeln, sondern tiefgreifende Einsichten bieten. Die unabhängige Positionierung von Atlas bewahrt die Glaubwürdigkeit der Ergebnisse. Da weder Hersteller noch externe Investoren Einfluss auf die Bewertung nehmen, können Nutzer der Plattform auf vertrauenswürdige Daten zurückgreifen. Dies ist besonders wichtig, da die KI-Branche oft von Marketingaussagen geprägt ist und objektive Fakten häufig untergehen. Atlas schafft durch diese neutrale Haltung eine verlässliche Grundlage für fundierte Entscheidungen – sei es für den Einkauf von KI-Lösungen, die Auswahl eines Modells für Forschungszwecke oder die Integration in kommerzielle Produkte.

Ein weiterer starker Vorteil von Atlas liegt in der Transparenz des gesamten Evaluationsprozesses. Die Plattform veröffentlicht nicht nur die endgültigen Scores, sondern gibt auch Einblick in verwendete Testdaten, Bewertungsmetriken und die Methodik. Diese Offenheit ermöglicht es der Community, den Prozess nachzuvollziehen, eigene Rückschlüsse zu ziehen und gegebenenfalls Verbesserungsvorschläge einzubringen. Die Einbindung der Nutzer trägt dazu bei, Atlas stetig weiterzuentwickeln und die Relevanz der Bewertungskriterien den jeweiligen Fortschritten der KI-Technologie anzupassen. In der Praxis zeigt Atlas bereits, wie wertvoll eine unabhängige Evaluierung sein kann.

Unternehmen, die auf der Suche nach einem passenden generativen KI-Modell für spezifische Anwendungen sind, profitieren enorm von vergleichbaren Daten zu Leistungsfähigkeit und Stärken der verschiedenen Systeme. So können Ressourcen optimiert und Fehlinvestitionen vermieden werden. Forschende wiederum nutzen die Plattform, um den Stand der Technik zu verstehen, Benchmarks zu setzen und ihre eigenen Modelle gezielter zu verbessern. Die Fokussierung auf generative KI-Modelle ist dabei speziell auf die Herausforderungen zugeschnitten, die mit der Erzeugung neuer Inhalte verbunden sind. Anders als bei klassischer KI, die sich oft auf vorhersehbare, rein analytische Aufgaben beschränkt, benötigen generative Systeme ein komplexes Verständnis von Kontext, Kreativität und Vielschichtigkeit.

Atlas greift diese Besonderheiten auf und setzt entsprechende Bewertungskriterien an, die auf die Eigenheiten der Generierung zugeschnitten sind. Neben der reinen Bewertung unterstützt Atlas die Entwickler auch durch den Austausch von Best Practices und Erkenntnissen aus den Benchmarking-Prozessen. Die Plattform fungiert somit nicht nur als Kontrollinstanz, sondern als Dreh- und Angelpunkt im Ökosystem generativer KI. Eine lebendige Community entsteht, die zum Fortschritt der Technologie beiträgt und Innovationen fördert. Die zunehmende Bedeutung von generativen KI-Modellen in Wirtschaft, Forschung und Gesellschaft macht ein unabhängiges Benchmarking zu einem unverzichtbaren Instrument.