In einer zunehmend digitalisierten Welt gewinnt das Thema Identitätsmanagement immer mehr an Bedeutung. Insbesondere biometrische Verfahren versprechen eine einzigartige und fälschungssichere Identifikation von Menschen. Das Projekt World, früher bekannt als Worldcoin, hat mit seinem Modell zur biometrischen Identitätsprüfung durch Iris-Scans und der Verteilung seines eigenen Tokens WLD weltweit für Aufsehen gesorgt. Doch während das Projekt vor allem finanzielle Inklusion fördern möchte, häufen sich kritische Stimmen, die die Risiken für Selbstbestimmung, Privatsphäre und Dezentralisierung betonen. Die Kerndebatte dreht sich um die Frage, ob ein biometrisches Identifikationsmodell, das auf proprietärem Hardwareeinsatz und zentralisierten Datenströmen basiert, überhaupt mit dem Ideal der Selbstbestimmung vereinbar ist.

Selbstbestimmung, oder Self-Sovereignty, bedeutet, dass der Nutzer die volle Kontrolle über seine eigenen Daten und Identitäten hat, ohne dass diese von einer zentralen Instanz überwacht, kontrolliert oder manipuliert werden können. Dieses Prinzip steht im starken Gegensatz zu zentralen Systemen, in denen einzelne Organisationen oder Unternehmen über biometrische oder persönliche Daten verfügen. Einer der zentralen Kritikpunkte an World ist die Rolle des sogenannten Orbs, einer speziellen Hardware, die Iris-Scans erstellt, um Menschen eindeutig zu identifizieren. Trotz der Aussage, dass die Daten nach der Erfassung Ende-zu-Ende verschlüsselt übertragen und von der Hardware sofort gelöscht werden, bleibt die Abhängigkeit von einer geschlossenen und proprietären Hardware bestehen. Kritiker warnen vor einer Konzentration der Macht, die zu einem einzelnen Ausfallpunkt führen kann, was in Zeiten von Cyberangriffen oder politischem Druck ein erhebliches Risiko darstellt.

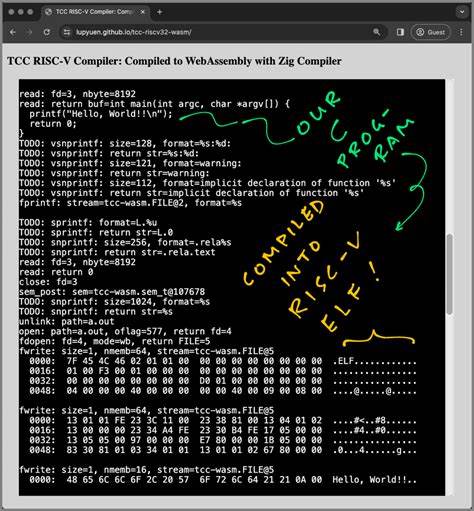

Die Technik, so erläutert Shady El Damaty, Mitbegründer der Holonym Foundation, kann nicht einfach von Nutzern individualisiert oder kontrolliert werden. Damit widerspricht sie dem Ethos einer dezentralen Architektur, die nicht nur technische Robustheit, sondern vor allem auch Nutzerkontrolle priorisiert. Neben der Hardware steht auch die Softwarearchitektur des Projekts in der Kritik. Obwohl World moderne Technologien wie Multiparty Computation und Zero-Knowledge-Beweise einsetzt, mit denen Daten anonymisiert verarbeitet werden sollen, sind diese Verfahren noch nicht ausreichend etabliert, um sicher und vollständig dezentral zu sein. Die Tatsache, dass World nach wie vor auf zentrale Code-Deployments und geschlossene Systeme setzt, sorgt für Skepsis hinsichtlich der tatsächlichen Privatsphäre und Selbstbestimmung der Nutzer.

Es bleibt unklar, inwieweit Anwender wirklich die Kontrolle über ihre biometrischen Daten behalten, wenn zentrale Knotenpunkte oder Infrastrukturen mögliches Ziel von Missbrauch oder staatlicher Überwachung werden. Ein weiterer Kritikpunkt bezieht sich auf die Zielgruppen von World. Das Unternehmen hat vor allem Menschen in Entwicklungsländern zur Teilnahme eingeladen. Diese Personen befinden sich häufig in prekären sozioökonomischen Verhältnissen und sind daher möglicherweise leichter beeinflussbar oder verstehen die Risiken für ihre Privatsphäre und die langfristigen Konsequenzen eines biometrischen Identitätssystems nicht vollständig. Die Gefahr, dass sensible biometrische Daten unter Druck oder aus Unkenntnis preisgegeben werden, ist real und führt zu ethischen Debatten darüber, ob solche Technologien einen modernen digitalen Kolonialismus fördern könnten.

Darüber hinaus sind viele Regierungen weltweit skeptisch gegenüber World. In Ländern wie Deutschland, Kenia und Brasilien wurden offizielle Bedenken geäußert, die sich auf die Sicherheit der biometrischen Nutzerdaten und deren rechtliche Verarbeitung beziehen. In Indonesien führte die Sorge der Regulierungsbehörden gar zur temporären Aussetzung der Zulassung des Projekts. Diese Reaktionen veranschaulichen, wie komplex und kontrovers die Implementierung eines solchen Systems in unterschiedlichen Rechtssystemen und kulturellen Kontexten ist. Die Frage der möglichen digitalen Exklusion ist ebenfalls relevant.

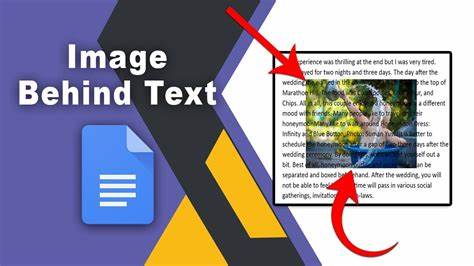

Das Argument lautet, dass der Zugang zu essentiellen digitalen Diensten an die biometrische Verifikation gekoppelt wird und damit faktisch eine Zweiklassen-Gesellschaft im digitalen Raum entsteht. Personen, die aufgrund von Datenschutzbedenken oder fehlenden Ressourcen die biometrische Identifikationsmethode ablehnen, könnten so vom Zugang zu grundlegenden Dienstleistungen ausgeschlossen werden. World bestreitet zwar, dass eine Biometrie-Pflicht besteht, dennoch bleibt die Sorge, dass sich ein Druck auf Nutzer aufbaut, ihre Daten preiszugeben, um im digitalen Raum voll teilhaben zu können. Neben dem Thema digitale Selbstbestimmung und Exklusion stellt sich die Frage nach der potenziellen Nutzung des Systems als Überwachungsinstrument, besonders in autoritären Staaten. Die Zentralisierung biometrischer Daten – auch wenn diese angeblich anonymisiert werden – könnte Regierungen oder mächtigen Akteuren als mächtiges Werkzeug dienen, um Nutzeraktivitäten zu verfolgen oder zu kontrollieren.

World behauptet allerdings, durch sein offenes und erlaubnisfreies Protokoll sei eine solche Rückverfolgung nicht möglich. Dennoch bleibt aufgrund der Komplexität und der technologischem und rechtlichen Herausforderungen ein Restrisiko bestehen. In diesem Kontext ist auch die Governance von World ein oft angesprochenes Thema. Die Entwickler heben hervor, dass das Projekt auf dem Weg zur Dezentralisierung ist und bereits Open-Source-Komponenten sowie erste Governance-Modelle eingeführt wurden, die eine Beteiligung der Community ermöglichen sollen. Die Kritik besagt jedoch, dass eine echte Nutzerkontrolle bislang nicht spürbar ist und das Modell weiterhin von wenigen zentralen Akteuren dominiert wird, was wiederum die Selbstbestimmung der Nutzer untergräbt.

Nicht zuletzt zeigt der Vergleich der Datenstrategien von World mit denen anderer Großprojekte wie OpenAI eine besorgniserregende Tendenz in der Tech-Branche auf. Während OpenAI vielfach für die Nutzung unautorisierter Nutzerdaten kritisiert wurde, verwendet World ähnliche aggressive Datenakquise-Methoden im sensiblen Bereich der biometrischen Daten. Diese Vereinbarung von Wachstum und Innovation mit enormen Risiken für Datenschutz und individuelle Rechte wird oft als problematisch erachtet und verdeutlicht einen dringenden Bedarf für klare ethische und regulatorische Leitplanken. Die Dringlichkeit für sichere und vertrauenswürdige Identifikationssysteme ist unbestritten. Mit der Zunahme von künstlicher Intelligenz und der Verschmelzung von menschlichen und nicht-menschlichen Interaktionen online steigt der Bedarf, eindeutig zwischen realen Personen und automatisierten Agenten zu unterscheiden.

Die Herausforderungen durch Betrug, Desinformation und Sicherheitsbedrohungen nehmen zu. Weltweit wird an Lösungen gearbeitet, die sowohl zuverlässige Verifikation als auch Nutzerdaten-Privatsphäre sicherstellen sollen. Hierbei spielen fortschrittliche kryptografische Verfahren eine entscheidende Rolle. Letztendlich zeigt der Fall World exemplarisch, wie komplex die Balance zwischen innovativer Technologie, Nutzerkontrolle und gesellschaftlichen Werten ist. Die biometrischen Identifikationsmodelle bieten spannende Möglichkeiten für finanzielle Inklusion und sichere digitale Kommunikation.

Doch nur wenn es gelingt, diese Systeme so zu gestalten, dass Datenhoheit, Dezentralisierung und Transparenz gewährleistet sind, besteht die Chance, den digitalen Wandel tatsächlich nutzerorientiert und freiheitserhaltend zu gestalten. Nur so kann das Vertrauen der Nutzer gewonnen und langfristige digitale Selbstbestimmung gewährleistet werden. Das Thema bleibt dynamisch und kontrovers. Für die Zukunft sind offene Debatten, verstärkte regulatorische Aufmerksamkeit und technologische Innovationen unerlässlich, um biometrische Identitätssysteme zu entwickeln, die kompatibel sind mit den Prinzipien der Selbstbestimmung, Privatsphäre und Inklusion – und solche, die nicht zur neuen Quelle zentralisierter Macht und Überwachung werden.