Die rasche Entwicklung im Bereich der künstlichen Intelligenz führt zu stetigen Verbesserungen bei großen Sprachmodellen, die zunehmend komplexe Aufgaben wie mathematische Problemlösungen, Programmierung und logisches Denken meistern. Das DeepSeek-R1-0528 Modell stellt in diesem Kontext einen bedeutenden Meilenstein dar. Mit einem Fokus auf verstärkte Tiefgründigkeit bei der Argumentation, effizientere Inferenzprozesse und reduzierte Fehler bei der Generierung, hebt sich die neueste Version deutlich von ihren Vorgängern und anderen Mitbewerbern ab. Die Aktualisierung basiert nicht nur auf einem gesteigerten Einsatz an Rechenressourcen, sondern auch auf intelligenten algorithmischen Optimierungen, die nach dem Training eingeführt wurden. Dadurch gelingt es dem Modell, in unterschiedlichen Benchmark-Tests neue Bestwerte zu erzielen und der Leistung führender Modelle wie O3 oder Gemini 2.

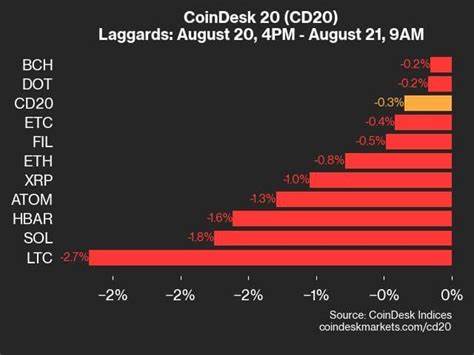

5 Pro nahezukommen. Eine der bemerkenswertesten Verbesserungen zeigt sich in der Mathematikleistung des Modells. Bei hochkomplexen Prüfungen wie dem AIME (American Invitational Mathematics Examination) konnte DeepSeek-R1-0528 seine Genauigkeit von vormals 70% auf beeindruckende 87,5% steigern. Dies ist maßgeblich auf die erhöhte Token-Nutzung pro Fragestellung zurückzuführen, die von durchschnittlich 12.000 Tokens im Vorgängermodell auf nunmehr 23.

000 Tokens anstieg. Diese Erweiterung der „Denkzeit“ erlaubt dem Modell, Inhalte tiefgründiger zu analysieren, Zwischenschritte besser zu verstehen und dadurch fundiertere Antworten zu liefern. Neben mathematischen Herausforderungen glänzt DeepSeek-R1-0528 auch durch seine verbesserten Fähigkeiten im Bereich der Programmierung. Mit einer deutlichen Steigerung beim Code-Benchmark LiveCodeBench von 63,5% auf 73,3% Passrate zeigt sich das Modell als verlässlicher Partner bei der Code-Erstellung und -Überprüfung. Auf Plattformen wie Codeforces konnte das Rating von 1530 auf 1930 angehoben werden, was eine zunehmende Effektivität in komplexen, realitätsnahen Programmieraufgaben bedeutet.

Ebenso ist der support für function calling verbessert worden, was die Interaktion mit externen Programmen und APIs deutlich vereinfacht und professionalisiert. Die Reduktion von Halluzinationen, also Fehlantworten oder unlogischen Ausgaben, markiert eine weitere Schlüsselverbesserung. In der Praxis bedeutet dies, dass DeepSeek-R1-0528 präzisere und verlässlichere Ergebnisse liefert, was gerade in kritischen Anwendungsgebieten wie Forschung oder automatisierter Entscheidungsfindung essentiell ist. Das Modell beeindruckt zudem mit gesteigerter Performanz in allgemeinen logischen Aufgaben und Sprachverständnisbenchmarks. Beim MMLU-Redux beispielsweise verbesserte sich die Genauigkeit von 92,9% auf 93,4%.

Obwohl diese Zahlen auf den ersten Blick moderat erscheinen mögen, zeigen sie dennoch eine konsequente Verfeinerung der Modellperformance auch in breitgefächerten Kontexten. Das Open-Source-Ökosystem profitiert parallel von der Entwicklung. Das auf DeepSeek-R1-0528 basierende DeepSeek-R1-0528-Qwen3-8B Modell ist ein herausragendes Beispiel dafür, wie anspruchsvolle Denkprozesse und komplexe Chain-of-Thought-Strategien selbst in kleineren Modellen wirksam angewendet werden können. Diese Version verzeichnet eine Steigerung um 10% bei der AIME 2024-Leistung im Vergleich zum ursprünglichen Qwen3-8B Modell und kommt sogar an die Resultate großer Modelle mit 235 Milliarden Parametern heran. Damit eröffnet das Modell nicht nur neue Chancen in der akademischen Forschung, sondern bietet auch industrielle Anwendern eine leistungsstarke und effiziente Alternative, um KI-intensivierte Anwendungen auf eng begrenzter Hardware zu realisieren.

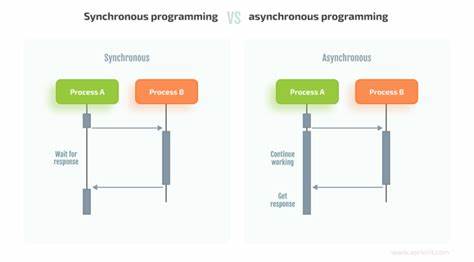

Besonders interessant ist der Ansatz des verstärkten Lernens mit einer Belohnungsstruktur, der in der wissenschaftlichen Veröffentlichung „DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning“ detailliert erläutert wird. Durch gezielte Verstärkung werden die Fähigkeiten der Modelle trainiert, komplexe Denkprozesse anzubahnen und zu optimieren. Dieses Prinzip bringt eine neue Dimension der Lernfähigkeit mit sich, die über reines Datenfressen hinausgeht und den Fokus auf zielgerichtete Problemlösungen legt. Für Entwickler und Nutzer bieten sich praktische Vorteile bei der Integration und Nutzung des Modells. Im Gegensatz zu alten Versionen ist es nicht mehr notwendig, spezielle Strings wie „<think>“ im Output zu verwenden, um das Modell zum fokussierten Nachdenken zu bringen.

Das System unterstützt jetzt offizielle System-Prompts, die eine komfortable Steuerung des Kontexts erlauben. Beispielsweise wird in der offiziellen DeepSeek-Webumgebung ein System-Prompt mit aktuellem Datum eingefügt, um zeitliche Relevanz und Konsistenz zu gewährleisten. Die Bereitstellung eines OpenAI-kompatiblen APIs vereinfacht zudem die Einbindung in bestehende Softwarelösungen und macht DeepSeek-R1-0528 zum optimalen Partner für vielfältige Anwendungsfelder etwa im Kundensupport, in der Content-Erstellung, bei komplexen Analyseaufgaben oder in interaktiven Chatbots. Weitere spannende Anwendungsbereiche finden sich in der mehrstufigen Dialogverarbeitung, wo DeepSeek-R1-0528 durch einen verbesserten Multiturn-Support besticht. Benchmarks wie BFCL_v3_MultiTurn belegen eine neue Dimension von Genauigkeit, die die Qualität fortlaufender Gespräche auf ein höheres Niveau hebt.

Daneben sind spezifische Branchen-Benchmarks wie Tau-Bench mit hervorragenden Ergebnissen für Bereiche wie Airline- und Retail-Szenarien ein Beweis für die praxisnahe Einsetzbarkeit in kommerziellen Umgebungen. Technisch gesehen basiert das Modell auf der bewährten Transformers-Architektur und nutzt Safetensors für effizientes und sicheres Modellmanagement. Die Unterstützung von FP8-Präzision trägt erheblich zur Geschwindigkeit und Ressourcenoptimierung bei, was gerade bei losen oder Cloud-basierten Rechenressourcen große Vorteile bietet. Durch die Veröffentlichung unter der MIT-Lizenz steht die Technologie der breiten Entwicklergemeinschaft offen und erlaubt sowohl kommerzielle Nutzung als auch das sogenannte „Distilling“, also das Herunterbrechen komplexer Modelle auf kleinere Versionen, die ressourcenschonender sind und dabei dennoch hohe Leistung bringen. Insgesamt zeigt DeepSeek-R1-0528 eindrucksvoll, wie moderne KI-Modelle durch gezielte Optimierungen auf mehreren Ebenen wachsen können.

Die Kombination aus erhöhter Denk- und Verarbeitungstiefe, verbesserten Code- und Matheleistungen sowie verringerten Fehlerquoten macht es zu einem Schwergewicht der nächsten Generation. Für Unternehmen, die auf Cutting-Edge KI setzen, bedeutet dies eine Steigerung der Effizienz und Präzision, während Forschungseinrichtungen von der verbesserten Modellbasis bei der Entwicklung neuer Denktechniken und Algorithmen profitieren. Die Zukunftsaussichten sind klar: Mit weiteren Iterationen und dem Austausch innerhalb der Community werden Modelle wie DeepSeek-R1-0528 die Grenzen des maschinellen Verstehens weiter verschieben und neue Maßstäbe für künstliche Intelligenz setzen.