Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren zahlreiche Bereiche revolutioniert, von der allgemeinen Sprachverarbeitung bis hin zu spezialisierten wissenschaftlichen Domänen. Besonders in den chemischen Wissenschaften eröffnen diese Technologien ganz neue Möglichkeiten, das Wissen der Forschung effizienter zu nutzen und chemische Problemstellungen automatisiert zu bearbeiten. Doch wie gut sind LLMs tatsächlich im Vergleich zur Expertise von menschlichen Chemikern? Können sie Wissen und komplexes chemisches Denken adäquat abbilden? Hierbei stellt sich die Frage, inwieweit diese Systeme die Chemie verstehen oder ob sie lediglich große Datenmengen reproduzieren. Ein aktuelles Forschungsprojekt hat sich genau dieser Thematik gewidmet und eine systematische Evaluation der chemischen Fähigkeiten von LLMs gegenüber professionellen Chemikern durchgeführt. Die Motivation für diese Untersuchung liegt in der zunehmenden Relevanz von LLMs in der wissenschaftlichen Forschung.

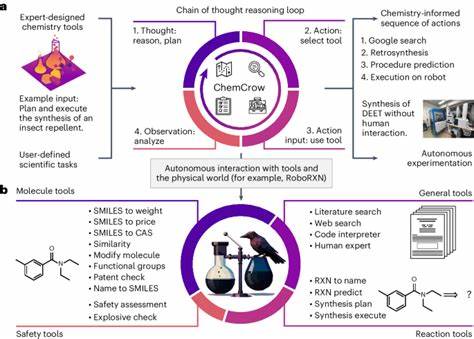

Viele dieser Modelle haben sich als in der Lage erwiesen, komplexe Textaufgaben zu lösen und sogar fachspezifische Prüfungen zu bestehen, wie etwa medizinische Fachprüfungen. Dies weckt sowohl Erwartungen als auch gewisse Bedenken, gerade im Bereich der Chemie, in dem Expertenwissen und präzise Analyse entscheidend sind. Dennoch fehlte bisher ein systematisches Bewertungsinstrument, das über einfache Datensatztests hinausgeht und ein ganzheitliches Bild der Fähigkeiten von LLMs in der Chemie vermittelt. Zur Füllung dieser Lücke wurde der ChemBench-Framework entwickelt. Diese umfassende Benchmark-Datenbank umfasst rund 2.

700 Frage-Antwort-Paare, die ein breites Spektrum an chemischen Themen abdecken. Sie wurde mit besonderem Augenmerk auf verschiedene Schwierigkeitsgrade und erforderliche Kompetenzen wie Wissensabruf, logisches Denken, Berechnungen und chemische Intuition gestaltet. Damit bietet ChemBench erstmals eine präzise Messlatte für das chemische Leistungsvermögen von LLMs und ermöglicht auch einen Vergleich mit fachkundigen Chemikern unterschiedlicher Spezialisierungen. Die Tests ergaben überraschende Resultate: Einige der leistungsstärksten LLMs, darunter proprietäre Modelle, übertrafen im Durchschnitt die Ergebnisse der teilnehmenden menschlichen Experten. Das zeigt, dass LLMs durch die Verarbeitung enormer Datenmengen und eine stark skalierte Modellarchitektur chemisches Wissen in bemerkenswerter Weise reproduzieren können.

Auch Open-Source-Modelle mit entsprechender Größe erreichen zum Teil ähnliche Leistungsniveaus. Diese Entwicklung wirft ein neues Licht auf den Einsatz dieser Technologien, insbesondere im Hinblick auf Assistenzsysteme für Chemiker, beispielsweise als digitale 'Copiloten' bei Forschung und Lehre. Gleichzeitig zeigten die Modelle klare Schwächen. Insbesondere bei Aufgaben, die tiefergehendes Wissen erfordern, etwa Daten über chemische Sicherheitsvorschriften oder spezifische toxikologische Informationen, sind die Antworten häufig ungenau oder inkonsistent. Zudem fällt auf, dass viele Modelle ihre Antwortsicherheit nicht zuverlässig einschätzen können.

Sie geben mitunter falsche Auskünfte mit hoher Zuversicht, was für den praktischen Einsatz ein erhebliches Risiko darstellt. Auch Aufgaben, die eine tiefere chemische Intuition oder komplexe logische Schlussfolgerungen erfordern, wie die Analyse von Spektren oder das Verständnis molekularer Symmetrien, stellen viele LLMs vor große Herausforderungen. Ein weiterer interessanter Aspekt ist die unterschiedliche Leistung der Modelle je nach chemischem Fachgebiet. So schneiden sie etwa in allgemeiner Chemie oder technischen Fragen deutlich besser ab als in Spezialgebieten wie analytischer Chemie oder in Themen der chemischen Sicherheit. Dieses Muster verweist darauf, dass die Datengrundlage und die Trainingsmethoden der Modelle stark darüber entscheiden, welche Bereiche sie sicher darstellen können.

Das menschliche Element bleibt dabei zentral. Die Chemiker, die an der Studie teilnahmen, konnten bei vielen komplexen Fragestellungen trotz Nutzung von Hilfsmitteln wie Webrecherchen oder spezialisierten Tools gegen die besten Modelle nicht mithalten. Doch Experten besitzen Fähigkeiten, die weit über die reine Wissensreproduktion hinausgehen, wie kritisches Denken, kreative Lösungsansätze und geübte Intuition, die sich aus jahrelanger Erfahrung speisen. Diese Qualitäten können derzeit von LLMs nur bedingt imitiert werden. Die Ergebnisse legen daher nahe, dass LLMs und menschliche Chemiker sich in der fachlichen Praxis hervorragend ergänzen können.

LLMs könnten als effiziente Informationslieferanten und Vorschlagsgeber wirken, während Experten durch kritische Prüfung und Weiterentwicklung die Ergebnisse bewerten und verfeinern. Der Weg zu einer automatisierten, sicheren und zuverlässigen KI-unterstützten Chemieführung erfordert jedoch noch bedeutende Fortschritte, insbesondere in Bezug auf Modellinterpretierbarkeit, zuverlässige Unsicherheitsabschätzung und Einbindung spezialisierter Datenbanken. Ein zusätzlicher wichtiger Aspekt ist die pädagogische Implikation. Da LLMs klassische Prüfungsfragen oftmals mühelos lösen, muss die Chemieausbildung neu gedacht werden. Die Fokussierung sollte zukünftig eher auf kritisches Denken, Problemlösung und experimentelles Design gelegt werden, statt auf das Auswendiglernen von Fakten.

So können zukünftige Generationen von Chemikern ihre Expertise auch in einer Ära der intelligenten Assistenten wirkungsvoll einsetzen. Auch ethische und sicherheitstechnische Fragen spielen im Zusammenhang mit leistungsfähigen LLMs in der Chemie eine bedeutende Rolle. Missbräuchliche Verwendungsmöglichkeiten, etwa für die Entwicklung toxischer Substanzen, bergen Risiken, die es durch angemessene Regulierungen und technische Schutzmaßnahmen zu minimieren gilt. Die breite Zugänglichkeit dieser Modelle macht es zudem erforderlich, dass Nutzer über deren Limitationen aufgeklärt werden, um Fehlinformationen beziehungsweise falsche Anwendung zu vermeiden. Der ChemBench-Ansatz als offenes Framework fördert zudem eine gemeinschaftliche Weiterentwicklung von Evaluationsmethoden und Modellverbesserungen.

Durch eine kontinuierliche Erweiterung der Datensätze und die Integration neuer Modelltypen kann ein dynamisches System geschaffen werden, das Fortschritte in der Modellierung transparent dokumentiert und so Forschung und Anwendung gleichermaßen voranbringt. Zusammenfassend lässt sich feststellen, dass große Sprachmodelle im Bereich der Chemie bereits heute beeindruckende Leistungen zeigen und in Teilbereichen die Leistung erfahrener Chemiker übertreffen. Dennoch bestehen substantielle Lücken hinsichtlich der zuverlässigen Anwendung, des sicheren Umgangs mit Fachwissen und der Fähigkeit zu tiefgründiger chemischer Analyse. Die Kombination aus menschlicher Expertise und KI-Unterstützung verspricht die Zukunft einer effizienteren, sichereren und innovativeren chemischen Forschung und Ausbildung. Diese Entwicklungen erfordern nicht nur technische Optimierungen, sondern auch eine interdisziplinäre Auseinandersetzung mit Bildungsstrategien, ethischen Fragen und der Implementierung von Kontrollmechanismen, um die Potenziale der LLMs verantwortungsvoll einzusetzen und die Rolle des Menschen als forschenden und kritischen Akteur zu bewahren.

Die Chemie befindet sich somit an einem spannenden Übergangspunkt, an dem Sprache, Daten und menschliche Kreativität neue Möglichkeiten und Herausforderungen zugleich eröffnen.