Die Entwicklung von Sprachmodellen hat in den letzten Jahren enorme Fortschritte gemacht. Diese Modelle bilden die Grundlage zahlreicher Anwendungen in Bereichen wie maschinelle Übersetzung, Textgenerierung, Sprachassistenz und vielen weiteren. Doch trotz der beeindruckenden Leistungsfähigkeit moderner Transformermodelle stehen Wissenschaftler und Entwickler weiterhin vor der Herausforderung, die Grenzen der Architekturdesigns zu erweitern und ein tieferes Verständnis für die zugrunde liegenden Mechanismen zu erlangen. Eine bedeutende jüngste Innovation in diesem Bereich ist die Einführung der sogenannten Canon Layers, die von Zeyuan Allen-Zhu in seiner Forschungsarbeit „Physics of Language Models: Part 4.1, Architecture Design and the Magic of Canon Layers“ vorgestellt wurden.

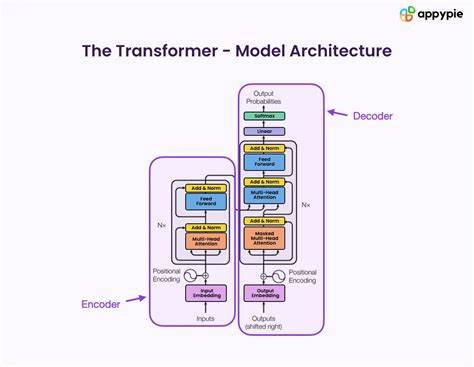

Die Innovationskraft der Canon Layers liegt in ihrer Fähigkeit, horizontale Informationsflüsse zwischen benachbarten Token-Repräsentationen zu fördern. Während herkömmliche Transformer-Architekturen primär auf selbstaufmerksame Mechanismen setzen, bei denen jedes Token im Kontext des gesamten Eingabesequenz bearbeitet wird, ermöglichen Canon Layers eine gezielte und gewichtete Summation benachbarter Tokeninformationen. Diese Eigenschaft erinnert metaphorisch an eine musikalische Kanontechnik, bei der melodische Elemente in einer strukturierten Abfolge wiederholt und variiert werden, was der Namensgebung dieser neuen Architekturkomponente zugrunde liegt. Ein großer Vorteil der Canon Layers besteht darin, dass sie flexibel in bestehende Sprachmodellarchitekturen integriert werden können. Ob Transformer, lineare Attention-Mechanismen oder sogar komplexere Zustandsraum-Modelle wie Mamba2, die Canon Layers fügen sich nahtlos ein und verbessern die Modellleistung.

Das macht sie zu einem universellen Werkzeug, das die Effizienz und Effektivität von Sprachmodellen erheblich steigern kann. Die Herausforderungen bei der Entwicklung und Evaluierung großer Sprachmodelle liegen zum einen in der enormen Rechenintensität akademischer Pretraining-Szenarien mit Milliarden von Parametern und zum anderen in der Schwierigkeit, Modelle zuverlässig zu vergleichen. Oftmals dominieren Zufälligkeiten und Datenrauschen die Evaluierungsergebnisse, wodurch valide Aussagen über die tatsächlichen Architekturverbesserungen erschwert werden. Hier setzen Allen-Zhu und sein Team an, indem sie kontrollierte synthetische Pretraining-Aufgaben entwerfen, die es erlauben, einzelne Kernfähigkeiten von Modellen isoliert und präzise zu testen. Diese synthetische Spielumgebung schafft die Möglichkeit, fundamentalste Leistungsaspekte von Sprachmodellen zu untersuchen, ohne von den Nebenwirkungen großer Datensets überlagert zu werden.

Innerhalb dieses Rahmens zeigen sich die Vorzüge der Canon Layers besonders deutlich. Das Modell steigt messbar in Bezug auf die Tiefe des Reasonings, also das Durchdringen komplexer kontextueller Zusammenhänge, um den Faktor zwei: Es ist also in der Lage, Aufgaben mit höherer Komplexität und mehrstufigen Anforderungen besser zu bewältigen. Auch die Breite des Reasonings wird verbessert, was bedeutet, dass das Modell eine größere Menge unterschiedlicher Konzepte effektiv miteinander verknüpfen kann. Interessant ist auch die Fähigkeit der Canon Layers, schwächere Architekturansätze aufzuwerten. Ein Beispiel ist hier der Vergleich zwischen NoPE und RoPE, beides Methoden zur Positionscodierung innerhalb von Transformern.

Während NoPE traditionell als weniger leistungsfähig betrachtet wird, schließen Modelle mit Canon Layers hier die Lücke zu RoPE, einem der stärkeren Verfahren. Gleichzeitig heben Canon Layers linear Attention-Modelle auf ein Leistungsniveau, das mit fortschrittlichen Zustandsraum-Modellen mithalten kann, was in der Praxis enorme Effizienzgewinne verspricht. Die Auswirkungen dieser Innovation reichen über synthetische Testaufgaben hinaus. In realen akademischen Pretraining-Szenarios, die Milliarden von Tokens und Parameter umfassen, konnten authentische Verbesserungen beobachtet werden. Das ist nicht selbstverständlich, da der Übergang von kontrollierten Experimenten zu groß angelegten Trainingsprozessen zahlreiche unerwartete Herausforderungen mit sich bringen kann.

Eine weitere spannende Perspektive, die die Arbeit von Allen-Zhu und seinem Team eröffnet, ist die potenzielle Vorhersagegenauigkeit bezüglich zukünftiger Architekturentwicklungen. Die Echtzeit-Analyse in einer „synthetischen Spielwiese“ mit unbegrenzten qualitativ hochwertigen Daten kann Trends und Wirkmechanismen frühzeitig sichtbar machen. So könnten zukünftige Modelle durch verbesserte Trainingspipelines, etwa via sorgfältigerer Datenkuratierung oder durch Techniken des Verstärkungslernens nach dem Training (RL-based post-training), von Anfang an besser auf tiefes, hierarchisches und komplexes Reasoning ausgerichtet werden. Die Erkenntnis, dass mikroskopische Architekturentscheidungen – wie die Integration von Canon Layers – makroskopisch einen signifikanten Einfluss auf die Fähigkeiten von Sprachmodellen haben, unterstreicht die Bedeutung gezielter Modellarchitektur-Forschung. Auch für Entwickler, die praktische Anwendungen konzipieren, bietet das Verständnis solcher Komponenten die Möglichkeit, Modelle effizienter und leistungsstärker zu gestalten.

Allgemein illustriert die Einführung der Canon Layers das Bestreben, die Architektur von Sprachmodellen aus einer physikalisch-inspirierten Perspektive zu betrachten. Statt lediglich incremental Anpassungen vorzunehmen, versuchen Forscher, neue Paradigmen zu entwickeln, die den Informationsfluss innerhalb der Modelle neu definieren und optimieren. Dadurch entsteht eine neue Dimension der Modellierungskomplexität, die letztlich mehr natürliche Sprachverständnisfähigkeiten abbilden kann. In der Welt der Künstlichen Intelligenz ist es immer wieder entscheidend, nicht nur auf zunehmende Modellgrößen oder Datenmengen zu setzen, sondern innovative Architekturen zu erforschen, die die eigentlichen Potenziale von maschinellem Lernen besser ausschöpfen. Canon Layers repräsentieren einen vielversprechenden Schritt in diese Richtung.

Die Suche nach der optimalen Balance zwischen Rechenaufwand, Modellkomplexität und Leistungsfähigkeit bleibt ein zentrales Thema. Techniken wie die von Allen-Zhu entwickelten synthetischen Pretraining-Aufgaben erlauben es Forschern, diese Balance fundiert zu erforschen. Sie bieten den Vorteil, Experimente mit geringerem Ressourcenverbrauch durchzuführen und trotzdem klare, aussagekräftige Messwerte über die Auswirkungen einzelner Architekturentscheidungen zu erhalten. Dies führt zu einem grundsätzlich effizienteren Entwicklungsprozess, der Innovationen schneller in die Praxis überführen kann. Gerade in einer Branche, in der jeder Fortschritt enorme Investitionen nach sich zieht, bieten solche Methodologien einen wichtigen Wettbewerbsvorteil.

Zusammenfassend lässt sich sagen, dass die Canon Layers nicht einfach nur eine weitere technische Verbesserung darstellen, sondern eine neue Denkrichtung in der Gestaltung von Sprachmodellen markieren. Sie helfen dabei, zentrale Schwächen bestehender Architekturen zu überwinden und eröffnen zugleich neue Möglichkeiten für Forschung und industrielle Anwendungen. Für Interessenten an der Zukunft von KI-Sprachmodellen ist es daher unerlässlich, die Konzepte hinter Canon Layers zu verstehen und deren Potenzial zur Veränderung heutiger Systeme nicht zu unterschätzen. Die Arbeit von Zeyuan Allen-Zhu öffnet eine Tür in eine vielversprechende Zukunft, in der Modelle noch intelligenter, flexibler und robuster sein können, um die vielfältigen Anforderungen moderner Sprachverarbeitung zu meistern.