Die moderne E-Commerce-Landschaft verlangt nach immer effizienteren und intelligenteren Empfehlungssystemen, um Kundenerwartungen zu erfüllen und die Conversion-Rate zu steigern. Klassische Systeme stoßen schnell an Grenzen, wenn es darum geht, Produktbeziehungen dynamisch und kontextabhängig zu erfassen. Hier bieten sich aktuell innovative Techniken mithilfe von Large Language Models (LLM) und Graphdatenbanken an, um ein Echtzeit-Produkt-Empfehlungssystem aufzubauen, welches weit über einfache Korrelationen hinausgeht und produktübergreifende Zusammenhänge erkennt. Ein Echtzeit-Empfehlungssystem hat den Vorteil, dass es Produktinformationen kontinuierlich verarbeitet, Kategorien intelligent einordnet und zugleich Komplementärprodukte identifiziert, die meist gemeinsam von Kunden gekauft werden. Damit verändert sich die Customer Journey grundlegend, da personalisierte und relevante Vorschläge zum richtigen Zeitpunkt gemacht werden.

Große Sprachmodelle wie GPT-4 ermöglichen dabei die semantische Analyse von Produktbeschreibungen und extrahieren automatisch präzise Produkt-Taxonomien und ergänzende Kategorien. Die Kombination mit einer Graphdatenbank bietet die ideale Basis, um die komplexen Beziehungen zwischen Produkten effektiv abzubilden und zu explorieren. Produkt-Taxonomie ist von zentraler Bedeutung für die Strukturierung umfangreicher Produktkataloge. Sie ermöglicht es, Produkte systematisch in hierarchischen Kategorien einzuordnen und diese Einordnung nicht nur statisch sondern mit Mehrfach-Kategorisierungen und mehreren Eltern-Kategorien flexibel abzubilden. Ein Produkt wie ein „Bleistift“ kann beispielsweise gleichzeitig zur Kategorie „Schreibwaren“ und „Schulbedarf“ gehören und so vielseitig referenziert werden.

LLMs helfen dabei, die relevanten Kategorien aus den Produktinformationen herauszufiltern und dabei auf eine klare, verständliche Sprache in US-Englisch zu achten, frei von unnötigem Fachjargon oder Markennamen. Die Ermittlung komplementärer Produkte ist ein weiterer wichtiger Aspekt in der Empfehlungspraxis. Hierbei analysiert das LLM, welche Produkte typischerweise ergänzend zu einem bestimmten Artikel gekauft werden. So kann es beim Kauf eines „Gelstifts“ etwa auf „Notizbücher“ als sinnvolle Ergänzung verweisen, was den Warenkorbwert erhöht und den Nutzern eine bessere Einkaufserfahrung bietet. Diese Zusammenhänge werden mithilfe der Graphdatenbank verknüpft, sodass sie bei der Abfrage der Empfehlungslogik zugrunde gelegt werden können.

Die Datenflussarchitektur dieses Systems ist schlank und effektiv mit rund 100 Zeilen Python-Code umsetzbar. Als Datenquelle werden Produktinformationen im JSON-Format eingelesen und mittels klassischer Datenbereinigung und Transformation für die Weiterverarbeitung vorbereitet. Die LLM-gestützte Extraktion erfolgt dann auf einer speziell formatierten Markdown-Darstellung, die die Produktdetails übersichtlich zeigt und so optimale Ergebnisse bei der semantischen Analyse liefert. Innerhalb des Workflows werden für jeden Artikel Produktknoten, Produkt-Taxonomie und komplementäre Taxonomie als separate Sammler definiert. Dies ermöglicht eine strukturierte Erfassung und Weiterleitung der Daten an die Graphdatenbank.

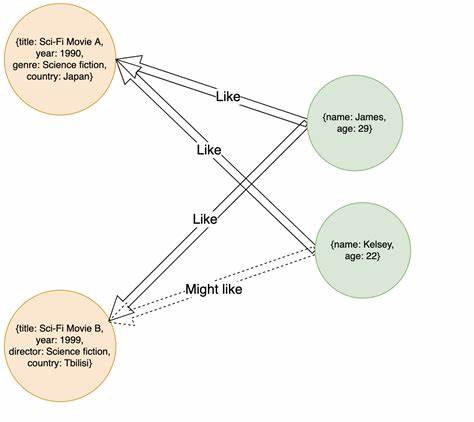

Die Wahl von Neo4j als Graphdatenbank erlaubt eine intuitive Repräsentation der Knoten (Produkte und Taxonomien) und deren Beziehungen. Die Knoten besitzen eindeutige Schlüssel, die eine Duplikatvermeidung gewährleisten und die Konsistenz der Datenbank aufrechterhalten. Der Export der Daten aus dem System in die Graphdatenbank erfolgt über spezifische Mapping-Funktionen, die definieren, wie Produkt- und Taxonomieknoten sowie deren Verbindungen belegt und modelliert werden. Aufbauend auf diesen Relationen lassen sich vielfältige Abfragen realisieren und komplexe Produktbeziehungen visualisieren. Eine Abfrage wie "MATCH p=()-->() RETURN p" in Neo4j gibt etwa alle Verbindungen aus und hilft bei der Exploration des vollständigen Produktgraphen.

Die Implementierung erfordert neben der Installation von PostgreSQL für die inkrementelle Verarbeitung auch Neo4j für das Speichern und Abfragen des Produktgraphen. Die Integration von OpenAI-APIs ermöglicht den Zugriff auf aktuelle LLMs. Alternativ bieten lokale LLM-Lösungen wie Ollama eine datenschutzfreundlichere Verarbeitung auf eigenen Servern. Der eigentliche Code definiert den Datenfluss konsequent: vom Laden der JSON-Dateien, über das Parsen und Transformieren der Produktdaten, bis zur LLM-gestützten Klassifikation und dem schlussendlichen Export in die Datenbank. Die Benutzung von CocoIndex als Datenindexierungsplattform vereinfacht dabei viele der komplexen Schritte und erlaubt die automatische Schemaerkennung sowie die kontinuierliche Aktualisierung bei neuen Produkten oder Änderungen im Katalog.

Die Qualität der Empfehlungen profitiert stark von der semantischen Tiefe des LLM und der präzisen Modellierung in Neo4j. Das System kann nicht nur einfache Kategorien erkennen, sondern auch Beziehungen zwischen scheinbar unabhängigen Produkten herstellen, die für den Kunden einen echten Mehrwert bieten. Für Betreiber von E-Commerce-Plattformen ergibt sich damit eine bedeutende Chance, sich durch innovative Technologien deutlicher vom Wettbewerb abzuheben und Kunden personalisierte Erlebnisse zu bieten, die Umsatz und Kundenzufriedenheit nachhaltig steigern. Gleichzeitig bietet die Kombination aus LLM und Graphdatenbank auch erhebliche Vorteile bei der Wartbarkeit und Skalierbarkeit des Recommendation Systems. Für Entwickler, die sich näher mit der Implementierung beschäftigen möchten, stellt das gesamte Beispielprojekt inklusive Quellcode eine exzellente Blaupause dar, die einfach auf eigene Anwendungsfälle angepasst werden kann.

Die Möglichkeit, das System in Echtzeit zu aktualisieren und mit neuen Produkten zu bestücken, erlaubt eine flexible und dynamische Nutzung, die mit der sich stetig wandelnden Produktwelt mithält. Neben den technischen Vorteilen überzeugt das System auch hinsichtlich der Nutzerfreundlichkeit. Durch die Visualisierungsmöglichkeiten in der Neo4j Browseroberfläche können beispielsweise Produktmanager und Analysten direkt relevante Produktcluster und Produktzusammenhänge erkennen und so datengetriebene Entscheidungen treffen. Abschließend ist der Trend zur Verbindung von künstlicher Intelligenz und graphbasierten Datenstrukturen als Meilenstein im Bereich der Empfehlungssysteme zu sehen. So entsteht eine neue Klasse von Applikationen, die dynamisch, erklärbar und hoch performant sind.

Ein Echtzeit-Produkt-Empfehlungssystem mit LLM und Graphdatenbank ist damit eine wegweisende Lösung für die Herausforderungen des digitalen Handels der Gegenwart und Zukunft.