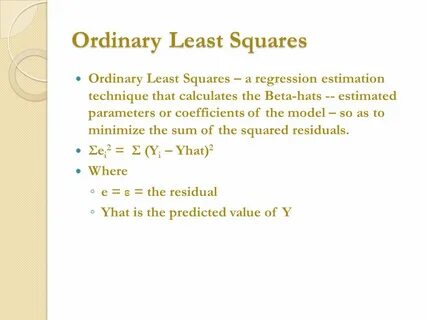

Die Methode der kleinsten Quadrate, im Englischen als Ordinary Least Squares (OLS) bekannt, ist ein zentrales Werkzeug in der Statistik und Datenanalyse. Sie dient dazu, den besten linearen Zusammenhang zwischen unabhängigen Variablen und einer abhängigen Variable zu bestimmen. Dabei wird eine lineare Regressionslinie so angepasst, dass die Summe der quadrierten Abweichungen zwischen den beobachteten Datenpunkten und den geschätzten Werten minimiert wird. Das Ziel ist es, ein Modell zu erschaffen, das die zugrundeliegenden Zusammenhänge möglichst genau widerspiegelt und gleichzeitig Vorhersagen für neue Daten ermöglicht. Der Ursprung dieser Methode liegt in den mathematischen Fundamenten der linearen Algebra und Statistik, wobei die Herleitung der OLS-Schätzung aus den Prinzipien der Fehlerquadratsumme resultiert.

Die Grundidee ist, eine Kostenfunktion zu definieren, in diesem Fall die Summe der quadrierten Residuen, und diese Funktion zu minimieren, um optimale Parameter für die lineare Funktion zu bestimmen. Das Verständnis von Ordinary Least Squares beginnt mit der Annahme eines einfachen linearen Modells, das als y = β0 + β1x + ε geschrieben werden kann. Hierbei steht y für die abhängige Variable, x für die unabhängige Variable, β0 für den Schnittpunkt der Regressionslinie mit der y-Achse, β1 für die Steigung der Linie und ε für den Fehlerterm, der Abweichungen zwischen beobachteten und vorhergesagten Werten beschreibt. Daraus ergibt sich der Ansatz, die Parameter β0 und β1 so zu bestimmen, dass die Summe der quadrierten Differenzen zwischen den tatsächlichen y-Werten und den durch das Modell geschätzten Werten minimal ist. Die Fehlerquadratsumme wird dabei als Maß für die Güte des Fits verwendet.

Die Herleitung der optimalen Schätzwerte erfolgt meist durch partielle Ableitungen der Fehlerquadratsumme nach den Parametern β0 und β1, welche auf Null gesetzt werden um die minimale Fehlerfunktion zu finden. Durch diese Vorgehensweise entstehen sogenannte Normalengleichungen, die sich bei einfachen linearen Modellen leicht lösen lassen und bei mehrdimensionalen Variablen mittels Matrizenoperationen effizient berechnet werden können. Die Linearisierung erleichtert die Berechnung optimaler Koeffizienten erheblich und ermöglicht eine klare Interpretation der Beziehungen im Modell. Das Verfahren ist nicht nur auf einfache lineare Zusammenhänge beschränkt, sondern lässt sich auch auf multiple lineare Regressionen mit mehreren erklärenden Variablen erweitern. Ein weiterer wichtiger Aspekt von Ordinary Least Squares ist die statistische Interpretation der Parameterschätzungen.

Unter bestimmten Annahmen, wie der Normalverteilung der Fehlerterme, ist es möglich, Konfidenzintervalle und Hypothesentests für die Regressionskoeffizienten abzuleiten. Dadurch können Aussagen über die statistische Signifikanz der einzelnen Einflussgrößen getroffen werden. Zudem führt OLS dazu, dass die Schätzungen unverzerrt, konsistent und effizient sind, wenn die Annahmen erfüllt werden. Dies macht OLS zu einem der wichtigsten Verfahren in der Regressionsanalyse und Modellierung. In der Praxis findet die Methode der kleinsten Quadrate breite Anwendung in verschiedensten Disziplinen, von der Ökonometrie über die Biologie bis hin zur Ingenieurwissenschaft.

In der Wirtschaftswissenschaft beispielsweise wird OLS verwendet, um den Einfluss von Werbeausgaben auf Umsätze zu analysieren oder um Preiselastizitäten zu berechnen. Auch in der Medizin unterstützt sie die Analyse von kausalen Zusammenhängen zwischen Behandlungsvariablen und Patientenergebnissen. Die relative Einfachheit der Umsetzung und die interpretierbaren Ergebnisse machen sie zu einem bevorzugten Verfahren bei quantitativer Datenanalyse. Trotz ihrer Vorteile hat die Methode der kleinsten Quadrate auch Einschränkungen. Wenn die Annahmen, wie beispielsweise die Homoskedastizität der Fehler oder deren Unabhängigkeit, verletzt werden, kann es zu verzerrten Schätzungen kommen.

Aus diesem Grund sind Diagnosetests und Residuenanalysen wichtige Bestandteile der OLS-Anwendung. Zudem sind OLS-Schätzungen anfällig gegenüber Ausreißern, die das Modell stark beeinflussen können. In solchen Fällen bieten robustere Regressionsverfahren oder regularisierte Modelle eine Alternative, um stabilere Schätzungen zu erzeugen. Die Erweiterung der Methode über die einfache lineare Regression hinaus führt zu zahlreichen komplexeren Modellen und Techniken. So lassen sich auch nichtlineare Zusammenhänge mithilfe linearer Modelle durch Transformationen der Variablen darstellen.

Weiterhin sind generalisierte lineare Modelle und Methoden der maschinellen Lernens in der modernen Statistik häufig auf der Grundlage von OLS aufgebaut oder davon inspiriert. Die Kombination aus theoretischer Fundierung und praktischer Anwendbarkeit macht Ordinary Least Squares zu einem unverzichtbaren Konzept in der Datenanalyse. Die Implementierung von OLS ist heute in vielen Softwarepaketen und Programmiersprachen wie R, Python, MATLAB und SPSS problemlos möglich. Die einfache Kodierung von OLS-Algorithmen ermöglicht es Datenwissenschaftlern und Forschern, schnell Analysemodelle zu erstellen und zu validieren. Gleichzeitig bietet die Offenlegung der mathematischen Grundlagen einen tiefen Einblick in das Verhalten der Modelle, was die Interpretierbarkeit und Vertrauenswürdigkeit der Ergebnisse erhöht.

Somit verbindet Ordinary Least Squares Theorie und Praxis auf einzigartige Weise. Zusammenfassend ist die Methode der kleinsten Quadrate eine fundamentale Technik der linearen Regression, die auf mathematischen Prinzipien basiert und sowohl Theorie als auch Praxis maßgeblich beeinflusst hat. Sie ermöglicht eine klare und effiziente Schätzung von Zusammenhängen zwischen Variablen und bildet die Basis vieler moderner statistischer Verfahren. Ein tiefgehendes Verständnis ihrer Grundlagen, Annahmen und Limitationen ist entscheidend für den erfolgreichen Einsatz und die kritische Interpretation der Ergebnisse in diversen Anwendungsgebieten.