Die chemische Wissenschaft erlebt seit einigen Jahren eine grundlegende Transformation durch den Einsatz künstlicher Intelligenz (KI). Besonders große Sprachmodelle, sogenannte Large Language Models (LLMs), haben sich als potenzielle Werkzeuge herauskristallisiert, die nicht nur einfache Informationsanfragen beantworten können, sondern auch komplexe chemische Fragestellungen bearbeiten. Die jüngsten Studien, darunter insbesondere eine umfassende Analyse von Mirza et al. im Jahr 2025, werfen ein neues Licht darauf, inwieweit diese KI-Systeme mit der Expertise von menschlichen Chemikern mithalten oder sie sogar übertreffen können. Im Zentrum der Diskussion steht die Frage, wie gut Large Language Models chemisches Wissen verstehen und anwenden können.

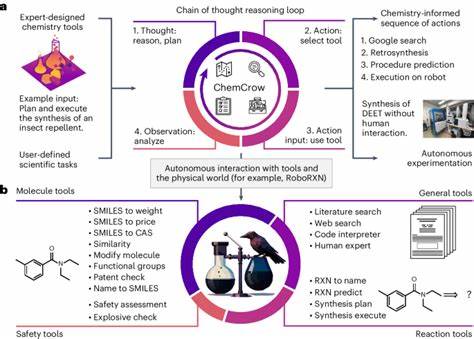

Chemie als Wissenschaft zeichnet sich durch ein breites Spektrum spezieller Inhalte aus – von allgemeinen Konzepten bis hin zu hochgradig spezialisierten Bereichen wie organischer Synthese, anorganischer Chemie, analytischer Chemie oder Toxikologie. Ein fundiertes Verständnis der Zusammenhänge erfordert nicht nur das Auswendiglernen von Fakten, sondern auch die Fähigkeit zu komplexem logischen Denken und intuitivem Schlussfolgern. Die Schlüsselkompetenzen umfassen somit reines Faktenwissen, multiphasische Problemlösung, mathematische Berechnungen und chemische Intuition. Bei der Bewertung der Leistungsfähigkeit von LLMs im chemischen Kontext haben Wissenschaftler das Framework ChemBench entwickelt, ein umfangreiches Benchmarking-System, das speziell dazu dient, verschiedene Facetten chemischen Fachwissens zu prüfen. Dieses System enthält über 2700 sorgfältig kuratierte Frage-Antwort-Paare, die sowohl Multiple-Choice- als auch offene Fragestellungen umfassen.

Dabei werden die Fragen nicht nur nach Inhalt, sondern auch nach den geforderten Fähigkeiten (Wissen, Rechnen, logische Argumentation, intuitive Einschätzungen) und dem Schwierigkeitsgrad klassifiziert. Die Ergebnisse bei der Anwendung von ChemBench auf verschiedene führende Sprachmodelle überraschen und faszinieren zugleich. Einige der besten LLMs können im Durchschnitt sogar bessere Resultate erzielen als erfahrene Chemiker, die an der Studie teilnahmen. Dies ist besonders bemerkenswert, wenn man bedenkt, dass die menschlichen Experten in einigen Fällen Zugriff auf Recherchetools wie Web-Suchmaschinen oder chemische Zeichensoftware hatten, während die Modelle weitgehend nur auf ihr trainiertes Wissen sowie die mitgelieferten Eingabedaten zurückgreifen konnten. Doch hinter diesen Erfolgen verbirgt sich auch eine differenzierte Realität.

Während Large Language Models in Bereichen glänzen, die auf Abruf und Kombination von bestehendem Wissen beruhen, zeigen sich deutliche Schwächen bei Aufgaben, die tiefere chemische Intuition und detaillierte Strukturanalysen erfordern. Besonders komplexe Themen wie die Anzahl unterscheidbarer Signale in der Kernspinresonanz (NMR) oder die korrekte Einschätzung chemischer Sicherheitsrisiken stellten große Herausforderungen dar. Dort schnitten menschliche Chemiker oft besser ab, vor allem wenn sie visuelle Hilfsmittel zur Verfügung hatten, die den Computermodellen in dieser Form derzeit fehlen. Ein wesentlicher Kritikpunkt an den Systemen ist auch ihre übermäßige Selbstsicherheit. Viele Modelle neigen dazu, Antworten mit hoher Zuversicht zu liefern, selbst wenn diese falsch sind.

Diese Fehlkalibrierung ihrer eigenen Unsicherheit ist eine wichtige Hürde für den praktischen Einsatz, bei dem Vertrauen und Verlässlichkeit entscheidend sind. Ohne kritisches Hinterfragen durch den Nutzer können fehlerhafte Informationen potenzielle Sicherheitsrisiken bergen, besonders in Fragen der chemischen Toxizität oder Gefahrenbeurteilung. Die Komplexität der chemischen Informationswelt spielt eine weitere Rolle. Ein Großteil des chemischen Wissens ist nicht in maschinenlesbaren Datenbanken gespeichert, sondern befindet sich in der Form von Text in wissenschaftlichen Artikeln, Lehrbüchern und sonstigen Publikationen. Diese Textquellen sind das Haupttrainingsmaterial für LLMs und bieten einen reichen Fundus, der allerdings mit nuancierten Interpretationen, Kontextualisierungen und abstrakten wissenschaftlichen Zusammenhängen verbunden ist.

Genau hier liegen die Stärken dieser Modelle, aber auch ihre Grenzen: Sie sind beeindruckende Textverarbeitungswerkzeuge, deren wahre „Verständnisfähigkeit“ jedoch oft in Frage gestellt wird. Gleichzeitig eröffnen die Fortschritte auch neue Perspektiven für die Zusammenarbeit zwischen Menschen und Maschinen. Während LLMs den Chemikern zeitintensive Routineaufgaben abnehmen können, etwa bei der Suche nach Literaturinformationen oder der Vorhersage physikochemischer Eigenschaften, bleiben kritische Analyse und kreative Problemlösung nach wie vor Domänen der menschlichen Expertise. Dadurch können sogenannte Copilot-Systeme entstehen, die Forscher mit gezielten Vorschlägen und schnellen Antworten unterstützen, ohne den Menschen zu ersetzen. Für die chemische Ausbildung ergibt sich aus diesen Entwicklungen ein Handlungsbedarf.

Die traditionelle Lehre, die häufig großes Gewicht auf Faktenwissen und standardisierte Prüfungsmethoden legt, erscheint im Vergleich zu den Fähigkeiten von KI-Systemen an manchen Stellen weniger sinnvoll. Stattdessen sollte stärker auf konzeptionelles Denken, kritische Bewertung von Informationen und Problemlösestrategien gesetzt werden. So können zukünftige Chemiker besser mit KI-Werkzeugen harmonieren und die Potenziale dieser Technologie voll ausschöpfen. Neben der fachlichen Dimension werfen die Ergebnisse auch ethische und sicherheitstechnische Fragen auf. Der Zugang zu mächtigen KI-Tools ist breit gefächert, und Nutzer mit unterschiedlichem Hintergrund können potenziell sensible oder gefährliche chemische Informationen generieren.

Die Gefahr von Missbrauch, etwa im Kontext der Chemiewaffenentwicklung, erfordert verantwortungsvolles Design und klare Regulierungen. Die Entwickler von LLMs arbeiten daher an Filtern, Sicherungsmaßnahmen und transparenten Technologien, um Risiken zu minimieren. Die Zukunft der KI in der Chemie hängt maßgeblich von der fortlaufenden Weiterentwicklung sowohl der Modelle als auch der Evaluationssysteme ab. Werkzeuge wie ChemBench tragen dazu bei, Fortschritte objektiv zu messen und Schwachstellen zu identifizieren. Zudem wird die Integration spezieller Wissensdatenbanken und multimodaler Eingaben – wie chemischer Strukturen oder experimenteller Daten – als nächster Schritt gesehen, um die Modelle in ihrer Leistungsfähigkeit weiter zu stärken.

Abschließend lässt sich sagen, dass durch die rasante Entwicklung großer Sprachmodelle eine spannende Zeit für die chemische Wissenschaft beginnt. Die Technologie fordert nicht nur die Rolle des menschlichen Experten heraus, sondern eröffnet auch neue Wege für Forschung, Lehre und den praktischen Laboralltag. Die Kombination aus menschlicher Erfahrung und maschineller Intelligenz verspricht ein synergetisches Zusammenspiel, das die Effizienz und Kreativität in der Chemie erheblich steigern kann, wenn man die Grenzen und Risiken bewusst berücksichtigt und verantwortungsvoll damit umgeht.