Künstliche Intelligenz hat in den letzten Jahren einen bemerkenswerten Wandel durchlaufen. Insbesondere KI-Agenten – autonome Programme, die Aufgaben in unterschiedlichsten Bereichen übernehmen können – erleben derzeit eine rasante Weiterentwicklung und Anwendung, vor allem in der Softwareentwicklung. Doch trotz ihres Potenzials, komplexe Prozesse zu automatisieren und den Arbeitsalltag von Entwicklern zu erleichtern, stellt der Umgang mit diesen Agenten eine große Herausforderung dar. Viele Nutzer empfinden die Kontrolle und Steuerung von KI-gestützten Agenten fast wie eine unmögliche Mission. Wie gelingt es also, KI-Agenten im realen Umfeld effektiv zu managen? Es braucht mehr als nur Technologie – es erfordert Planung, ein tiefes Verständnis der eingesetzten Werkzeuge und vor allem eine sorgfältige Steuerung ihrer Fähigkeiten und Kosten.

Das Fundament jeder erfolgreichen Interaktion mit KI-Agenten ist die bewusste Auswahl der Werkzeuge und die Unterscheidung zwischen Tools, Materialien und Technik. Während Tools wie Cursor AI, Copilot oder Google Gemini ähnlich arbeiten, liegt der Unterschied im Input – also der Qualität und Struktur der bereitgestellten Daten, Codefragmente, Diagramme und Prompts – sowie in der Methode, wie diese Materialien dem Agenten präsentiert werden. Gerade die Eingaben bestimmen maßgeblich die Qualität der Outputs. Ein tieferes Verständnis des jeweiligen AI-Tools sowie das Verfolgen von Updates und Dokumentationen sind entscheidend, um die Möglichkeiten des Agenten voll auszuschöpfen und Überraschungen im Arbeitsprozess zu minimieren. Der Nutzer selbst ist außerdem ein wesentlicher Faktor.

Wer glaubt, dass auch Nicht-Entwickler mit KI-Agenten sofort hochwertige Ergebnisse erzielen können, irrt grundlegend. Die Steuerung von KI-Agenten erfordert nicht nur Fachwissen im Programmieren, sondern auch die Fähigkeit, architektonische Zusammenhänge zu erkennen und diese verständlich in klaren Anweisungen niederzulegen. Schlechter Input führt unvermeidlich zu minderwertigen Ergebnissen. Der Umgang mit KI-Tools verlangt also eine selbstkritische Beurteilung des eigenen Könnens und eine bewusste Abwägung, wann der menschliche Eingriff gefragt ist und wann der Agent autonom handeln darf. Eine der größten Fallen bei der Arbeit mit KI-Agenten ist das sogenannte "Vibe Coding" – die Vorstellung, man könne spontan und ohne Planung mit einem Agenten kommunizieren und sofort perfekte Lösungen erhalten.

Die Realität zeigt: Während KI-Modelle mittlerweile in der Lage sind, fast jede erdenkliche Aufgabe zu bearbeiten, sind sie ohne strukturierte Planung kaum in der Lage, sauberen, stabilen und wiederverwendbaren Code zu liefern. Vibe Coding mag gute Protoypen erzeugen, aber um dauerhafte, produktionsreife Ergebnisse zu erzielen, ist ein modularer und gut durchdachter Plan unerlässlich. Ein solcher Plan schafft zudem die Grundlage für iterative Verbesserungen und erleichtert das spätere Refactoring oder die Erweiterung der Software erheblich. Die Erarbeitung einer solchen Route vom Ziel bis zur Umsetzung ist häufig mühsam und wird von Entwicklern oft als überflüssig empfunden. Doch gerade in diesem Schritt zeigt sich die Effektivität von KI-Agenten: Sie unterstützen den Entwickler dabei, komplexe Aufgaben in überschaubare Teilaufgaben zu zerlegen und so Schritt für Schritt dem Ziel näherzukommen.

Dabei gilt es, realistisch mit den Fähigkeiten des Agenten umzugehen. Einfache Anweisungen, die für Menschen selbstverständlich sind, können für einen KI-Agenten problematisch sein. Hier ist es notwendig, die eigene Fragestellung präzise zu formulieren und die relevanten Codeteile und Ressourcen zugänglich zu machen. So wird der Agent zu einem echten Partner, der auf fundierten Informationen aufbaut, anstatt auf bloßen Vermutungen. Eine nachhaltige Programmierarbeit mit KI-Agenten setzt eine konsequente Planungsphase voraus.

Pläne sind nicht einfach nur Dokumentationen, sondern fungieren als ausführbare Anweisungen, die in der Software-Repository gespeichert und von Agenten interpretiert werden können. Eine Praxis, die sich zunehmend durchsetzt, besteht darin, alle komplexen Vorgänge in formatierten Markdown-Dateien abzulegen, die sowohl lesbar als auch maschinenverarbeitbar sind. Diese Pläne enthalten neben erklärendem Text auch Beispielcodes und werden stetig gepflegt und über Versionskontrolle aktualisiert. So ist jederzeit nachvollziehbar, welche Schritte unternommen wurden, was bereits getestet wurde und welche Anpassungen erfolgt sind. Allerdings ist gerade am Anfang mit Fehlern und Unstimmigkeiten in den Plänen zu rechnen.

Kein Plan ist direkt perfekt, sondern muss durch Revisionen verfeinert werden. Entwickler sollten sich daran gewöhnen, Pläne als dynamische Schriftstücke zu betrachten, die wachsen, sich verändern und gelegentlich sogar restrukturiert werden müssen. Ein transparenter Umgang mit diesen Unvollkommenheiten fördert letztlich ein besseres Verständnis und einen effizienteren Arbeitsfluss. Die Prüfung und das Testen der erstellten Pläne mit realem Code und in der realen Umgebung gehören zu den wichtigsten Aufgaben bei der Arbeit mit KI-Agenten. Statt sich blind auf die KI zu verlassen, sollten Entwickler alle Ergebnisse selbst überprüfen und bei Bedarf Refactorings vornehmen.

Gerade die Fähigkeit von KI, schnell umfassende Änderungen vorzuschlagen, eignet sich hervorragend, um technische Schulden abzubauen und den Code auf lange Sicht wartbar zu machen. Doch auch hier gilt: Der Agent ist nur so gut wie die Architektur und die Vorgaben, die der Mensch ihm bietet. Eine schlechte Codebasis führt zwangsläufig zu problematischen Ergebnissen – auch wenn der Agent versucht, das Beste daraus zu machen. Eine der zentralen Erkenntnisse im Umgang mit KI-Agenten ist die Verantwortung des Menschen für die Qualität des Codes. Fehler, schlechte Architekturen oder ineffiziente Strukturen sind nicht die Schuld der KI, sondern spiegeln die Kompromisse und Herausforderungen der Softwareentwicklung wider.

Künstliche Intelligenz deckt Schwächen schneller und umfassender auf als herkömmliche Methoden und zwingt Entwickler so, sich mit bekannten Problemen auseinanderzusetzen, anstatt sie zu ignorieren. Dieser Prozess mag unangenehm sein, bietet jedoch die Chance, die Codequalität und die gesamte Entwicklungsumgebung signifikant zu verbessern. Der Einsatz von Regeln und Richtlinien spielt eine wichtige Rolle bei der Steuerung von KI-Agenten. Unterschiedliche Regeltypen erlauben es, den Kontext und die Einschränkungen für verschiedene Aufgaben fein granuliert zu steuern – sei es durch immer angehängte Regelwerke, die für das gesamte Projekt gelten, oder durch kontextbasierte Regeln, die nur in bestimmten Situationen aktiv werden. Die Erstellung solcher Regeln erfordert eine präzise und positive Formulierung, um Missverständnisse zu vermeiden und die Zuverlässigkeit des Agenten zu erhöhen.

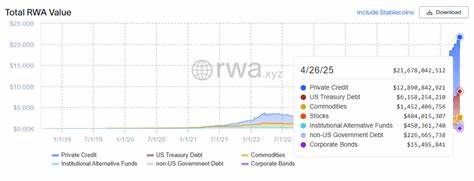

Moderne Tools erlauben es sogar, dass KI-Agenten diese Regelwerke selbst aktualisieren, wodurch ein lernender, kontextsensitiver Prozess entsteht. Kostenkontrolle bleibt ein zentrales Thema im Umgang mit KI-Agenten. Die Nutzung von KI ist nicht kostenlos, und flexible Preisgestaltung sowie unterschiedliche Modelle mit verschiedenen Leistungs- und Preisklassen erfordern ein umsichtiges Management. Entwickler sollten monatliche Nutzungslimits setzen, nur die wirklich notwendigen Modelle aktivieren und Preisangebote vergleichen, um die Effizienz ihrer Investitionen zu maximieren. Der Versuch, mit kostenlosen oder ineffizienten Modellen zu arbeiten, führt oft zu Frustration und enttäuschenden Ergebnissen.

Dabei ändert sich das Angebot an Modellen und deren Preise ständig, sodass ein kontinuierliches Monitoring ratsam ist. Verschiedene Modelle eignen sich für unterschiedliche Aufgaben. Action-Modelle sind beispielsweise sparsamer und besser geeignet für sofortige, einfache Anweisungen, während Planung- und Deep-Thinking-Modelle mehr Ressourcen verbrauchen, dafür aber komplexe Überlegungen und Detailanalysen ermöglichen. Ein intelligenter Wechsel zwischen diesen Modellen im Verlauf eines Projekts sorgt für Effizienz und Qualität gleichermaßen. Technologische Standards wie das sogenannte Model Context Protocol (MCP) spielen eine immer größere Rolle bei der Integration und Kommunikation zwischen verschiedenen KI-Agenten und Tools.

MCP beschreibt formale Schemata zur Übergabe von Prompts und Werkzeugaufrufen zwischen Systemen und basiert auf etablierten Datenformaten wie JSON und Markdown. Obwohl MCP selbst keine magische Lösung darstellt, fördert es die Interoperabilität und Modularisierung, muss aber mit Bedacht eingesetzt werden, um Überkomplexität und Fehleinschätzungen zu vermeiden. Am Ende des Tages bleibt der menschliche Entwickler der wichtigste Faktor im Management von KI-Agenten. Nur wer sich selbst als Architekt, Kritiker und Kommunikator versteht, kann die Werkzeuge mit ihrem immensen Potenzial bestmöglich nutzen. Dies erfordert Mut zu Fehlern, die Bereitschaft, immer wieder Pläne zu überarbeiten, und ein konsequentes Prüfen der Resultate.

Die Zusammenarbeit zwischen Mensch und KI wird so zu einer partnerschaftlichen Mission, die zwar herausfordernd, aber auch höchst lohnend ist. Die Zukunft der KI-Agenten im Softwareentwicklungsprozess verspricht eine Verschmelzung aus Automatisierung und menschlicher Expertise, bei der beide Seiten ihre Stärken perfekt ausspielen. Wer sich heute das nötige Wissen aneignet, Systeme sorgfältig plant und die Agenten aufmerksam steuert, wird morgen in der Lage sein, Projekte effizienter, stabiler und kreativer umzusetzen. In einer Welt, in der KI-Agenten zunehmend Teil der täglichen Arbeit werden, ist der Weg vom "Mission Impossible" zum erreichbaren Ziel somit vorgezeichnet.