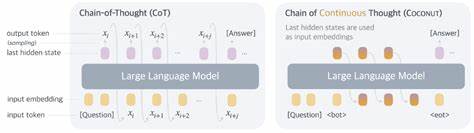

Die Entwicklung Künstlicher Intelligenz (KI) hat in den letzten Jahren enorme Fortschritte gemacht, insbesondere durch den Einsatz großer Sprachmodelle (Large Language Models, LLMs), die zunehmend komplexe Aufgaben bewältigen können. Ein zentrales Thema innerhalb dieser Fortschritte ist das Konzept des Chain of Thought, das es Modellen ermöglicht, einen gedanklichen Prozess Schritt für Schritt abzubilden, um bessere Ergebnisse bei anspruchsvollen Problemlösungen zu erzielen. Jüngst gewinnt eine neue Variante dieser Denkweise an Bedeutung: das Chain of Continuous Thought, ergänzt durch das Prinzip des Reasoning by Superposition. Traditionell operieren LLMs mit diskreten Tokens, also einzelnen, klar vordefinierten Einheiten, um Gedankenketten zu generieren. Diese Methode ist zwar effektiv, stößt jedoch bei Skalierung und komplexen logischen Aufgaben an Grenzen.

Reasoning by Superposition rückt deshalb einen innovativen Mechanismus in den Mittelpunkt: Statt einzelner diskreter Gedanken werden kontinuierliche Gedankenvektoren erzeugt, die – vergleichbar mit Quantenzuständen – als Überlagerung verschiedener Suchpfade gleichermaßen repräsentiert werden. Die theoretische Grundlage dieses Prinzips stammt aus einer Studie von Hanlin Zhu, Shibo Hao, Zhiting Hu, Jiantao Jiao, Stuart Russell und Yuandong Tian, in der gezeigt wird, wie ein einfacher zweischichtiger Transformer mit Hilfe von D Schritten kontinuierlicher Gedankenketten (Chain of Continuous Thought) in der Lage ist, das Problem der gerichteten Graph-Reichweite effizient zu lösen. Dieses Problem, das die Frage beantwortet, ob ein Pfad zwischen zwei Knoten in einem gerichteten Graphen existiert, ist ein klassisches Modell für viele praktische Aufgaben und gilt als eine Herausforderung in algorithmischer und graphentheoretischer Forschung. Der Clou liegt darin, dass die kontinuierlichen Gedankenvektoren in der Lage sind, parallel mehrere Suchfronten gleichzeitig zu kodieren. Das bedeutet, dass anstelle eines sequentiellen Abtastens einzelner Pfade – wie bei diskreten Token-basierten Chain of Thought – eine parallele Suche abgebildet wird, vergleichbar mit einer breit angelegten Breitensuche (Breadth-First Search, BFS).

Während diskrete Token zwangsläufig einen Pfad herauspicken müssen, um diesen weiter zu verfolgen, erfassen die kontinuierlichen Vektoren ein Superpositionsprinzip, das mehrere Pfade gleichzeitig mit einbezieht. Diese Eigenschaft führte zu überraschenden Erkenntnissen: Die Anzahl der notwendigen Schritte zur Problemlösung reduziert sich von bisher bekannten O(n²)-Dekodierschritten in diskreten Transformern auf D Schritte, die der Graph-Durchmesser widerspiegeln. Das bedeutet nicht nur eine erhebliche Effizienzsteigerung, sondern auch ein robustes Verfahren, das weniger anfällig ist, in lokalen Tälern oder unproduktiven Suchpfaden hängen zu bleiben. Die theoretischen Ergebnisse wurden durch umfangreiche Experimente bestätigt, die zeigten, dass Models beim Training tendenziell genau diese Superpositionszustände der kontinuierlichen Gedanken automatisch erlernen – und zwar ohne explizite Vorgaben oder Überwachung. Dies zeigt, dass künstliche neuronale Netze auf natürliche Weise diese effizienten Suchverfahren adaptieren, sofern das Modell durch kontinuierliche Token-Darstellung die entsprechenden Voraussetzungen bekommt.

Die Implikationen dieser Erkenntnisse sind vielfältig und haben das Potenzial, aktuelle Denkprozesse in KI-Modellen grundlegend zu verändern. Durch die Nutzung von Reasoning by Superposition können komplexe Problemlösungen in Bereichen wie Graphanalyse, Planung und Entscheidungsfindung deutlich schneller und präziser vorgenommen werden. Ein weiterer Vorteil besteht in der Skalierbarkeit: Da kontinuierliche Gedankenvektoren mehrere mögliche Lösungswege parallel repräsentieren können, ist das Modell weniger anfällig für Fehler durch ungünstige Pfadauswahl. Somit überwindet es die Einschränkung sequenzieller Denkprozesse und öffnet Türen zu flexibleren und adaptiveren Denkstrategien in der KI. Darüber hinaus trägt diese Methodik dazu bei, das Verständnis zu vertiefen, wie maschinelles Denken näher an menschlich-logisches Denken herangeführt werden kann.

Menschen tendieren dazu, in komplexen Situationen mehrere Alternativen parallel abzuwägen und erst im weiteren Verlauf eine konkrete Entscheidung zu treffen. Die kontinuierlichen CoTs bilden eine ähnliche Fähigkeit künstlich ab, wodurch die nächste Generation von LLMs an Effizienz und „Intelligenz“ gewinnt. Ein wichtiger Aspekt ist auch die Architektur der verwendeten Transformermodelle. Die Studie zeigt, dass bereits zweischichtige Transformer mit der richtigen Gestaltung von kontinuierlichen Gedankenvektoren ausreichend komplex sind, um signifikante Leistungssteigerungen zu erzielen. Dies steht im Gegensatz zu tiefen Netzwerken, die oft für komplexe Planungsschritte als notwendig erachtet werden, und macht den Ansatz sowohl theoretisch elegant als auch praktisch umsetzbar.

Die Verbindung von theoretischer Fundierung und empirischer Bestätigung in diesem Forschungsfeld liefert somit eine zuverlässige Grundlage für weitere Entwicklungen. Unternehmen, die im Bereich Künstliche Intelligenz innovative Lösungen entwickeln, können von dieser Methodik profitieren, um Anwendungen zu fördern, die auf komplexe Entscheidungsfindung angewiesen sind. Dies kann vom autonomen Fahren über die medizinische Diagnostik bis hin zur Optimierung logistischer Systeme reichen. Weiterhin regen die Erkenntnisse um Reasoning by Superposition auch Debatten über die zukünftige Integration quantenähnlicher Prinzipien in KI an. Die Überlagerung von Zuständen, ein Konzept aus der Quantenmechanik, findet in diesem Kontext eine analoge Umsetzung, die zwar nicht physikalischer Natur, aber auf Informationsebene bahnbrechend wirkt.