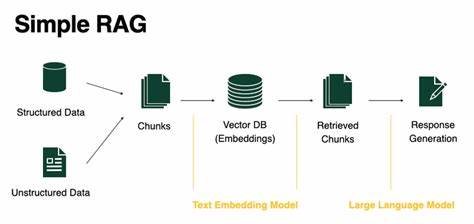

Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat die Art und Weise, wie wir mit Computern interagieren und Wissen verarbeiten, grundlegend verändert. Durch die Integration externer Wissensquellen mittels Retrieval-Augmented Generation (RAG) wird eine deutlich verbesserte Textgenerierung möglich, die nicht nur auf den im Modell gespeicherten Informationen basiert, sondern auch aktuellen und relevanten Kontext aus großen Datenbanken einbindet. Diese Kombination eröffnet zahlreiche Anwendungsfelder, von Chatbots über wissenschaftliche Recherche bis hin zu personalisierten Assistenzsystemen. Dennoch ist die praktische Implementierung von RAG-Systemen besonders auf Consumer-Geräten mit begrenztem Arbeitsspeicher und Rechenleistung eine große Herausforderung. Genau hier setzt das innovative System RAGDoll an.

Entwickelt von Weiping Yu, Ningyi Liao, Siqiang Luo und Junfeng Liu, zielt RAGDoll darauf ab, die üblichen Engpässe bei der Ausführung von Retrieval- und Generation-Prozessen effizient zu überwinden. Die meisten existierenden RAG-Systeme führen Retrieval und Textgeneration sequenziell aus, was zu signifikanten Wartezeiten und einer schlechten Auslastung der Hardware führt. RAGDoll hingegen nutzt eine intelligente Entkopplung dieser beiden Prozesse und betreibt sie parallel, wodurch die vorhandenen Ressourcen eines einzelnen GPUs maximal ausgenutzt werden können. Der Kern von RAGDoll besteht darin, Retrieval und generative Modellierung nicht nur unabhängig voneinander, sondern auch mit dynamischer Speicherverwaltung und adaptiver Batch-Verarbeitung zu orchestrieren. Das System erkennt, dass beide Komponenten unterschiedliche Anforderungen an Rechenleistung und Speicher haben: Während der Retrieval-Teil intensiven Zugriff auf Datenbanken erfordert, fokussiert die Generationsphase stark auf das neuronale Netzwerk und die sequenzielle Verarbeitung großer Modelle.

Durch die Aufteilung in Parallelpipelines kann RAGDoll das Ineinandergreifen dieser unterschiedlichen Belastungen so organisieren, dass Auslastungslücken minimiert werden. Besonders beeindruckend ist, wie RAGDoll die Speicherplatzverteilung entlang der Pipeline automatisiert optimiert. Es sorgt dafür, dass Zwischenergebnisse und Modellparameter immer an optimaler Stelle im Speicher abgelegt werden, um Datenübertragungen und Verzögerungen zu reduzieren. Ergänzend dazu steuert die dynamische Batch-Scheduling-Strategie, wie viele Anfragen gesammelt und gleichzeitig verarbeitet werden, um den Spagat zwischen hoher Durchsatzrate und geringer Latenz zu meistern. Durch diese innovative Architektur erreicht RAGDoll im Vergleich zu traditionellen seriellen RAG-Systemen wie vLLM eine durchschnittliche Beschleunigung der Antwortzeiten um den Faktor 3,6.

Das bedeutet, dass Benutzer auf ressourcenbeschränkten Computern nun erheblich schneller hochqualitative Antwortinhalte erhalten können. Diese Leistungssteigerung hat nicht nur technische Relevanz, sondern eröffnet auch neue Möglichkeiten für Anwendungen, die auf Echtzeit-Reaktionen und großen Wissensdatenbanken basieren, beispielsweise in der Literaturrecherche, Kundenbetreuung oder interaktiven Lernplattformen. Darüber hinaus zeigt die Flexibilität von RAGDoll, dass das System sich an verschiedene Hardwareumgebungen und Modellgrößen anpassen lässt. Egal ob Einsteiger-GPUs in Desktop-PCs oder leistungsfähige Geräte in Servern, RAGDoll skaliert intelligent mit, was den Zugang zu RAG-Technologie breitflächig erleichtert und die Eintrittsbarrieren für Forschung und Entwicklung senkt. Aus technischer Sicht setzt RAGDoll auf moderne Programmieransätze und Frameworks, die parallele Verarbeitung und effizientes Speicher-Management erlauben.

Es arbeitet mit State-of-the-Art-Mechanismen zur Synchronisation der Pipeline-Stufen, um Deadlocks oder Ressourcen-Konflikte zu vermeiden. Dieses systematische Design schafft eine stabile und gleichzeitig flexible Ausführungsumgebung. Der Fortschritt, den RAGDoll darstellt, hat außerdem Auswirkungen auf Nachhaltigkeit und Energieeffizienz. Durch bessere Ressourcennutzung wird der Energieverbrauch beim Betrieb riesiger Sprachmodelle auf kleineren Geräten reduziert, was nachhaltigere KI-Anwendungen fördert. Insgesamt zeigt RAGDoll, wie durch intelligente Algorithmik und systematische Anpassungen an die Besonderheiten von Hardware-Ressourcen neue Wege beschritten werden können, um große Sprachmodelle zugänglicher zu machen.

Die Kombination aus paralleler Verarbeitung, dynamischem Scheduling und optimiertem Memory-Management hebt die Barrieren für den effizienten Betrieb komplexer LLMs auf Einzel-GPU-Systemen. Mit der Veröffentlichung dieser Forschung wird das Potenzial für zahlreiche praktische Anwendungen erweitert. Entwickler und Unternehmen profitieren von einer Technologie, die nicht nur theoretisch innovative Konzepte umsetzt, sondern auch in realen Szenarien messbare Performancegewinn bringt. RAGDoll stellt somit einen bedeutenden Schritt in der Demokratisierung von KI-Modellen dar, indem es leistungsfähige Algorithmen für eine breitere Nutzergruppe auf Geräten mit begrenzten Ressourcen zugänglich macht. Abschließend lässt sich sagen, dass RAGDoll durch seine einzigartige Kombination aus Offloading-Techniken, paralleler Prozessarchitektur und adaptivem Ressourcenmanagement ein Musterbeispiel für zukunftsweisende KI-Infrastruktur darstellt.

Es bietet eine Antwort auf die steigenden Anforderungen moderner KI-Anwendungen und die Notwendigkeit, diese effizient und ressourcenschonend zu betreiben. Die Forschungsarbeit von Yu, Liao, Luo und Liu bringt damit einen wertvollen Beitrag zur Weiterentwicklung von LLMs und deren Integration in den alltäglichen Gebrauch.