In der modernen Datenverarbeitung spielt Zeit eine zentrale Rolle, vor allem wenn es um das Streamen und Verarbeiten von Ereignissen in Echtzeit geht. Apache Flink SQL ist eine leistungsstarke Plattform, die Echtzeit-Datenströme analysiert und verarbeitet. Dabei sind Wasserzeichen (Watermarks) ein entscheidendes Konzept, um zeitliche Konsistenz und effiziente Fensterauswertungen zu gewährleisten. Doch was genau sind Wasserzeichen, warum sind sie so wichtig und wie lassen sie sich in Flink SQL professionell einsetzen? Dieser ausführliche Einblick beleuchtet die Grundlagen, Herausforderungen und praxisorientierte Einsatzmöglichkeiten von Wasserzeichen in Apache Flink SQL. Zeitbegriffe in der Datenverarbeitung – Event Time und Processing Time Die Differenzierung von Zeitbegriffen ist essenziell, um Stream-Daten korrekt zu interpretieren und zu verarbeiten.

Zum einen gibt es die sogenannte Event Time, die den Zeitpunkt beschreibt, zu dem ein Ereignis tatsächlich in der realen Welt stattfand. In unserem Alltagsbeispiel ist das etwa der Moment, in dem ein Kunde eine Bestellung aufgibt. Zum anderen existiert die Processing Time, welche den Zeitpunkt angibt, an dem ein System das jeweilige Ereignis verarbeitet. Dies ist der sogenannte System- oder Wall-Clock-Zeitpunkt. Gerade in verteilten Systemen, wie Kafka und Flink, divergiert häufig die Event Time stark von der Processing Time, da Ereignisdaten verzögert, in anderer Reihenfolge oder gar verspätet (Late Events) eintreffen können.

Um diese Unterschiede zu handhaben, sind präzise Zeit-Attribute und der Einsatz von Wasserzeichen notwendig. Die Rolle von Zeitattributen in Flink SQL Flink SQL verwendet explizite Zeitattribute, um zeitliche Operationen wie Fensterfunktionen korrekt durchzuführen. Zeitstempel allein reichen hier nicht aus. Für Event Time muss ein Zeitstempel explizit als Zeitattribut gekennzeichnet werden, indem Wasserzeichen definiert werden. Bei Processing Time wird oft die Flink-eigene Funktion PROCTIME() verwendet, um das Wall-Clock-Zeitkonzept abzubilden.

Ein Zeitattribut zu definieren ist nicht nur Grundvoraussetzung, damit Fenster-Operationen ohne Fehlermeldungen ausgeführt werden können, sondern stellt auch sicher, dass zeitabhängige Abfragen deterministisch und korrekt ablaufen. Kafka und Flink: Wo liegt die Zeit? Kafka liefert neben dem eigentlichen Ereignisdaten eine Message-Timestamp-Metadaten, die entweder vom Producer oder vom Broker stammen können. Diese kann als Event Time dienen, muss aber nicht zwangsläufig mit einem im Payload enthaltenen Zeitstempel übereinstimmen. Im Kafka-Connector von Flink kann man sowohl Events über deren Payload-Zeit (etwa ein Feld „created_at“) als auch über die Kafka-Message-Timestamp verarbeiten. Für exakte Event-Time-Auswertungen ist es jedoch üblich, einen Event-Zeitstempel aus dem Payload festzulegen und die Kafka-Message-Timestamp als weitere Metainformation zu nutzen.

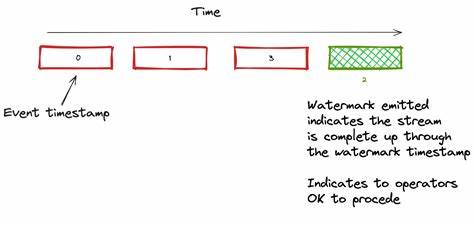

Wasserzeichen: Das Herzstück des Event-Time-Handling Wasserzeichen definieren einen Fortschrittsindikator im Event-Time-Fluss und helfen Flink dabei, zu bestimmen, wann Zeitfenster geschlossen werden können. Sie geben an, wie weit Flink im Zeitfluss vorgedrungen ist, also welche Events mit Zeitstempeln bis zu einem bestimmten Zeitpunkt vollständig angekommen sein sollten. Werden Wasserzeichen korrekt definiert, kann Flink belastbare Zeitfensterabschlüsse ermöglichen und gleichzeitig auf verspätete Ereignisse (Late Events) reagieren. Ohne Wasserzeichen wäre es unmöglich, zeitbasierte Fenster korrekt abzuschließen, da das System nicht wissen kann, ob spätere, ältere Events noch eintreffen könnten. Wasserzeichen werden im Flink SQL über die DDL-Sprache definiert.

Ein Wasserzeichen wird an eine Zeitspalte mit der Konstruktion „WATERMARK FOR <Spaltenname> AS <Spaltenname> - INTERVAL '5' SECOND“ gebunden. Dabei definiert der Intervall die maximale Toleranz für verspätete Ankünfte – here eine fünf Sekunden Verzögerung. Dieses Zeitfenster der Toleranz stellt damit die Balance zwischen Latenz und Vollständigkeit der Daten dar. Praktisches Beispiel und Herausforderungen in der Wasserzeichen-Konfiguration Wird in einer Flink-Tabelle die Event-Time-Spalte „created_at“ als Zeitattribut genutzt, muss ein Wasserzeichen definiert sein. Ohne Wasserzeichen treten bei Fensterfunktionen Fehler auf, da die Event-Zeit-Spalte nicht als Zeitattribut erkannt wird.

Fällt die Wahl auf Processing Time, etwa mit PROCTIME(), so verwendet Flink die Systemzeit und wartet die errechneten Fenster bis deren Laufzeit anhand des Wall-Clocks vergeht. Dies hat den Nachteil, dass Ergebnisse nicht deterministisch sind und Late Events nicht adäquat berücksichtigt werden. Ein prominentes Problem bei Flink-Streams aus Kafka-Quellen sind die sogenannten idle partitions. Das bedeutet, einige Kafka-Partitionen liefern statt aktiv laufenden Daten keine neuen Nachrichten, sodass von ihnen keine Wasserzeichen aktualisiert werden. Da Flink den aktuell niedrigsten Wasserzeichenwert aller Partitionen referenziert, bleibt diese Wasserzeichenposition unverändert stehen und Fenster können nicht geschlossen werden.

Die Lösung ist die Konfiguration eines idle-timeouts („scan.watermark.idle-timeout“), welche in Flink angibt, wie lange eine Partition bei Inaktivität ignoriert wird, sodass unterschiedliche Verarbeitungs-Operatoren trotzdem Wasserzeichen vorantreiben können. Ein neues Datenereignis in einer zuvor inaktiven Partition kann das Wasserzeichen weiter verschieben und so Fenster abschließen, was vorher nicht möglich war. Ausgabe und Beobachtung der Wasserzeichen Dank der Funktion CURRENT_WATERMARK() lassen sich in Flink-SQL-Abfragen Wasserzeichenpositionen abfragen, allerdings spiegeln diese Werte insbesondere zu Beginn der Ausführung oder bei spärlicher Datenlage nicht immer die aktuelle Wasserzeichenposition wider.

Für ein präzises Monitoring empfiehlt sich daher die Flink-Weboberfläche oder die REST-API, welche jederzeit den tatsächlichen Stand der Wasserzeichen anzeigt. Diese Sicht hilft auch bei der Problembehandlung, falls Fenster nicht wie erwartet schließen oder Aggregationen ausbleiben. Balance zwischen Latenz und Genauigkeit Wasserzeichen stehen im Zentrum der Balance zwischen „Frachtpünktlichkeit“ und „Frachtvollständigkeit“. Ein kurzer Wasserzeichen-Offset führt zu schnelleren Ergebnissen, aber mehr Late Events werden abgeschnitten und gehen verloren. Ein langer Offset reduziert solche Verluste, erhöht aber die Verzögerung bei Ergebnislieferungen.

Somit hängt die individuelle Einstellung von den spezifischen Anforderungen des Anwendungsfalls ab. Für Anwendungsfälle, die Echtzeit-Ergebnisse bevorzugen, sind kleinere Offsets nützlich; Szenarien, die hohe Datenkomplettheit fordern, benötigen längere Offsets. Fazit Das Verständnis und die richtige Anwendung von Wasserzeichen sind unverzichtbar für eine präzise Event-Time-Verarbeitung mit Apache Flink SQL, insbesondere in Kombination mit verteilten, verzögerten oder unvollständigen Datenströmen aus Systemen wie Apache Kafka. In der Praxis sind Zeitattribut-Definitionen, optimale Wasserzeichen-Strategien sowie die Konfiguration von idle-timeouts elementar, um zuverlässige zeitbasierte Fensterabfragen zu realisieren. Die Kombination dieser Strategien ermöglicht es, massive Datenströme effizient und korrekt zeitlich zu analysieren, was für Echtzeitanalysen, Monitoring oder Business Intelligence unabdingbar ist.

Wer mit Flink SQL arbeitet, sollte sich intensiv mit Wasserzeichen auseinandersetzen, um das Potenzial der Plattform vollständig auszuschöpfen und Verzögerungen, Auslassungen oder nicht-deterministische Ergebnisse zu vermeiden. Die kontinuierliche Beobachtung der Wasserzeichen über Flink UI oder REST-Schnittstellen unterstützt zudem ein nachhaltiges Monitoring und Troubleshooting der Streaming-Jobs auf Betriebsebene. Indem Unternehmen die komplexen zeitlichen Zusammenhänge ihrer Daten verstehen und gezielt steuern, schaffen sie die Grundlage für verlässliche, aussagekräftige und schnelle Echtzeit-Datenverarbeitung auf höchstem Niveau.