Im digitalen Zeitalter erleben wir eine rasante Entwicklung künstlicher Intelligenz und insbesondere großer Sprachmodelle (LLMs), die ihre Anwendungsmöglichkeiten kontinuierlich erweitern. Viele Entwickler und Unternehmen sind bestrebt, durch den Einsatz von Multi-Agenten-Systemen, also mehreren kooperierenden KI-Agenten, komplexe Probleme effizienter zu lösen und parallele Arbeitsprozesse zu realisieren. Doch trotz dieser Versuchung raten Experten wie die Entwickler von Devin, vorsichtig bei der Einführung solcher Architekturen zu sein. Die Gründe dafür sind vielschichtig und tief verwurzelt in der Art und Weise, wie Kontext, Entscheidungen und Kommunikation zwischen Agenten gehandhabt werden müssen, um langfristige Zuverlässigkeit und Kohärenz zu gewährleisten. Einer der zentralen Aspekte, der gegen Multi-Agenten-Systeme spricht, ist das Problem der Kontextkontinuität und der gemeinsamen Wissensbasis.

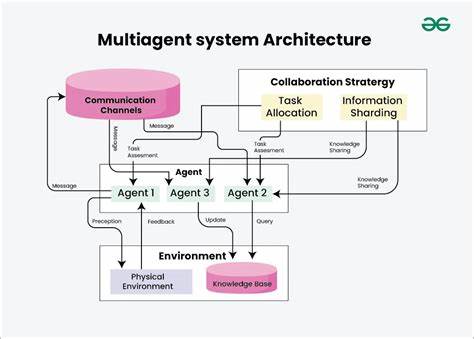

Moderne KI-Modelle, so intelligent sie auch sein mögen, benötigen einen klar definierten und durchgängigen Kontext, um Aufgaben effektiv zu lösen. Dieser Kontext muss alle relevanten Informationen der vergangenen Interaktionen, Entscheidungen und Aktionen umfassen. Bei einem System, in dem mehrere Agenten parallel an unterschiedlichen Teilaufgaben arbeiten, ist die Sicherstellung dieses Kontext-Sharings äußerst komplex. Der Grund dafür liegt darin, dass jeder Subagent isoliert agiert und häufig nicht die Möglichkeit hat, die Arbeit der anderen Agenten vollständig oder präzise nachzuvollziehen. Dieses Fehlen eines durchgängigen und dynamisch geteilten Kontexts führt unvermeidlich zu Inkonsistenzen und widersprüchlichen Ergebnissen.

Wenn zum Beispiel die Aufgabe darin besteht, ein Spiel wie Flappy Bird nachzubauen, könnte ein Agent den Hintergrund designen, während ein anderer den spielbaren Charakter konstruiert. Fehlt die Möglichkeit zur Abstimmung, könnten die visuellen Stile völlig auseinanderdriften oder die Funktionalität nicht harmonieren. Diese Probleme resultieren aus impliziten Entscheidungen, die von den einzelnen Agenten getroffen werden, ohne dass sie sich gegenseitig vollständig darüber informieren oder eine gemeinsame Entscheidungsgrundlage schaffen. Das bedeutet, dass selbst kleine Missverständnisse innerhalb eines Subagenten gravierende Auswirkungen auf das gesamte Projektergebnis haben können. Der Bereich der Kontext- und Entscheidungskontrolle wird durch das sogenannte "Context Engineering" adressiert, das als neue Disziplin weit über das klassische Prompt Engineering hinausgeht.

Es umfasst das automatische und dynamische Management von Kontextdaten in einem laufenden KI-Agentensystem. Entwicklern wird empfohlen, den gesamten Verlauf der Entscheidungen, Nachrichten und Aktionen transparent und für alle involvierten Prozesse verfügbar zu halten, um eine einheitliche und konsistente Aufgabenbearbeitung sicherzustellen. Ein zentrales Prinzip dabei ist, nicht nur einzelne Nachrichten oder Datenfragmente zu teilen, sondern vollständige Agentenspuren und Entscheidungsprotokolle einzubeziehen. Das schafft eine Grundlage dafür, dass Fehler und Missverständnisse, welche bei fragmentiertem Informationsaustausch entstehen, minimiert werden. Vor diesem Hintergrund wird die klassische Idee der parallelen Subagenten-Arbeit stark infrage gestellt.

Die Gefahr, dass sich Zustände und Arbeitsstände der Agenten auseinanderentwickeln, ist hoch, und die Reparatur solcher Inkonsistenzen erfordert in der Regel deutlich mehr Aufwand, Zeit und Rechenressourcen als die vermeintliche Zeitersparnis durch Parallelisierung. Der Ansatz, der sich stattdessen bewährt hat, ist der eines single-threaded, also linear aufbauenden Agentensystems. In einem solchen System gibt es eine klare Abfolge von Entscheidungen und Aktionen, wodurch der Kontext kontinuierlich erweitert und gepflegt werden kann. Dies unterstützt nicht nur die Kohärenz der Ergebnisqualität, sondern macht auch das Debugging und die Fehleranalyse wesentlich effizienter. Natürlich hat auch ein linearer Agent bei sehr umfangreichen und komplexen Aufgaben seine Grenzen, insbesondere wenn der Kontextumfang die maximale Verarbeitungskapazität eines Modells überschreitet.

Devin und andere Pioniere schlagen daher vor, intelligente Komprimierungsstrategien für den Kontext zu implementieren. Hierbei kommen spezialisierte Modelle zum Einsatz, die in der Lage sind, längere Gesprächs- und Aktionsverläufe in wesentliche Informationen, Entscheidungen und Ereignisse zusammenzufassen, ohne dass wichtige Details verloren gehen. Solche Methoden erlauben eine effektive Bewältigung von Langzeitaufgaben, die mit reinem Single-Threading sonst schwer zu bewältigen wären. Neben dem technischen Hintergrund spielen aber auch praktische Erfahrungen mit Multi-Agenten-Systemen eine wichtige Rolle in der Aussprache gegen diese Modelle. Beispiele wie das Agentensystem von Claude Code verdeutlichen, dass selbst etablierte und fortschrittliche Implementierungen Multi-Agenten zwar nutzen, jedoch bewusst keine parallele Bearbeitung großer Subtasks durchführen.

Stattdessen werden etwaige Unteragenten nur für klar umrissene, zeitlich versetzte Anfragen eingesetzt. So können widersprüchliche Antworten und uncoordinierte Aktionen vermieden werden, was die Systemzuverlässigkeit signifikant steigert. Ein weiteres interessantes Beispiel ist der Wandel im Bereich der Code-Editing-Modelle. Früher waren viele KI-gestützte Editiermethoden in zwei Schritte unterteilt: ein großes Modell schlug Änderungen als textuelle Erläuterungen vor, während ein kleineres Modell diese Vorschläge dann umsetzte. Doch dieser Ansatz erwies sich als fehleranfällig, da die Interpretation der Änderungsvorgaben oft nicht fehlerfrei passierte.

Heutige Verfahren tendieren zu einem einheitlichen Modell, das sowohl Entscheidung als auch Umsetzung kombiniert, was die Fehlerquellen reduziert und den Prozess beschleunigt. Die Idee einer aktiven Kommunikation und Interaktion unter Multiplen KI-Agenten ist langfristig keineswegs ausgeschlossen. Im Gegenteil, es ist sehr wahrscheinlich, dass zukünftige Generationen von KI-Systemen solche Paradigmen beherrschen werden. Dabei gilt es jedoch, den erheblichen intellektuellen Aufwand zu beachten, den Menschen in realen Teams für erfolgreiche Kommunikation und konfliktfreie Zusammenarbeit investieren. Aktuelle KI-Systeme verfügen nicht über die gleiche Fähigkeit, differenzierte Informationen effizient auszutauschen oder komplexe Streitfragen autonom zu klären.

Ohne diese Kompetenz führt die Aufteilung von Entscheidungsverantwortung auf mehrere Agenten momentan eher zu einem Zerfall der Kohärenz und Zuverlässigkeit. Zusammenfassend lässt sich festhalten, dass Entwickler und Unternehmen, die heute robuste und produktionsreife KI-Agenten-Systeme aufbauen wollen, Multi-Agenten-Architekturen mit großer Vorsicht betrachten sollten. Eine stringente Kontextverwaltung, die Vermeidung voneinander entkoppelter Entscheidungsprozesse und eine klare lineare Ablaufsteuerung sind aktuell die Schlüssel zu stabilen Systemen. Gleichzeitig zeigen innovative Komprimierungsansätze und das integrierte Handling von Entscheidungsfindung und Ausführung in einem Modell Wege auf, wie auch langfristige, komplexe Aufgaben bewältigt werden können. Die Überlegungen und Erkenntnisse von Devin sind nicht als endgültiges Urteil zu betrachten, sondern vielmehr als wichtige Impulse für die Weiterentwicklung von Prinzipien beim Aufbau intelligenter Agentensysteme.

Das Gebiet ist dynamisch und offen für künftige Innovationen, aber die derzeitigen Erfahrungen und Forschungsergebnisse legen nahe, dass Multi-Agenten-Systeme in ihrer aktuellen Form weder effizient noch zuverlässig genug sind, um als Standardlösung für anspruchsvolle KI-Anwendungen zu gelten. Für Projektverantwortliche empfiehlt es sich daher, zunächst auf bewährte, kontextbewusste Ein-Agenten-Architekturen zu setzen und eher auf deren kontinuierliche Optimierung und intelligente Kontextkompression zu fokussieren. Sobald der Bereich der Agentenkommunikation wesentliche Fortschritte gemacht hat, wird das Potenzial paralleler Multi-Agenten-Systeme vielversprechend sein. Bis dahin bleibt Vorsicht geboten, um Fehlentwicklungen und kostspielige Fehler bei komplexen KI-Projekten zu vermeiden.

![Quantum Computing without the Linear Algebra [pdf]](/images/B8B9322F-36A4-44B3-8FD7-9B2A01969BFB)