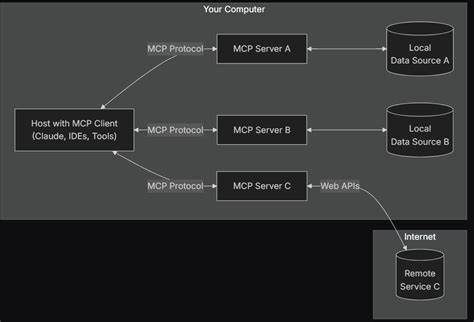

Die zunehmende Bedeutung von Künstlicher Intelligenz (KI) und insbesondere großer Sprachmodelle (Large Language Models, LLMs) führt zu immer anspruchsvolleren Anwendungen, bei denen es nicht nur auf reine Sprachverständnisfähigkeiten ankommt, sondern vor allem auch auf den Zugriff auf aktuelle und verlässliche Wissensquellen. Ein zentrales Problem dabei ist die Fragmentierung von Schnittstellen zu externen Datenquellen und Tools, die bisher eine individuelle und oft umständliche Integration erfordert haben. Das Model-Context-Protocol (MCP), entwickelt von Anthropic, setzt genau an diesem Punkt an und stellt eine standardisierte Schnittstelle für die Interaktion zwischen KI-Modellen und externen Servern bereit. Das ermöglicht eine nahtlose, wiederverwendbare Anbindung unterschiedlichster Ressourcen und fördert zugleich die Skalierbarkeit von KI-Systemen. In diesem Zusammenhang ist das Aufbauen eines Wikipedia MCP Servers ein anschauliches und praxisnahes Beispiel, wie LLMs direkten Zugriff auf eine der umfangreichsten frei verfügbaren Wissensdatenbanken erhalten können.

MCP definiert einen Client-Server-Ansatz, bei dem Clients, meistens die KI-Modelle oder Anwendungen, externe Server anfragen, welche spezifische Fähigkeiten in Form von Ressourcen, Prompts oder Tools bereitstellen. Ressourcen liefern strukturierte Kontextdaten, Prompts bieten vordefinierte Nachrichten- und Interaktionsmuster, und Tools ermöglichen das Ausführen bestimmter Funktionen durch die KI. Diese klare Trennung der Verantwortlichkeiten macht den Umgang mit vielfältigen Datenquellen erheblich effizienter und schafft außerdem eine gemeinsame Sprache für den Datenaustausch.Beim Aufbau eines Wikipedia MCP Servers steht daher die Frage im Mittelpunkt, wie man die umfangreichen Informationen der Wikipedia-Datenbank über die Wikimedia API sinnvoll zugänglich macht. Die Wikipedia als dynamische, stets aktualisierte Wissensquelle eignet sich hervorragend, um KI-Modellen kontextreiche und verifizierbare Daten zur Verfügung zu stellen.

Dank der Python-Bibliothek wikipedia-api gelingt der Zugriff auf Artikel, deren Zusammenfassungen, einzelne Seitenabschnitte und auch Suchergebnisse mit minimalem Aufwand.Das technische Grundgerüst des Servers basiert auf moderner Python-Entwicklung. Mit dem Paketmanager uv wird ein Projekt initiiert und die relevanten Abhängigkeiten installiert, darunter FastMCP für die Umsetzung des Protokolls und pydantic als robuste Lösung für die Modellierung und Validierung der Datenstrukturen. Die WikipediaClient-Klasse kapselt die Interaktion mit der Wikipedia API und stellt Methoden zum Abrufen ganzer Seiten, spezifischer Abschnitte und Suchergebnisse bereit. Dabei werden die Daten in wohlstrukturierten pydantic-Modellen zurückgegeben, die neben den eigentlichen Inhalten auch Metainformationen wie URLs, Abschnittstitel und Wortanzahl enthalten.

Die Entscheidung, die vollständigen Inhalte einer Seite nicht standardmäßig zu laden, sondern auf Anfrage bereitzustellen, ist eine pragmatische Strategie. So wird vermieden, dass Sprachmodelle durch zu viel Textdaten überfordert oder zu träge im Antwortverhalten werden. Stattdessen erlaubt die Option des gezielten Abrufs von Unterkapiteln oder die Nutzung der Suchfunktion eine feingliedrige Steuerung, wie viele und welche Informationen abgefragt werden. Diese Flexibilität ist zentral für den Einsatz in produktiven KI-Systemen, die auf verschiedenste Nutzeranfragen reagieren müssen.Die Definition der Tools im MCP Server erfolgt elegant über dekorierte Funktionen, die mit FastMCP registriert werden.

Funktionen wie get_wikipedia_page, get_wikipedia_section und search_wikipedia repräsentieren die Hauptfähigkeiten des Servers. Sie sind mit klaren Parametern und aussagekräftigen Beschreibungen versehen, so dass Clients die Möglichkeiten verstehen und gezielt ansprechen können. Fehlerbehandlungen, etwa bei nicht vorhandenen Seiten oder Abschnitten, führen zu verständlichen Ausnahmen, die intelligent verarbeitet werden können.Ein weiteres Highlight ist die Integration eines Beispielprompts im System, der Anwendern oder anderen KI-Modulen einen Leitfaden gibt, wie sie die Werkzeuge effektiv nutzen. Das Prompt fordert dazu auf, zunächst gezielt zu suchen, dann relevante Abschnitte oder Seiten einzuholen und darauf aufbauend eine fundierte Antwort zu formulieren.

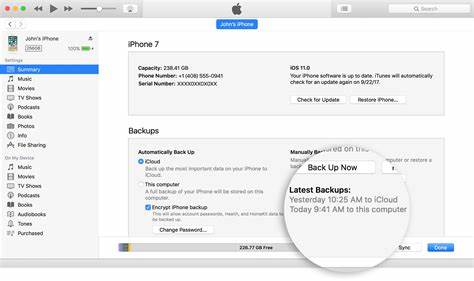

Auch das Zitieren der Quellen wird empfohlen, um die Nachvollziehbarkeit zu gewährleisten. Dieses Benutzererlebnis fördert den bewussten und gezielten Einsatz der Technologien.Neben der lokalen Ausführung per Stdio-Transport bietet der Artikel auch Hinweise auf den parallelen Betrieb via Server-Sent-Events (SSE). Das ist gerade für verteilte oder webbasierte Anwendungen interessant, da hier eine entkoppelte Kommunikation möglich wird. Tools wie die MCP Inspector ermöglichen ein einfaches Debugging und Monitoring, was bei der Entwicklung und beim Betrieb unerlässlich ist.

Spannend wird die Anbindung des MCP Servers an eine Agenten-Architektur, die mit der Smolagents-Bibliothek realisiert wird. Hier kommen openAI-Modelle zum Einsatz, die über den MCP-Server Zugriff auf Wikipedia-Wissen erhalten und komplexe Fragen selbstständig beantworten können. Das Beispiel zeigt, wie sich der Agent erst auf eine fehlerhafte Anfrage mit einer nicht-existierenden Sektion einstellt, dann umschwenkt und via Suchfunktion die richtige Strategie findet. Solche adaptiven Workflows unterstreichen die Robustheit und Intelligenz heutiger KI-Systeme.Die damit erzielten Ergebnisse demonstrieren eindrucksvoll, dass ein durch MCP eingebundener Wikipedia-Server in Kombination mit Sprachmodellen fundierte, gut strukturierte und zitierte Antworten liefern kann.

Die Praxisrelevanz für diverse Anwendungen aus dem Kundenservice über Forschung bis hin zu Bildungsplattformen ist enorm. Denn die Qualität der Antworten hängt hier nicht nur von den Sprachfähigkeiten ab, sondern vor allem von der Qualität und Aktualität der zugrundeliegenden Daten.Abseits der technischen Umsetzung sollte auch der Aspekt der Sicherheit nicht vernachlässigt werden. MCP-Server, die Funktionalitäten exponieren, bergen Risiken wie mögliche Missbrauchsszenarien oder Angriffe über manipulierte Eingaben. Anthropic hat darauf reagiert und empfiehlt Authentifizierungsmechanismen für den Zugang.

Gleichzeitig forschen Sicherheitsexperten weiter daran, um etwaige Schwachstellen durch Prompt-Injection oder andere Attacken frühzeitig zu erkennen und zu beheben. Für Unternehmen und Entwickler ist es daher wichtig, die Entwicklungen in diesem Bereich genau zu verfolgen und passende Schutzmaßnahmen zu implementieren.Zusammenfassend zeigt der Aufbau eines Wikipedia MCP Servers, wie moderne KI-Systeme durch standardisierte Protokolle und modulare Architekturen effektiver, skalierbarer und vielseitiger gestaltet werden können. Die Entkopplung von Modell und Werkzeugen ermöglicht eine Wiederverwendbarkeit in verschiedenen Szenarien und vereinfacht die Wartung. Durch das Bereitstellen strukturierter, granular abrufbarer Inhalte aus Wikipedia gewinnen KI-Anwendungen erheblich an Informationsreichtum und Glaubwürdigkeit.