Die Chemie zählt zu den naturwissenschaftlichen Disziplinen, die durch den Einsatz moderner Technologien nachhaltig transformiert werden. Insbesondere große Sprachmodelle, sogenannte Large Language Models (LLMs), nehmen eine immer bedeutendere Rolle ein. Diese KI-Systeme basieren auf maschinellem Lernen und sind in der Lage, komplexe Aufgaben in der menschlichen Sprache zu bewältigen, obwohl sie ursprünglich nicht explizit auf Fachwissen in Chemie trainiert wurden. Wie stehen sie im Vergleich zur Expertise von ausgebildeten Chemikern? Sind sie bereit, traditionelle Wege in Forschung, Lehre und Industrie zu revolutionieren oder stoßen sie auf fundamentale Grenzen? In den letzten Jahren haben LLMs bemerkenswerte Fortschritte gemacht und sind beispielsweise darauf trainiert worden, medizinische Prüfungen zu bestehen oder komplexe Texte zu generieren. Chemiewissenschaftlern eröffnen diese Modelle die Möglichkeit, riesige Mengen an chemischem Wissen aus wissenschaftlichen Publikationen, Datenbanken und Lehrmaterialien auszuwerten und auf Basis dessen neue Erkenntnisse zu gewinnen.

Systeme wie ChemBench stellen dafür eine Evaluierungsplattform bereit, die über 2700 Fragen aus diversen Bereichen der Chemie enthält. Dadurch lässt sich der Wissensstand und die Problemlösekompetenz der Modelle systematisch mit der von menschlichen Chemikern vergleichen. Die Ergebnisse solcher Vergleiche überraschen und faszinieren zugleich. Einige der führenden LLMs können in diesem standardisierten Rahmen sogar besser als menschliche Experten abschneiden. Insbesondere bei vielen Basis- und Mittelschwer-Aufgaben zeigen die Modelle eine enorme Leistungsfähigkeit, die teilweise den Menschen übersteigt.

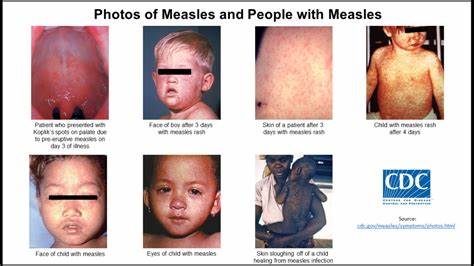

Dadurch entsteht das Bild eines digitalen „Superchemikers“, der jederzeit verfügbar ist, selbsterklärende Antworten liefert und dabei auf eine umfassende Datenbasis zurückgreift – ein potenzieller „Co-Pilot“ des Forschers. Doch der Schein trügt, wenn es um Detailfragen und tiefgründiges chemisches Denken geht. Viele LLMs kämpfen insbesondere mit Fragestellungen, die über bloßes Faktenwissen hinausgehen und komplexe Schlussfolgerungen oder praktische Erfahrungen erfordern. So sind Aufgaben aus Bereichen wie analytischer Chemie, der Bewertung der Toxizität oder den Prinzipien der chemischen Sicherheit für manche Modelle nur schwer zu bewältigen. Darüber hinaus weisen LLMs eine Tendenz zu übergroßem Selbstvertrauen auf.

Das bedeutet, dass sie oft Antworten als gesichert präsentieren, bei denen Unsicherheiten bestehen oder Fehler vorliegen – ein nicht unerhebliches Risiko in sicherheitskritischen Kontexten. Eine wichtige Beobachtung bei der Analyse von Modellen ist, dass ihre Größe und Trainingsdatenbasis wichtige Einflussgrößen für die Leistung darstellen. Größere Modelle können mehr chemisches Wissen speichern und auf komplexere Zusammenhänge eingehen, allerdings profitieren sie auch davon, auf speziellere chemische Datenbanken und strukturierte wissenschaftliche Ressourcen zurückzugreifen. Dies zeigt, dass der Weg zu höherer Zuverlässigkeit und Tiefe in der chemischen Analyse durch eine Kombination aus Datenvielfalt, Modellarchitektur und gegebenenfalls Werkzeugintegration führt. Ebenso spannend ist der Einsatz von multimodalen Ansätzen, in denen Modelle neben der Verarbeitung von Text auch mit chemischen Strukturen, Formeln und Gleichungen umgehen können.

Da viele klassische Chemieaufgaben eine visuelle oder grafische Komponente beinhalten, stellt die Fähigkeit, molekulare Strukturen angemessen zu interpretieren, einen wichtigen Fortschritt dar. Aktuelle LLMs nutzen beispielsweise die SMILES-Notation, um Moleküle darzustellen, doch die vollständige semantische Erfassung chemischer Strukturen bleibt eine Herausforderung. Im Bildungskontext wirft die zunehmende Leistungsfähigkeit von LLMs grundlegende Fragen auf. Während traditionell das Auswendiglernen von Fakten und das Lösen vielfacher Übungsaufgaben wesentliche Elemente der Chemieausbildung sind, zeigen LLMs, dass das reine Memorieren bald nicht mehr konkurrenzfähig ist. Mehr denn je wird kritisches Denken und die Fähigkeit zur eigenständigen Analyse erforderlich.

Gleichzeitig eröffnen digitale Assistenten neue Wege, individuelles Lernen zu fördern und zeitintensive Rechercheprozesse zu verkürzen. Trotz der Potenziale sollten auch die ethischen und sicherheitsrelevanten Aspekte nicht vernachlässigt werden. LLMs könnten etwa dazu missbraucht werden, schädliche Substanzen zu konzipieren oder irreführende Informationen zur chemischen Sicherheit zu verbreiten. Die Breite der Nutzergruppen, zu denen auch Laien und Studierende gehören, macht es besonders wichtig, robuste Kontrollmechanismen zu etablieren, um Missbrauch und gefährliche Fehlannahmen zu vermeiden. Im Bereich Forschung und Entwicklung bieten LLMs zudem Möglichkeiten, Hypothesen zu generieren, experimentelle Pläne vorzuschlagen und Erkenntnisse aus einer enormen Bandbreite von Fachartikeln und Daten schnell zu integrieren.

Einige Systeme kombinieren Sprachmodelle mit automatisierten Laborsystemen, wodurch ein fast autonomer Erkenntnisgewinn möglich wird. Dennoch bleiben menschliche Chemiker unverzichtbar, insbesondere wenn es darum geht, komplexe Zusammenhänge zu interpretieren, ethische Entscheidungen zu treffen und kreative Innovationsprozesse voranzutreiben. Die ChemBench-Plattform zeigt auch, dass die derzeitigen Benchmarks in der Entwicklung von und Evaluierung von LLMs nicht ausreichen, wenn es um die umfassende Bewertung chemischer Kompetenzen geht. Standardtests basieren oft auf Multiple-Choice-Fragen und bloßer Faktenabfrage, während reale Anwendungen tiefere Denkprozesse und die Integration unterschiedlicher Wissensbereiche benötigen. Daher legen die Entwickler Wert auf offene Fragen, komplexe Problemstellungen und die Einbeziehung verschiedener Kompetenzen wie Intuition, Rechenfertigkeiten und elementare wie fortgeschrittene Wissensebenen.

Ein weiterer interessanter Aspekt ist die oftmals fehlende Übereinstimmung der LLM-Ergebnisse mit den Präferenzen erfahrener Chemiker, etwa bei der Bewertung der Attraktivität von Molekülen für die Wirkstoffentwicklung. Die Modelle zeigen meist keine konsistenten Präferenzmuster, was deren Anwendung in der frühen Phase der Medikamentensuche erschwert. Dies unterstreicht den Bedarf, Modelle besser zu trainieren und auf die Belange der Domäne auszurichten. Für die Zukunft der Chemie sind die Implikationen dieser Entwicklungen zweischneidig. Einerseits versprechen LLMs eine Beschleunigung wissenschaftlicher Prozesse, eine Demokratisierung von Wissen und das Entstehen neuer, intelligenter Assistenzsysteme, die Forscher unterstützen.