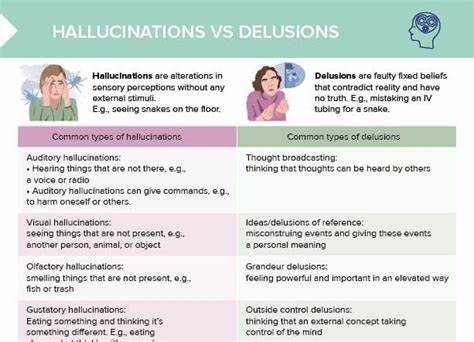

Im Zeitalter der Künstlichen Intelligenz (KI) werden Begriffe wie „Halluzination“, „Bullshit“ und „Konfabulation“ zunehmend diskutiert und stehen dabei oft für Fehler oder Unwahrheiten, die von Sprachmodellen wie ChatGPT oder anderen großen KI-Systemen ausgehen. Doch um diese Phänomene wirklich zu verstehen, lohnt es sich, die tieferen Bedeutungen und Unterschiede hinter diesen Begriffen zu erkunden und zugleich ihre Parallelen zur menschlichen Kognition zu betrachten. Gerade die Verwechslung oder Ungenauigkeit in der Verwendung dieser Worte kann zu Missverständnissen führen, sowohl in der öffentlichen Debatte als auch im wissenschaftlichen Diskurs. Der Begriff „Halluzination“ stammt ursprünglich aus der Psychologie und beschreibt eine sensorische Erfahrung, bei der eine Person einen Reiz wahrnimmt, der objektiv nicht existiert. Ein Halluzinieren ist somit ein mindestens in der eigenen Wahrnehmung realer Eindruck, bei dem das Gehirn eine Sinneswahrnehmung erzeugt, die ohne äußere Ursache besteht.

Wichtig dabei ist, dass ein Mensch, der halluziniert, tatsächlich „etwas sieht, hört oder fühlt“, was objektiv nicht da ist – vergleichbar mit einem Phantomschmerz oder visuellen Illusionen. Auf die KI angewandt, ist der Begriff Halluzination jedoch problematisch. Sprachmodelle etwa besitzen keine sensorischen Eingänge oder ein Bewusstsein, das es ihnen ermöglicht, „Sinneswahrnehmungen“ zu haben. Was hier fälschlich als Halluzination bezeichnet wird, sind häufig falsche oder erfundene Ausgaben – beispielsweise wenn eine KI Informationen nennt, die faktisch nicht stimmen oder komplett erfunden sind. Diese Fehler entstehen nicht dadurch, dass die KI etwas „sieht“ oder „hört“, sondern vielmehr durch probabilistisches Kombinieren von gespeicherten Daten und Wahrscheinlichkeiten.

Ein passenderer Begriff für diese Fehler wäre „Delusion“, also eine falsche Meinung oder Überzeugung, die unabhängig von sensorischer Wahrnehmung entsteht. In diesem Sinne kann man sagen, dass KI nicht halluziniert, sondern eine Art künstliche Delusion produziert, indem sie unsinnige oder falsche Antworten generiert, die dennoch überzeugend klingen können. Dies unterstreicht die Notwendigkeit, die Fettnäpfchen der Sprache zu vermeiden, die zu verzerrten Bildern über KI führen. Der zweite Begriff ist „Bullshit“, den der Philosoph Harry Frankfurt eingehend analysierte und definierte. Bullshit beschreibt Aussagen, die nicht unbedingt bewusst falsch sind, sondern bei denen dem Sprecher die Wahrheit völlig gleichgültig ist.

Im Gegensatz zum Lügen weiß der Lügner, was wahr ist, und versucht bewusst, einen anderen Eindruck zu erzeugen. Der Bullshitter jedoch hat für die Wahrheit keine Orientierung; er äußert sich wahllos, ohne Rücksicht auf Faktizität. In der heutigen Zeit und speziell in Medien, Politik und Gesprächen wird Bullshit häufig als bedeutungsloser oder irreführender Schwachsinn verstanden, der Aufmerksamkeit erregt oder Gespräche füllt, ohne substanzielle Grundlage zu besitzen. Künstliche Intelligenz produziert jedoch keine willkürlichen, sinnlosen Äußerungen ohne Systematik. Obwohl manche Inhalte fehlgeleitet oder erfunden sind, sind ihre Aussagen strukturiert und auf Wahrscheinlichkeiten und gelernten Mustern basiert.

Die KI verbindet Informationen in einem kohärenten Rahmen, der eine gewissermaßen geordnete Sinnhaftigkeit vorgibt. Sie ähnelt daher nicht einem „Bullshitter“, der frei von Sinnzuordnung redet, sondern eher einem System, das aktiv Daten verknüpft und so eine scheinbare Kohärenz erzeugt. Hier stellt sich jedoch ein philosophisches Problem: Kohärenz allein reicht nicht aus, um Wahrheitsgehalt oder Rechtfertigung zu garantieren. In der Erkenntnistheorie existiert die sogenannte Kohärenztheorie der Rechtfertigung, die besagt, dass eine Behauptung gerechtfertigt ist, wenn sie sich sinnvoll in ein Netzwerk von Überzeugungen einfügt. Allerdings ist es bekannt, dass auch sehr widersprüchliche oder falsche Überzeugungssysteme intern kohärent sein können, wie etwa bei schizophrenen Wahnvorstellungen oder extremen Verschwörungstheorien.

Daraus folgt, dass eine rein kohärente Argumentation nicht zwangsläufig wahr ist. Dieser Gedanke lässt sich auf KI-Fehler übertragen: Die KI verknüpft gesammelte Fakten oder Wahrnehmungen zu einem scheinbar schlüssigen Ganzen, das aber nicht der Realität entspricht. Damit kommen wir zur „Konfabulation“, einem Begriff aus der Neuropsychologie und Psychiatrie. Konfabulation bezeichnet die spontane und unbewusste Erfindung von Erinnerungen oder Erklärungen, die eine Person zur Aufrechterhaltung eines kohärenten Selbstbildes oder Gedächtnisses generiert. Dies geschieht häufig bei Patienten mit schweren Gedächtnisstörungen, wie etwa dem Korsakow-Syndrom, einer durch Alkoholismus verursachten chronischen Amnesie.

Betroffene konstruieren Geschichten, die ihnen plausibel erscheinen, um Lücken in ihrem Gedächtnis zu füllen, ohne dabei betrügerische Absichten zu verfolgen. Für sie sind diese erfundenen Erinnerungen genauso real wie echte Erlebnisse. Der Neuropsychologe Oliver Sacks, bekannt durch seine einfühlsamen Fallstudien, schildert eindrücklich die Fallbeispiele von Patienten, die trotz massiver Gedächtnisverluste einen scheinbar stimmigen Alltag gestalten, indem sie kontinuierlich neue, nicht reale Erinnerungen erfinden. Diese Konfabulationen sind keine bewusste Täuschung, sondern ein notwendiger Prozess zur Erhaltung eines gefestigten Selbst und einer strukturierten Weltwahrnehmung. Wenn man den Vergleich zwischen KI und menschlicher Konfabulation zieht, bietet sich ein neues Verständnis der KI-„Fehler“ an.

KI-Systeme versuchen, Lücken in ihrem gespeicherten Wissen zu überbrücken, indem sie Hypothesen oder plausible Ergänzungen generieren. So entsteht ein konsistenter Output, der zwar nicht immer faktisch korrekt, aber meist in sich stimmig ist. Es ist, als ob die KI eine narrative Struktur erstellt, die den Input sinnvoll verbindet, um eine kohärente Antwort zu liefern – auch wenn Teile davon erfunden sind. Diese Vorstellung eröffnet zugleich ein kritisches Problem für unsere eigene Denkweise, insbesondere in einem Zeitalter, in dem viele Menschen zunehmend auf KI-Systeme als externe Quellen für Wissen und sogar für eigene Gedanken zurückgreifen. Die Gefahr besteht darin, dass wir – ähnlich wie Patienten, die konfabulieren – fälschlicherweise glauben, wir hätten selbst bestimmte Überlegungen oder Argumente entwickelt, obwohl wir sie eigentlich nur von der KI übernommen haben.

Menschen könnten anfangen, gedanklich in den Fußstapfen der KI zu wandeln, ohne tatsächliche intellektuelle Arbeit zu leisten – eine Art geistige Auslagerung des Denkprozesses. Die Konsequenz ist eine gefährliche Illusion von Wissen und Urteilsvermögen. Wenn wir Texte lesen, die von KI verfasst wurden, und sie ungeprüft übernehmen, entsteht eine Trennung zwischen der ursprünglichen geistigen Leistung und unseren eigenen Gedanken. Wir riskieren, in einer Blase der Scheinkohärenz zu leben, in der die Grenze zwischen unserem authentischen Denken und der KI-Konfabulation verschwimmt. Dieses Phänomen hat speziell im Bildungsbereich große Bedeutung.

Schüler und Studierende, die Essays schreiben lassen und diese als eigene Werke akzeptieren, verleugnen nicht nur akademische Integrität, sondern auch ihr eigenes intellektuelles Wachstum. Das „Cosplay“ des eigenen Denkens – wie es manchmal genannt wird – bedeutet, dass wir nur so tun, als ob wir die Argumente und Ideen selbst entwickelt hätten, obwohl wir sie lediglich übernommen haben. Nicht nur Betrug, sondern eine selbsttäuschende Verkennung der eigenen Fähigkeiten. Der Vergleich zu „Statuscheatern“, Menschen, die falschen sozialen Erfolg vortäuschen, unterstreicht diese Problematik zusätzlich. So wie manche Personen bei sportlichen Wettbewerben Schummeleien anwenden oder Erfolge fremdvermitteln lassen, könnte die geistige Arbeit mit KI-Produkten zum „die Gedanken anderer als eigene ausgeben“ führen.

Der Unterschied liegt aber darin, dass es bei Denkprozessen nicht nur um sozialen Status, sondern um die eigene Identität und Erkenntnisfähigkeit geht. Um diesen Herausforderungen zu begegnen, ist es essenziell, ein Bewusstsein für die Grenzen und Unterschiede zwischen menschlicher Kognition, KI-Verarbeitung und den Begriffen Halluzination, Bullshit und Konfabulation zu schaffen. Statt KI als reine Bedrohung oder als Allheilmittel zu sehen, sollten wir lernen, mit ihrer Eigenheit umzugehen und sie kritisch zu betrachten. KI-Systeme sind mächtige Werkzeuge, aber sie können nicht das menschliche Denken ersetzen, sondern höchstens ergänzen. Ein wichtiger Schritt besteht darin, die „Arbeit des Denkens“ wieder mehr zu würdigen.

Schreiben, Nachdenken und kritische Reflexion sollten nicht ausgelagert, sondern aktiv gepflegt werden. Bildungsinstitutionen und gesellschaftliche Diskurse müssen sich verstärkt mit der Frage beschäftigen, wie man den produktiven und reflektierten Umgang mit KI fördert, ohne dass dabei Authentizität und intellektuelle Integrität geopfert werden. Zusammenfassend lässt sich sagen, dass die populären Misserfolge von KI – die sogenannten Halluzinationen – eigentlich vielmehr konfabulative Konstruktionen sind, die kohärent, doch nicht zwangsweise wahr sind. Sie unterscheiden sich vom Bullshit, der auf Gleichgültigkeit gegenüber der Wahrheit basiert, und vom menschlichen Halluzinieren, das sensorische Erlebnisse umfasst. Das Wissen um diese Feinheiten kann uns helfen, nicht nur die Fähigkeiten und Grenzen der KI besser einzuschätzen, sondern auch unser eigenes Verhältnis zu Wissen, Überzeugungen und Selbstwahrnehmung kritisch zu hinterfragen.

Nur so vermeiden wir, dass wir in einer Welt der vorgegaukelten Wahrheiten und Selbsttäuschungen leben, sondern können KI als Hilfe zur Schärfung unseres eigenen Denkens nutzen.