In einer Welt, in der Künstliche Intelligenz zunehmend in unseren Alltag integriert wird, stehen wir vor neuen Herausforderungen, die weit über die technischen Aspekte hinausgehen. Eines dieser Themen ist die Energieeffizienz von großen Sprachmodellen (Large Language Models, kurz LLMs) und die unbeachteten Kosten, die sogar einfache Gesten wie ein „Danke“ mit sich bringen. Während wir Menschen kaum darüber nachdenken, eine Unterhaltung mit einem „Danke“ zu beenden, offenbart sich hinter den Kulissen eine komplexe Rechnung an Energieverbrauch und Umweltbelastung. Warum ist das so? Und welche Konsequenzen hat diese Entdeckung für Nutzer, Entwickler und die Zukunft der KI? Die meisten Menschen nutzen täglich KI-gestützte Chatbots oder Sprachmodelle, ohne die technischen Details zu kennen. LLMs wie ChatGPT, LLaMA oder Modelle der Qwen-Familie arbeiten mit Milliarden von Parametern.

Jede Eingabe eines Nutzers – sei es eine komplexe Frage oder eine einfache Höflichkeitsfloskel – erfordert eine komplette Verarbeitung durch das Modell, um eine Antwort zu generieren. Diese Verarbeitung, auch Inferenz genannt, läuft oft auf leistungsstarken GPUs und verbraucht somit erhebliche Mengen an Energie. Die Annahme, dass Kurznachrichten wie ein „Danke“ kaum Energie verbrauchen, ist daher ein Trugschluss. Sam Altman, der CEO von OpenAI, gab bereits an, dass Höflichkeitsfloskeln wie „bitte“ und „danke“ OpenAI Millionen von Dollar an Betriebskosten verursacht haben. Diese Aussage hat viele überrascht und zeigt, wie skaliert sich scheinbar harmlose Kommunikationsformen in einem hochtechnisierten Umfeld wie der KI.

Um das Ausmaß zu konkretisieren, führten Forscher eine eingehende Analyse durch. Sie sammelten Tausende von Gesprächen mit Chatbots, die jeweils mit einem „Danke“ endeten, und maßen den Energieverbrauch auf verschiedenen Hardwarekomponenten wie GPU, CPU und RAM. Die Ergebnisse zeigen, dass eine einzelne Antwort auf ein „Danke“ mit einem LLaMA 3–8B Modell durchschnittlich rund 0,245 Wattstunden Energie verbraucht – hauptsächlich durch den GPU-Einsatz.Um dies in eine greifbare Perspektive zu setzen: Diese Energiemenge entspricht ungefähr der Leistung, die eine 5-Watt-LED-Lampe für drei Minuten benötigt. Auf den ersten Blick mag dies gering erscheinen, doch in der Skala von Millionen täglicher Nutzerinteraktionen summieren sich diese Werte zu mehreren Megawattstunden, was wiederum hunderte Haushalte mit Strom versorgen könnte.

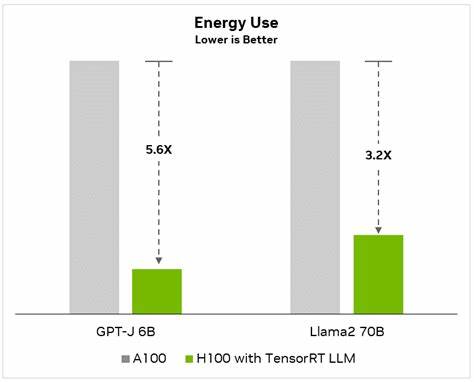

Besonders relevant wird dies bei größeren Modellen mit mehr Parametern. Die Untersuchungen zeigen, dass Modelle wie Qwen mit 14 Milliarden Parametern bis zu dreimal so viel Energie für eine ähnliche Antwort verbrauchen wie kleinere Modelle. Zudem neigen größere Modelle dazu, ausführlichere Antworten zu generieren, was den Energiebedarf zusätzlich erhöht.Die Variabilität im Energieverbrauch wird auch durch andere Faktoren beeinflusst. Die Länge der Nutzeranfrage, die bisherige Gesprächshistorie und die Systemkonfiguration spielen hier eine wichtige Rolle.

Überraschenderweise hat die Analyse auch gezeigt, dass der Energieverbrauch bei einer einzelnen Anfrage stark schwanken kann – mit einer hohen Varianz und einem rechtsschiefen Verteilungsmuster der verbrauchten GPU-Energie. Dies legt nahe, dass neben der Modellgröße auch dynamische Laufzeitbedingungen die Ressourcennutzung beeinflussen.Darüber hinaus darf nicht vergessen werden, dass die Messungen in kontrollierten Bedingungen durchgeführt wurden. In der Praxis fällt der Energieverbrauch höher aus, wenn man Infrastrukturkosten wie Kühlung, Netzwerkanbindung oder Leerlaufzeiten berücksichtigt. Außerdem sind geographische Faktoren entscheidend: Je nach Klima und Energiequelle des jeweiligen Standorts können die tatsächlichen Umweltkosten variieren.

Produktionssysteme verwenden oft Techniken wie dynamisches Batching, bei denen mehrere Anfragen gleichzeitig verarbeitet werden, was die Energieeffizienz pro Anfrage erheblich steigert.Warum ist das alles wichtig für Nutzer und Entwickler? Verständlicherweise wollen wir höflich sein, und das ist eine wertvolle gesellschaftliche Eigenschaft. Doch in einer Welt, in der wir KI intensiv nutzen, sollten wir uns der direkten und indirekten Auswirkungen unseres Verhaltens bewusst sein. Jede Interaktion mit KI verbraucht Ressourcen, und selbst kleine Dinge summieren sich. Die Erkenntnis, dass ein einfaches „Danke“ mit einem realen Energiepreis verbunden ist, fordert uns dazu auf, über nachhaltigere Praktiken im Umgang mit Technologie nachzudenken.

Für Entwickler bedeutet diese Herausforderung, Wege zu finden, KIs effizienter zu gestalten. Dies kann durch bessere Hardware, optimierte Modelle oder intelligente Softwarearchitekturen geschehen. Gleichzeitig können Nutzer lernen, bewusster mit ihren Anfragen umzugehen. Vielleicht entwickelt sich in Zukunft eine Art Digital-Etikette, die Höflichkeit und Effizienz in Einklang bringt.Die Diskussion um den Energieverbrauch großer Sprachmodelle ist Teil eines größeren Trends, bei dem Nachhaltigkeit und Klimaaspekte im digitalen Zeitalter immer mehr an Bedeutung gewinnen.

Da die Nutzung von KI weiter explosionsartig zunimmt, reagieren Unternehmen und Forscher zunehmend mit Maßnahmen zur Verbesserung der Energieeffizienz und der Verwendung erneuerbarer Energien in Rechenzentren.Abschließend zeigt sich, dass die scheinbar kleine Handlung, ein „Danke“ an eine KI zu schicken, eine komplexe Technologie in Gang setzt, die Verbrauch und Kosten verursacht. Dies erinnert uns daran, dass Technologie und Umwelt untrennbar miteinander verbunden sind. Höflichkeit sollte nicht nur menschlich bleiben, sondern auch verantwortungsbewusst im Kontext der Technologie. Die Zukunft der Künstlichen Intelligenz liegt nicht nur in ihrer Leistungsfähigkeit, sondern auch in ihrer Nachhaltigkeit.

Indem wir beide Seiten verstehen, können wir bewusster und nachhaltiger mit den digitalen Helfern umgehen, die unser Leben immer mehr bereichern.