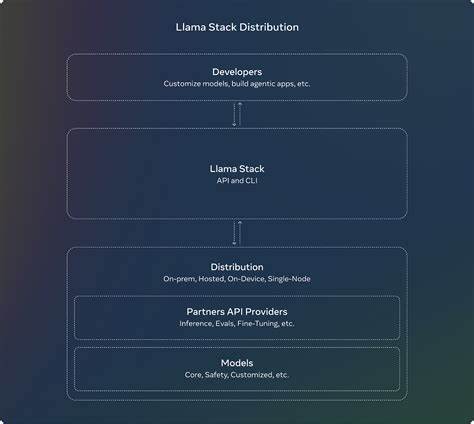

In der heutigen digitalen Welt gewinnen Chat-Anwendungen immer mehr an Bedeutung, da sie die direkte, schnelle und effiziente Kommunikation zwischen Menschen ermöglichen. Doch während viele auf Standardlösungen zurückgreifen, setzt die Entwicklung individueller Chat-Apps neue Maßstäbe hinsichtlich Flexibilität, Anpassbarkeit und technologischem Fortschritt. Ein besonders spannendes Beispiel ist die von Vibe entwickelte Chat-App, die modernste Technologien wie den Meta Llama-Stack und die MCP-Integration nutzt, um eine innovative Benutzererfahrung zu bieten. Die Grundlage dieser Chat-App bildet der Meta Llama-Stack, ein leistungsfähiges Framework, das speziell für die Verwaltung von großen Sprachmodellen (Large Language Models – LLMs) entwickelt wurde. Meta Llama-Stack ermöglicht es Entwicklern, komplexe KI-Modelle effizient zu steuern und nahtlos in Anwendungen zu integrieren.

Die Integration solcher Sprachmodelle erhöht die Interaktivität und Intelligenz der Chat-App erheblich, da sie auf natürliche Spracheingaben reagieren, Kontext verstehen und menschenähnliche Antworten generieren kann. Ein zentrales Element dieser Architektur ist die Nutzung von Ollama, einer Plattform, die für die Bereitstellung von Modellinferenz verantwortlich ist. Ollama sorgt dafür, dass die KI-Modelle mit hoher Leistung lokal oder cloudbasiert ausgeführt werden können. Für Anwender, die lieber auf cloudbasierte Dienste setzen möchten, besteht die Möglichkeit, den Together.ai API-Service zu verwenden, der ebenfalls in die Infrastruktur der Chat-App eingebunden ist.

Diese Flexibilität gewährleistet, dass unterschiedliche Nutzeranforderungen und Ressourcenkapazitäten abgedeckt werden können. Durch die Implementierung von MCP (Modular Chat Protocol) wird ein weiteres entscheidendes Standbein für die Funktionalität der Chat-App gelegt. MCP ist ein innovatives Protokoll, das den modularen und erweiterbaren Aufbau von Chat- und Kommunikationsdiensten unterstützt. Durch MCP-Integration kommunizieren verschiedene Module wie der Sprachmodell-Client, Tool-Handler und Suchdienste miteinander und ermöglichen dadurch eine hochgradig skalierbare und erweiterbare Plattform. Diese modulare Struktur sorgt dafür, dass neue Funktionen oder Dienste schnell und unkompliziert hinzugefügt werden können, was zukünftige Weiterentwicklungen erleichtert.

Die Chat-App stellt ihre Oberfläche mithilfe von Gradio bereit, einer benutzerfreundlichen Framework-Lösung, die es erlaubt, interaktive Machine-Learning-Modelle im Web anzuzeigen. Gradio erleichtert somit die Einbindung komplexer KI-Funktionalitäten in ein übersichtliches Frontend und stellt sicher, dass Nutzer ohne technische Vorkenntnisse direkt von den Funktionen profitieren können. Die App ist damit nicht nur leistungsfähig, sondern auch zugänglich und intuitiv bedienbar. Besonders hervorzuheben ist die Möglichkeit, die Chat-App sowohl lokal mit dem Ollama-Service als auch über die Together.ai Cloud zu betreiben.

Dies bietet sowohl Entwicklern als auch Organisationen vielfältige Optionen je nach Sicherheitsanforderungen, Kostenbudget und technischer Infrastruktur. Die Installation des Systems folgt einem klar strukturierten Prozess, der die Einrichtung des virtuellen Python-Umfelds, die Nutzung des uv-Paketmanagers und die Konfiguration der Umgebungsvariablen beinhaltet. Für Entwickler ergeben sich dadurch hervorragende Voraussetzungen, das Projekt schnell starten und an ihre Bedürfnisse anpassen zu können. Die Kombination der leistungsfähigen Meta Llama-Modelle mit der Multiprotokoll-Funktionalität von MCP eröffnet neue Möglichkeiten für den Einsatz von Chatbots im Kundenservice, in interaktiven Lernumgebungen oder sogar in komplexeren Anwendungen wie Beratungssystemen oder digitalen Assistenten. Da die Chat-App auf Open-Source-Technologien aufbaut, lässt sie sich flexibel erweitern und in bestehende IT-Infrastrukturen integrieren.

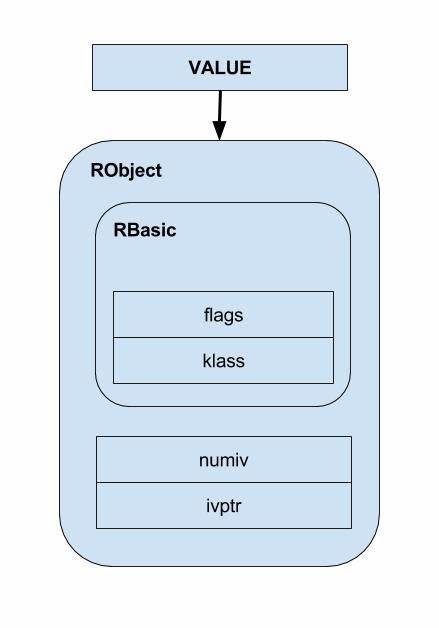

Dies schafft eine attraktive Alternative zu proprietären Lösungen, die häufig durch feste Funktionen und Lizenzbedingungen eingeschränkt sind. Technologisch gesehen basiert der Meta Llama-Stack auf modernsten Fortschritten im Bereich der KI-Modellverwaltung. Große Sprachmodelle wie LLaMA (Large Language Model Meta AI) haben das Potenzial, natürliche Sprache auf einem Niveau zu verarbeiten, das bisher nur bei menschlicher Kommunikation möglich war. Diese Modelle basieren auf tiefen neuronalen Netzen und maschinellem Lernen, mit denen die Chat-App kontextbezogene Antworten generiert, Stimmungen erkennt und sogar mehrschichtige Dialoge führt. Insbesondere der Einsatz von Meta Llama-Stack sorgt für eine effiziente Nutzung der Rechenressourcen, da Modelle sowohl lokal als auch über Cloud-Ressourcen flexibel orchestriert werden können.

Dabei spielt auch das MCP-Protokoll eine wichtige Rolle, da es den Informationsaustausch verschiedener Module und Services in der Chat-App regelt. MCP sichert eine offene, modulare Kommunikation, weckt Potenzial für die Integration von Drittanbieter-Diensten und ermöglicht so eine kontinuierliche Erweiterung der Chat-Funktionalität. Der modulare Aufbau verbessert die Wartbarkeit und lässt Raum für innovative Features wie kontextbasierte Suchanfragen, dynamische Werkzeuge zur Datenanalyse oder automatisierte Workflows. Die Entwicklung einer solchen Chat-App spricht technisch versierte Anwender ebenso an wie Unternehmen, die eine individuell anpassbare Kommunikationslösung suchen. Sie profitieren von einer Plattform, die auf modernster KI- und Protokolltechnik basiert und dennoch übersichtlich, benutzerfreundlich und leicht skalierbar ist.

Die Möglichkeit, das System mit wenigen Handgriffen einzurichten und zu erweitern, macht es auch für Kleinst- und Mittelstandsunternehmen attraktiv. Insgesamt zeigt die Kombination aus Meta Llama-Stack und MCP in einer Chat-Anwendung, wie innovative Technologien im Bereich der KI-gestützten Kommunikation zunehmend an Bedeutung gewinnen. Solche Systeme sind wegweisend für die Zukunft, in der intelligente Anwendungen nicht nur auf einfache Text- oder Sprachinteraktionen reduziert sind, sondern tief ins Nutzerverhalten eingebunden werden, um maßgeschneiderte und effiziente Lösungen zu bieten. Für Entwickler bietet die Open-Source-Natur dieser Chat-App zudem Chancen, aktiv an der Community teilzuhaben, neue Ideen umzusetzen und von anderen Beiträgen zu profitieren. Die Nutzung von Tools wie Gradio erleichtert hybrid-technische Zugänge und erhöht die Zugänglichkeit für Anwender aller Erfahrungsstufen.

Dies ist besonders wichtig, um die Hürde zur Nutzung moderner KI-Technologie niedrig zu halten und Innovationskraft zu fördern. Zusammenfassend lässt sich sagen, dass die von Vibe entwickelte Chat-App mit Meta Llama-Stack und MCP-Integration ein Paradebeispiel für die Verschmelzung von künstlicher Intelligenz, modularer Softwarearchitektur und nutzerorientiertem Design ist. Sie demonstriert eindrucksvoll, wie technische Expertise und moderne Frameworks genutzt werden können, um flexibel anpassbare und zukunftssichere digitale Kommunikationslösungen zu schaffen. Mit solch einem System sind die Voraussetzungen für die nächste Generation von interaktiven Chat-Anwendungen gelegt – leistungsfähig, intuitiv und vielseitig einsetzbar.