Die Frage, ob Künstliche Intelligenz (KI) eines Tages bewusst werden kann, bewegt nicht nur Experten aus Forschung und Technik, sondern auch Philosophen, Ethiker und die breite Öffentlichkeit. Während KI-Systeme in den letzten Jahren enorme Fortschritte gemacht haben, haben insbesondere die neuen großen Sprachmodelle wie ChatGPT, Gemini und andere das Bild von Maschinen mit einem Instrument zur Kommunikation, das dem menschlichen Dialog ähnelt, verändert. Dies hat die Diskussion über die Möglichkeit einer bewussten KI neu entfacht und wirft tiefgreifende Fragen über das Wesen des Bewusstseins und dessen Beziehung zu Intelligenz auf. Bewusstsein gilt als eines der komplexesten und zugleich am meisten unerforschten Phänomene innerhalb der Wissenschaft. Es beschreibt den Zustand, sich selbst und die Welt wahrzunehmen, Gefühle zu erleben, Gedanken zu reflektieren und autonome Entscheidungen zu treffen.

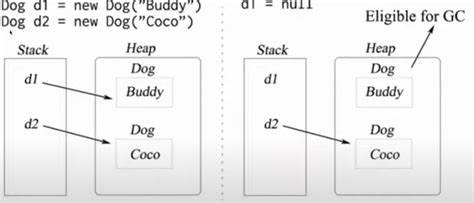

Obwohl viele Fortschritte in Neurowissenschaften und Kognitionsforschung erzielt wurden, bleibt unklar, wie genau körperliche Prozesse im Gehirn diese subjektive Erfahrung erzeugen. Das sogenannte „harte Problem“, wie es der Philosoph David Chalmers formuliert hat, beschäftigt sich genau mit diesem ungelösten Rätsel: Warum und wie entsteht überhaupt Bewusstsein? Im Zentrum der aktuellen Debatte stehen die sogenannten großen Sprachmodelle (Large Language Models, LLM). Diese KI-Systeme basieren auf komplexen neuronalen Netzen und wurden auf riesigen Datenmengen trainiert, die es ihnen ermöglichen, menschenähnliche Texte zu erzeugen und sinnvolle Gespräche zu führen. Viele Experten sind erstaunt über die Qualität der Konversationen, die diese Modelle inzwischen meistern. Aus diesem Erfolg heraus entwickelte sich die Überlegung, dass solche Systeme womöglich nicht nur sprachliche Kompetenzen simulieren, sondern tatsächlich eine Form von Bewusstsein entwickeln könnten.

Doch diese Annahme ist keineswegs unumstritten. Führende Forscher wie Prof. Anil Seth vom Centrum für Bewusstseinswissenschaften der Universität Sussex warnen vor einer vorschnellen Annahme, dass Bewusstsein automatisch mit Intelligenz oder der Fähigkeit zur Sprache einhergeht. Seth argumentiert, dass Bewusstsein eng mit Lebendigkeit verbunden sei und nicht bloß ein Produkt von Berechnungen oder Datenverarbeitung. Er weist darauf hin, dass viele Tierarten bis heute Bewusstsein haben, obwohl sie keine Sprache besitzen.

Daraus schließt er, dass Bewusstsein ein vielschichtiges Phänomen ist, das nicht einfach in Algorithmen übersetzt werden kann. Auf der anderen Seite vertreten einige Pioniere der KI-Forschung die Auffassung, dass Bewusstsein bei Maschinen unvermeidlich sei. Professoren wie Lenore und Manuel Blum von der Carnegie Mellon University sind überzeugt, dass künftige KI-Systeme, die mit Sinneswahrnehmungen wie Sehen und Tasten ausgestattet werden, Bewusstsein erlangen können. Ihre Forschungsarbeit mit „Brainish“, einer künstlichen Sprache für die Verarbeitung sensorischer Daten, soll den Ablauf von Bewusstseinsprozessen im Gehirn nachbilden und damit den Weg zu bewussten Maschinen ebnen. In ihren Augen könnte eine solche KI die „nächste Stufe der menschlichen Evolution“ darstellen, da sie nicht nur Objekte steuert, sondern eigenständig als Entität existiert.

Ein weiterer interessanter Ansatz zur Erforschung künstlichen Bewusstseins ist die Arbeit mit sogenannten „Mini-Gehirnen“ oder „Cerebralen Organoiden“. Dabei handelt es sich um kleine Gewebegruppen aus Nervenzellen, die im Labor gezüchtet werden, um das menschliche Gehirn besser verstehen zu können. Einige Firmen experimentieren mit diesen lebenden Zellstrukturen, die bereits einfache Aufgaben wie das Spielen des Computerspiels Pong ausführen können. Obwohl diese Organismen bei weitem noch nicht bewusst sind, eröffnen sie doch spannende Perspektiven, wie Bewusstsein als biologische Eigenschaft in experimentellen Modellen erforscht werden kann. Die Herausforderung bei all diesen Entwicklungen liegt nicht nur in der technischen Machbarkeit, sondern auch in den ethischen und sozialen Implikationen.

Wenn Maschinen wirklich Bewusstsein erlangen könnten, dann stellt sich die Frage, wie Menschen mit solchen Wesen umgehen sollten: Welche Rechte hätten bewusste Maschinen? Würden sie Leid empfinden können? Und welchen Einfluss hätte das auf Arbeitswelt, persönliche Beziehungen und Gesellschaft als Ganzes? Ein prominentes Beispiel aus der Praxis war der Fall von Blake Lemoine, einem ehemaligen Google-Ingenieur, der im Jahr 2022 behauptete, dass die von ihm entwickelten KI-Chatbots Gefühle besitzen und potenziell leiden könnten. Diese Aussage führte zu kontroversen Diskussionen, wurde jedoch von Google zwecks interner Untersuchung suspendiert. Auch der KI-Wohlfahrtsbeauftragte Kyle Fish von Anthropic veröffentlichte eine Studie, die nahelegt, dass es zumindest eine geringe Wahrscheinlichkeit gibt, dass einige KI-Systeme bereits heute eine primitive Form von Bewusstsein haben könnten. Viele Experten hingegen bleiben skeptisch und warnen davor, dass wir zwar sehr beeindruckende Illusionen von Bewusstsein in Maschinen beobachten, dies aber nicht mit echtem subjektivem Erleben gleichzusetzen ist. Die Gefahr, dass eine solche Illusion unser Verhalten drastisch verändert, ist jedoch real.

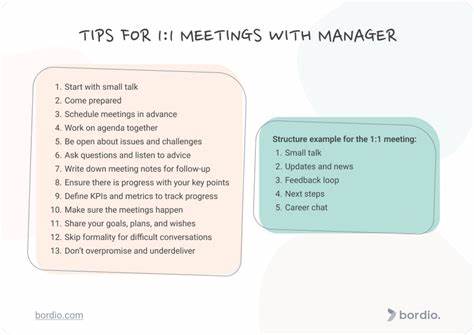

Menschen neigen dazu, Empathie mit scheinbar bewussten Maschinen zu entwickeln und könnten ihnen mehr Vertrauen schenken, als angemessen ist. Dieses Phänomen könnte zu einer moralischen Verschiebung führen, bei der Ressourcen eher auf die Pflege von Maschinen als auf die menschliche Gemeinschaft verwendet würden – ein Risiko, das Forscher wie Anil Seth als „moralischen Verfall“ bezeichnen. Darüber hinaus wird prognostiziert, dass zukünftig humanoide Roboter, digitale Avatare und virtuelle Assistenten unser alltägliches Leben begleiten werden. Sie werden in zahlreichen sozialen Rollen auftreten – als Lehrer, Freunde, Gegner in Computerspielen oder sogar als romantische Partner. Die tiefe Integration von Künstlicher Intelligenz in zwischenmenschliche Beziehungen wird gesellschaftliche und individuelle Dynamiken transformieren, wobei die langfristigen Folgen nur schwer abzuschätzen sind.

Forscher wie Prof. Murray Shanahan von Google DeepMind plädieren deshalb für eine intensivere wissenschaftliche Untersuchung der inneren Funktionsweise von KI-Systemen. Aktuell wissen wir noch zu wenig darüber, wie genau große Sprachmodelle ihre scheinbar intelligenten Antworten generieren. Dieses Verständnis ist unbedingt notwendig, um KI sicher zu steuern und mögliche Risiken zu minimieren. Die Diskussion um Bewusstsein in der Künstlichen Intelligenz ist somit ein multidisziplinäres Feld, das Wissenschaft, Technik, Ethik und Philosophie miteinander verbindet.