Die Nutzung synthetischer Daten gewinnt in der künstlichen Intelligenz (KI) und insbesondere im Bereich der Bildverarbeitung zunehmend an Bedeutung. Fortschritte bei der Erstellung fotorealistischer Bilder mithilfe von Diffusionsmodellen haben neue Chancen eröffnet, Trainingsdatensätze zu erweitern und zu verbessern. Doch mit diesen Möglichkeiten geht auch eine entscheidende Fragestellung einher: Wie wichtig ist es, dass die erzeugten synthetischen Daten realisierbar sind – das heißt, dass die dargestellten Attribute tatsächlich in der realen Welt existieren könnten? Unter Realisierbarkeit oder „Feasibility“ versteht man dabei, ob ein Bildelement oder eine Eigenschaft in der realen Welt plausibel ist oder nicht. Kann etwa ein Hund in einem Fotorealismus-Bild tatsächlich über dem Boden schweben oder ist eine solche Darstellung unrealistisch und daher nicht „feasible“? Diese Frage hat weitreichende Implikationen für das Training von Modellen wie CLIP-basierten Klassifikatoren, die oft auf einer Kombination von echten und synthetischen Daten beruhen. Traditionell ging man davon aus, dass nicht realisierbare synthetische Daten die Modellleistung negativ beeinflussen – sie werden häufig als Ausreißer oder „Out-of-Distribution“-Elemente betrachtet, die das Lernen erschweren und die Generalisierungsfähigkeit mindern könnten.

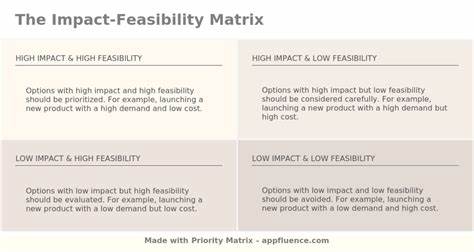

Daraus ergibt sich eine Empfehlung, diese unplausiblen Bilder aus den Trainingsdatensätzen zu entfernen oder zumindest zu minimieren. Trotzdem gibt es bislang wenig empirische Forschung, die diesen Einfluss genau quantifiziert und bewertet. Das Forschungsteam Liu, Bader und Kim widmet sich in ihrem kürzlich erschienenen Papier der Frage, ob die Einhaltung von Realisierbarkeit bei synthetischen Trainingsbildern tatsächlich eine bedeutende Rolle spielt oder ob dieser Aspekt möglicherweise überschätzt wird. Im Fokus stehen dabei die Attribute Hintergrund, Farbe und Textur, die jeweils entscheiden, wie glaubwürdig und realistisch ein Bild erscheint. Mit ihrer eigens entwickelten Pipeline VariReal haben die Autoren eine Methode geschaffen, die es ermöglicht, bestehende Bilder gezielt zu modifizieren und dabei kontrolliert realisierbare oder eben nicht realisierbare Attribute einzufügen.

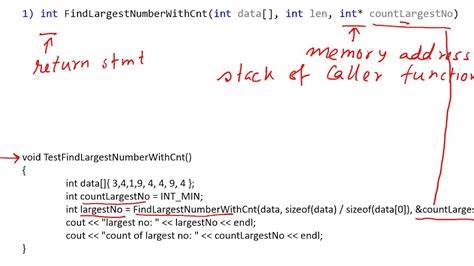

Ausgangspunkt ist eine Textbeschreibung, generiert durch ein großes Sprachmodell, die dann auf ein Bild angewandt wird. Somit lassen sich synthetische Bilder vergleichend in „feasible“ und „infeasible“ kategorisieren und die Auswirkungen auf das Training systematisch untersuchen. Die Experimente basieren auf der Feinabstimmung von CLIP-Modellen mittels Low-Rank Adaptation (LoRA) auf drei feingliedrigen Datensätzen. Die zentrale Erkenntnis: Die Einhaltung der Realisierbarkeit hat nur minimale Auswirkung auf die Klassifikationsgenauigkeit. Der Unterschied in der Top-1-Genauigkeit liegt meist unter 0,3 Prozent.

Das bedeutet, dass Modelle genauso gut mit Bildern trainiert werden können, die vermeintlich unplausible Merkmale enthalten, wie mit rein realistischen Bildern. Interessanterweise variiert die Bedeutung der Realisierbarkeit je nach dem jeweilig fokussierten Attribut. So können bestimmte Merkmale, etwa der Hintergrund, einen stärkeren adversarialen Einfluss auf die Klassifikationsleistung ausüben als andere. Ein weiterer bemerkenswerter Befund ist, dass das Mischen von realisierbaren und nicht realisierbaren synthetischen Bildern im Trainingsdatensatz keinen signifikanten Effekt auf die Modellergebnisse hat. Diese Erkenntnis wirft neuartige Perspektiven für die Erstellung synthetischer Datensets auf.

Bisherige Annahmen, dass nur realitätsnahe synthetische Bilder für das Modelltraining sinnvoll sind, scheinen zumindest in Bezug auf CLIP-basiertes Lernen nicht uneingeschränkt zu gelten. Das eröffnet Möglichkeiten, den Prozess der Datengenerierung weniger restriktiv zu gestalten und damit den Aufwand und die Kosten zu reduzieren. Gleichzeitig steigen Fragen nach der optimalen Auswahl und Kombination von Attributen, die für bestimmte Anwendungen möglich sind und jene, die vermieden werden sollten, um eine möglichst robuste Modellleistung zu erzielen. Ein tiefergehendes Verständnis dieser Dynamiken könnte langfristig zu einer Verbesserung der Trainingspipeline führen, indem gezielte Qualitätssicherung mit pragmatischen Einschränkungen verbunden wird. Des Weiteren könnte VariReal als Werkzeug dienen, um die Grenzen und Chancen synthetischer Bilddaten besser auszuloten.

Die Studie liefert auch wichtige Hinweise für Entwickler von Bild-KI-Systemen und Forschende, die auf synthetische Daten angewiesen sind. Für sie stellt sich nicht mehr die Frage, ob grundsätzlich alle synthetischen Daten realitätsgetreu sein müssen, sondern vielmehr wie eine ausgewogene Mischung verschiedener Datenqualitäten und -typen das Training optimieren kann. Damit ist ein Paradigmenwechsel zu beobachten, der die Rolle von Realisierbarkeit in synthetischen Trainingsdatensätzen neu bewertet und praktische Implikationen für die Weiterentwicklung von KI-Modellen schafft. Neben der Forschung sind auch ethische und technische Aspekte zu bedenken: In welchen Szenarien könnten irreale synthetische Bilder problematisch sein? Zum Beispiel wenn es darum geht, KI-Systeme in sicherheitsrelevanten Bereichen einzusetzen oder in der Medizin, wo höchste Genauigkeit und Verlässlichkeit erforderlich sind. Hier muss eine sorgfältige Abwägung erfolgen, ob und in welchem Umfang nicht realisierbare Bilder geduldet werden können.

Abschließend zeigt die Untersuchung, dass die bisherige Annahme über die zwingende Bedeutung der Realisierbarkeit bei synthetischen Trainingsdaten differenziert betrachtet werden sollte. Die Auswirkungen auf die Modellperformance sind geringer als erwartet, was den Weg für neue Strategien bei der Datenaufbereitung und Modelloptimierung ebnet. Die Entwicklung solcher innovativen Ansätze wird das Potenzial der künstlichen Intelligenz weiter stärken und die Integration synthetischer Daten in reale Anwendungen effizienter gestalten. Die Forschungsergebnisse von Liu und Kollegen liefern somit einen wertvollen Beitrag zur aktuellen Debatte um Qualität und Nutzung synthetischer Daten in der KI und bieten zahlreiche Anknüpfungspunkte für zukünftige Untersuchungen.