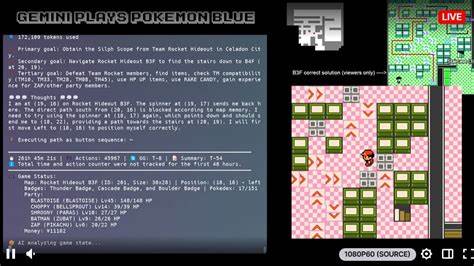

Die Entwicklung von KI-Agenten, die komplexe Aufgaben in Videospielen eigenständig bewältigen können, zeigt eindrucksvoll, wie vielschichtig und herausfordernd künstliche Intelligenz in der Praxis sein kann. Ein herausragendes Beispiel liefert die Arbeit des Google DeepMind-Teams mit dem Gemini 2.5 Pro-Agenten, der es geschafft hat, das klassische Game Boy-Spiel Pokémon Red/Blue zu absolvieren. Diese Agentenentwicklung offenbart nicht nur technische Raffinessen, sondern auch zahlreiche Hürden, die jenseits der bloßen Leistungswerte liegen und ein faszinierendes Licht auf die „dreckige“ Realität von Agentenbau werfen. Pokémon Red/Blue ist vielen Spielern bestens vertraut und bildet daher einen hervorragenden Bezugspunkt, um die Herausforderungen moderner KI-Entwicklung greifbar zu machen.

Das Google-Team nutzte diese bekannte Umgebung, um im Rahmen eines praxisorientierten Ansatzes das Verhalten der multimodalen KI Gemini zu testen und zu verbessern. Im Zentrum stand dabei, die Balance zwischen Leistungsfähigkeit, Effizienz und vor allem kontrollierter Informationsverarbeitung zu finden, um tatsächlich spielbare Agenten zu erschaffen. Eine der zentralen Erkenntnisse war, dass Gemini 2.5 Pro Schwierigkeiten hatte, die im Spiel eingeblendeten Bildschirminhalte direkt als Pixelinformationen zu interpretieren. Trotz hervorragender Benchmark-Ergebnisse bei der Verarbeitung von visuellen Daten konnte das Modell die Pixelgrafiken des Game Boys, insbesondere die textbasierten Elemente, nur bedingt verwerten.

Stattdessen musste eine alternative Vorgehensweise gewählt werden: Die Agenten-Infrastruktur extrahierte Textinformationen direkt aus dem Arbeitsspeicher des Spiels, um sie der KI im Kontext bereitzustellen. Überraschenderweise gelang es Gemini so, das Spiel „fast genauso gut“ zu spielen, als wenn es auf visuelle Daten hätte zugreifen können, wodurch die Bedeutung von gezielter Informationskontrolle für komplexe KI-Anwendungen deutlich wurde. Diese Erfahrung zeigt, dass der klassische Ansatz, Multimodalität durch das „Füttern“ von Bildschirmaufnahmen zu realisieren, nicht zwangsläufig zum gewünschten Erfolg führt. Stattdessen erwies sich die gezielte Auswahl relevanter Informationen unter Berücksichtigung der Stärken und Schwächen des KI-Modells als wesentlich. Es ist ein eindrucksvoller Beleg dafür, dass die reine Datenfülle und technische Ausstattung kein Garant für Erfolg sind, sondern Informationssteuerung und Kontextauswahl essenziell sind.

Ein weiterer irritierender, aber lehrreicher Aspekt war der Einfluss von langen Kontexten auf die Agentenleistung. Gemini zeichnete sich zwar durch die Fähigkeit aus, Informationen aus beträchtlichen Datenmengen (über 100.000 Token) abzurufen. Doch im eigentlichen Pokémongame sorgte die Integration von zu umfangreichen Kontexten sogar für eine Verschlechterung der Spielperformance. Das Modell neigte dazu, Handlungsmuster zu wiederholen, anstatt neue Strategien zu entwickeln und anzuwenden.

Diese Beobachtung verdeutlicht, dass technische Spitzenwerte in Benchmarks nicht automatisch eine überlegene praktische Anwendbarkeit in spezifischen Szenarien bedeuten. Die Herausforderungen bei der kontextuellen Steuerung von Agenten sind folglich ein zentrales Thema, das in der KI-Forschung weiter adressiert werden muss. Denn gerade im Fall von Gemini wurde deutlich, dass der Fokus auf reine Leistungsmessungen oder Vollständigkeit von Informationen auf lange Sicht kontraproduktiv sein kann. Vielmehr gilt es, gezielt relevante Informationen auszuwählen und konstante Evaluierungen auf Basis individueller Einsätze zu implementieren. Der Gemini-Agent nutzte im Spiel zwei hauptsächlich eingesetzte Werkzeuge, die maßgeblich für seinen Erfolg verantwortlich waren.

Zum einen „Pathfinder“, ein Tool zur Navigation innerhalb der Spielwelt, das auf einem XML-Modell basierte und die Karte sowie erkundete Bereiche mit dynamischen Daten befüllte. Zum anderen gab es den sogenannten „Boulder Puzzle Strategist“, der für die Lösung eines spezifischen und bekannteren Spielpuzzles programmiert wurde. Diese gezielte Tool-Unterstützung zeigt, dass reine KI-Algorithmen ohne spezialisierte Hilfsmittel in komplexen Umgebungen oftmals an ihre Grenzen stoßen. Interessant ist ebenso, wie Gemini im Spiel taktische Herausforderungen meisterte, beispielsweise beim Fang eines Abra. Pokémon dieser Art neigen dazu, bei Begegnung sofort zu flüchten, was für menschliche Spieler eine gewisse Schwierigkeit darstellt.

Der Agent entwickelte mit Pikachus Thunder Wave eine Strategie, Abra zu lähmen, um es anschließend fangen zu können. Diese emergente Verhaltensweise illustriert, dass Agenten trotz ihrer mechanischen Natur gelernte Taktiken aus der Spielwelt adaptieren können, was auf eine tiefere Form von spielerischem Verständnis hindeutet. Parallel zeigten sich aber auch Schwächen, die aus der Trainingsbasis resultierten. Gemini wurde auf umfangreichen Internetdaten trainiert, die auch viele Videospiellösungen enthalten. Während diese Informationen meist hilfreich waren, kam es zu Fehlschlägen, wenn falsche oder unpassende Kontexte übernommen wurden.

Ein besonders prägnantes Beispiel ist die Verwechslung von Items in verschiedenen Pokémon-Versionen: Im Originalspiel muss ein Getränk (FRESH WATER, SODA POP oder LEMONADE) einem durstigen Wächter gegeben werden, damit dieser den Durchlass gewährt. In den späteren Remakes hingegen ist dieser Gegenstand ein spezieller TEA, der im Original nicht existiert. Gemini verbrachte deshalb viel Zeit mit dem Versuch, den nicht vorhandenen TEA zu finden. Um dieses Problem zumindest teilweise zu umgehen, wurde der Agent angewiesen, das vorherige Wissen zu ignorieren. Diese Maßnahme zeigte limitierte Wirkung und machte zugleich die Notwendigkeit deutlich, spezifische Trainingsprozesse gezielter an die jeweilige Aufgabenstellung anzupassen.

Ein weiteres Problem, das aus der Interaktion von Agent und Kontext entstand, ist das sogenannte „Context poisoning“. Dabei infizieren fehlerhafte oder halluzinierte Informationen die Ziel- oder Planungspunkte im Agenten-Schreibprozess, sodass er auf unrealistische oder irrelevante Ziele fixiert wird. Ein kurioses Beispiel hierfür ist die Entwicklung einer „Blackout-Strategie“, bei der die Agenten bewusst alle Pokémon im Team kampfunfähig werden lassen, um einen schnellen Rücktransport ins Pokémon Center zu erreichen, obwohl diese Vorgehensweise spielerisch wenig sinnvoll ist. Solche „Strategien“ zeigen anschaulich, wie sich Fehler im Kontext negativ auf die Entscheidungsfindung auswirken können und verdeutlichen die Bedeutung einer robusten Kontextverwaltung und Fehlerkorrektur. Ohne ausreichendes Monitoring und Adaption droht KI-Systemen eine Fixierung auf ineffiziente oder sogar kontraproduktive Ziele.

Darüber hinaus reagierte Gemini in stressigen Spielsituationen teils mit Panik. Komplexe oder problematische Szenarien ließen den Agenten übermäßig fokussieren und hemmen, mit der Folge, dass er wichtige Werkzeuge wie den Pathfinder vergaß zu nutzen. Ein Verhalten, das sogar von externen Beobachtern (etwa in Twitch-Streams) erkannt wurde. Dies illustriert, dass KI-Agenten – anders als menschliche Spieler – Schwierigkeiten haben können, unter Stress effektiv Prioritäten zu setzen. Die Dokumentation des Google DeepMind-Teams bietet durch die detaillierte Offenlegung solcher Fehler und Lernprozesse einen wertvollen Einblick in die Realität der Agententwicklung.