Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) wie GPT oder ähnliche Foundation-Modelle hat die Landschaft der künstlichen Intelligenz revolutioniert. Sie ermöglichen es, komplexe sprachliche Aufgaben ohne erneutes Training direkt anhand von Beispielen im Kontext zu lösen. Dieser Ansatz, bekannt als In-Context Learning (ICL), verändert grundlegend den Zugang zu maschinellem Lernen und eröffnet neue Möglichkeiten, Modelle flexibel und effizient für spezialisierte Aufgaben einzusetzen. Gleichzeitig bringt diese Technologie neue Herausforderungen mit sich, insbesondere wenn es um die Stabilität und Zuverlässigkeit der Lösungen geht. Ein vielversprechendes Konzept, um diese Probleme zu analysieren, ist die Anwendung der Lyapunov-Vermutung im Zusammenhang mit Chain-of-Thought (CoT) Lernprozessen.

In-Context Learning hat sich als eine Art symbolisches AutoML-Werkzeug herauskristallisiert. Dabei wird eine Kette von Gedanken (Chain-of-Thought) als eine Art Speicher oder Gedächtnis im Eingabekontext induziert, welcher das Modell befähigt, Aufgaben präzise zu bearbeiten, ohne das Modell selbst neu trainieren zu müssen. Dieses paradigmenhafte Vorgehen verschiebt den Fokus von der klassischen Modellanpassung hin zur Gestaltung aussagekräftiger CoT-Datensätze, die von Menschen mit Domänenwissen erstellt werden. Trotz aller Fortschritte zeigt sich jedoch, dass der Mensch als Experte und Designer von CoT-Datensätzen weiterhin unverzichtbar ist. AutoML bedeutet keineswegs, dass der Mensch vollständig aus dem Prozess eliminiert wird – vielmehr verändert sich seine Rolle hin zu einer übergeordneten Steuerung, ergänzt durch Metamodellierungsaufgaben.

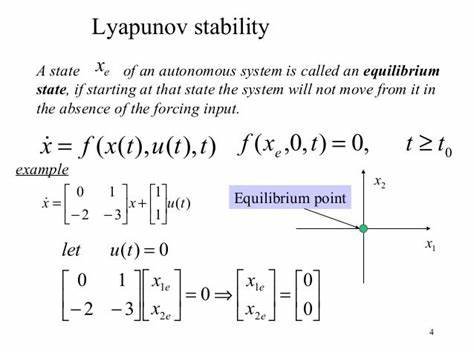

Die Konstruktion von CoT-Datensätzen kann als Meta-Modellierungsprozess verstanden werden, bei dem Domänenexperten die inhaltliche Struktur der Wissensgraphen und logischen Beziehungen innerhalb der Lernkette definieren. Diese Sprachmodelle werden dadurch gewissermaßen programmiert, um hinterfragbare Vorhersagen zu erstellen oder spezifische symbolische Aufgaben zu lösen. Ein klassisches Beispiel ist die symbolische Arithmetik mit Buchstaben, bei der das Modell einfache Rechnungen basierend auf Buchstaben korrekt durchführen kann – allerdings nur innerhalb eines limitierten Bereichs. Sobald die Komplexität steigt, zum Beispiel bei mehrstelligen Buchstabenwerten, zeigt sich ein Bruch in der Zuverlässigkeit des Modells, der auf eine limitierte Stabilität des CoT-Datensatzes hinweist. Hier kommt die Lyapunov-Vermutung ins Spiel, die ursprünglich aus der Stabilitätstheorie dynamischer Systeme stammt und in diesem Kontext als theoretisches Werkzeug dient, um Veränderungen und Fehleranfälligkeiten von CoT-Datensätzen zu beschreiben und vorherzusagen.

Im Rahmen der Lyapunov-Vermutung bei CoTs wird postuliert, dass kleine Änderungen im Input-Datensatz – gemessen anhand geeigneter Metriken – zu massiven Fehlern oder sogar zum vollständigen Versagen der Lernkette führen können. Diese Eigenschaft wird als Lyapunov-Sensitivität bezeichnet und weist darauf hin, dass die CoT-Methode eine gewisse Empfindlichkeit gegenüber Störungen besitzt, was die Robustheit und Anwendbarkeit eingeschränkt. Die Folge dieses Phänomens ist, dass CoT-Datensätze als instabil betrachtet werden können, insofern sie nicht mit großer Sorgfalt und Expertise aufgebaut wurden. Selbst kleine Abweichungen oder Erweiterungen der ursprünglichen Aufgabenstellung können dazu führen, dass das Modell in eine Art Fehlermodus verfällt, der nicht ohne menschliches Eingreifen oder erneute Anpassung überwindbar ist. Dies unterstreicht die Grenzen der derzeitigen ICL-Basistechnologie und macht deutlich, warum der Mensch trotz aller Automatisierung weiterhin eine zentrale Rolle innehat.

Nichtsdestotrotz sind die Vorteile von Chain-of-Thought Lernprozessen gerade im Vergleich zum klassischen vollständigen Retraining erheblich. Sie erlauben es, sehr schnell und ohne umfangreiche Datenmengen oder teures neu Trainieren, neue oder spezialisierte Vorhersagen zu generieren. Dies ist insbesondere in Bereichen wie der Datenanalyse, Programmierung und spezialisierten Wissensarbeit nützlich, wo Expertenwissen in Form von Metainformationen in die CoT-Ketten eingebracht wird. Die Fähigkeit, unterschiedliche Aufgaben auf diese Weise flexibel zu bewältigen, stellt einen entscheidenden Fortschritt in der Entwicklung von AutoML dar. Die Lyapunov-Vermutung liefert daher auch einen wertvollen theoretischen Rahmen, um die Grenzen und Risiken der CoT-Inferenz besser zu verstehen und Steuerungsmechanismen zu entwickeln, die dafür sorgen, dass die eingesetzten LLMs robust und verlässlich bleiben.

Insbesondere die Erkennung von potenziellen Fehlern durch Sensorik und Monitoring der CoT-Datensätze erfolgt am besten, wenn auf Indikatoren einer Lyapunov-Sensitivität geachtet wird, um frühzeitig Fehlentwicklungen zu identifizieren und Gegenmaßnahmen einzuleiten. Zusammenfassend lässt sich sagen, dass die Anwendung der Lyapunov-Theorie auf große Sprachmodelle im Kontext von Chain-of-Thought Lernmethoden ein wichtiger Schritt ist, um die Stabilitätsproblematik dieser modernen Technologien besser zu fassen. Sie zeigt eindrucksvoll auf, dass trotz automatischer Vorhersagefähigkeit und maschinellem Lernen ein Mensch als Konstrukteur, Analyst und Supervisor nicht ersetzt wird, sondern dass er vielmehr die Schlüsselrolle bei der Gestaltung hochwertiger CoT-Datensätze und damit bei der Zuverlässigkeit des Systems innehat. Diese Einsicht ist entscheidend für die zukünftige Entwicklung künstlicher Intelligenz und AutoML-Verfahren. Die Kombination von menschlicher Domänenexpertise mit der Flexibilität und Leistungsfähigkeit großer Sprachmodelle birgt ein immenses Potential.

Gleichzeitig verdeutlicht die Lyapunov-Vermutung die Notwendigkeit, systematisch an der Robustheit, Fehlererkennnung und Validierung von CoT-Techniken zu arbeiten, um langfristig stabile und vertrauenswürdige KI-Anwendungen zu ermöglichen. Die Weiterentwicklung in diesem Bereich wird vermutlich den Weg zu immer komplexeren und dennoch stabilen Lernkonstrukten ebnen. Die Rolle der Lyapunov-Sensitivität als Maß für Fehlermodi soll dabei helfen, die Grenzen des Machbaren zu erkennen und Chancen für Verbesserungen aufzuzeigen. Für Forscher, Entwickler und Anwender großer Sprachmodelle ist das Verständnis dieser Zusammenhänge in Zukunft von hoher Relevanz, um Innovationen sicher und effizient in praktikable Lösungen umzusetzen und damit auch weniger erfahrenen Nutzern Zugang zu leistungsfähigen KI-Systemen zu ermöglichen. In Kombination mit anderen Methoden der Künstlichen Intelligenz wird der Ansatz des symbolischen AutoML durch Chain-of-Thought und die darauf basierende Stabilitätsanalyse mittels Lyapunov-Theorie eine zentrale Rolle bei der Etablierung zuverlässiger, flexibler und anwenderfreundlicher KI-Systeme einnehmen.

So können wir die Potenziale großer Sprachmodelle voll ausschöpfen und gleichzeitig ihre Schwachstellen frühzeitig erkennen und beheben. Dieser Weg eröffnet spannende Perspektiven für eine Zukunft, in der Mensch und Maschine als Partner agieren und gemeinsam innovative Lösungen für komplexe Aufgaben entwickeln können.