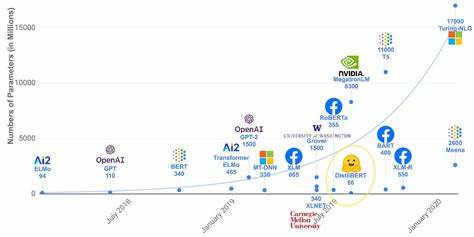

In den letzten Monaten hat eine neue Skalenkurve für Künstliche Intelligenz in der Fachwelt, den sozialen Medien und sogar etablierten Medien wie der Financial Times breite Aufmerksamkeit erhalten. Die Grafik versucht, die Leistungsfähigkeit großer Sprachmodelle bei softwareorientierten Aufgaben anhand der Zeit zu messen, die Menschen benötigen, um diese Aufgaben zu lösen, und setzt diese in Relation zur Leistung der Modelle. Doch bei genauerer Betrachtung offenbart sich, warum die Interpretationen, die daraus häufig gezogen werden, nicht stichhaltig sind und einige der wichtigsten Herausforderungen bei der Messung von KI-Leistungsfähigkeit verdeutlichen. Das zugrundeliegende Forschungsprojekt, das diese Skalenanalyse präsentiert, stammt von einem gemeinnützigen Forschungsinstitut namens Model Evaluation and Threat Research (METR), das Ende 2023 gegründet wurde. METR führte eine umfangreiche Studie durch, in der die Fähigkeit verschiedener großer Sprachmodelle untersucht wurde, Software-bezogene Aufgaben zu bewältigen.

Dabei wurden 107 Problemstellungen gewählt, die von Experten sorgfältig ausgewählt und bearbeitet wurden. Ziel war es, herauszufinden, wie sich die KI-Fähigkeiten im Bereich der Softwareentwicklung im Laufe der Zeit entwickelt haben. Auf den ersten Blick wirkt das Vorhaben vielversprechend, denn eine systematische Bewertung von KI in einem notwendigerweise schwer fassbaren Bereich wie dem Software-Engineering ist eine wertvolle Ergänzung zur Forschung. Dennoch bergen die angewendeten Methoden und vor allem die Art der grafischen Darstellung einige Problemstellen, die auf den ersten Blick nicht offensichtlich sind. Der Kernkritikpunkt betrifft die Gestaltung der Y-Achse der Grafik, die die „Schwierigkeit“ der Probleme anhand der Zeit misst, die Menschen benötigen, um diese zu lösen.

Auf der Y-Achse der Skalenkurve wird die „Schwierigkeit“ in Zeit angegeben. Hierzu wird der Durchschnittswert herangezogen, den menschliche Experten angeblich brauchen, um eine Aufgabe zu bewältigen. Beispielsweise ergibt sich für eine spezifische Programmieraufgabe eine durchschnittliche Zeit von fast 24 Stunden bei Experten. Im Gegenzug wird die Leistungsfähigkeit der KI daran gemessen, für welche Aufgaben sie 50 Prozent Korrektheit erreicht und die Zeit wird dann passend dieser menschlichen Referenzzeit zugeordnet. So heißt es beispielsweise, dass GPT-4 50 Prozent der Aufgaben korrekt gelöst hat, für die Menschen durchschnittlich ca.

vier Minuten benötigen. Diese Kombination aus Zeitangabe und Genauigkeit ist jedoch äußerst problematisch. Die Zeit, die ein Mensch benötigt, um eine bestimmte Aufgabe zu erledigen, ist kein objektives Maß für Komplexität oder Schwierigkeit. Sie variiert stark je nach Art der Aufgabe, Erfahrung, Vertrautheit mit dem Themengebiet, verfügbaren Hilfsmitteln und zahlreichen anderen Faktoren. Die Skala suggeriert fälschlicherweise, dass eine kürzere Zeit eine leichtere Aufgabe bedeutet, was in der Praxis oft nicht zutrifft.

So kann das Zählen von Wörtern in einem Text in manchen Fällen nur Sekunden dauern, bei komplizierteren Texten oder unbekannten Schriftsystemen aber deutlich länger. Ebenso kann das Beantworten von Fragen sehr unterschiedlich viel Zeit beanspruchen, abhängig von deren Komplexität, Kontext und Vorerfahrung. Diese willkürliche Zeitmessung und die 50-Prozent-Korrektheit bewirken, dass die Zuordnung der Fähigkeiten der KI-Modelle auf der Zeitskala eher zufällig erscheint als eine fundierte Bewertung. Es ist daher nicht glaubwürdig oder zuverlässig, von einem Modell wie GPT-4 zu behaupten, es löse Aufgaben so gut wie ein Mensch, der durchschnittlich vier Minuten benötigt, ebenso wenig wie man GPT-3 mit einer Leistungsfähigkeit auf dem Niveau von Aufgaben, für die Menschen 15 Sekunden brauchen, gleichsetzen kann. Die Y-Achse wird so zu einer illusorischen Metrik, die in den Kontext der tatsächlichen Fähigkeiten und Herausforderungen eines KI-Systems nur bedingt passt.

Darüber hinaus ist die Skalenkurve isoliert auf softwarebezogene Problemstellungen beschränkt. Softwareaufgaben besitzen spezifische Merkmale, die sie von anderen kognitiven Bereichen unterscheiden. Es ist kein realistischer Schluss, dass Erkenntnisse, die aus Softwareaufgaben gewonnen wurden, ohne Weiteres auf andere Domänen der menschlichen Kognition oder auf allgemeinere Aufgabenfelder übertragen werden können. Die Autoren der technischen Studie machen diesen Vorbehalt zwar deutlich, doch in sozialen Medien und anderen öffentlichen Debatten wird er leider oft ignoriert – stattdessen werden die Ergebnisse fahrlässig verallgemeinert und überinterpretiert. Ein weiterer Kritikpunkt betrifft den sogenannten „Messiness“-Begriff, mit dem METR die Komplexität von Aufgaben zu erklären versucht.

Dieser Begriff beschreibt Aufgaben danach, wie „unordentlich“ oder unübersichtlich sie sind, beispielsweise durch fehlende klare Rückmeldeschleifen oder die Notwendigkeit, proaktiv nach relevanter Information zu suchen. Obwohl die Idee interessant ist, erweist sie sich als zu simpel, um den vielfältigen Facetten von kognitiven Aufgaben gerecht zu werden. So kann etwa das Zählen von Wörtern sowohl simpel als auch von einer Aufgabenstellung zur anderen sehr unterschiedlich schwierig sein, was durch die Messiness-Theorie kaum treffend beschrieben wird. In der Folge ist die Skalenkurve kein verlässliches Instrument, um klare Vorhersagen darüber zu treffen, welche Aufgaben KI in welcher Zeit beherrschen wird oder wann sie menschliche Fähigkeiten erreichen oder übertreffen könnte. Die beeindruckenden, oft exponentiell wirkenden Wachstumskurven, die gerne in der Debatte herangezogen werden, suggerieren einen Fortschritt, der linear oder sogar exponentiell fortschreitend ist – doch solche Trends brechen zwangsläufig ab, wenn sie an physikalische, technische oder logische Grenzen stoßen.

Ein weiterer wichtiger Punkt ist die hohe Fehlinterpretation und Übertreibung in den sozialen Medien. Tweets und Posts bedienen oft Hoffnung und Erwartungshaltungen, die wissenschaftliche Arbeiten nur vorsichtig stützen, wenn überhaupt. Die dadurch entstehende Echokammer verstärkt unreflektierte Behauptungen über die zukünftige Leistungsfähigkeit von KI, was zu Fehleinschätzungen sowohl in der Öffentlichkeit als auch bei Investoren und politischen Entscheidungsträgern führt. Doch es gibt auch positive Aspekte. Die von METR erarbeiteten Datensätze für softwaretechnische Aufgaben sind an sich ein wertvolles Gut und legen eine gute Grundlage für weitere Forschung und Evaluierung von KI-Systemen.

Auch die detaillierte technische Arbeit und kritische Reflexion innerhalb der wissenschaftlichen Arbeit selbst werden gelobt. Nur ist der Transfer dieser Arbeit in populärwissenschaftliche Darstellungen oder Social-Media-Kanäle mit ihrem schnellen und oft vereinfachten Diskurs problematisch. In der Gesamtschau zeigt die Debatte rund um die KI-Skalenkurve deutlich, dass bei der Bewertung der Fähigkeiten und Fortschritte von Künstlicher Intelligenz ein tiefes Verständnis für Messmethoden und Kontext notwendig ist. Es reicht nicht, sich von beeindruckenden Graphen oder vermeintlich exponentiellen Fortschritten blenden zu lassen – vielmehr sollten die zugrundeliegenden Daten, deren Herkunft, Aussagekraft und Anwendbarkeit kritisch hinterfragt werden. Spannend bleibt jedoch die Frage, wie sich die Leistungsfähigkeit von KI in den kommenden Jahren tatsächlich entwickeln wird und in welchen Bereichen echte Durchbrüche zu erwarten sind.

Dabei werden sorgfältig überprüfte, domain-spezifische Benchmarks und realistische Maßstäbe entscheidend sein, um Fortschritte sinnhaft bewerten und einordnen zu können. Die Entwicklung von KI bleibt ein bedeutendes Forschungsgebiet, das nicht nur durch technische Innovationen, sondern auch durch reflektierte Analyse und verantwortungsbewusste Kommunikation geprägt sein sollte. Letztendlich mahnt die Betrachtung der neuesten KI-Skalenkurve zur Vorsicht und zur kritischen Auseinandersetzung mit Medienberichten und überzogenen Erwartungen. Eine nüchterne, faktenbasierte Herangehensweise ist notwendig, um die tatsächlichen Fähigkeiten von KI-Modellen richtig einzuordnen und den Weg für nachhaltige Innovationen und Anwendungen zu ebnen.

![What Is Bitcoin, Exactly? [+ Is This Cryptocurrency The “New Gold”?]](/images/8763D668-8670-43C8-B49E-9AF3A21281DC)