Die rasante Entwicklung der Künstlichen Intelligenz (KI) hat unsere Arbeitswelt und insbesondere die Softwareentwicklung revolutioniert. KI-Agenten, die heute in unterschiedlichsten Branchen Einzug halten, bieten einerseits ungeahnte Möglichkeiten, bringen aber auch komplexe Herausforderungen mit sich. Die Verwaltung dieser Agenten in der Realität gleicht oft einer scheinbar unmöglichen Mission – eine Herausforderung, vor der viele Entwickler, Projektmanager und Unternehmen gleichermaßen stehen. Doch mit der richtigen Herangehensweise lässt sich der scheinbare Kontrollverlust eindämmen, und KI-Agenten können produktiv und sicher in den Entwicklungsprozess integriert werden. Die entscheidende Grundlage für den Erfolg liegt in der Planung und der Einschränkung des Kontextes, in dem KI-Agenten agieren dürfen.

Wer verstehen will, wie man diese Werkzeuge vernünftig und nachhaltig einsetzt, muss den Unterschied zwischen Werkzeug, Material und Technik begreifen. Anders als in der Kunst, wo nur das Endprodukt zählt, sind bei KI die Eingaben – also der Code, die Daten und vor allem die präzisen Anweisungen – das eigentliche Material. Die Kunst liegt darin, diese Materialien gezielt und effizient zu verweben, damit die Agenten brauchbare und qualitativ hochwertige Ergebnisse liefern. Eine verbreitete Fehlannahme ist, dass die Wahl des richtigen KI-Tools allein maßgeblich für den Erfolg ist. Tatsächlich haben sich viele Werkzeuge wie Cursor, GitHub Copilot oder ChatGPT in den Funktionen stark angenähert.

Viel wichtiger ist das Verständnis für die Arbeitsweise dieser Modelle und die Fähigkeit, die eigenen Anforderungen klar, präzise und gut strukturiert zu formulieren. Ohne dieses Know-how kann auch das beste Tool kaum zufriedenstellende Resultate liefern. Zudem spielt die eigene Expertise eine zentrale Rolle. KI-Agenten sind weder Zauberkünstler noch Komplettlösungen für jeden Entwickler. Für qualitativ hochwertige Ergebnisse sind tiefes Architekturverständnis, fundierte Programmierkenntnisse und die Fähigkeit, klare Kommunikationsstrukturen aufzubauen, unabdingbar.

Die Qualität der Eingaben spiegelt sich direkt in den Ausgaben wider. Wer beispielsweise als Entwickler seine eigenen Schwächen nicht kennt oder verbirgt, darf sich nicht wundern, wenn der Agent dieselben Probleme reproduziert. Die Versuchung, sogenannten „Vibe Coding“ zu betreiben – also einfach irgendetwas in den Agenten zu tippen und auf magische Ergebnisse zu hoffen – ist groß. Doch das führt meist nur zu Prototypen, die zwar ansprechend aussehen, in der Praxis jedoch nicht bestehen können. Für produktive Software ist eine wiederverwendbare Planung notwendig, die nicht nur einmal funktioniert, sondern auch über mehrere Iterationen stabil bleibt und leicht angepasst werden kann.

Diese Pläne sollten modular aufgebaut sein, sodass komplexe Aufgaben in überschaubare, bewältigbare Schritte zerlegt werden können. So wird sichergestellt, dass der Agent nicht vom Kurs abkommt oder fragwürdige Zwischenlösungen erfindet, um fehlende Schritte zu kompensieren. Die Suche nach dem richtigen Weg ist ein weiterer zentraler Aspekt im Umgang mit KI-Agenten. Obwohl es verlockend sein mag, kleine Änderungen direkt selbst vorzunehmen, lohnt es sich gerade bei komplexeren Aufgaben, den Agenten mit einer klaren Zielvorgabe und detaillierter Anleitung auszustatten. Der Agent folgt dabei keiner starren Regel, sondern trifft Prognosen basierend auf Wahrscheinlichkeiten.

Das macht das Verhalten anfangs unberechenbar und erfordert viel Kontrolle und Nacharbeit. Gerade proaktive Planung und offene Kommunikation mit dem Agenten helfen dabei, Missverständnisse zu vermeiden und das Endergebnis Schritt für Schritt zu verbessern. Das Erstellen eines Plans gleicht dem Komponieren eines Musikstücks: erst nach mehreren Anpassungen entsteht eine harmonische Komposition, die sich später problemlos weiterentwickeln lässt. Entwickler sollten Pläne daher als vollwertige, im Repository gepflegte Dokumente sehen, die Versionierung, Kommentare und Beispiele enthalten. Diese Art von Planung macht Code nicht nur nachvollziehbarer und wartbarer, sondern erhöht auch die Effizienz bei späteren Erweiterungen oder Fehlerbehebungen.

Darüber hinaus wird das Team über den Entwicklungsstand besser informiert, was in verteilten und agilen Arbeitsumgebungen enorm hilfreich ist. Doch niemand sollte davon ausgehen, dass ein einmal erstellter Plan sofort perfekt ist. Die Realität zeigt, dass Pläne ständig angepasst, verbessert und erneut getestet werden müssen. Gerade am Anfang des Einsatzes von KI-Agenten ist die Lernkurve steil. Frustration gehört dazu, weil der Agent nie genau das macht, was man erwartet, aber mit Geduld und fundierter Überprüfung lassen sich die Arbeiten zunehmend automatisieren.

Es ist wichtig, eigene Erwartungen an die KI realistisch zu halten: Sie ist ein Werkzeug zur Unterstützung, kein vollwertiger Ersatz für menschliches Denken und Erfahrung. Testen ist deshalb elementar. Die Überprüfung der Resultate gegen den ursprünglichen Plan fördert nicht nur Fehler zutage, sondern offenbart oft auch Schwächen im eigenen Code oder in der Softwarearchitektur. Dies bietet eine erstklassige Chance zur nachhaltigen Qualitätsverbesserung und zur Reduzierung von technischem Schuldenstand – einer der größten Herausforderungen im Softwareprojektmanagement. KI-Agenten unterstützen dabei als wertvolle Assistenten beim Refactoring und Debugging.

Auch wenn KI-Modelle immer besser werden, dürfen sie nie unbeaufsichtigt agieren. Entwickler sollten ihre eigenen Builds und Tests starten und die Resultate kritisch auf Plausibilität prüfen. KI-Agenten können nicht „verstehen“, wofür der Code gedacht ist oder wie die Benutzerschnittstelle sich verhält. Sie liefern nur Vorschläge aufgrund statistischer Wahrscheinlichkeiten. Daher ist es wichtig, bei Korrekturen und Problembehebungen systematisch vorzugehen: Zunächst eine präzise Fehlerbeschreibung verfassen, dann eine neue Planungsrunde starten und schließlich den Agenten Schritt für Schritt arbeiten lassen.

Wenn größere Probleme oder Architektur-Schwächen auftreten, sollten diese direkt adressiert werden. KI entlarvt oftmals Schwachstellen im eigenen Code schneller, als das bisher möglich war. Statt zu versuchen, den Agenten mit Tricks um die schlechten Stellen herumzulenken oder ihn mit immer mehr Kontext zu überfrachten, ist der bessere Ansatz, den Code zu verbessern und dann den Agenten gezielt darauf anzusetzen. Die Kombination von Empathie für den Agenten und der Bereitschaft, die eigene Arbeit kritisch zu hinterfragen, führt zu spürbaren Fortschritten. Regelwerke und automatisierte Vorgaben helfen dabei, den Umgang mit KI besser zu strukturieren.

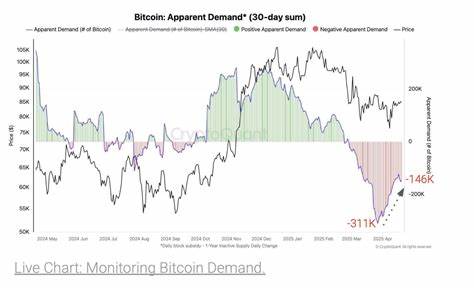

Regeln, die je nach Kontext automatisch angewendet werden, verhindern, dass in jedem neuen Schritt die gleichen Fehler passieren. Zugleich stellen sie sicher, dass der Agent den speziellen Anforderungen des Projekts gerecht wird. Der Aufbau von sogenannten „Always Rules“ oder „Agent Assigned Rules“ ermöglicht, wiederkehrende Standards effizient einzuführen und automatisch in die Arbeitsschritte einzubinden. Die Investition in KI ist allerdings kein Selbstläufer. Neben der menschlichen Arbeitszeit sind auch Lizenzkosten für KI-Modelle zu berücksichtigen.

Wer hier blind mit Technik experimentiert, riskiert teure Fehlinvestitionen und geringe Produktivität. Kostenkontrolle durch monatliche Limits, Auswahl geeigneter Modelle je nach Aufgabe und kontinuierliche Überwachung des Verbrauchs sind daher unerlässlich. Dazu kommt die Notwendigkeit, die Dynamik und den Wandel in der KI-Landschaft im Blick zu behalten, da neue Modelle und Funktionen ständig auftauchen und alte ablösen. Die Model Context Protocol (MCP) Implementierungen, trotz aller Euphorie, sind kein Wundermittel. Sie erleichtern nur die Interaktion verschiedener KI-Dienste und Agenten, jedoch bleibt das Prinzip das Gleiche: Prompts und Werkzeugaufrufe, orchestriert von Menschen, sind das Herzstück.