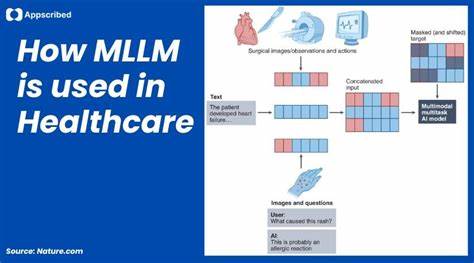

Die Fortschritte im Bereich der Künstlichen Intelligenz (KI) sind beeindruckend und insbesondere die großen Sprachmodelle (Large Language Models, LLMs) wie GPT-4o haben in medizinischen Tests für Aufsehen gesorgt. Diese Modelle erreichen bei medizinischen Prüfungen Werte von bis zu 90% Genauigkeit und übertreffen gelegentlich sogar erfahrene Ärzte bei Diagnoseaufgaben. Doch wie schlägt sich diese Technologie im realen Einsatz, wenn sie von Patienten oder Laien genutzt wird? Eine aktuelle Studie der Universität Oxford bringt ernüchternde Erkenntnisse ans Licht, die den Traum von der allzeit verfügbaren medizinischen KI-Begleitung auf den Boden der Realität zurückholen. Die Kernfrage der Untersuchung war, ob Menschen mithilfe von LLMs wie GPT-4o, LLaMA 3 oder Command R+ tatsächlich in der Lage sind, eigene Symptome korrekt einzuschätzen und daraus angemessene Handlungen abzuleiten. Dabei ist das Ergebnis eher ernüchternd: Während die KI-Modelle selbst die richtigen Diagnosen in knapp 95% der Fälle liefern, schaffen es die menschlichen Nutzer nicht einmal in einem Drittel der Fälle, die richtigen Schlüsse daraus zu ziehen.

Sogar Personen, die ohne jegliche Unterstützung durch KI eine Diagnose stellten, waren etwa doppelt so erfolgreich. Diese Diskrepanz verdeutlicht, dass das Problem nicht unbedingt an der Leistung der KI selbst liegt, sondern vielmehr an der Art und Weise, wie Menschen die Technologie nutzen. Die Studie simulierte 1.298 Patientenfälle unterschiedlichster Schwere – von harmlosen Kopfschmerzen bis zu lebensbedrohlichen Blutungen – und bat Teilnehmer, auf Basis von KI-Rückmeldungen geeignete Maßnahmen zu wählen. Ein besonders drastisches Beispiel zeigte sich bei der Frage, ob ein junger Erwachsener mit plötzlich auftretenden, sehr starken Kopfschmerzen umgehend die Notaufnahme aufsuchen sollte.

Hier verfehlten viele Nutzer die dringende Empfehlung der KI, was fatale Folgen im echten Leben haben könnte. Die Gründe für diese Fehlinterpretationen sind vielfältig. Zum einen geben Nutzer oft unzureichende oder unscharfe Informationen in ihre Anfragen ein. Dies führt dazu, dass die KI-Modelle auf Basis der spärlichen Daten nur generische oder ungenaue Antworten liefern können. Zum anderen finden viele User Schwierigkeiten darin, die Aussagen und Hinweise der Modelle richtig einzuordnen.

Selbst wenn die KI passende Warnhinweise gibt, setzen viele die Empfehlungen nicht konsequent um. Dieser Kommunikationsbruch zwischen Mensch und Maschine offenbart eine fundamentale Schwäche in der Art, wie KI-Lösungen für den medizinischen Einsatz bislang getestet und entwickelt werden. Üblicherweise evaluieren Experten die Modelle unter idealisierten Bedingungen mit präzisen, klar formulierten Eingaben. Der Alltag von Patienten mit echten Schmerzen, Ängsten und Unsicherheiten sieht jedoch anders aus – vage Beschreibungen, fehlendes medizinisches Wissen und emotionaler Stress prägen das Bild. Das Oxford-Team versuchte zudem, sogenanntes „simuliertes KI-Patientenverhalten“ einzusetzen: KI-Modelle, die mit anderen KI-Systemen interagieren.

Diese Szenarien bergen deutlich höhere Erfolgsraten bei der Diagnose, was wiederum bestätigt, dass die großen Sprachmodelle miteinander deutlich besser kommunizieren als mit echten Menschen. Die Herausforderungen dieser menschlichen Interaktion sind jedoch nicht auf die Medizin beschränkt. Im gesamten Bereich der KI-Nutzung erleben wir immer wieder ähnliche Phänomene: interne Tests zeigen beeindruckende Resultate, doch sobald die Anwendungen in der freien Wildbahn auf Nutzer mit unterschiedlichsten Vorkenntnissen und Verhaltensweisen treffen, entstehen erhebliche Probleme. Dieses Missverhältnis wird als menschlich-ki Reibung oder Human-AI Friction bezeichnet und hemmt die volle Entfaltung der Technologie. Nathalie Volkheimer, Expertin für Nutzererfahrung an der Renaissance Computing Institute der Universität North Carolina, beschreibt diesen Umstand treffend mit einem Vergleich, der an die Anfänge der Internetsuche erinnert.

Die Qualität der Eingaben, also der Prompts, sei entscheidend für den Erfolg. Genau wie bei der Google-Suche früher müssen Nutzer lernen, mit den neuen Werkzeugen gezielt und präzise umzugehen – was im medizinischen Kontext jedoch eine ganz besondere Verantwortung mit sich bringt. Die Konsequenzen für die praktische Anwendung sind weitreichend. Es genügt nicht, ein noch so leistungsfähiges Modell zu entwickeln. Vielmehr muss der gesamte Nutzungskontext berücksichtigt werden: Wie gut verstehen Patienten die Hinweise? Werden die Benutzerführung und das Interface so gestaltet, dass sie auch unter Stress und Unsicherheit funktionieren? Ist eine angemessene Schulung oder Begleitung vorgesehen, die Missverständnissen vorbeugt? Optimierungspotential liegt daher vor allem im Bereich des human-centered Designs, das die Bedürfnisse, Fähigkeiten und Grenzen der Nutzer in den Mittelpunkt stellt.

Schnittstellen, die ein natürliches, klares und vertrauenswürdiges Gespräch ermöglichen, sind unerlässlich. Ebenso wichtig sind Feedbackmechanismen, die den Patienten aktiv helfen, Verständnisbarrieren zu überwinden und richtige Entscheidungen zu treffen. Nur so kann die Kluft zwischen der Leistung der KI und deren praktischer Wirksamkeit überbrückt werden. Die Ergebnisse der Oxford-Studie fordern insbesondere Anbieter, Entwickler und Entscheidungsträger in der Branche dazu auf, nicht allein die Leistungskennzahlen der Modelle ins Zentrum zu stellen, sondern ganzheitliche Systeme zu schaffen, in denen KI und Mensch effektiv zusammenarbeiten können. Der Fokus muss darauf liegen, eine Brücke zu bauen, anstatt nur Werkzeuge für maschinelle Kommunikationspartner zu konstruieren.

Diese Erkenntnisse eröffnen auch eine wichtige Debatte für zukünftige Regulierungen und ethische Standards. Wenn KI-Systeme im Gesundheitswesen eingesetzt werden, müssen sie nicht nur sicher und akkurat sein, sondern auch verständlich und für Nutzer handhabbar – gerade in kritischen Situationen. Die Verantwortung liegt bei Entwicklern und Institutionen, sicherzustellen, dass die Technologie nicht nur im Labor oder unter Laborbedingungen exzellent funktioniert, sondern auch in realen, emotional belasteten Lebenslagen ihre volle Wirkung entfalten kann. Zusammengefasst bestätigt die Oxford-Studie eine wichtige Wahrheit: Große Sprachmodelle besitzen das Potenzial, Diagnosen auf hohem Niveau zu stellen. Doch bis diese Systeme Patienten sicher anleiten und begleiten können, ist noch viel Entwicklungsarbeit notwendig.