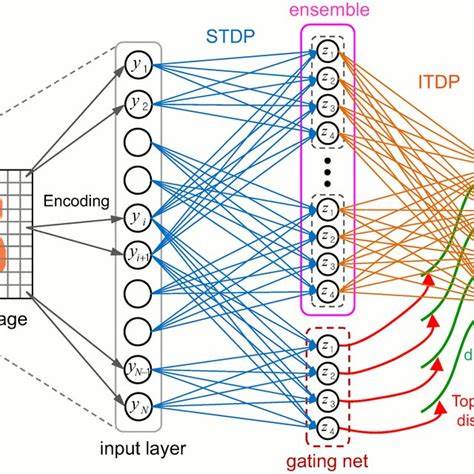

Im immer dynamischer werdenden Feld der Künstlichen Intelligenz und des maschinellen Lernens rückt die Fähigkeit, längere Kontextinformationen in Sprachmodellen zu verarbeiten, zunehmend in den Vordergrund. Eines der spannendsten Themen in diesem Zusammenhang ist die Frage, wie Modelle wie Gemini von Google in der Lage sein könnten, extrem lange Kontextfenster von bis zu zehn Millionen Token effizient zu handhaben. Eine plausible Erklärung dazu findet sich in der Hypothese rund um die Long Context Mixture of Experts (MoE) Architektur, auch bekannt als Mesh of Experts (MeoE). Diese Technologie, die Forschungsarbeiten wie Shazeers MoE, GShard und Switch und die fortschrittlichen TPU-Architekturen von Google einschließt, steht möglicherweise hinter Geminis beeindruckenden Fähigkeiten im Bereich Langzeitkontextverarbeitung. Die Grundidee hinter der MoE-Architektur besteht darin, aus einer Vielzahl spezialisierter Teilnetzwerke — den sogenannten Experten — zu bestehen, von denen bei der Verarbeitung eines einzelnen Inputs nur eine kleine, relevante Auswahl aktiv geschaltet wird.

Dieser sogenannte Sparsity-Ansatz erlaubt es, massiv skalierende Sprachmodelle mit reduzierter Rechenlast zu erzeugen. Im Falle von Gemini wird vermutet, dass für extrem lange Kontextfenster von bis zu einer Million bis zehn Millionen Tokens ein neuartiges Konzept implementiert ist, bei dem ein gemeinsamer, verteilbarer Langzeitkontext von mehreren TPU-Instanzen innerhalb eines Pods genutzt wird. Dieser gemeinsame Kontext ist dabei nicht ein monolithischer Block, sondern vielmehr aufgeteilt in «Shards», also kontextuelle Fragmente, die von verschiedenen Experten verarbeitet werden können. Diese Sub-Kontexte agieren teilweise unabhängig voneinander, was es ermöglicht, dass unterschiedlich komplexe oder thematisch diverse Anfragen parallel abgearbeitet werden können. Man spricht in diesem Zusammenhang von dynamischen Pfaden, bei denen pro Anfrage lediglich eine spezifische Teilmenge von Experten aktiviert wird, die genau auf den jeweiligen Kontext zugeschnitten ist.

Somit lassen sich mehrere Nutzeranfragen gleichzeitig bearbeiten, ohne den gesamten Hardware-Pool zu blockieren. Relevant für das Verständnis der vermuteten Technologie sind auch die verwendeten TPU-Generationen von Google, speziell TPUs der vierten und fünften Generation sowie die experimentaleren v5p- und Ironwood-Chips. Diese verfügen über enorme Mengen an Hochbandbreiten-Speicher (HBM) und schnelle, dreidimensionale Torus- oder optische Inter-Chip-Verbindungen (OCI), die einen extrem schnellen Datenaustausch innerhalb eines TPU-Pods ermöglichen. Dies ist eine wesentliche Grundlage für die parallele und verteilte Verarbeitung des umfangreichen Kontextes. Zusätzlich zeigen Googles Forschung zu Pathways und System-Optimierungen, wie Modellkomponenten und Hardware intelligent orchestriert werden können, um die Verarbeitung großer kontextueller Einheiten über horizontal verteilte Rechenressourcen zu ermöglichen.

Die Kombination aus spezialisierter MoE-Architektur, fortschrittlichen Hardware-Pods und Systemsoftware schafft eine Umgebung, in der theoretisch Kontextfenster von Millionen Tokens praktikabel werden. Der Clou des Ganzen liegt in der Fähigkeit, mehrere Anfragen nicht nur simultan zu bearbeiten, sondern dabei jedem Input seinen eigenen, isolierten und maximal relevanten Kontextpfad zuzuweisen. So wird vermieden, dass der riesige Kontext für eine Anfrage nur als Ganzes geladen werden muss. Stattdessen greift jeder Expertenpfad auf exakt die Teile des Langzeitkontexts zu, die zur jeweiligen Aufgabe passen. Dies reduziert Speicher- und Rechenanforderungen drastisch und ermöglicht dennoch umfassendes Kontextdenken.

Die Idee, den Langzeitkontext in sogenannte Sub-Global Attention Buffers oder Sub-Kontext-Experten zu unterteilen, ist ein vielversprechender Ansatz, um die Skalierbarkeit von Sprachmodellen zu erhöhen. Diese Blöcke können teilweise autonom arbeiten, was die Komplexität pro Verarbeitungsschritt verringert und gleichzeitig die Aggregation zu einem globalen, kohärenten Kontext erlaubt. Dies könnte theoretisch in einem dynamischen Zusammenspiel verschieden spezialisierter Experten resultieren, die auf bestimmte Fragmente des Kontextfensters fokussiert sind und so eine skalierbare Verarbeitung von teilweise nicht-linearen und hochkomplexen sprachlichen Bezügen ermöglichen. Das Konzept steht jedoch noch am Anfang der praktischen Umsetzung. Es braucht umfassende Engineeringanstrengungen, um die genannten Theorien in prototypische Anwendungen zu überführen und mögliche Skalierungsbarrieren zu überwinden.

Für Entwickler und Forscher im KI-Bereich liegt hier eine spannende Möglichkeit, die unter anderem auf kleineren Modellen im Labormaßstab getestet werden kann, um die grundlegenden Prinzipien zu validieren und weiterzuentwickeln. Auch die Weiterentwicklung der Recheninfrastruktur spielt eine entscheidende Rolle. Die Fähigkeit, extrem hohe Bandbreiten zwischen Rechenzyklen zu gewährleisten und gleichzeitig parallele Abläufe von Experten zu koordinieren, erfordert innovative Hardwarelösungen und nochmals verbesserte Netzwerk-Topologien. Google verfügt durch die enge Verzahnung von Forschung, Softwareentwicklung und Hardwareentwicklung über einen erheblichen Wettbewerbsvorteil, der das Realisieren solcher komplexer Modelle begünstigt. Neben dem technischen Potenzial wirft die komplexe Architektur des Gemini-Modells auch Fragen hinsichtlich Effizienz, Energieverbrauch und praktischer Einsetzbarkeit auf.

Modelle mit so langen Kontextfenstern bieten zwar enorme Vorteile in Bezug auf Textkohärenz, Langzeitgedächtnis und Kontextualisierung von Informationen, doch stellt sich die Herausforderung, diese Leistungsfähigkeit in realen Szenarien kosteneffektiv und ressourcenschonend nutzbar zu machen. Insbesondere die Verwaltung von Speicherkapazitäten und die parallele Skalierung von Expertenpfaden müssen so gestaltet sein, dass Durchsatz und Latenzzeiten sich im für Nutzer akzeptablen Rahmen bewegen. Die intensive Diskussion rund um Geminis vermeintliche Long Context MoE Architektur zeigt, dass die Grenzen heutiger Sprachmodelle noch lange nicht erreicht sind. Es ist davon auszugehen, dass weitere Innovationen in der Modellarchitektur, kombiniert mit verbesserten Hardware-Plattformen, in naher Zukunft die Verarbeitung immer längerer und komplexerer kontextueller Daten ermöglichen werden. Die Erforschung von sogenannten dynamischen Pfaden und sub-globalen Kontextblöcken könnte sich dabei als wegweisend erweisen und die nächste Generation von Sprachmodellen prägen.

Schließlich ist die verbesserte Handhabung extrem langer Kontextfenster besonders für Anwendungen wie wissenschaftliche Recherche, juristische Dokumentenanalyse, Softwareentwicklung oder mehrschichtige Dialogsysteme von enormer Bedeutung. Je genauer ein Modell den Zusammenhang über viele tausende oder gar millionen Tokens erfassen kann, desto relevanter und kontextsensitiver werden die generierten Antworten und Empfehlungen. Gemini könnte durch seine innovative Hypothese des Mesh of Experts mit gemeinsam genutztem Langzeitkontext einen Meilenstein in der Weiterentwicklung dieser Technologien setzen und die Zukunft der KI-gestützten Kommunikation maßgeblich beeinflussen.

![Python: The Documentary [Official trailer] [video]](/images/FF2A7C41-4A65-4355-880E-3B10BD295570)