Im Jahr 2025 hat sich die Welt des maschinellen Lernens rasant weiterentwickelt, und Machine-Learning-Ingenieure stehen vor neuen Herausforderungen und Möglichkeiten. Eine Methode hat sich dabei als besonders wegweisend erwiesen: das Fine-Tuning. Diese Technik ist sozusagen die geheime Zutat, die aus vortrainierten Modellen flexible, anwendungsorientierte Werkzeuge macht, die präzise auf individuelle Bedürfnisse zugeschnitten sind. Warum Fine-Tuning inzwischen als essenziell gilt, wie es funktioniert und welche neuen Ansätze wie Reinforcement Learning from Human Feedback (RLHF) die Szene verändern, ist Thema dieser Ausführung. Die Bedeutung von Fine-Tuning in modernen ML-Projekten lässt sich nicht hoch genug einschätzen.

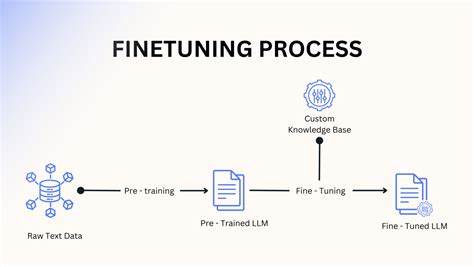

Statt große Modelle von Grund auf neu zu trainieren, ermöglicht Fine-Tuning eine effiziente Anpassung bereits existierender, leistungsfähiger Modelle. Diese Vorgehensweise spart enorm viel Rechenzeit und Ressourcen. Modelle, die mit massiven Datenmengen vortrainiert wurden, beispielsweise große Sprachmodelle, können mithilfe von Fine-Tuning für spezifische Aufgaben optimiert werden. Ursprünglich konnte das Training eines leistungsfähigen Modells Wochen oder sogar Monate dauern – heute erlaubt Fine-Tuning schnelle Iterationen und gezielte Verbesserungen, was besonders im professionellen Umfeld unverzichtbar ist. Die Technik beruht darauf, ein vortrainiertes Modell als Basis zu verwenden und dieses mit einer begrenzten, oftmals domänenspezifischen Datenmenge individuell zu justieren.

So kann ein Sprachmodell, das auf allgemeiner Sprachverarbeitung trainiert wurde, etwa für juristische Fachtexte, medizinische Diagnosen oder Marketingkommunikation optimiert werden. Die Anpassung führt zu präziseren und relevanteren Ergebnissen, die exakt auf die jeweilige Anwendung zugeschnitten sind. Neben der Effizienz bietet Fine-Tuning auch eine bessere Kontrollierbarkeit und Flexibilität. Machine-Learning-Ingenieure können Modelle schneller an neue Anforderungen anpassen, ohne den enormen Aufwand eines kompletten Neubaus. Dies fördert die Innovationsgeschwindigkeit und erhöht die Wettbewerbsfähigkeit von Unternehmen, die KI-Lösungen einsetzen.

Die wachsende Popularität von Fine-Tuning hängt auch mit dem Aufkommen spezieller Bibliotheken und Tools zusammen, die den Prozess zugänglicher machen. Ein prominentes Beispiel ist die von Hugging Face entwickelte TRL-Bibliothek (Transformers Reinforcement Learning). Diese Software erleichtert den Einsatz fortgeschrittener Fine-Tuning-Methoden, einschließlich moderner Algorithmen wie Reinforcement Learning from Human Feedback. RLHF ist eine Technik, die Feedback von Menschen nutzt, um die Leistung und Qualität von Modellen zu verbessern. Dabei erhält das Modell nicht nur einfache Korrekturen, sondern lernt durch Interaktionen mit menschlichen Rückmeldungen, welche Arten von Antworten erwünscht sind.

Diese Kombination aus maschineller Lernfähigkeit und menschlicher Kompetenz sorgt für eine deutlich bessere Anpassung an komplexe, realweltliche Anforderungen. Der Einsatz von RLHF macht Fine-Tuning noch kraftvoller, da Modelle so nicht nur systematisch trainiert, sondern auch verantwortungsvoller und benutzerorientierter optimiert werden können. Gerade bei Anwendungen, bei denen ethische oder qualitative Anforderungen hoch sind, fällt dieser Ansatz ins Gewicht. Die Integration von RLHF und verwandten Methoden bei Fine-Tuning-Prozessen bringt erhebliche Verbesserungen bei der Benutzerfreundlichkeit und Anwendbarkeit von KI-Systemen mit sich. Für ML-Ingenieure im Jahr 2025 ist es deshalb von zentraler Bedeutung, diese Techniken zu beherrschen.

Das Verständnis von Fine-Tuning ist heute mehr als eine technische Fähigkeit – es ist ein strategischer Vorteil. Unternehmen, die diese Kompetenz besitzen, können KI-Modelle schneller und gezielter auf ihre individuellen Geschäftsprozesse zuschneiden, die Genauigkeit von Vorhersagen steigern und Innovationen vorantreiben. Im Hinblick auf die Karriereentwicklung erhöht Fachwissen im Bereich Fine-Tuning deutlich die Chancen auf Führungspositionen und verantwortungsvolle Rollen in der AI-Branche. Die Handhabung von Fine-Tuning verlangt außerdem ein solides Verständnis von Datenaufbereitung, Modellarchitektur und Evaluierungsmethoden. Die Zusammenarbeit unterschiedlicher Disziplinen wird dabei wichtiger denn je.

Data Scientists, Software-Entwickler und Domänenexperten arbeiten eng zusammen, um je nach Anforderung optimale Ergebnisse zu erzielen. So entstehen praxisnahe und effiziente Lösungen, die den wachsenden Ansprüchen an Automatisierung, Personalisierung und Effizienz gerecht werden. Zudem spielen ethische Überlegungen eine zentrale Rolle. Durch das Fine-Tuning lassen sich etwa ungewollte Verzerrungen in AI-Modellen gezielter eliminieren. So können Entwickler sicherstellen, dass ihre Systeme faire und transparente Ergebnisse liefern.

Dies ist ein wichtiger Schritt hin zu verantwortungsvoller KI, der in der heutigen Zeit nicht mehr wegzudenken ist. Ein weiterer Aspekt, der Fine-Tuning attraktiv macht, ist die breite Verfügbarkeit von leistungsfähigen vortrainierten Modellen. Große Institute und Unternehmen wie OpenAI, Google oder Meta stellen ihre Modelle der Öffentlichkeit zur Verfügung. Dadurch entsteht eine Infrastruktur, die ML-Ingenieuren erlaubt, auf hochentwickelte Basismodelle zurückzugreifen und diese für ihre Zwecke anzupassen. Dies fördert die Demokratisierung von KI und eröffnet neue Möglichkeiten für Forschung und Entwicklung.

Gleichzeitig ist Fine-Tuning nicht ohne Herausforderungen. Je nach Datenqualität und Aufgabe kann es schwierig sein, das Modell optimal anzupassen, ohne dabei Overfitting oder Leistungsabfall zu riskieren. Auch die Wahl der richtigen Methoden und die Balance zwischen Modellkomplexität und Trainingsaufwand verlangen Erfahrung und Experimentierfreude. Aus diesem Grund sind zudem automatisierte Pipelines und Best Practices für Fine-Tuning von großer Bedeutung. Moderne Tools unterstützen dabei, Fehler zu minimieren und den Prozess zu standardisieren.