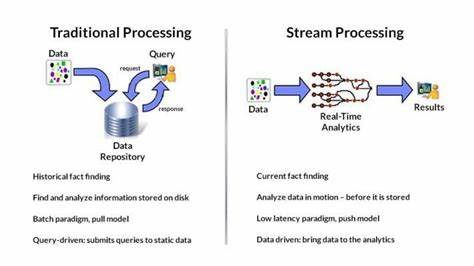

Stream Processing ist heute ein zentrales Thema in der Datenverarbeitung und spielt eine entscheidende Rolle, wenn es darum geht, in Echtzeit auf große Datenmengen zu reagieren. Während Batch Processing als bewährte Methode seit Jahrzehnten genutzt wird, gilt Stream Processing als innovativ und zukunftsweisend, bringt aber gleichzeitig eine Vielzahl von Komplexitäten mit sich, die sowohl Entwickler als auch Unternehmen vor große Herausforderungen stellen. Doch warum ist Stream Processing eigentlich so schwer? Um diese Frage zu beantworten, lohnt es sich, die technischen Hintergründe zu verstehen und auch den Blick auf die Architektur und das Ökosystem der Stream-Verarbeitung zu werfen. Gleichzeitig eröffnet der Fortschritt in diesem Bereich neue Möglichkeiten, um diese Schwierigkeiten zu überwinden und die Vorzüge von Streaming-Technologien breiter zugänglich zu machen. Im Kern unterscheidet sich Stream Processing fundamental von Batch Processing.

Während Batch Processing auf der Verarbeitung feststehender, einmaliger Datenmengen basiert, bei denen der gesamte Datensatz vorliegt und abgearbeitet wird, muss Stream Processing kontinuierlich Daten verarbeiten, die fortlaufend eintreffen. Dies bedeutet, dass ein Stream Processor sowohl den aktuellen Datenzustand verarbeitet als auch Strukturen aufbauen muss, um zukünftige Datenänderungen effizient zu handhaben. Diese Doppelrolle sorgt für erhebliche Komplexität in der Architektur und im Betrieb von Streaming-Systemen. Ein anschauliches Beispiel für die Herausforderungen bei Stream Processing sind Join-Operationen, die in der Datenverarbeitung grundlegend sind. Bei Batch Processing kann das System, da alle Daten zu einem Zeitpunkt vorliegen, eine Hash-Tabelle für die kleinere Datenseite erstellen und dann die größere Seite sequenziell abarbeiten.

Im Streaming-Kontext hingegen ist das nicht möglich, weil Daten jederzeit eintreffen können. Deshalb muss das System Hash-Tabellen für beide Seiten aufbauen und kontinuierlich aktualisieren, um neue oder veränderte Daten korrekt zu verarbeiten. Dieses erhöhte Maß an temporärem Speicher- und Verwaltungsaufwand ist ein Grund, warum Stream Processing technisch anspruchsvoller ist. Ein weiterer zentraler Punkt bei Stream Processing ist die Notwendigkeit, die Reihenfolge der eingehenden Daten genau zu wahren und größere zeitliche und logische Konsistenzen sicherzustellen. In Batch Jobs fällt diese Herausforderung weg, da alle Daten zusammen abgearbeitet werden.

Beim Streaming muss beispielsweise garantiert werden, dass eine eingefügte Datenzeile erst nach dem eigentlichen Einfügen auch wieder gelöscht wird und nicht umgekehrt. Dies wird zusätzlich erschwert, wenn parallele Verarbeitung zum Einsatz kommt, um Latenzzeiten niedrig zu halten und Skalierbarkeit sicherzustellen. Neben der inhärenten Komplexität einer stream-basierten Architektur müssen Stream Processing Systeme oftmals auch mit einer Vielzahl externer Komponenten und anderer Datenprodukte zusammenarbeiten. Eine typische Streaming-Pipeline kann beispielsweise verschiedenste Tools beinhalten: Change Data Capture (CDC) Systeme, Message Queues, Schema-Registry-Dienste, Stream-Prozessoren und schlussendlich Datenbanken, die die Ergebnisse speichern. Alle diese Komponenten müssen perfekt zusammenarbeiten, was die Einrichtung, Wartung und Fehlerbehebung stark erschwert.

Sogar kleine Unterschiede in der Art, wie eine Quell-Datenbank mit Partitionen, ENUMs oder Datenformaten umgeht, können zu Bugs führen, die sich im gesamten System auswirken. Diese enge Verzahnung mit externen Datenprodukten macht Stream Processing nicht nur komplex, sondern auch anfällig für Fehler außerhalb der eigenen Kontrollzone. Das Zusammenspiel von unterschiedlichen Versionen, Datenstrukturen und Schnittstellen verkompliziert die Implementierung und den Betrieb weiter. Hier zeigt sich ein großer Unterschied zu klassischen Datenbanken oder Batch-Verarbeitungssystemen, die oft als vollständige End-to-End-Lösungen fungieren und deshalb unabhängiger in sich sind. Die historische Entwicklung des Stream Processing gleicht einem Puzzle aus vielen einzelnen Bausteinen.

Das Ziel vieler Pioniere war es, die immense Komplexität großer Systeme durch Spezialisierung einzelner Komponenten beherrschbar zu machen. So sind zum Beispiel Koordinationssysteme wie Zookeeper, Ressourcenkontrollsysteme wie Mesos oder YARN, Indizierungsbibliotheken wie Lucene oder Serialisierungsformate wie Avro Teil eines komplexen Ecosystems, das zusammenspielt, um verteilte Streaming-Systeme zu realisieren. Diese modulare Vorgehensweise hat die Entwicklung von Streaming-Technologien stark beschleunigt und größere Innovationssprünge ermöglicht. Gleichzeitig hat diese Zerlegung in viele spezialisierte Tools und Bibliotheken dazu geführt, dass Endanwender und Entwickler oft tief in technisches Wissen eintauchen müssen, um Streaming-Systeme effektiv nutzen zu können. Während der Nutzer einer relationalen Datenbank vielleicht vor allem SQL beherrschen muss, verlangt der Betrieb eines typischen Streaming-Systems zusätzliche Kompetenzen bezüglich Konfigurationsdetails, Fehlerbehandlung und Performanceoptimierung.

Konzepte wie Watermarks, Checkpoints oder die Handhabung von Schemaänderungen in Echtzeit sind oft nicht trivial zu verstehen und umzusetzen. Die gute Nachricht ist, dass sich die Streaming-Technologie kontinuierlich weiterentwickelt, um diese Barrieren zu reduzieren und den Anwendern mehr Abstraktion anzubieten. Genau wie in der Vergangenheit die Komplexität der Oracle-Datenbank den Weg für benutzerfreundliche Systeme wie PostgreSQL ebnete, entsteht heute eine neue Generation von Stream Processing Plattformen, die versuchen, die technische Raffinesse im Hintergrund zu bündeln, während sie nach außen eine einfache und intuitive Bedienbarkeit bieten. Neue Streaming-Ansätze fokussieren sich stärker auf End-to-End-Garantien und Vereinfachung der Betriebsabläufe. Fortschrittliche Algorithmen und parallele Verarbeitungstechniken werden durch strengere Transaktionsmodelle ergänzt, die gewährleisten, dass Änderungen am Quellsystem konsistent und atomar in der Streaming-Pipeline und im Zielsystem abgebildet werden.

Diese Entwicklung adressiert eines der grundlegendsten Probleme älterer Systeme, bei denen z.B. große operationale Änderungen auf der Quellseite nicht einheitlich in den Zielsystemen sichtbar wurden. Ein weiterer innovativer Aspekt liegt in der engen Verzahnung von Transformationen und Replikationen innerhalb der Pipeline. Moderne Systeme erkennen automatisch neue Tabellen oder Datenänderungen im Quell-Datenbank-Schema und passen die Streaming-Verarbeitung dynamisch daran an.

Das entlastet Entwickler und Administratoren enorm und trägt zur Stabilität und Skalierbarkeit bei. Parallel hierzu werden häufig eingesetzte technische Herausforderungen wie parallele Verarbeitung, Fehleranfälligkeit und Schema-Evolution komplett vom System gehandhabt. Die Nutzer müssen sich somit nicht mehr um komplexe interne Mechanismen kümmern. Stattdessen erhalten sie über eine zentrale und einfache Schnittstelle die Möglichkeit, Datenströme zu konfigurieren, Transformationen zu definieren und Ergebnisse in andere Systeme zu übertragen. Auch wenn das Stream Processing in seiner technischen Tiefe wohl immer anspruchsvoller bleiben wird als Batch Processing, führt diese neue Generation von Technologien dazu, dass die klassische Trade-off-Diskussion zwischen hoher Echtzeit-Performance und einfacher Implementierung neu bewertet werden kann.

Es zeichnet sich ab, dass Streaming-Lösungen bald die Benutzerfreundlichkeit von traditionellen Batch-Systemen erreichen werden, ohne dabei an Funktionalität oder Zuverlässigkeit einzubüßen. Die Bedeutung von Stream Processing wird mit der zunehmenden Digitalisierung, dem Internet der Dinge und immer schnelleren Datenströmen weiter wachsen. Daher ist es essenziell, sowohl die bestehenden Herausforderungen transparent zu machen als auch die Fortschritte zu würdigen, die aktuell gemacht werden, um Streaming zu einem integralen und leicht bedienbaren Werkzeug der modernen Datenwelt zu machen. Unternehmen, die heute in Streaming-Technologien investieren und sich fachlich weiterbilden, können sich langfristig Wettbewerbsvorteile sichern und Innovationspotenziale in Echtzeit erkennen und nutzen. Fazit ist, dass Stream Processing trotz seiner Komplexität unverzichtbar für die Zukunft der Datenverarbeitung ist.

Die größte Herausforderung liegt darin, die Vielschichtigkeit der Technik so zu verpacken, dass Nutzer von den Vorteilen ohne Überforderung profitieren können. Die Zukunft verspricht genau diesen Paradigmenwechsel: Leistungsfähige, skalierbare und vor allem benutzerfreundliche Streaming-Plattformen, die es erlauben, die dynamische Welt der Daten in Echtzeit zu erobern.