Sprachassistenten wie Siri, Alexa oder Google Assistant haben unseren Alltag schon lange revolutioniert, doch sie haben einen entscheidenden Nachteil: Die Sprachbefehle und Daten werden meist an die Cloud geschickt. Dort werden sie analysiert, ausgewertet und verarbeitet. Für viele Nutzer stellt das ein großes Datenschutzrisiko dar und wirft Fragen zur Privatsphäre auf. Was wäre, wenn man einen solchen Assistenten bauen könnte, der vollständig lokal läuft, alle Daten nur auf dem eigenen Gerät verarbeitet und keinerlei Verbindung zur Cloud oder zu externen Servern herstellt? Genau diese Vision verfolgt die Idee, eine eigene Siri zu erschaffen – lokal, auf dem Gerät und ohne Cloud. Diese Möglichkeit ist heute nicht nur denkbar, sondern dank moderner Technologien einfacher als je zuvor.

Die Entwicklung eines lokal laufenden Sprachassistenten stellt insbesondere für Entwickler und Teams in sensiblen Bereichen wie Gesundheitswesen oder Recht einen immensen Vorteil dar. Datenschutz und Datensicherheit stehen hier im Fokus, und man möchte nicht, dass sensible Informationen irgendwo auf Drittservern landen. Aber auch für Entwickelnde von mobilen Apps oder Desktop-Anwendungen wird es zunehmend interessant, KI-gesteuerte Funktionen ohne permanente Internetverbindung oder Zusatzkosten durch API-Nutzung anzubieten. Der Grundpfeiler eines solchen Systems besteht aus mehreren wesentlichen Komponenten: Ein Sprach-zu-Text-Modul (Speech-to-Text), ein Sprachverständnismodell (Language Model) mit Funktionserkennung und eine Ausführungsumgebung für die eingebetteten Funktionen, die der Assistent steuern soll. Whisper, ein Open-Source-Modell für Spracherkennung, hat sich als äußerst leistungsfähig und ressourcenschonend etabliert und kann gut lokal betrieben werden.

Das Sprachmodell übernimmt die Aufgabe, die umgangssprachlichen Anfragen zu verstehen und sie in eindeutig definierte Funktionsaufrufe umzuwandeln. Dabei sind Modelle wie das LLaMA 3.1 in Kombination mit modernen Finetuning-Techniken wie LoRA besonders geeignet, da sie effizient und für lokale Geräte optimiert sind. Ein lokal betriebenes KI-System hat gegenüber cloudbasierten Lösungen zahlreiche Vorteile. Primär steht der Schutz der Privatsphäre im Vordergrund.

Die Sprachaufnahmen und Befehle verlassen nie das eigene Gerät, was das Risiko von Datenlecks oder ungewollter Datenweitergabe minimiert. Zudem entfallen Wartezeiten oder Abhängigkeiten von Internetverbindungen – auch in schlecht vernetzten Regionen funktioniert der Assistent reibungslos. Nicht zuletzt ist die Nutzungskostenfreiheit hervorzuheben: Es gibt keine API-Kosten, die bei der Nutzung großer Cloud-Modelle anfallen und bei häufigen Anfragen schnell ins Gewicht fallen können. Doch solch ein System zu bauen, ist mehr als nur ein technisches Experiment. Es erfordert solide Planung, eine durchdachte Systemarchitektur und professionelle MLOps-Prinzipien, um eine verlässliche und skalierbare Lösung zu erhalten.

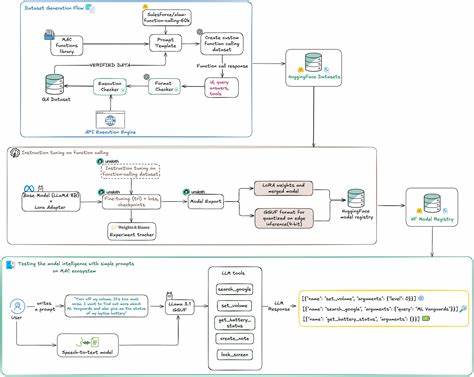

Auch wenn das Ziel ist, den Sprachassistenten ganz lokal auf dem Endgerät auszuführen, startet der Entwicklungsprozess in der Regel online. Vom Sammeln und Erstellen eines qualitativ hochwertigen und diversifizierten Datensatzes, über das Trainieren und Finetunen des Modells, bis hin zur Verteilung und finalen Integration in die Zielumgebung – all diese Schritte benötigen eine strukturierte Arbeitsweise. Das Herzstück des Trainingsprozesses ist die Erstellung eines speziell zugeschnittenen Datensatzes für Funktionserkennung. Anders als bei allgemeinen Sprachmodellen geht es hier darum, das Modell darauf zu trainieren, natürliche Sprache in präzise, maschinenverständliche Funktionsaufrufe zu übersetzen. Dabei ist es entscheidend, eine Vielzahl an realistischen, menschlichen Formulierungen zu integrieren, inklusive seltener, mehrdeutiger oder fehlerhafter Ausdrücke, um die Robustheit zu verbessern.

Die korrekte Validierung und Versionierung dieses Datensatzes ist zentral, denn die Modellqualität hängt stark davon ab, wie gut die Beispiele sind, mit denen es trainiert wurde. Im Fine-Tuning-Schritt wird das Basis-Sprachmodell mithilfe der selbst erstellten Funktions-Daten trainiert. Techniken wie LoRA (Low-Rank Adaptation) ermöglichen es, auch mit limitierten Hardware-Ressourcen effiziente Anpassungen vorzunehmen, ohne das gesamte Modell neu zu trainieren. Dieses Vorgehen erlaubt es, maßgeschneiderte Modelle zu erstellen, die genau auf die eigenen Funktionen abgestimmt sind und so präzise und zuverlässig reagieren. Das Modell kann anschließend in einem effizienten Format wie GGUF exportiert werden.

Die Quantisierung auf 4-Bit ermöglicht, dass das Modell sogar auf Geräten ohne leistungsstarke GPU läuft – auf Laptops, Smartphones oder sogar kleinen Computern wie Raspberry Pi. Die Kombination aus Whisper für die Spracherkennung und dem lokal angepassten LLaMA-Modell liefert eine umfassende Pipeline: Vom gesprochenen Wort bis zur ausgeführten Funktion ohne die geringste Verbindung ins Internet. Ebenfalls entscheidend bei einer solchen Lösung ist ein durchdachtes System für Fehlererkennung und Monitoring. Auch wenn alle Prozesse lokal ablaufen, sollten Entwickler nicht auf MLOps verzichten. Die Modelle und Datensätze sollten versioniert, regelmäßig überprüft und mit einem umfangreichen Testszenario auf Herz und Nieren geprüft werden.

Sprachkommandos werden dazu in unterschiedlichen Varianten abgespielt, auch Fehler wie Hintergrundrauschen, Unterbrechungen oder regionale Akzente müssen simuliert werden. Nur so lässt sich gewährleisten, dass der Sprachassistent im produktiven Einsatz zuverlässig agiert und die Nutzererfahrung positiv bleibt. Nach der Entwicklungs- und Testphase folgt die Integration in die Zielumgebung. Dabei kann der persönliche Assistent als Menüleisten-App, Hintergrunddienst auf Linux-Systemen oder als Bestandteil einer mobilen App realisiert werden. Je nach Einsatzgebiet muss die Benutzeroberfläche intuitiv sein und Interaktionsmöglichkeiten bieten, die ein natürlicheres Nutzungserlebnis stärken.

Wichtig ist, dass das System leicht anpassbar bleibt, um auf spezifische Anwendungsfälle, weitere Funktionsaufrufe oder neue Sprachmuster schnell reagieren zu können. Der Trend zu lokalen Sprachassistenten spiegelt den wachsenden Wunsch nach mehr Kontrolle und Sicherheit wider. Während Cloud-basierte Systeme ihre Stärken bei großen Rechenkapazitäten und ständig aktualisierten Modellen haben, gewinnt die lokale Verarbeitung für viele Nutzer und Organisationen immer mehr an Bedeutung. Die Technologie vieler Open-Source-Modelle wie LLaMA und Whisper hat inzwischen ein Niveau erreicht, das keine riesigen Rechenzentren mehr zwingend erforderlich macht. So wird echte Privatsphäre möglich, gepaart mit hoher Flexibilität und Unabhängigkeit von externen Dienstleistern.

Gleichzeitig ist der Aufbau eines solchen Assistenten ein Paradebeispiel dafür, wie moderne KI-Entwicklung und MLOps zusammenwirken. Die Prinzipien der Nachvollziehbarkeit, Validierung und kontinuierlichen Verbesserung sind nicht nur im Cloud-Umfeld wichtig, sondern gerade bei lokal laufenden Anwendungen unverzichtbar. Der Entwickler trägt die volle Verantwortung, denn es gibt keine automatische Updates oder Heilung durch externe Anbieter. Qualitätssicherung wird hier zur Chefsache. Zukünftige Entwicklungen werden diesen Trend weiter beschleunigen.

Mit Fortschritten bei quantisierten Modellen, verbesserten Sprachverarbeitungsalgorithmen und immer intelligenteren kleinen KI-Systemen auf Endgeräten wird die Erschaffung eigener Sprachassistenten immer zugänglicher. Eine selbstgebaute Siri-Alternative muss dabei weder in Funktionsumfang noch in Bedienkomfort hinter den bekannten Lösungen zurückbleiben. Für Entwickler und Organisationen, die ihre Anwendungen und Dienste besonders sicher und selbstbestimmt gestalten möchten, bietet sich hier eine Chance, sich von der Abhängigkeit großer Cloud-Anbieter zu lösen. Zudem können Anwendungsmöglichkeiten in Bereichen mit hohen Compliance-Anforderungen, wie Medizin, Recht oder Öffentlicher Verwaltung, erschlossen werden, in denen der Umgang mit sensiblen Daten streng geregelt ist. Insgesamt ist die lokale Sprachassistenz kein bloßes Zukunftsmodell mehr, sondern die Gegenwart einer neuen, selbstbestimmten KI-Generation.

Sie kombiniert Datenschutz, Nutzerfreundlichkeit und innovative Technologie auf eine Weise, die gerade für professionelle Anwender und technisch versierte Nutzer enorme Vorteile bietet. Wer frühzeitig mit der Entwicklung und Integration solcher Systeme startet, sichert sich einen wichtigen Wettbewerbsvorteil und gestaltet die KI-Landschaft von morgen aktiv mit.