Die rasante Verbreitung von Large Language Models (LLMs) hat in den letzten Jahren eine regelrechte Revolution in der Art und Weise ausgelöst, wie Menschen mit Technologien interagieren. Textbasierte Chats mit KI-Modellen sind mittlerweile integraler Bestandteil nicht nur von Produktivitätswerkzeugen, sondern auch von kreativen Anwendungen und Alltagshilfen. Trotz der großen Verbreitung fällt auf, dass die Optimierung des Nutzererlebnisses bei diesen Chats ein Feld ist, das gerade erst an Bedeutung gewinnt und auf das sich zunehmend engagierte Entwickler und Unternehmen konzentrieren. Wer aber gestaltet die UX von LLM-Text-Chats aktiv? Welche Innovationen treiben das Nutzererlebnis wirklich voran und wie könnten zukünftige Verbesserungen aussehen?Das Potenzial von LLM-Text-Chats liegt darin, Nutzern eine natürliche und intuitive Schnittstelle zu bieten, die weit über einfache Textabfragen hinausgeht. Dennoch zeigen viele marktübliche Angebote, dass die Grundmechanik oft noch sehr traditionell ist: Ein Eingabefeld für Nutzeranfragen, gefolgt von einer Liste historischer Antworten, reduzierter Unterstützung für Multitasking und limitiertem Input-Handling.

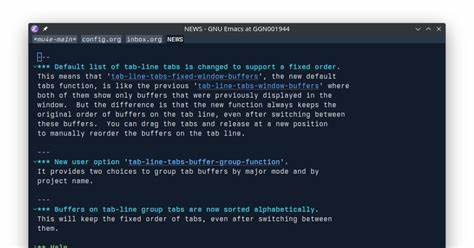

Die Folge sind manchmal kleine Friktionen, die den Nutzungskomfort beeinträchtigen – etwa der fehlende schnelle Zugriff auf relevante Informationen oder Probleme bei der mehrzeiligen Texteingabe.Eine interessante Initialzündung in diesem Bereich kommt von experimentellen Projekten wie chatgpt-shell, das den Ansatz verfolgt, LLM-Interaktionen als eine Art Shell oder REPL (Read-Eval-Print Loop) zu gestalten. Dieses Modell unterstützt die direkte und schnelle Ausführung von Befehlen, analog zu einer Kommandozeilenumgebung, und versucht, typische Stellen mit Bedienungshürden zu entschärfen. Dabei rücken Features wie TAB-Navigation in den Fokus, um etwa schnell zwischen Codeblöcken oder Links zu springen – alles komfortabel per Tastatur. Das ist vor allem für Anwender relevant, die ihre Produktivität mit Keyboard-Shortcuts maximieren wollen und eine flüssige, unterbrechungsfreie Nutzung bevorzugen.

Die Differenzierung zwischen Editierbarkeit und Lesbarkeit ist ebenfalls ein zentraler Punkt. Viele aktuelle LLM-Chat-Interfaces trennen strikt die Eingabezone vom Verlauf, was Eingaben mehrzeilig komplex macht und häufig zu versehentlichem Abschicken vor Fertigstellung führt. Fortschrittliche UX-Designs versuchen hier intelligente Modi einzuführen, die automatisch zwischen Edit- und Ansichtszustand wechseln, sodass Nutzer jederzeit unkompliziert Korrekturen vornehmen können, ohne den Gesprächsfluss zu stören.Ein weiterer bedeutsamer Aspekt ist das Handling der Chat-Historie. Die meisten Nutzer benötigen normalerweise nur den aktuellen Antworten-Output, während die vollständige Historie im Hintergrund liegt.

Ein permanenter Anzeigeverlauf kann schnell überfordernd wirken und „Rauschen“ erzeugen. Innovative Interfaces bieten deshalb sogenannte „Viewports“ oder Pager, die standardmäßig nur die letzte Antwort zeigen und bei Bedarf Zugriff auf frühere Gespräche ermöglichen. Dieses schichtweise Ein- und Ausblenden schafft eine schlankere, fokussierte Oberfläche und reduziert kognitive Belastung.Ein zukunftsweisender Ansatz ist die Schaffung einer einzigen Benutzeroberfläche für verschiedene Modelle. Hier spricht man vom Multi-Model-Support, der es erlaubt, verschiedene KI-Engines innerhalb einer Anwendung nahtlos zu nutzen, ohne dass der Nutzer seine Arbeitsweise an verschiedene Tools anpassen muss.

Diese Einheitlichkeit beugt Frust vor, der entsteht, wenn unterschiedliche „Shells“ oder Chat-Interfaces eigene Bedienkonzepte und Shortcuts mitbringen. Die Entwicklung eines zentralen Frameworks, das flexibel anpassbar ist und vielseitige Modelle unterstützt, kann deshalb einen bedeutenden Beitrag zur UX-Optimierung leisten.Doch wer sind nun die Player, die diese Nutzererfahrung aktiv vorantreiben? Neben etablierten Tech-Giganten wie OpenAI, Google und Microsoft investieren zahlreiche Start-ups und Open-Source-Projekte massiv in die Weiterentwicklung der Chat-UX. Community-getriebene Projekte punkten oft mit innovativen Feinheiten, etwa durch die Integration von Tastatur-orientierten Navigationsmöglichkeiten oder smarter Historienverwaltung. Ebenso prüfen Unternehmen mit Fokus auf Entwicklerproduktivität, wie sich die Schnittstellen auf command-line-ähnliche Umgebungen übertragen lassen, um eine Brücke zwischen traditioneller Shell-Nutzung und moderner KI-Interaktion zu schlagen.

Die sozialen Netzwerke Mastodon, Twitter, Reddit oder Bluesky bieten darüber hinaus interessante Diskussionsplattformen, auf denen die Nutzer selbst über Wünsche und Schwachstellen der aktuellen Chat-UX debattieren. Gerade der Wunsch nach Tastaturzentrierung und schnellen, eleganten Shortcuts wird dabei häufig genannt. Die Rückmeldungen aus der Nutzerbasis fließen wertvoll in die Produktentwicklung ein und helfen, kleine, oft unterschätzte Hürden zu identifizieren und zu beseitigen.Insgesamt befindet sich die UX von LLM-Text-Chats an einem spannenden Wendepunkt. Während die zugrundeliegenden Modelle immer leistungsfähiger werden, ist die Nutzeroberfläche vielfach noch versteckt hinter simplen Chatfenstern und herkömmlichen Bedienmustern.

Mit innovativen Konzepten wie intelligenten Editiermodi, verbesserten Navigationstechniken per Tastatur, fokussierten Viewports und Multi-Model-Interfaces rückt die Branche in Richtung einer höheren Nutzbarkeit und Effizienz vor. Solche Verbesserungen sind nicht nur für technisch versierte Anwender relevant, sondern helfen auch Gelegenheitsnutzer dabei, das volle Potenzial der KI-basierenden Chats einfacher und angenehmer auszuschöpfen.Zukunftsweisend wird vor allem sein, wie gut es gelingt, unterschiedliche Kommunikationsebenen – vom schnellen Sparring bis hin zu detaillierten Programmierdialogen – in einer kohärenten, nahtlosen Erfahrung zu vereinen. Hier ist Kreativität in der Interfacegestaltung gefragt, die die Stärken von Command-Line-Interfaces mit der Flexibilität moderner GUI-Modelle verbindet. Ebenso entscheidend wird die Barrierefreiheit sein, um KI-gestützte Chats für möglichst breite Nutzerkreise attraktiv und zugänglich zu machen.

Abschließend bleibt die Erkenntnis, dass die Optimierung der Nutzererfahrung bei LLM-Text-Chats kein statisches Ziel, sondern ein dynamischer Prozess ist. Die Verschmelzung von Technik- und UX-Innovationen, angetrieben von Community-Feedback und fortlaufendem Experimentieren, wird die nächsten Jahre prägen. Wer heute die kleinen, aber entscheidenden Reibungspunkte identifiziert und elegant löst, legt den Grundstein für Chat-Interfaces, die nicht nur funktional, sondern auch inspirierend und einfach zu bedienen sind. So entwickelt sich die Nutzung von LLMs hin zu einem echten Alltagswerkzeug, das Effizienz, Kreativität und Benutzerfreundlichkeit meisterhaft kombiniert.