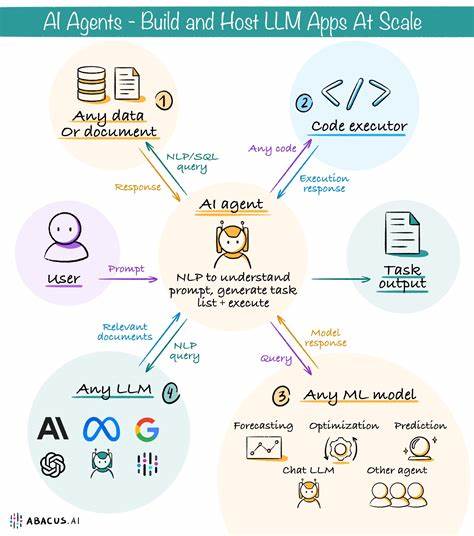

Die rasante Entwicklung der Künstlichen Intelligenz und insbesondere der großen Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren eine Innovationsexplosion ausgelöst. Doch trotz ihrer Leistungsfähigkeit sind diese Modelle häufig extrem groß und ressourcenintensiv. Die hohen Anforderungen an Rechenleistung und Speicherkapazität führen dazu, dass der Betrieb oft nur auf spezialisierten Cloud-Plattformen möglich ist, was enorme Kosten und Energieverbrauch nach sich zieht. Hier setzt das spanische Unternehmen Multiverse Computing mit seiner revolutionären Technologie CompactifAI an, das nun eine beachtliche Finanzierungsrunde in Höhe von 215 Millionen US-Dollar abschloss, um die Skalierung und Verbreitung ihrer Kompressionslösung voranzutreiben. Die Investition ist außerdem ein klares Zeichen für die Bedeutung effizienterer KI-Anwendungen und das Potenzial, die gesamte KI-Infrastruktur nachhaltig zu verändern.

Multiverse Computing hat einen einzigartigen Weg entwickelt, um die Größe von großen Sprachmodellen um bis zu 95 % zu reduzieren, ohne dabei die ursprüngliche Leistungsfähigkeit zu beeinträchtigen. Der Schlüssel bildet die quantum-inspirierte Technologie namens Tensor Networks, mit der sich neuronale Netzwerke detailliert analysieren und optimieren lassen. Durch das gezielte Eliminieren redundanter und unnötiger Informationen werden sogenannte „spurious correlations“ aus den Modellen herausgefiltert. Dieser Ansatz erlaubt es, Modelle wesentlich schlanker zu gestalten, ohne dass es zu Verlusten bei der Genauigkeit oder Funktionalität kommt. Die Vorteile von CompactifAI sind vielfältig und betreffen sowohl Geschwindigkeit als auch Effizienz und Kosten.

So können mit der komprimierten Version herkömmlicher LLMs Verarbeitungszeiten um das Vier- bis Zwölffache verkürzt werden. Gleichzeitig sinken die Kosten für die Inferenz, also das tatsächliche Ausführen der Modelle, um bis zu 80 %. Das eröffnet den Weg für eine breite Nutzung intelligenter Anwendungen selbst auf kleineren, ressourcenärmeren Endgeräten wie Smartphones, PCs, Autos oder sogar dem Raspberry Pi. Beispielsweise können Unternehmen KI-Assistenten oder komplexe Verarbeitungsschritte mit lokaler Datensicherheit, schneller Reaktionszeit und geringem Energieverbrauch bereitstellen. Die Finanzierungsrunde wurde von Bullhound Capital angeführt, einem international anerkannten Investor mit Fokus auf technologische Innovationen.

Weitere bedeutende Unterstützer sind HP Tech Ventures, Forgepoint Capital, Toshiba, Santander Climate VC und weitere Investoren aus Europa und den USA. Dieses breite Syndikat signalisiert das enorme Wachstumspotenzial und die strategische Bedeutung der Kompressionstechnologie im expandierenden AI-Inferenzmarkt, der auf jährlich etwa 106 Milliarden US-Dollar geschätzt wird. Enrique Lizaso Olmos, Gründer und CEO von Multiverse Computing, betont, dass die Kompression traditionell als kompromissbehaftet galt. Die verbreitete Annahme war, dass durch das Verkleinern von Modellen Abstriche bei der Genauigkeit gemacht werden müssen. Mit CompactifAI hat Multiverse diese Vorstellung durchbrochen und leistet einen «Gamechanger»: Die Modelle bleiben performant bei deutlich geringerem Hardwarebedarf und Kosten.

Dies verändert grundlegend, wie KI-Anwendungen entwickelt, betrieben und skaliert werden können. Ein wesentlicher wissenschaftlicher Impuls kam von Román Orús, Co-Gründer und Chief Scientific Officer, der mit seinem Fachwissen im Bereich Tensor Networks eine neue Denkweise bei der Optimierung neuronaler Netzwerke etablierte. Tensor Networks sind ein Konzept aus der Quantenphysik, das ursprünglich zur Modellierung komplexer Quantensysteme entwickelt wurde. Ihre Anwendung im Bereich Künstliche Intelligenz ist neuartig und hat eine präzise Analyse und Verdichtung hochdimensionaler Datenstrukturen ermöglicht, die für LLMs typisch sind. Die Technologie wurde bereits auf mehrere populäre Open-Source-Modelle wie Llama, DeepSeek und Mistral angewandt, mit großem Erfolg.

Die komprimierten Modelle sind heute schon bei Unternehmen im Einsatz, die von der verbesserten Effizienz profitieren. Weitere LLM-Modelle sollen in naher Zukunft folgen, um den Ansatz auf noch mehr Bereiche auszuweiten. Die Bedeutung dieser Entwicklung geht über technische Vorteile hinaus. Durch die drastische Senkung der Hardwareanforderungen entsteht eine Demokratisierung von KI-Technologie. Kleinere Unternehmen, Entwickler und Forschungseinrichtungen können KI-Anwendungen nutzen, die vorher nur für wenige Großkonzerne zugänglich waren.

Zudem trägt die erhöhte Effizienz maßgeblich zur ökologischen Nachhaltigkeit bei, da weniger Energie für Rechenzentren oder Geräte benötigt wird, die KI unterstützen. HP Tech Ventures hebt hervor, wie wichtig es ist, KI-Anwendungen auch am sogenannten «Edge» verfügbar zu machen. Das sind Endgeräte am Rand von Netzwerken, also beispielsweise mobil genutzte Smartphones, IoT-Geräte, Fahrzeuge oder Smart Homes. Wird KI in diesen Bereichen leistungsfähiger und kostengünstiger, entstehen völlig neue Anwendungsmöglichkeiten – von personalisierter Assistenz über bessere Sicherheitsfunktionen bis hin zu intelligenter Steuerung in Echtzeit. HP sieht in der Investition auch die Chance, die Produktpalette für Arbeitsumgebungen und Kreativbranchen deutlich zu erweitern.

Forgepoint Capital unterstreicht die strategische Rolle von Multiverse Computing als eine Art Grundbaustein der zukünftigen KI-Infrastruktur. Die Kompressionstechnologie ist aus ihrer Sicht nicht nur eine technische Innovation, sondern ein wesentlicher Schlüssel, um KI weltweit nachhaltiger, erschwinglicher und schneller verfügbar zu machen. Die globale Dimension des Marktes birgt enormes Wachstumspotenzial und eröffnet Chancen für führende Positionen in der aufstrebenden KI-Ökonomie. Neben den kommerziellen Möglichkeiten hat die Unterstützung durch europäische Institutionen dazu beigetragen, Meilensteine bei der Forschung und Entwicklung von CompactifAI zu erreichen. Die Förderung ermöglicht es, Forschung auf Weltniveau mit industriellem Know-how zu vereinen und die technologischen Fortschritte zügig in marktfähige Produkte zu überführen.

In der Zukunft könnte die Kompression von LLMs nicht nur die Anwendungsszenarien von KI grundlegend verändern, sondern auch die Art und Weise, wie die Künstliche Intelligenz in den Alltag integriert wird. Von intelligenten Mobilgeräten, die ohne ständige Cloud-Verbindung auskommen, über autonome Fahrzeuge bis hin zu smarten Robotern oder Industrieanlagen – überall ergeben sich durch kompakte und leistungsfähige Modelle neue Chancen zur Effizienzsteigerung und Innovationsförderung. Zusammenfassend lassen sich die Kernpunkte von Multiverse Computings Erfolg so darstellen: Durch die Kombination von quanteninspirierten Algorithmen, einem international führenden Investorennetzwerk und der starken Nachfrage nach performantem, kosteneffizientem KI-Betrieb gelingt eine Revolution in der Art und Weise, wie LLMs genutzt werden können. Die Skalierung von CompactifAI wird die Entwicklung und Verbreitung intelligenter Technologien weltweit beschleunigen, Kosten senken und Energieverbrauch reduzieren. Dies macht Multiverse Computing zu einem zentralen Akteur im globalen KI-Ökosystem und einem Innovationsmotor für die nächste Generation von KI-Anwendungen.

Unternehmen aller Größenordnungen erhalten damit neue Werkzeuge, um erfolgreich und wettbewerbsfähig im digitalen Zeitalter agieren zu können. Die Zukunft der KI ist nicht nur mächtiger, sondern auch zugänglicher und nachhaltiger. Multiverse Computing zeigt, dass Fortschritt ohne Kompromisse möglich ist und setzt damit Maßstäbe für die gesamte Branche.

![Guy found a way to reduce his phone usage by carrying a notebook everywhere [video]](/images/5F62FDC9-E9D5-45B6-9AC2-BD9BF87FED3E)