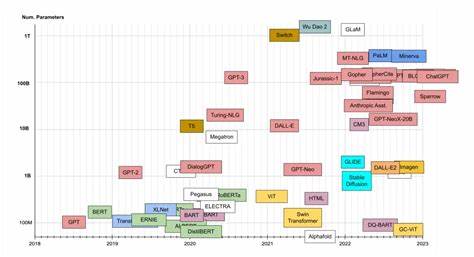

Die rasante Entwicklung großer Sprachmodelle (Large Language Models, LLMs) hat in den letzten Jahren die Landschaft der Künstlichen Intelligenz maßgeblich beeinflusst. Modelle wie GPT, BERT oder Chinchilla setzen auf immer größere neuronale Netzwerke, deren Leistungsfähigkeit mit zunehmender Größe offensichtlich steigt. Doch trotz zahlreicher Erfolge und Anwendungen war lange unklar, warum genau diese Leistungssteigerung so konsistent mit der Modellgröße zusammenhängt. Die sogenannte neurale Skalierungsgesetzmäßigkeit, bei der der Verlust (Loss) in Abhängigkeit von der Modellgröße als Potenzgesetz abnimmt, wirft spannende theoretische Fragen auf, die nun durch neue Forschungsergebnisse besser verstanden werden können. Im Zentrum dieser Erklärung steht das Konzept der Superposition von Merkmalen, welches eine entscheidende Rolle im inneren Aufbau von LLM-Repräsentationen spielt.

Superposition bedeutet in diesem Kontext, dass Sprachmodelle gleichzeitig mehr sprachliche Merkmale oder Konzepte repräsentieren, als sie einzelne Dimensionen in ihren neuronalen Repräsentationen besitzen. Anstatt für jedes Merkmal einen eigenen Nerv oder Vektorabschnitt zu reservieren, werden mehrere Merkmale miteinander überlagert (superponiert). Dieser Ansatz widerspricht traditionellen Vorstellungen, nach denen Modelle möglichst disentangled, also klar getrennte, Merkmale lernen sollten. Stattdessen zeigen empirische Beobachtungen, dass moderne LLMs eine hochgradige Überlagerung ihrer internen Repräsentationen nutzen, um Effizienz und Kompaktheit zu erreichen.Ein weiterer wichtiger Faktor sind die stark heterogenen Häufigkeiten sprachlicher Merkmale oder Konzepte.

Sprache folgt häufig Verteilungen, die durch sogenannte Power-Laws beschrieben werden – das bedeutet, einige Worte oder Konzepte kommen sehr häufig vor, während andere selten sind. Diese Hierarchie der Häufigkeiten spiegelt sich auch in den gelernten Repräsentationen der Modelle wider und beeinflusst maßgeblich die Art und Weise, wie der Verlust mit der Größe des Modells sinkt.Forscher haben ein vereinfachtes, sogenanntes Toy-Modell entwickelt, um den Einfluss von Superposition und Merkmalsfrequenzen auf die Skalierung des Verlusts zu untersuchen. Dabei unterscheidet man zwischen schwacher und starker Superposition. Bei schwacher Superposition werden nur die häufigsten Merkmale ohne größere Überlappung in den Repräsentationen untergebracht – hier zeigt sich, dass die Verlustskala direkt von der Frequenzverteilung der Merkmale abhängt.

Wenn diese Verteilung ein Power-Law ist, so folgt auch der Verlust einer Power-Law-Abhängigkeit von der Modellgröße.Anders verhält es sich bei starker Superposition. Hier repräsentieren die Modelle alle Merkmale, sind aber gezwungen, diese vielfach zu überlagern, wodurch es zwangsläufig zu gegenseitiger Interferenz in den Repräsentationen kommt. Überraschenderweise führt dies zu einer robusteren und universelleren Skalierung: Der Verlust ist in einem weiten Bereich von Häufigkeitsverteilungen invers proportional zur Modellgröße. Diese Eigenschaft lässt sich geometrisch erklären: Wenn viele Vektoren in einem niedriger dimensionalen Raum untergebracht werden, skaliert die durchschnittliche Interferenz durch Überlagerung quadratisch und ihre Summe ergibt eine Inversproportionalität zur Dimension.

Dies zeigt, dass stärkere Superposition eine natürliche und effiziente Methode ist, um die Repräsentationskapazität bei begrenzten Modellgrößen zu maximieren.Die Theorie wurde anschließend an mehreren öffentlich zugänglichen LLM-Architekturen validiert. Analysen zeigen, dass aktuelle große Sprachmodelle wie jene der Chinchilla-Reihe unter die Kategorie der starken Superposition fallen und das skalierungsgesetz aus der Theorie perfekt widerspiegeln. Dies bestätigt, dass Superposition ein grundlegendes Prinzip bei der Repräsentationswahl und der Leistungsentwicklung moderner Sprachmodelle ist. Interessanterweise passen auch experimentelle Ergebnisse, wie das Chinchilla-Skalierungsgesetz, hervorragend in das von den Forschern vorgeschlagene Bild.

Diese Erkenntnisse haben nicht nur theoretischen Wert, sondern auch praktische Auswirkungen auf die Gestaltung zukünftiger Modelle und Trainingsstrategien. Das Verständnis, dass Superposition hilft, Informationen effizienter zu komprimieren und gleichzeitig eine vorteilhafte Verlustskala zu erzielen, kann neue Ansätze motivieren, die mit weniger Parametern besser performen. Beispielsweise könnten gezielte Methoden entwickelt werden, um Superposition zu fördern oder Interferenzen besser zu kontrollieren. Dies könnte bei gleichbleibender Rechenleistung bessere Modelle ermöglichen.Die Rolle der Merkmalsfrequenzen bleibt dabei zentral.

Da natürliche Sprache durch eine Power-Law-Verteilung der Wortfreqenzen charakterisiert ist, profitieren Modelle, die Merkmale in Superposition codieren, sozusagen auf natürliche Weise von der statistischen Struktur der Eingaben. Das Zusammenspiel von Superposition und Frequenzverteilung schafft ein Zusammenspiel, das sich als neuartige Erklärung für die beobachteten neuralen Skalierungsregeln eignet.Zusammenfassend lässt sich sagen, dass Superposition von Merkmalen ein Schlüsselmechanismus ist, der die leistungssteigernden Effekte größerer Modellkapazitäten erklärt und gleichzeitig den Weg zu effizienteren Sprachmodellen weist. Die geometrische Perspektive auf Vektorüberlagerung öffnet einen faszinierenden Blick auf interne Repräsentationen im neuronalen Raum und liefert eine theoretische Basis, auf der zukünftige Forschung und Entwicklung aufbauen kann. Die Entdeckung dieser Prinzipien fördert ein tieferes Verständnis darüber, wie LLMs Sprache verarbeiten und lehren uns, wie wir diese Fähigkeiten mit weniger Rechenaufwand und Speicherbedarf verbessern können.

Angesichts des starken Wachstums im Bereich der KI und der Bedeutung effizienter Modelle ist dieses Wissen von unschätzbarem Wert für die Gestaltung der nächsten Generation großer Sprachmodelle.